La décision d'Intel de se lancer dans les puces graphiques destinées aux cartes dédiées n'est pas nouvelle. On pense ainsi inévitablement aux i740 commercialisées au début de l'année 1998 et qui connurent un certain succès. Mais le fondeur lâcha rapidement l'affaire, laissant le marché à d'autres sociétés, dont une petite Start Up âgée d'à peine 5 ans, NVIDIA, aujourd'hui une des sociétés les plus valorisées au monde... Il est facile de réécrire l'histoire en connaissant la fin (ou tout du moins la situation actuelle), mais quelle erreur stratégique ce fût. À cette époque, le CPU était l'élément archi dominant et nul doute que ceux que l'on n'appelait pas encore des GPU, ont été jugés indignes des investissements nécessaires pour consolider une place dans ce marché balbutiant. En 2007, les bleus comprenant que leurs produits ne permettaient pas de répondre au besoin croissant de calcul massivement parallèle, relance les études avec le projet Larrabee. La déclinaison GPU ne vit jamais le jour, mais l'étude fut partiellement réutilisée pour les Xeon Phi. En 2017, Intel décide une fois encore de se (re)lancer dans le domaine en recrutant Raja Koduri, l'ex-patron de la branche graphique d'AMD. S'il a depuis quitté la société, nul doute qu'il a insufflé son savoir-faire avant cela. Les premiers fruits issus de 5 ans de travaux virent le jour sous la dénomination ARC Axxx, connue également sous le nom de code Alchemist. Le résultat bien que largement perfectible, était prometteur. C'est pourquoi l'arrivée de l'ARC B580, première carte issue du projet Battlemage, son successeur, est intéressante à plus d'un titre. En effet, cela montre qu'Intel est cette fois résolu à ne pas lâcher l'affaire comme par le passé, et ce malgré un manque de succès initial. La nouvelle venue corrige-t-elle les principales faiblesses des ARC Axxx ? Quid de l'évolution des pilotes ? Comment se place-t-elle dans le marché actuel ? Réponse à ces questions et bien d'autres au sein de ce dossier.

tout n'est pas parfait mais son avantage de vram lui donne beaucoup d'intérêt dans cette gamme de prix

très bon test comme d'habitude

le fonctionnement du mode turbo est spéciale je suis sur que la carte pourrait grapiller des mhz avec un fonctionnement plus comme amd/nvidia

Par contre j'ai fini vraiment à l'arrache, donc désolé s'il y a des fautes/typos/coquille, on va corriger une bonne partie de cela dans les heures qui viennent.

je dis ça pas parce que Eric est un ami, mais ses tests sont une tuerie complète et tellement riches d'enseignements, ils servent de base dans mes connaissances 😊

je viens de lire plus en detail l'article si on écoute le descriptif on croit que la b580 a un die complet et le b570 un die castré

de se que j'ai compris la b580 a aussi un die castré mais je me trompe peut être

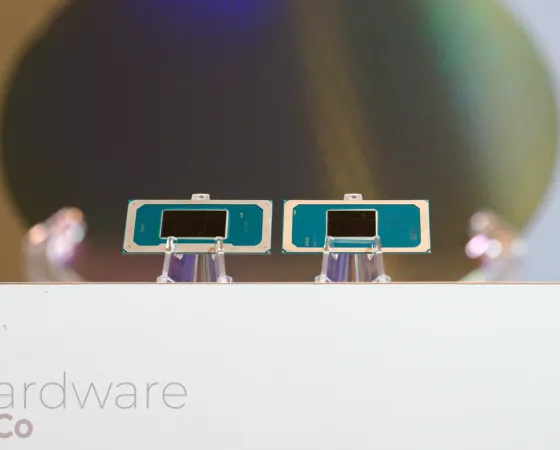

Intel ne l'a pas précisé, mais si tu regardes bien la représentation du die en page 2, tu distingues facilement les 5 Render Slice (20 Xe Engine) et 6 contrôleurs mémoire, pas un de plus. Donc il semble bien que le die soit complet.

J'avais vu passer que les 5 render slice c'était bizarre et que du coup il y en aurait 6 mais ton explication tient la route

Mais du coup le côté faible densité en prend un coup j'ai cru que le die avait réellement un bus 256 bits

Ils ont pour moi en tout cas chier dans la colle sur ça

Après ont sait que avec les unités xmx prennent beaucoup (trop ?) de place et qu'il faut un plus gros die pour être équivalent à amd/nvdia mais la c'est peu abusé

J'ai aucune certitude, mais c'est ce qui me semble le plus probable. De toute façon lorsque tu poses la question à Intel (ou aux deux autres) la réponse est toujours la même : "nous ne communiquons jamais sur des produits ou fonctionnalités non annoncées" donc il y a toujours un doute.

L ia chez intel sert à quoi à par le xess ? Pas grand chose il me semble

Il faut des unités ia mais je trouve ça surdimentionné

Les arcs ne sont même pas décliné en secteur pro il me semble

Il ne faut pas oublier aussi que la densité est très étroitement liée à la maîtrise / expérience du procédé de gravure... ce qui passe par l'expertises des outils de conception. Avec Intel qui débarque tout juste chez TSMC - qui plus est avec des GPU qui ne sont pas sa spécialité -, face à un NVIDIA et AMD rompu à la tâche car fabless, c'est compliqué. Il est aussi possible que Intel avait des buts plus agressifs en matière de fréquence, et a initialement designé la puce avec des transistors moins denses mais plus susceptibles de monter en cadence.

Merci pour le test, c'est encourageant pour intel, mais ça arrive beaucoup trop tard et trop cher chez nous.

330€ ce serait plus cher que certaines RTX 4060. Alors certes elle est censée être mieux (hors consommation), mais l'image de marque de NVIDIA est forte.

Si on suit le taux de change + TVA, 250$ c'est moins de 290€, donc à voir si ça va baisser dans les prochaines semaines.

🙏

Comme d'hab', le master des testeurs fr a pondu le meilleur test fr, plein/trop d'info' mais " vulgarisé" , pour un néophyte comme moi qui passe son temps a jouer.. ok je m'égare hihi.

Plus sérieusement, en toute franchise elle a bcp de potentielle, faut voir une fois les pilotes matures ( Intel l'a prouvé avec Arc), son écosystème évolue aussi,

Loin d'être ridicule.

Mais son prix fr va peut être freiné, c'est chère Payé.. et aussi sa conso pas énorme mais face a la 4060...

Merci Éric pour ce test et ces pavés ! On adore!

Un peu moins quand même hein ! 😅 Je suis juste un gars passionné qui est tombé il y a très longtemps dans l'informatique et qui essaie simplement de faire les choses sérieusement. Ma prétention s'arrête à ça et c'est déjà beaucoup vu les biais et erreurs qui peuvent survenir sur chaque test, surtout quand tu es contraint par le temps disponible du fait d'une activité parallèle.

Et en plus il a de l'humilité comme personne !!

☺️

C'est ta passion qui anime ce genre de ticket, de façon factuelle et impartial, n'en déplaise a certains ( et certains sites putacliks)

Merci, toujours un plaisir de te lire, de VOUS lire!