Verdict

Nous voici parvenus au terme de ce dossier, et il y a deux façons d'appréhender cette carte et plus généralement Blackwell. Soit on les voit comme une timide mise à jour d'Ada Lovelace, bridée par un procédé de fabrication inchangé entrainant une consommation électrique en hausse notable et un différentiel de performance limité. Soit on croit au virage opéré par Nvidia et son Neural Rendering. Ce dernier constitue un changement de paradigme complet, rendant sa compréhension et acceptation difficile pour beaucoup, et soulève des doutes bien légitimes. Tâchons d'y voir un peu plus clair en détaillant tout cela.

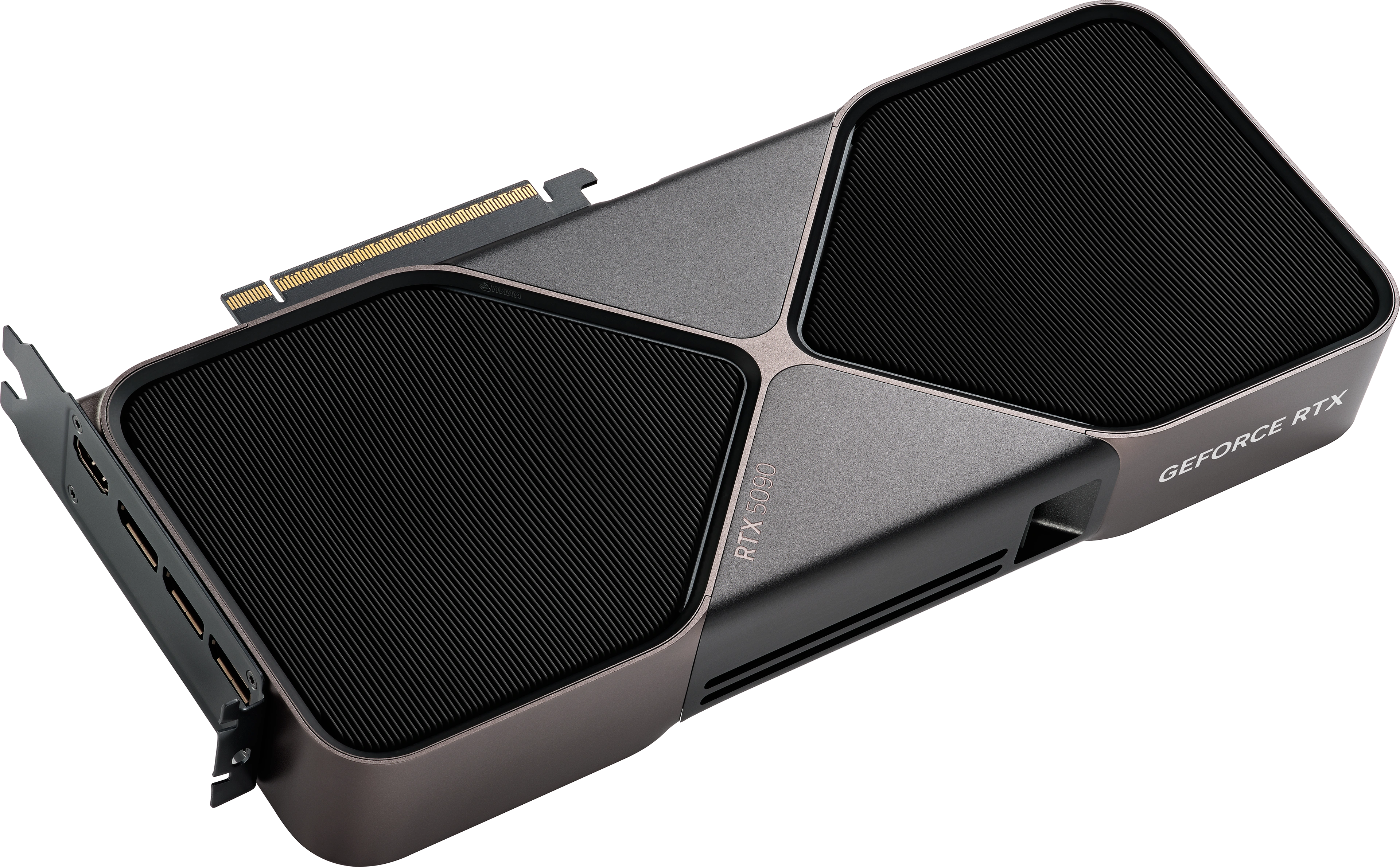

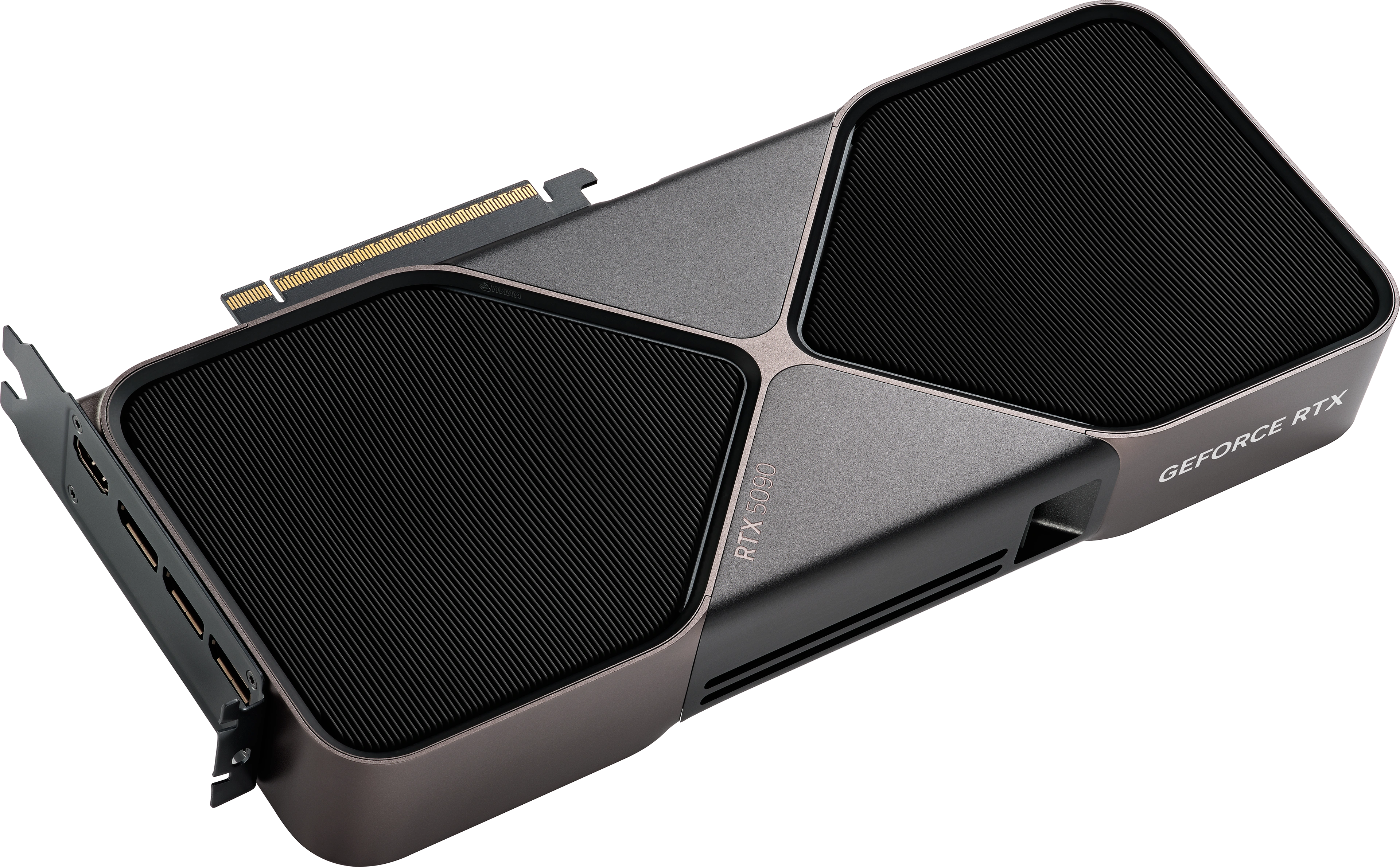

Nvidia GeForce RTX 5090 Founders Edition

Nvidia GeForce RTX 5090 Founders Edition

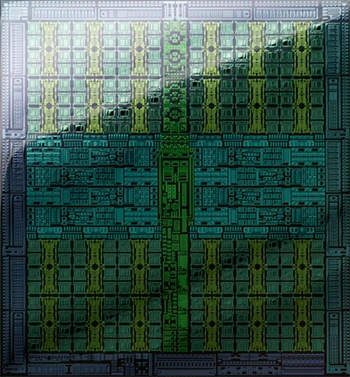

Pour concevoir sa nouvelle microarchitecture, Nvidia n'est comme souvent pas parti d'une feuille blanche, mais d'une évolution de la précédente. Certaines orientations qui n'ont pas été adoptées par les développeurs (comme les Displaced Micro-Meshes) ont vu émerger des alternatives (Mega Geometry), mais globalement il ne s'agit pas d'une complète remise à plat. Du point de vue des unités de calculs "historiques", on notera surtout l'abandon du dual issue (doublement des unités FP32 par Cuda Core), qui n'a finalement pas apporté les gains anticipés par les utilisateurs, lorsque le marketing s'était empressé d'indiquer un doublement des Cuda Cores avec Ampere (poursuivi avec Ada), ce qui n'était bien entendu qu'une astuce sémantique, comme nous l'indiquions à l'époque sur un autre média. La direction prise par Nvidia n'était donc pas de faire évoluer en profondeur cet aspect architectural, probablement jugé comme suffisamment abouti pour l'heure, mais bien celui lié à l'utilisation plus efficace de l'IA au sein de rendus 3D, via l'intégration de "briques matérielles" facilitant cela (AMP, etc.). C'est un arbitrage important, surtout lorsque l'on considère que la stagnation du procédé de gravure limite votre budget total en transistors, les dies ne pouvant grandir à l'infini pour des raisons techniques, de coût et de consommation électrique. Ce choix implique donc de "sacrifier" une augmentation des unités classiques au profit d'autres, ce qui est encore plus flagrant sur les GPU de gamme inférieure (GB203/205). Pourquoi diable un tel choix ? Les verts ont acté qu'un mur se présentait devant eux, qu'il s'agisse du ralentissement des progrès en matière de procédé de gravure, comme des limitations CPU qui vont se faire de plus en plus prégnantes.

C'est parfait alors ? Il est encore trop tôt pour le dire, puisque nous n'avons pour l'heure pu tester que 4 des 6 jeux proposant ces technologies, faute de temps et de titres compatibles en avant de la commercialisation effective des cartes. C'est donc un échantillon trop réduit pour avoir une vue exhaustive des résultats, comptez sur nous pour vous proposer à l'avenir des dossiers dédiés à ce sujet. Une technologie, tout aboutie soit-elle, n'a aussi d'intérêt que si elle est adoptée massivement. Vu l'historique de Nvidia sur le sujet, il semble toutefois légitime d'être optimiste, d'autant que ce dernier a déjà prévu un plan B pour favoriser la démocratisation. Il est en effet possible de remplacer le modèle utilisé par l'upscaler directement au sein de Nvidia App, pour peu que le jeu dispose déjà d'une implémentation du DLSS, quelle qu'elle soit. Il en est de même pour la frame generation avec les mêmes contraintes que celles précédemment citées (implémentation existante de la FG dans les jeux). Mais le neural rendering ne s'arrête pas à ces points, puisque l'on peut y ajouter une compression de textures plus efficace, et de multiples autres usages (Neural Faces/Skin/Materials, etc.). Tout ceci est possible par le biais d'une intégration plus poussée des Tensor Cores au sein du pipeline de rendu et facilité par les Neural Shaders.

Alors, que penser de cette RTX 5090 ? C'est probablement la carte qu'il ne vous faut pas. Au-delà de la punch line (ainsi parlai(en)t Zarathoustra les communicants), c'est une simple question statistique : faites-vous partie des 1 % de personnes susceptibles d'en acheter une pour jouer (si on se fie aux statistiques Steam pour la RTX 4090 ?) ? Vous serez probablement plus nombreux à la choisir pour ses capacités de production, mais son prix officiel de 2349 € et sa consommation électrique auront vite fait de refroidir (un comble !) bien des ardeurs. C'est d'autant plus vrai que le début de commercialisation, prévu le 30/01, s'avère pour le moins chaotique si l'on se réfère à cette rumeur et à nos oreilles indiscrètes. Cette carte s'adresse à un marché de niche et il faut vraiment vouloir la crème de la crème pour accepter son prix et ses contreparties.

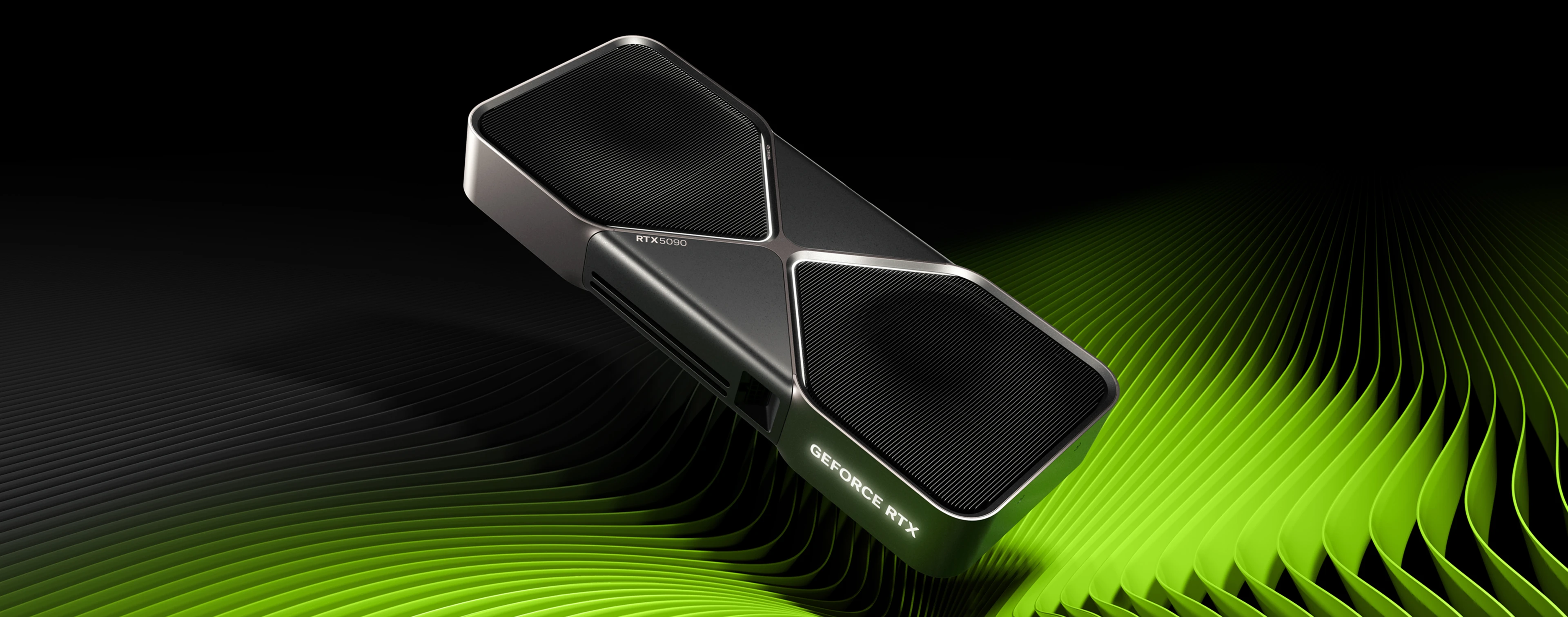

Ça n'en fait pas une mauvaise carte pour autant, mais comme toujours, la version 90 sert de porte-drapeau pour le reste de la série. Plus spécifiquement concernant la Founders Edition, on ne peut que tirer notre chapeau à Nvidia pour la qualité de fabrication et conception de ce modèle limité à 2 slots. Ce ne sera probablement pas le modèle le plus silencieux qui soit, mais réussir à dissiper ainsi une telle quantité de joules, laisse pantois. Les amateurs fortunés de belles pièces d'ingénierie seront en tout cas aux anges, mais à associer obligatoirement avec un boitier (très) bien ventilé et de préférence un AIO pour le CPU. Quelle concurrence pour une telle bête ? A priori aucune, puisqu'AMD semble avoir déserté le haut de gamme pour cette génération et qu'Intel ne propose rien non plus. Le seul choix va se résumer aux différents modèles ou opter éventuellement pour une 4090.

Reste toutefois à en trouver une, et si c'est difficile en neuf, les modèles d'occasions pourraient proposer des alternatives intéressantes financièrement, puisqu'en puissance brute, elle n'est pas si loin que ça. Sa consommation électrique est également plus modérée. Elle est par contre dénuée de certaines innovations architecturales, qui se feront probablement sentir dans les années à venir. Quoi qu'il en soit, nous vous conseillons de ne pas précipiter votre choix et d'attendre la déclinaison de la gamme pour jauger les différents modèles et les estimer à l'aune de vos besoins. Cela permettra d'éviter la "surtaxe" de l'effet nouveauté et de disposer de davantage de recul sur le DLSS 4, du fait d'une implémentation plus large, pouvant potentiellement nuancer notre avis initial basé sur un échantillon réduit et forcément bien travaillé par Nvidia

Terminons toutefois sur un sentiment bien plus positif. Certes cette carte ne se destine pas à tout le monde, très loin de là même, mais elle porte en elle les promesses d'une nouvelle ère qui semblait impossible à court terme il n'y a de ça que quelques mois. Être capable de jouer en UHD avec les détails maximaux à des jeux AAA en Full Ray Tracing (Path Tracing) à 200 images par seconde, ça paraissait impossible, du domaine de l'utopie, et pourtant c'est à présent une réalité ! La bonne nouvelle, c'est qu'on n'a pas besoin d'autant de FPS pour jouer confortablement et nous sommes impatients de voir ce que le reste de la gamme va pouvoir proposer. Nous sommes probablement ici devant une avancée majeure dans le monde de la 3D ludique, l'avenir nous le dira. Ce sont en tout cas des temps enthousiasmants, comme on en connait trop peu dernièrement dans le microcosme du matériel PC.

Plutôt qu'un Award (qui certes fait plaisir aux marques pour leur communication, mais a du mal à retranscrire les nuances développées dans cette page verdict), nous avons tenté de vous proposer une représentation synthétique des prestations à attendre de la carte, en comparaison de ses principales rivales. C'est un exercice périlleux, parce qu'une notation reste assujettie à une échelle de valeurs susceptible de changer dans le temps et selon les priorités personnelles de chacun. Voici quelques précisions d'ordre général sur les valeurs attribuées et la manière de procéder pour ce faire :

♦ la notation utilise une base décimale pour donner un minimum de précision et nuances

♦ Le positionnement de chaque critère est déterminé à la sortie de la carte uniquement (et peut donc devenir obsolète dans le futur si réajustement tarifaire ou autres).

♦ Le prix (tout comme les autres métriques), est un classement relatif des cartes et pas une appréciation dans l'absolu de la valeur pécuniaire de ces dernières. La note est basée sur le meilleur tarif disponible en boutiques livrant en France.

♦ Les valeurs dans chaque catégorie représentent une appréciation de la pertinence des cartes comparativement entre elles. Il est donc tout à fait possible de voir une carte bas de gamme obtenir la note maximum en performance, et ce même si elle est loin du niveau d'une RTX 4090 dans l'absolu.

♦ La catégorie "Environnement logiciel" est un fourre-tout regroupant la robustesse et l'ergonomie des pilotes, les performances avec des logiciels de production, la qualité visuelle des technologies proposées (DLSS, FSR, XeSS, FG, RR, etc.), les logiciels additionnels mis à disposition de l'utilisateur (Broadcast, etc.). C'est la seule dont l'évaluation n'est pas calculée, mais estimée.

Bilan RTX 5090

Nous remercions naturellement nos partenaires pour la mise à disposition du matériel ayant permis la réalisation de ce dossier.

C'est parti pour un peu de lecture, merci d'avance pour votre test !!

🙏

Merci pour le test les copains ! 💯

🙏

Merci beaucoup pour le test, très complet!

Alors certes elle a de la patate et est à l'aise en upscale + FG, mais voilà la conso (et la température des puces mémoire, aouch)!

🙏

Merci Hardware & Co pour cet article de qualité (et les petites touches de cultures).

Bonne journée.

Quelques points à signaler vu l'ampleur du dossier et le temps imparti pour le réaliser :

Merci pour votre compréhension

Cool le test merci

rajouter une passe en UHD RT mais sans DLSS? Parce que le DLSS ca fonctionne mais on le sait depuis les premières RTX!

30 heures de boulot mini, désolé je peux pas. Il fallait que je case quelque part l'apport du DLSS 4. Sur 4 def/réglages, il y en a 3 sans DLSS/FSR et c'est en UHD RT qu'il fait plus sens.

Ouai je comprend , après je n'ai clairement pas la même vision sur le dlss!

Avec le DLSS 4 il y a match ! C'est justement tout l'intérêt de cette nouvelle version utilisant Transformer

Toute mes excuses j'avais sauté la page dlss 4, il y a l'info que je souhaitais, mea culpa!

Il n'y a pas de mal, c'est vrai que j'ai ajouté les tests en UHD RT natif dans la page DLSS 4, mais ça se limite à la seule 5090 et les 4 jeux testés, tant mieux si tu as trouvé ton bonheur.

Pour un test partiellement "rushé" 🙃 c'est juste incroyable le travail réalisé 🤩

Merci 🤸♂️