Verdict

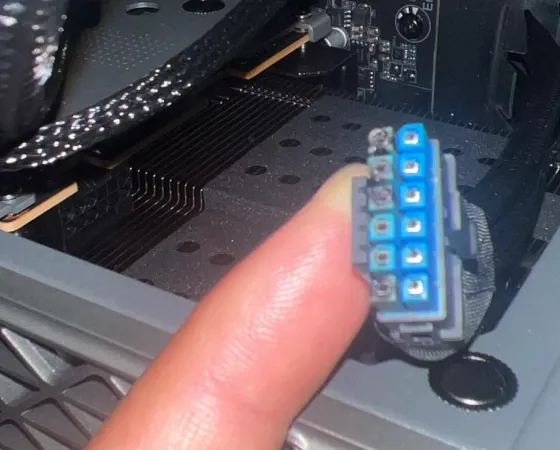

Nous voici parvenus au terme de ce dossier, et il n'est pas facile de résumer en quelques lignes l'intégralité des informations et tests contenus au sein des pages précédentes. Avant de détailler notre avis sur les nouvelles gammes des différents concepteurs de GPU, rappelons que seule celle de Nvidia est complète (ou pratiquement, si d'aventure une RTX 4050 ou 4080 Ti venaient à sortir) pour le moment. Il manque en effet les RX 7800/7700 côté rouge, qui ne devraient plus tarder si on se fie aux dernières rumeurs, quant à Intel, il n'a toujours pas lancé ses ARC A500 pourtant annoncées lors de la commercialisation des A700. Il faudra donc garder en tête cet élément, limitant la pertinence globale de l'analyse que nous allons tâcher de réaliser. Un dernier mot avant d'attaquer cette dernière : si le lancement de la gamme Ada a été perturbé par les soucis liés au connecteur 12HPWR de la RTX 4090, les nouvelles cartes d'AMD et Intel ont, elles, été plombées au départ par des pilotes pour le moins perfectibles. La bonne nouvelle, c'est que tant du côté bleu que rouge, la situation tend à se normaliser à ce niveau, si bien que nos mesures des 2 côtés ne nous ont pas posé de problèmes particuliers et de nombreux bugs ont été résolus depuis leurs lancements respectifs, inspirant davantage confiance en la robustesse et le suivi de ces produits, point qui n'est pas anodin avant d'investir plusieurs centaines d'euros dans une carte graphique.

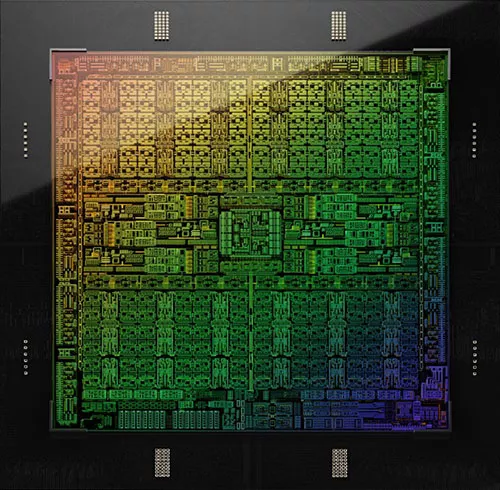

• Ada Lovelace

Plus bas dans la gamme, AD103 est une puce bien moins ambitieuse, puisqu’on passe de 609 mm² à 379 mm². Sans surprise, le niveau de prestation est clairement un ou deux tons en dessous, c'est malgré tout suffisant pour finir dans les mêmes eaux que la RX 7900 XTX, tout en la dominant après activation du Ray Tracing. Enfin, la dernière puce nous intéressant au sein de ce dossier est AD104, qui passe sous les 300 mm² fois et propose des prestations encore moindres et cette fois insuffisantes pour revenir au niveau de la RX 7900 XT en rastérisation sur notre échantillon de tests (même si elle garde l'avantage une fois le RT actif). Si on exclut la RTX 4090 et son AD102 qui n'ont pas de rivaux, on remarque également que les GPU Ada se montrent plus économes que leurs pendants de la concurrence, profitant donc d'une meilleure efficience. On peut ajouter également au titre des atouts, une écrasante domination d'un point de vue des applications créatives et un écosystème logiciel plus fournis, en particulier le DLSS 3 qui constitue une carte maîtresse pour augmenter significativement les performances et sans concurrence à l'heure actuelle, malgré des annonces en ce sens il y a plus de nombreux mois.

Tout est beau au pays du géant vert alors ? Eh bien non, et la problématique n'est pas à chercher dans la prestation des cartes (on peut toutefois grincer des dents sur la non intégration du DP 2.x pour des cartes se voulant à la pointe de la technologie), excellente au demeurant comme nous venons de le rappeler, mais de leur tarification. Si on peut comprendre que Nvidia désire monnayer sa supériorité actuelle, il y a toutefois des limites selon nous à cette politique. La 4090 étant intouchable, même si son tarif est scandaleusement élevé pour certains, la crème de la crème n'a jamais été et ne sera jamais un modèle au niveau de la performance / €. Qui plus est, la carte semble très bien se vendre malgré son prix stratosphérique, alors pourquoi s'en priver ? Par contre, le placement des autres cartes nous parait pour le coup beaucoup plus problématique. La RTX 4080 est une excellente carte, mais pas à 1250 / 1300 € quand on trouve des RX 7900 XTX à 1050 €. C'est guère mieux pour la RTX 4070 Ti, et finalement celle qui s'en sortirait le moins mal reste la RTX 4070, si tant est que l'on n’ait pas en face des 6800/6900/6950 XT à prix cassé. Vous l'aurez compris, Ada Lovelace est une nouvelle génération cruelle pour le consommateur, puisqu'elle propose des prestations de premier plan, à un tarif difficilement acceptable pour la plupart.

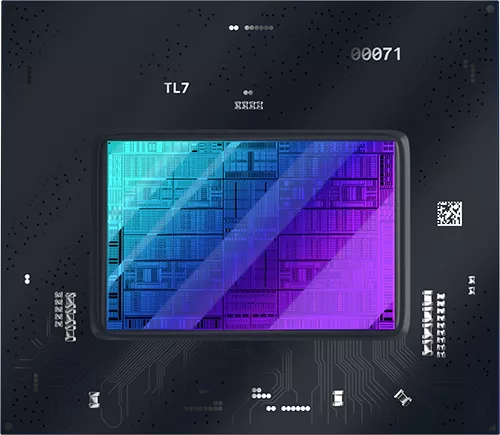

• Alchemist

Mais que vaut vraiment cette architecture Alchemist déployée sur les ARC Axxx ? Bien, mais peut mieux faire penserons la plupart. Le fait est que le gabarit de la puce ACM-G10, incite à penser qu'elle devrait aisément jouer des coudes avec les RX 6700 XT et RTX 3070. En pratique, sa version intégrale peine à suivre le rythme de ces dernières en rastérisation, même si le passage en UHD limite la casse (du fait d'un manque de VRAM pour la carte de Nvidia et d'un bus mémoire plus étriqué côté rouge), sans oublier toutefois qu'aucune de ces cartes n'est réellement pensée pour une telle définition. C'est donc à première vue en deçà des attentes vu le budget transistors alloué, mais ce serait oublier bien vite que la carte d'Intel dispose de fonctionnalités (encodage AV1, Display Port 2.0) qui ne sont apparues que sur la génération suivante de ses concurrents (et encore le moteur d'affichage n'est pas à niveau sur Ada) et qui ne sont pas gratuites à ce niveau. Autre point notable, l'intégration d'unités matricielles et d'un accélérateur Ray Tracing de haut niveau pour un premier jet, faisant pratiquement jeu égal avec celui d'Ampere et devançant largement celui de RDNA 2. Là aussi ce n'est pas gratuit, mais donne une certaine pérennité à la carte vis-à-vis de ces technologies d'avenir.

Mais pour reprendre le slogan d'un célèbre pneumaticien, "sans maîtrise la puissance n'est rien", la principale difficulté dans le domaine du rendu 3D se situe bien plus du côté software que matériel. Comme nous l'indiquions précédemment, Intel ne ménage pas ses efforts pour améliorer la prise en charge de ses nouveaux GPU au niveau des pilotes, mais c'est un travail de longue haleine, s'appuyant qui plus est sur l'expérience des équipes dédiées, afin de parvenir à extirper au maximum les bugs de fonctionnement, mais surtout tirer la substantifique moelle de son hardware au niveau des performances en jeu. Les bleus viennent d'ailleurs de communiquer à propos de gains d'une vingtaine de pourcents sur les jeux DX11 avec les dernières versions de pilotes, en comparaison de ceux disponibles au lancement. C'est une bonne nouvelle qui démontre que les investissements paient, mais la route va être encore longue et semée d'embûches avant d'arriver à rattraper complétement ses concurrents à ce niveau. En octobre 2022, choisir une carte ARC comportait une grande part d'inconnu et de risques d'être confronté à des problèmes franchement gênants, et sans garantie quant à leur résolution future. C'est bien moins le cas à présent, ce qui en fait un choix tout à fait légitime si les prestations et la tarification conviennent. Pour le futur, les progrès réalisés au niveau du XeSS sont très encourageants, et montrent que le fondeur n'est pas décidé à se laisser devancer par la concurrence sur ce sujet. Au niveau des prix pratiqués, Intel s'était montré plutôt agressif (en particulier pour l'A750) au lancement puis au printemps, mais ceux-ci sont quelque peu repartis à la hausse depuis. Il faudra donc peser l'offre globale du marché au moment d'un éventuel achat, pour jauger la pertinence des ARC A750/770 au moment de franchir le pas en leur faveur.

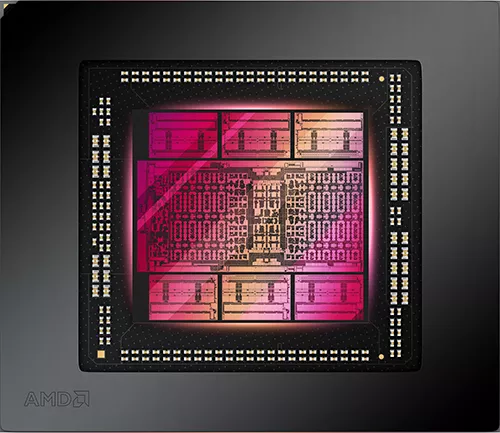

• RDNA 3

C'est un souci récurent d'AMD, que de faire naitre des attentes démesurées pour au final décevoir avec un produit inabouti, alors qu'au demeurant très correct, une fois la tarification adaptée et les bugs de lancement éliminés. Rien n'obligeait AMD à annoncer jusqu'à 70 % de gains par rapport à la RX 6950 XT, alors qu'il était en pleine connaissance du fait que c'était loin d'être l'ordre de grandeur des gains à attendre. Pourquoi lancer ces cartes si tôt alors que les pilotes nécessitaient clairement de mûrir, surtout quand le concurrent proposaient des tarifs stratosphériques, empêtré dans la gestion de son surstock d'Ampere ? Pourquoi parler d'un FSR 3, qui de toute évidence était loin d'être prêt, vu qu'il n'est toujours pas disponible 9 mois plus tard (nous avons bon espoir qu'il sorte prochainement toutefois) ? Et nous pourrions citer des exemples de ce type à la pelle par le passé, le fait est que le service marketing des rouges lui fait souvent plus de tort que la concurrence. Cette petite digression traduit notre dépit vis-à-vis d'une société bourrée d'ingénieurs talentueux, et qui pourrait faire tellement mieux en adoptant une politique différente. Nous sommes bien conscients que notre avis ne rentre pas en ligne de compte dans la politique de la société, probablement guidée par de nombreuses contraintes non exposées publiquement. Toutefois, il faut bien convenir à minima d'une certaine maladresse côté communication, et comme le dit l'adage, "on n'a jamais qu'une seule chance de faire une bonne première impression".

Pour autant RDNA 3 est-il raté ? Clairement non, le résultat étant d'ailleurs plus satisfaisant à l'heure actuelle qu'il ne le fut il y a 9 mois, pour les raisons évoquées précédemment. En l'état, cette microarchitecture et les puces qui en découlent, proposent un gain appréciable de performances en rastérisation, efficience et encore davantage en Ray Tracing, là où RDNA 2 pêchait cruellement. Malgré cela, RDNA 3 s'avère un peu "juste" pour concurrencer Ada, comme pouvait le faire avec brio la précédente microarchitecture vis-à-vis d'Ampere. En effet, il lui faut près de 530 mm² (certes sur 2 procédés de gravure différents dont un seul est équivalent à celui du concurrent) pour égaler une puce de 379 mm² (légèrement incomplète qui plus est), tout en consommant davantage et ce sans même parler du déficit en Ray Tracing ou d'écosystème logiciel. Ceci dit, la tarification élitiste adoptée par Nvidia ouvre une porte qu'AMD peut saisir. Il sera d'ailleurs intéressant de voir comment se positionneront les remplaçantes des RX 6800 XT / 6700 XT, car en sus de la concurrence des 4070 / 4060 Ti, les nombreuses opérations de bradages des RX 6800 XT / 6950 XT pourraient compliquer sérieusement l'adoption des nouvelles venues tant que perdurera du stock. Si le passage aux chiplets n'a pas eu l'effet escompté sur les prix pour l'heure, l'expérience accumulée par AMD sur le sujet pourrait lui donner un réel avantage compétitif dans le futur. Wait & see donc, mais on peut d'ores et déjà acter qu'à l'heure actuelle, RDNA 3 dispose de davantage d'atouts dans sa manche qu'il n'en avait fin 2022.

• Verdict

Compte tenu du nombre de solutions éprouvées dans ce dossier et le très large éventail de prix, vous comprendrez aisément qu'il n'est pas possible de désigner des vainqueurs ou des perdants. En effet, l'acheteur potentiel d'une RTX 4090, n'hésitera vraisemblablement pas entre cette dernière et une ARC A770 par exemple, sans pour autant qu'un de ces choix soit mauvais, mais juste adapté à des attentes et budget différents. Ce test a donc principalement pour vocation de fournir une base de comparaison des différentes prestations proposées par les modèles haut de gamme (si tant est que l'ARC A770 soit considérée comme une carte haut de gamme, en l'occurrence c'est ce qu'il y a de plus élevé dans la gamme d'Intel) de dernière génération (et certains représentatifs de la génération précédente), afin de vous permettre d'identifier au sein de ces derniers, celui ou ceux correspondant à vos besoins. Le choix final et le montant que chacun est disposé à dépenser pour un tel élément, restant bien entendu une appréciation individuelle (chacun fait bien ce qu'il veut de son argent). Pour ceux qui n'ont pas le courage, l'envie, ni même le temps de procéder à un travail d'analyse approfondie de leur besoin, nous vous proposerons une mise à jour prochaine de nos guides d'achat, afin de les aider davantage dans leur choix.

Un dernier mot sur un élément prenant de plus en plus d'ampleur et que nous avons totalement ignoré dans ce dossier faute de temps, mais qui fera l'objet d'un article dédié : le neural rendering. Les DLSS, FSR (qui n'est pas du neural rendering pour le coup car dénué de toute phase d'apprentissage profond) et XeSS sont à présent des options courantes en jeu et changent souvent radicalement les performances. Le DLSS 3 a permis au caméléon de prendre un avantage considérable sur la concurrence à ce niveau, reste à voir comment ces derniers vont tenter de revenir dans la course et surtout à quelle échéance. Un point toutefois très important concernant ces upscalers et qui ne doit pas être négligé, c'est la qualité d'image produite. Pour cela, une analyse des images fixes et en mouvement est nécessaire, ce qui nécessite un temps considérable car, le résultat dans un jeu ne sera pas forcément représentatif pour d'autres et ce pour une même technologie. C'est cette raison qui nous a contraint à ne pas aborder ce sujet au sein de ce dossier cumulant déjà près de 200 H de travail en l'état. Nous tâcherons donc de répondre à ces questions légitimes prochainement (idéalement une fois le FSR 3 disponible, s'il ne tarde pas trop à sortir), en complément de ce dossier.

Nous remercions naturellement nos partenaires pour la mise à disposition du matériel ayant permis la réalisation de ce dossier.

Merci pour ce gros test !

Super boulot ! Merci ! Les explications de fonctionnement sont super informatives.

Je pourrai abuser et demander l'ajout de la gamme en dessous : une 3060, une 4060, une 6600 de chez dédé ? ou tout du moins l'une d'elle ? :oS

Sinon ce serait super d'avoir une représentation des résultats en 3D (interactive ?) x: perf synthétique sur les 20 jeux, y: nuisance sonore, z: conso ... bon pi quand les humains auront évolué pour le percevoir, un 4ème axe "prix" ça serait au poil :D car c'est un peu de cette optimisation que chacun prend sa décision d'achat ;) Et ça serait marrant de voir des gros outliers sortant du lot.

Alors non, désolé et ce pour une raison simple : ces cartes ne sont pas adaptées du tout pour les définitions et réglages sélectionnés pour ce dossier. Même parmi l'échantillon de test, certaines références se retrouvent dans une situation inconfortable parce qu'elle ne sont pas utilisées dans leur plage adaptée (principalement en UHD). Le souci, c'est que cela conduit à une hiérarchie pour ces cartes qui n'est pas pertinente (parce que structurellement (plus de VRAM, de ROP, etc.) la référence A serait moins limitée que la référence B dans ces conditions qui ne font pas partie de leur plage nominale et ce même si cela ne rend pas le réglage jouable pour autant) et qui pourra induire en erreur le lecteur qui se contente de regarder l'indice moyen (et il y en a bcp).

C'est pour ça que je suis contre les plages de références trop larges du fait de ce biais. On pourrait le contourner partiellement en rajoutant le FHD en plus des QHD/UHD, mais d'une part cela va multiplier de manière conséquente la durée des mesures (et le risque qu'une nouvelle version de pilotes ou un patch de jeu sorte obligeant à reprendre toutes les cartes déjà testées), et d'autre part la pertinence retrouvée via cette nouvelle définition pour ces cartes entrainera aussi une absence de pertinence (pour cette même définition) pour certaines autres références qui pour le coup vont être totalement limitées par le CPU et se tourner les pouces rendant la hiérarchie biaisée à nouveau même si pour d'autres raisons. Nous avons toutefois réalisé d'autres dossiers où l'on retrouve des références communes qui permet d'extrapoler quelque peu le positionnement des références demandées.

Nos graphs dynamiques ne permettent pas de folie de ce genre pour le moment, mais probablement un type radar à l'avenir. Par contre les nuisances sonores sont fortement liées à la version choisie : on ne peut pas inférer ce que sera le niveau d'une Asus, Gigabyte, MSI, etc. en se basant sur la prestation à ce niveau de la carte de référence.

Pour ça il y a nos guides d'achat, ils vont être remis à jour prochainement.

Ça c'est du test de qualité (et de quantité) non de diou ! Merci Riton pour l'investissement !

Je me suis régalé en page 2 3 4, c'est tellement bien détaillé !

Merci pour le test Eric, comme d'hab' au top!

Content que ça t'ait plu 😉