Protocole de test

Ce dossier visant à départager les cartes graphiques, nous tâchons de les mettre dans une situation limitant autant que possible les influences d’autres facteurs. Nous optons donc pour une configuration particulièrement musclée, avec un Core i9 de dernière génération (Raptor Lake Refresh). Nous désactivons l’Hyper-Threading afin de privilégier la répétabilité des mesures et les performances, tout en conservant suffisamment de threads pour les moteurs 3D les plus gourmands à ce niveau. Enfin, nous activons le Resizable BAR dans le bios, afin de profiter de cette fonctionnalité pour les cartes le supportant. Nous couplons à ce processeur de la mémoire très véloce fournie par G.Skill, pour tirer parti au mieux de ce dernier.

• Hardware

Intel Core i9-14900K (HT Off)

ASUS MAXIMUS Z690 Hero

G.Skill Trident Z5 RGB [2 x 16 Go 7200@34-45-45-2T]

Western Digital Black SN850X - 1 To (OS) / Corsair MP 600 Core - 4 To (Jeux) / Western Digital Blue SN570 - 1 To (Applications pro)

BeQuiet ! Dark Power Pro 13 - 1300 W

Asus PG43UQ / MSI Optix NXGR253R

Asus nous a également procuré un moniteur ROG Swift PG43UQ pour nos tests. Ce modèle UHD d’une diagonale élevée permet de mieux traquer les éventuels défauts ou optimisations par trop agressives des concepteurs de GPU, dans leurs tentatives pour pousser toujours plus loin les performances. L’Adaptive Sync est désactivée durant les mesures en jeu et nous utilisons une fréquence de rafraîchissement de 144 Hz en UHD. Nous utilisons également ponctuellement un second moniteur, le MSI Optix NXGR253R, pour mesurer la consommation au repos en multi-écrans, et ce dans de différentes conditions, y compris avec un rafraîchissement vertical très élevé (360 Hz). Nous réactivons également ponctuellement l'Adaptive Sync pour mesurer son effet lors de la consommation au repos des cartes.

Nous avons réuni pour ce test l'échantillon de cartes suivantes. Entre parenthèses, sont indiquées les fréquences GPU et mémoire maximales en MHz. Pour rappel, la fréquence GPU variera plus ou moins largement à la baisse, pour les cartes dotées d’un "boost" par rapport à cette valeur indiquée, selon la charge, température et/ou puissance électrique absorbée. Cette indication n’est donc là qu’à titre purement informatif et ne correspond pas à la fréquence réellement appliquée durant les tests.

AMD Radeon RX 6900 XT (2 532 / 1 988)

Gigabyte Radeon RX 7700 XT Gaming Pro (2738 / 2238)

Gigabyte Radeon RX 7800 XT Gaming Pro (2 738 / 2 238)

AMD Radeon RX 7900 XT Made By AMD (2 952 / 2 487)

AMD Radeon RX 7900 XTX Made By AMD (3 125 / 2 487)

NVIDIA GeForce RTX 3090 Founders Edition (2 025 / 1 219)

NVIDIA GeForce RTX 4070 Founders Edition (2 820 / 1 313)

NVIDIA GeForce RTX 4070 SUPER Founders Edition ( 2 820 / 1 313

Gainward GeForce RTX 4070 Ti Phoenix (2 880 / 1 313)

NVIDIA GeForce RTX 4080 Founders Edition (2 805 / 1 400)

Il n'existe pas de Founders Edition pour la GeForce RTX 4070 Ti, nous avons donc utilisé notre Gainward Phoenix Golden Sample mise à jour avec un firmware respectant scrupuleusement les spécifications de référence et fournie par le constructeur (que nous remercions). De quoi représenter cette référence dans nos différents tests, sans biais lié à un quelconque overclocking de série. Les températures et nuisances sonores sont par contre spécifiques à ce modèle. N'ayant pas de Radeon RX 7800 XT MBA à disposition et un tel modèle n'existant tout simplement pas pour la 7700 XT, Gigabyte nous a procuré ses versions customs pour les représenter. Ces dernières sont toutefois overclockées tout en disposant d'une limite de puissance nettement plus élevée, leur permettant d'être plus rapides que des modèles de référence. En l'absence d'outil Ad Hoc pour flasher ces références avec des BIOS adéquats, nous avons ramené leurs limites de puissance respectives aux valeurs de référence, soit 245 W pour la 7700 XT et 263 W pour la 7800 XT. Sans en faire totalement des cartes de référence, cela permettra une comparaison plus équitable avec les autres modèles de référence.

• Software

- Windows 11 Pro 23H2

- AMD Adrenalin 23.12.1

- NVIDIA 546.52 (presse)

- Intel 101.5122

Nous utilisons Windows 11, ce qui implique nécessairement une version 64-bit afin d’exploiter une quantité conséquente de mémoire vive et ne pas limiter les jeux qui en auraient besoin à ce niveau. Les dernières mises à jour de l’OS sont bien sûr installées avant de procéder aux séries de tests des cartes graphiques : pas d’évolution logicielle (jeux/OS/applications) -hormis les pilotes graphiques bien entendu- entre toutes les cartes composant l’échantillon retenu. Côté pilotes, nous utilisons les derniers disponibles au moment des mesures. Les réglages par défaut sont utilisés pour tous les constructeurs, voici ce que cela donne pour les cartes du caméléon :

Réglages pilotes Nvidia

Réglages pilotes Nvidia

Réglages par défaut des pilotes GeForce

Ci-dessous les réglages par défaut des Radeon :

Pilotes AMD 23.x.x

Pilotes AMD 23.x.x

Réglages par défaut des pilotes Radeon

Et enfin ceux d'Intel :

Réglages pilotes Intel

Réglages pilotes Intel

• Protocole

Concernant les différents benchmarks / logiciels utilisés, nous exécutons ces derniers au minimum 3 fois et retenons le meilleur score de la série. Pour les performances en jeu, les résultats ont été obtenus via Frameview 1.5.9611.33638487 (une interface graphique pour PresentMon ajoutant des données de monitoring) sur un déplacement reproductible, et correspondent à la moyenne de 3 "passes" minimum. La température de la pièce est maintenue à 20°C durant tous les tests.

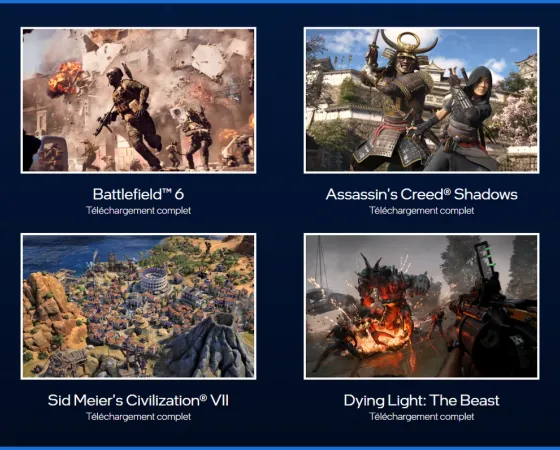

L’échantillon de test est composé au total de 23 jeux, ils utilisent tous un moteur 3D différent, afin de mesurer l’efficacité de nos cartes dans de nombreuses situations réellement différenciées. Cela nous permet de vous proposer les résultats obtenus pour 20 jeux en rastérisation et 18 utilisant le Ray Tracing. Nous essayons de suivre l’actualité vidéoludique en remplaçant régulièrement des références par de nouvelles, tout en nous assurant que les titres choisis conviennent à cet exercice (répétabilité, absence de limitation ou biais, etc.). Nous avons retenu les définitions 2560 x 1440 (QHD) et 3840 x 2160 (UHD) qui siéent aux cartes testées. Notons tout de même que les tests en UHD et Ray Tracing actif, sont réalisés avec l'apport des technologies d'upscaling et Frame Generation (si l'option est présente) disponibles, car la charge est trop lourde pour la grande majorité des cartes. Les différents niveaux de qualité sélectionnés sont quant à eux précisés au sein des graphiques.

Excellent test

La carte améliore le perf/prix chez nvidia c'est toujours une bonne chose mais je trouve que 12 go ça ne lui va pas bien

C'est sûr que 16 Go eussent été mieux, mais on est pas limité par les 12 Go pour l'heure, en particulier en QHD. Le bus mémoire 192-bit permet aussi de réduire significativement la taille du die (les interfaces sont moins denses en transistors et scalent moins bien en affinant la gravure comme l'a prouvé AMD), sur du 4/5 nm ce n'est pas négligeable en terme de coût pour une puce monolithique. Après Nvidia pourrait aussi sacrifier un peu de sa marge, mais vu qu'il en fait beaucoup plus sur les puces dédiées à l'IA et que TSMC n'arrive pas à suivre, je crois qu'il faut pas trop en demander pour le moment.

Tsmc peut suivre

C'est l'emballage des puces ia qui bloque pas la production des die

J'avoue que je n'ai pas suivi pour savoir où se trouvait la limitation. M'enfin t'as compris la remarque : pourquoi rogner sa marge quand tu peux faire plus de sous en privilégiant l'affectation des puces à l'IA plutôt qu'au gaming.

Je précise que je ne cautionne pas, mais je serais CEO je me poserais sérieusement la question.

Bah je te réponds ils peuvent produire plus si nvidia le décide

C'est l emballage du die avec l interposé et la hbm qui bloque

Chose que n'utilise pas les puces gaming

Ah mais tu n'utilises pas que du H100/H200 pour faire de l'IA, tu as aussi des produits comme les L40 (principalement utilisés en inférence) qui n'ont pas de HBM (puisque c'est un AD102) et qui margent plus qu'une GeForce.

Que penses tu d'un bus 128 bits avec 8 puces donc 16 go mais 64 mo de cache et ram à 24 gbps ?

Je ne suis pas architecte GPU, mais j'imagine que les ingénieurs de Nvidia ont fait leurs simulations et que l'option retenue pour AD104 était le meilleur compromis à leurs yeux.

Bah ça a 2 problème je pense que la puce serait pas plus petit le cache remplaçant les contrôleur ram en moins

Mais 2 puces ram en plus plus cher et version pro avec plus de ram impossible

C'est marrant tu fais les questions et les réponses 🙂

Très bon test !

l'evolution des graphs du site est plaisante, celui en fin de conclusion est très appréciable également !

Merci pour ton retour 😉

Merci bien, ça fait plaisir 😊

Je confirme qu'il est toujours aussi agréable de vous lire à travers ces tests toujours complets. Pour le produit, une carte diablement intéressante et bien foutue, dans ma gamme de conso, mais toujours assez chère malgré "l'effort" fait par nvidia pour la conserver au même prix que sa devancière. Tout progrès est bon à prendre, mais la majorité va continuer à s'intéresser à ce qu'il se passe à moins cher, alors qu'avant, cette gamme touchait plus de monde. Le 1080p a de beaux jours devant lui.

ça ressemble à une mise à niveau pour se caler un peu au dessus de la 7800xt en augmentant la conso ?