Consommation des cartes

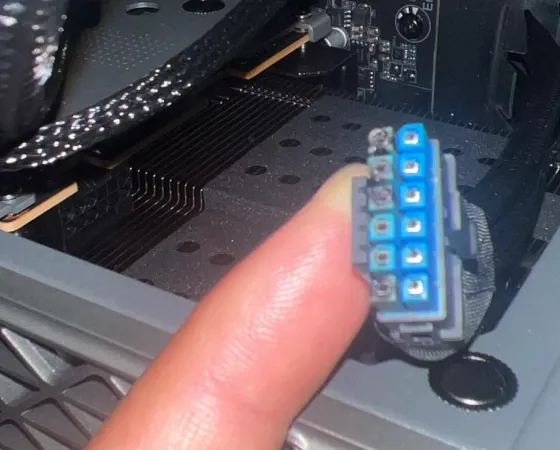

Pour déterminer la consommation électrique des cartes graphiques (seules), nous utilisons PCAT, un kit composé d’un riser PCIe connecté à un module s’intercalant entre le bloc d’alimentation et la carte graphique. Toutes les sources de puissance sont donc enregistrées au travers d’un petit logiciel via une connexion USB. Par mesure de sécurité, nous contrôlons certaines mesures de manière aléatoire, via notre précédent kit (riser + pinces ampèremétriques), pour nous assurer de la fiabilité des données remontées.

Consommation au repos

Nous avons multiplié les situations afin de vérifier le comportement des cartes au repos selon le nombre d'écrans utilisés et leur type. Avec une fréquence de rafraichissement vertical à 60 Hz, c'est plutôt serré entre Radeon et GeForce de dernière génération, si on omet la RTX 4070 Ti de Gainward, qui n'est pas très vertueuse à ce niveau. En passant la fréquence de rafraîchissement de notre écran UHD à 144 Hz, les Radeon voient leur consommation s'emballer (du fait d'une fréquence mémoire bloquée à sa valeur maximale), à l'exception de la Radeon 7900 XTX (???). Il est toutefois possible de revenir à une situation nominale pour les autres en activant le VRR (Freesync dans les pilotes de ces dernières) si l'écran dispose d'une telle fonctionnalité.

En utilisant cette fois deux écrans (1 UHD & 1 FHD) à 60 Hz, on va retrouver une situation globalement similaire à celle avec un seul écran à cette fréquence de rafraîchissement vertical, avec quelques watts de plus au compteur et des Radeon plus frugales que leurs concurrentes. Avec l'activation du 144 Hz sur l'écran principal, ces dernières repassent en consommation élevée (encore une fois du fait de la fréquence VRAM appliquée), l'activation de Freesync rétablissant la situation pour RDNA 3, mais pas les cartes RDNA 2. À noter que nous avons poussé nos mesures un peu plus loin en passant le second écran à 360 Hz (le premier toujours à 144 Hz), la consommation augmente considérablement pour toutes les cartes, même si les GeForce s'en sortent mieux globalement. Il est même possible de réduire encore leur consommation via le VRR, ce qui n'est par contre pas le cas des Radeon et ce quelque soit leur génération cette fois.

Consommation au repos - RTX 4070 SUPER

Consommation en charge

En charge, nous mesurons la puissance électrique absorbée par les cartes graphiques sous un jeu gourmand en UHD / rastérisation, un autre en QHD / Ray Tracing et nous ajoutons une troisième valeur correspondant à la moyenne de consommation établie sur les tous jeux constituant notre échantillon de tests en UHD (y compris en Ray Tracing avec upscaling & frame generation). Sous A Plague Tale: Requiem, notre RTX 4070 SUPER FE absorbe plus de puissance électrique que ce qui est attendu, avec 236 W au lieu de 220 W. Nous avons reproduit ce fait avec un second module PCAT, mais aussi notre ancien protocole. A noter que l'API renvoie, elle, 220 W maximum. Nous supposons donc que le système de contrôle de la puissance sur la carte est mal étalonné sur notre exemplaire, ou que le caméléon n'assume pas complétement les 235 W dans les jeux les plus énergivores. Cela rend en tout cas notre exemplaire un peu plus performant, dans les jeux saturant totalement l'enveloppe de puissance. Pour le second jeu (RT en QHD) et la moyenne UHD, les valeurs mesurées sont cette fois conformes aux spécifications, puisque proches de 220 W.

Consommation en charge - RTX 4070 SUPER

Nous verrons ce qu’il en est des conséquences de ces puissances absorbées sur l’efficience globale un peu plus bas, mais avant cela, rappelons que depuis que nous utilisons PCAT, nous ne nous contentons pas de relever la consommation au sein d’un ou deux jeux, mais de l’intégralité de ces derniers. Pour avoir une vue plus exhaustive, voici donc le tableau récapitulant les consommations moyennes relevées (la plus élevée parmi toutes les "passes" de chaque jeu (et la plus élevée entre rastérisation et RT si les 2 modes de rendu sont testés)).

| Puissance absorbée par le GPU (Watts) | RTX 4070 SUPER FE |

|---|---|

| A Plague Tale : Requiem | 236 |

| Alan Wake II | 226 |

| Assassin's Creed Mirage | 202 |

| Avatar: Frontiers of Pandora | 232 |

| Cyberpunk 2077 | 234 |

| Dead Space | 200 |

| Doom Eternal | 235 |

| Dying Light 2 | 225 |

| Elden Ring | 180 |

| F1 23 | 232 |

| Forspoken | 220 |

| Forza Motorsport | 214 |

| Ghostrunner II | 233 |

| Hitman III | 219 |

| Lord of the Fallen | 225 |

| Metro Exodus Enhanced Edition | 236 |

| Ratchet & Clank : Rift Apart | 211 |

| Red Dead Redemption 2 | 226 |

| Resident Evil 4 | 224 |

| Starfield | 226 |

| Total War : Pharaoh | 221 |

| Warhammer 40,000: Darktide | 233 |

| Watch Dogs : Legion | 221 |

| Moyenne | 222 |

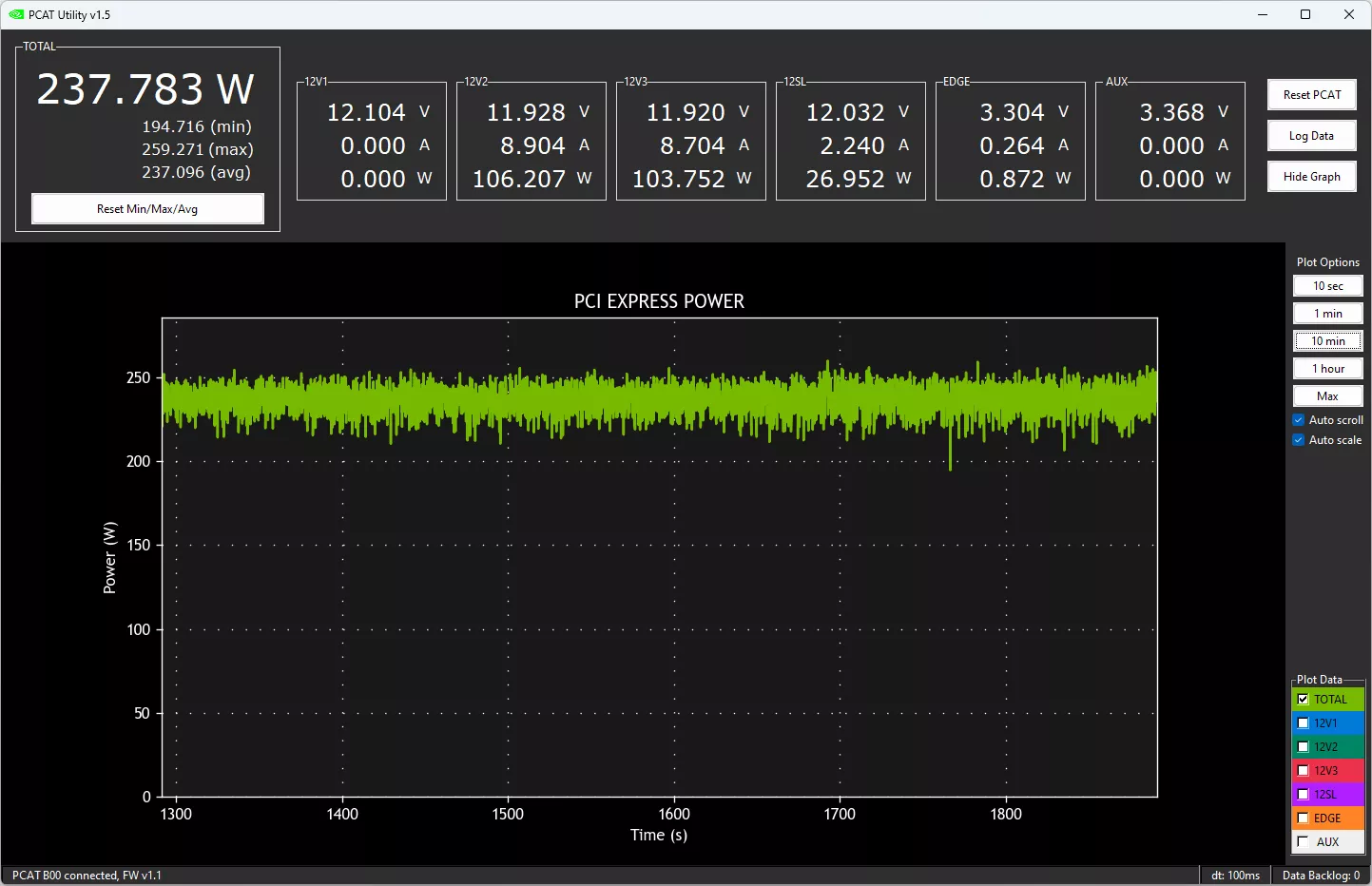

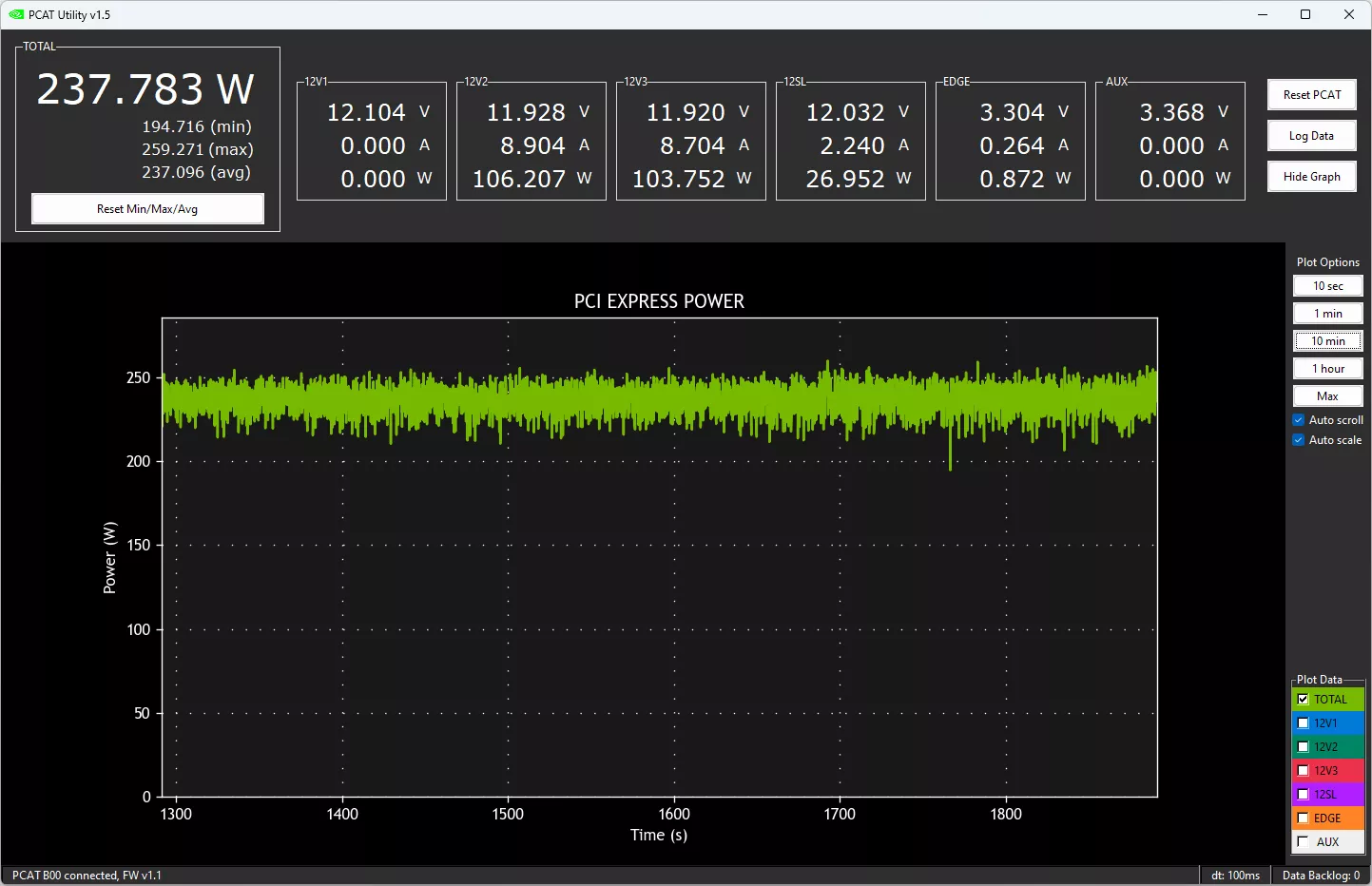

On note qu'à 7 occasions la carte dépasse les 230 W et qu'elle outrepasse significativement sa limite de consommation à 14 reprises. La moyenne s'approche toutefois des 220 W, du fait de titres moins gourmands. Pour boucler le sujet consommation, nous vous proposons le suivi durant 30 min d’une charge soutenue (A Plague Tale : Requiem en UHD) ci-dessous et qui confirme les points précédents avec 237 W absorbé en moyenne, sensiblement au-delà des 220 W annoncés.

PCAT : Nvidia GeForce RTX 4070 SUPER Founders Edition en charge

PCAT : Nvidia GeForce RTX 4070 SUPER Founders Edition en charge

Consommation en charge sous A Plague Tale : Requiem de la GeForce RTX 4070 SUPER FE

Efficacité énergétique

Afin d’évaluer l’efficacité énergétique des cartes, nous réalisons un indice basé sur les performances et puissances absorbées durant l'exécution de nos tests. Bien entendu, ces indices ne représentent que la situation au travers des jeux mesurés, durant ces scènes et avec les niveaux de détails sélectionnés, tout ceci pouvant varier assez largement dans des conditions de test différentes. Pour pallier à une partie de cette variabilité, nous ajoutons également la moyenne des indices énergétiques de chaque jeu en UHD (rastérisation + RT). Notre RTX 4070 SUPER FE, malgré ses quelques prises de liberté avec sa limite de puissance, s'avère tout aussi efficiente que que sa petite soeur sous notre jeu le plus gourmand. Elle la devance même en moyenne, talonnant la RTX 4080.

Efficacité énergétique en jeu - RTX 4070 SUPER

Avant de passer au verdict, intéressons nous à d’autres usages que le jeu page suivante.

Excellent test

La carte améliore le perf/prix chez nvidia c'est toujours une bonne chose mais je trouve que 12 go ça ne lui va pas bien

C'est sûr que 16 Go eussent été mieux, mais on est pas limité par les 12 Go pour l'heure, en particulier en QHD. Le bus mémoire 192-bit permet aussi de réduire significativement la taille du die (les interfaces sont moins denses en transistors et scalent moins bien en affinant la gravure comme l'a prouvé AMD), sur du 4/5 nm ce n'est pas négligeable en terme de coût pour une puce monolithique. Après Nvidia pourrait aussi sacrifier un peu de sa marge, mais vu qu'il en fait beaucoup plus sur les puces dédiées à l'IA et que TSMC n'arrive pas à suivre, je crois qu'il faut pas trop en demander pour le moment.

Tsmc peut suivre

C'est l'emballage des puces ia qui bloque pas la production des die

J'avoue que je n'ai pas suivi pour savoir où se trouvait la limitation. M'enfin t'as compris la remarque : pourquoi rogner sa marge quand tu peux faire plus de sous en privilégiant l'affectation des puces à l'IA plutôt qu'au gaming.

Je précise que je ne cautionne pas, mais je serais CEO je me poserais sérieusement la question.

Bah je te réponds ils peuvent produire plus si nvidia le décide

C'est l emballage du die avec l interposé et la hbm qui bloque

Chose que n'utilise pas les puces gaming

Ah mais tu n'utilises pas que du H100/H200 pour faire de l'IA, tu as aussi des produits comme les L40 (principalement utilisés en inférence) qui n'ont pas de HBM (puisque c'est un AD102) et qui margent plus qu'une GeForce.

Que penses tu d'un bus 128 bits avec 8 puces donc 16 go mais 64 mo de cache et ram à 24 gbps ?

Je ne suis pas architecte GPU, mais j'imagine que les ingénieurs de Nvidia ont fait leurs simulations et que l'option retenue pour AD104 était le meilleur compromis à leurs yeux.

Bah ça a 2 problème je pense que la puce serait pas plus petit le cache remplaçant les contrôleur ram en moins

Mais 2 puces ram en plus plus cher et version pro avec plus de ram impossible

C'est marrant tu fais les questions et les réponses 🙂

Très bon test !

l'evolution des graphs du site est plaisante, celui en fin de conclusion est très appréciable également !

Merci pour ton retour 😉

Merci bien, ça fait plaisir 😊

Je confirme qu'il est toujours aussi agréable de vous lire à travers ces tests toujours complets. Pour le produit, une carte diablement intéressante et bien foutue, dans ma gamme de conso, mais toujours assez chère malgré "l'effort" fait par nvidia pour la conserver au même prix que sa devancière. Tout progrès est bon à prendre, mais la majorité va continuer à s'intéresser à ce qu'il se passe à moins cher, alors qu'avant, cette gamme touchait plus de monde. Le 1080p a de beaux jours devant lui.

ça ressemble à une mise à niveau pour se caler un peu au dessus de la 7800xt en augmentant la conso ?