AD104

Pour ceux intéressés par l'architecture Ada Lovelace, nous vous renvoyons aux pages que votre serviteur/rédacteur lui avait consacrées, alors qu'il sévissait au sein d'un autre média. Comme nous l'indiquions en débutant ce dossier, NVIDIA utilise de nouveau AD104 pour animer la RTX 4070, après la déclinaison dédiée au modèle Ti. Son die est 22 % plus petit que celui d'AD103 officiant sur la RTX 4080, pour une superficie de 294 mm². Le procédé de gravure retenu est le même que celui des autres puces Ada, à savoir le très performant (et onéreux) 4N de TSMC, une version légèrement personnalisée du nœud de gravure 5 nm du fondeur Taïwanais. La densité est (très) légèrement supérieure à celle de son grand frère, du fait d'un bus mémoire plus étroit, les interfaces étant par nature moins denses en transistors que les unités de calculs ou le cache par exemple.

| Gravure |

GPU |

Nombre de transistors | Superficie Die |

Densité (Millions de transistors / mm²) |

|---|---|---|---|---|

| 4N TSMC | AD102 | 76,3 Milliards | 608,5 mm² | 125,4 |

| 4N TSMC | AD104 | 35,8 Milliards | 294,5 mm² | 121,6 |

| 4N TSMC | AD103 | 45,9 Milliards | 378,6 mm² | 121,2 |

| 5 nm + 6 nm TSMC | Navi 31 | 57,7 Milliards | 522 mm² | 110,5 |

| 7 nm TSMC | GA100 | 54.2 Milliards | 826 mm² | 65,6 |

| 6 nm TSMC | ACM-G10 | 21,7 Milliards | 406 mm² | 53,4 |

| 7 nm TSMC | Navi 21 | 26,8 Milliards | 520 mm² | 51,6 |

| 7 nm TSMC | Navi 22 | 17,2 Milliards | 335 mm² | 51,3 |

| 7 nm TSMC | Navi 23 | 11,1 Milliards | 237 mm² | 46,8 |

| 6 nm TSMC | ACM-G11 | 7,2 Milliards | 157 mm² | 45,9 |

| 8 nm Samsung | GA102 | 28,3 Milliards | 628,4 mm² | 45 |

| 8 nm Samsung | GA104 | 17,4 Milliards | 392 mm² | 44,4 |

| 8 nm Samsung | GA106 | 12 Milliards | 276 mm² | 43,5 |

| 7 nm TSMC | Navi 10 | 10,3 Milliards | 251 mm² | 41 |

| 7 nm TSMC | Vega 20 | 13.2 Milliards | 331 mm² | 39,9 |

| 16 nm TSMC | GP102 | 12 Milliards | 471 mm² | 25,5 |

| 14 nm GF | Vega 10 | 12.5 Milliards | 495 mm² | 25,3 |

| 16 nm TSMC | GP100 | 15,3 Milliards | 610 mm² | 25,1 |

| 12 nm TSMC | TU104 | 13,6 Milliards | 545 mm² | 25 |

| 12 nm TSMC | TU102 | 18,6 Milliards | 754 mm² | 24,7 |

| 12 nm TSMC | TU106 | 10,8 Milliards | 445 mm² | 24,3 |

AD104 intègre pas loin de 36 milliards de transistors, soit davantage que sur le précédent flagship (GA102), qui était pourtant plus de 2 fois plus grand (628 nm), mais gravé en 8 nm par Samsung. Si la RTX 4070 Ti utilisait la version intégrale d'AD104, ce n'est pas le cas ici. En effet, dans le but de certifier autant de puces aptes pour la RTX 4070 que possible, Nvidia a procédé à la désactivation d'un nombre conséquent d'unités au sein de son die. De quoi baisser le coût unitaire par puce, puisque TSMC facturant les Wafers à ses clients, plus ces derniers contiennent de puces opérationnelles, et plus les coûts de production par puce sont réduits.

| AD104 | RTX 4070 | RTX 4070 Ti |

|---|---|---|

| GPC | 4 | 5 |

| TPC / SM | 23 / 46 | 30 / 60 |

| FP32 | 5 888 | 7 680 |

| TMU | 184 | 240 |

| Tensor Cores | 184 | 240 |

| RT Cores | 46 | 60 |

| ROP | 64 | 80 |

| L2 (Mo) | 36 | 48 |

| Bus mémoire (bits) | 192 | 192 |

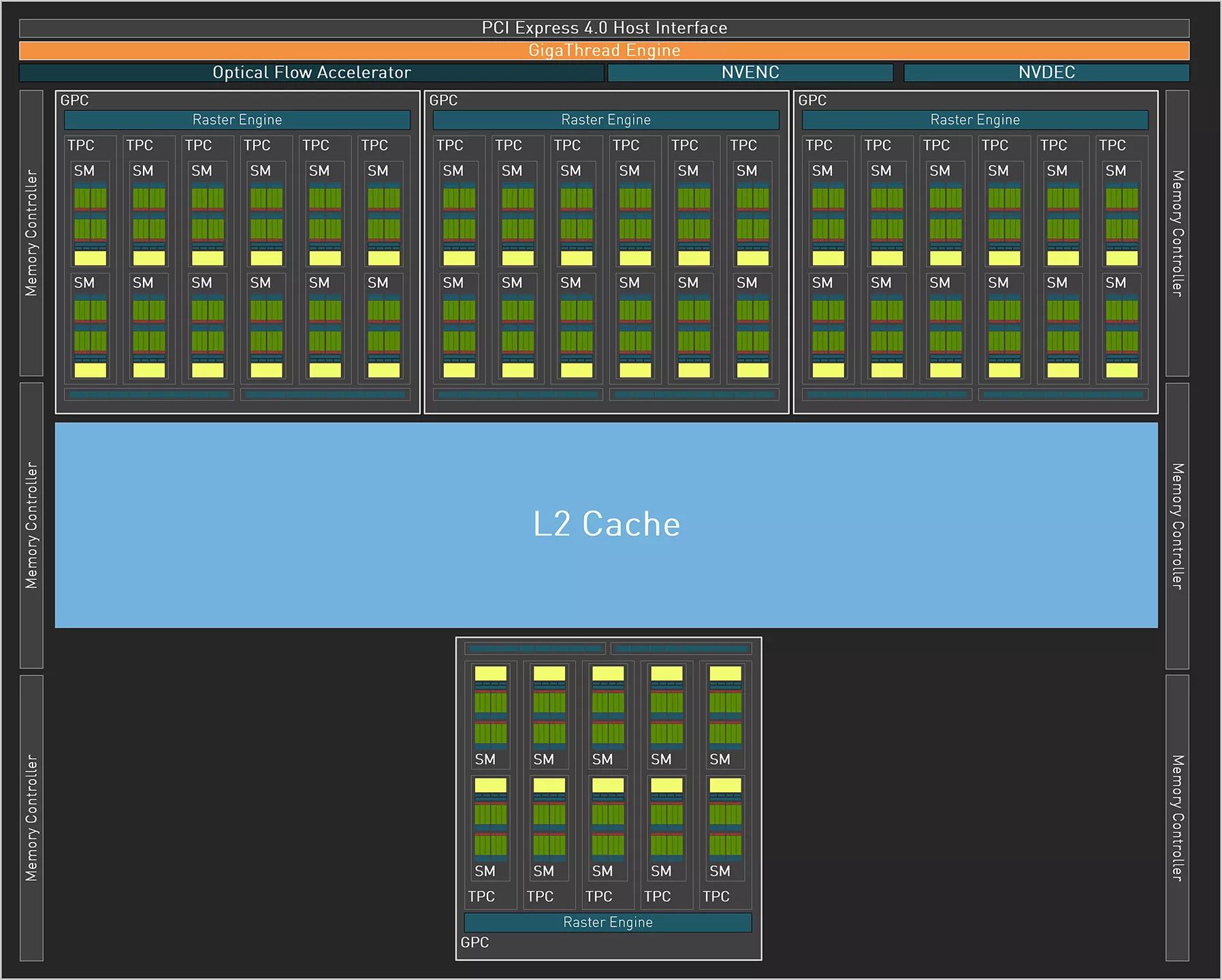

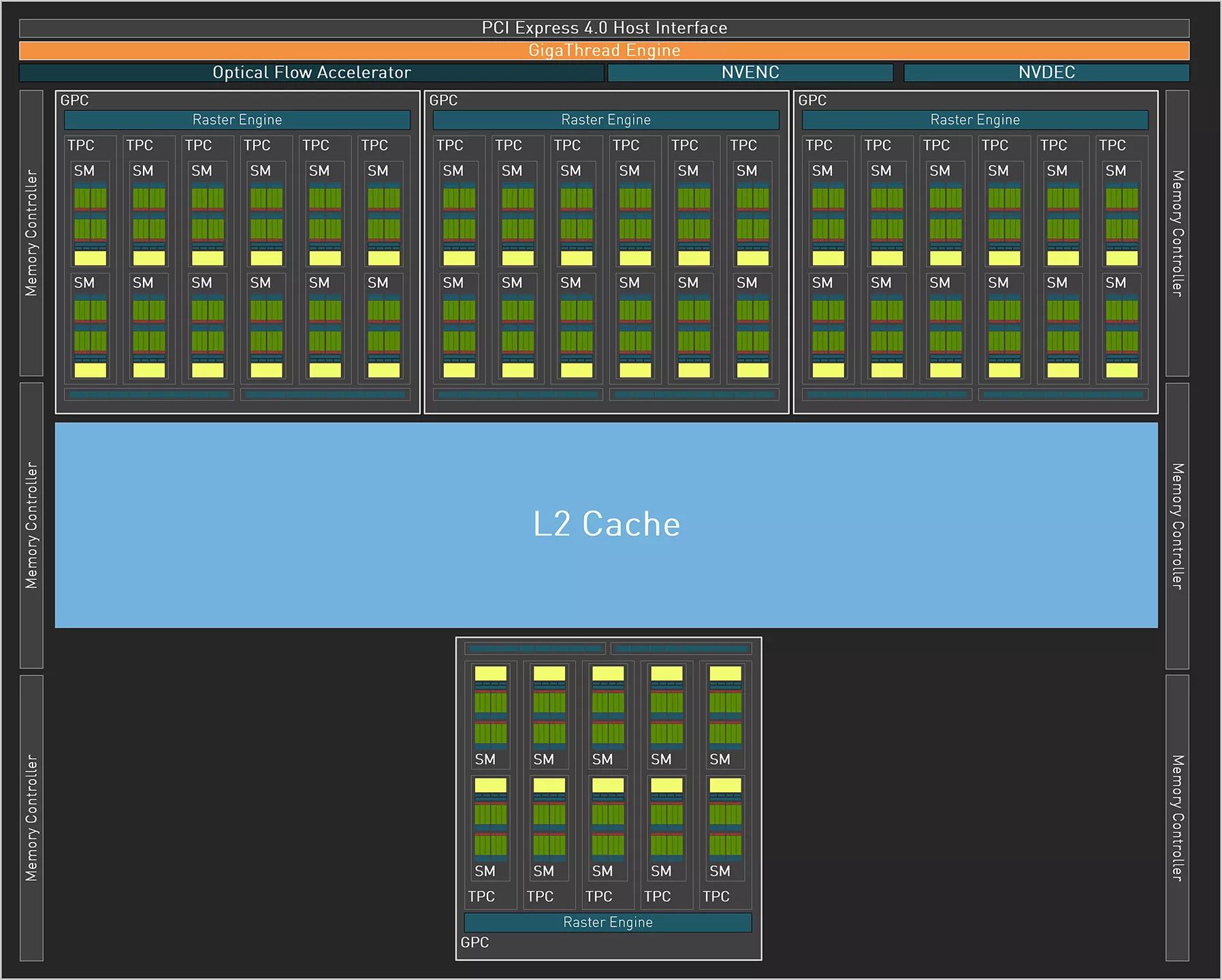

Un coup d'œil rapide au diagramme d'AD104 dans sa version RTX 4070, permet de constater que sur les 5 GPC inclus, seuls 4 sont activés. Qui plus est, un TPC est également désactivé parmi un des GPC actifs. Cela conduit à une réduction de 23% du nombre d'unités de calcul et de texturing. Du côté des unités de sortie ou ROP, la baisse est cette fois de 20 %. Enfin, si le bus mémoire reste identique à 192-bit, le cache L2 se voit lui, amputé de 25 %, à 36 Mo en tout et pour tout.

Diagramme GA104 de la RTX 4070

Diagramme GA104 de la RTX 4070

GA104 tel que configuré pour la RTX 4070

Pour le reste, le GPU de la nouvelle venue reprend les différents composants présents sur la version intégrale, mais avec une différence notable : exit le double encodeur, puisqu'un seul des deux sera activé pour la RTX 4070. Par contre, l'unité OFA, pierre angulaire de DLSS 3 est bel et bien présente. Du côté TGP, les verts ont retenu une valeur de 200 W, en baisse notable par rapport aux 285 W du modèle Ti. C'est également mieux que la RTX 3070, qui réclamait 220 W de son côté, et il faut remonter à la RTX 2070 (non SUPER), pour trouver une valeur moindre sur une carte de cette gamme. Il est temps de passer à la description de la carte de test page suivante.

Où ai-je écrit ça ? Je dis juste que les développeurs calent leur moteur 3D pour "tourner" sur les consoles qui ont une quantité de mémoire limitée. Du coup avec 12 Go en QHD, il y aura possibilité de tourner très correctement durant leur vie commerciale. Et puis passer le réglage d'ultra à très élevée pour les textures dans cette définition, ça n'a que rarement une différence visuelle notable.

Mais où ai-je écrit que le visuel en Ray Tracing était différent entre RTX et RX ?? Faut lire ce qui est écrit et pas interpréter. Et désolé, mais il n'y a jamais eu de version propriétaire "RTX pur jus" du Ray Tracing, puisque dès le début tous les jeux s'appuient sur DXR (ou VUlkan RT). Le fait est que l'unité d'accélération RT des RDNA2 est anémique et ne supporte pas les charges lourdes du fait d'un défaut de conception. Cela te gêne peut-être de le lire, mais le comportement de ces cartes en RT l'atteste. La version RDNA3 corrige en partie ces problèmes, mais reste bien moins performante que celle d'Ada, il suffit de regarder le test DXR de 3DMark en page 4 pour s'en assurer. Enfin, comme écrit dans mon message et le dossier, le RT dans les jeux actuels (hormis les jeux en path tracing) est hybride. Si une carte donnée a une avance suffisante en rastérisation, ses performances finales une fois le RT activé, pourront être supérieures à celles d'une autre moins impactée par la charge RT. Seulement, cela dépendra justement du niveau de charge RT, et plus les jeux en feront usage intense, plus les RDNA2 souffriront, ne t'en déplaise.

Et ça bride en quoi le DP 1.4a pour une carte taillée pour le QHD ? Concernant ce que tu appelles le "fake frame generation" (impatient de lire ce que diront certains quand le FSR3 proposera la même chose, voir si les images insérées seront aussi taxées de fake). Autant parler de fake pixels pour les DLSS/FSR/XeSS puisqu'on en est là. Pour ta gouverne, si tu n'actives pas le FG, c'est du DLSS 2.x, donc écrire "DLSS 3.0 qui n'est mieux qu'avec le FG" n'a tout simplement pas de sens. Et avec un bus 192-bit, tu mettrais 24 Go pour une carte prévue pour le QHD ? Il faut arrêter ce délire avec la mémoire. Maintenant on a bien compris que Nvidia c'était pas ta came, c'est ton droit, mais ça ne t'autorise pas à balancer des âneries ou déformer mes propos.

Pouce bleu.

Rouston rouge