AD104

Pour ceux intéressés par l'architecture Ada Lovelace, nous vous renvoyons aux pages que votre serviteur/rédacteur lui avait consacrées, alors qu'il sévissait au sein d'un autre média. Comme nous l'indiquions en débutant ce dossier, NVIDIA utilise de nouveau AD104 pour animer la RTX 4070, après la déclinaison dédiée au modèle Ti. Son die est 22 % plus petit que celui d'AD103 officiant sur la RTX 4080, pour une superficie de 294 mm². Le procédé de gravure retenu est le même que celui des autres puces Ada, à savoir le très performant (et onéreux) 4N de TSMC, une version légèrement personnalisée du nœud de gravure 5 nm du fondeur Taïwanais. La densité est (très) légèrement supérieure à celle de son grand frère, du fait d'un bus mémoire plus étroit, les interfaces étant par nature moins denses en transistors que les unités de calculs ou le cache par exemple.

| Gravure |

GPU |

Nombre de transistors | Superficie Die |

Densité (Millions de transistors / mm²) |

|---|---|---|---|---|

| 4N TSMC | AD102 | 76,3 Milliards | 608,5 mm² | 125,4 |

| 4N TSMC | AD104 | 35,8 Milliards | 294,5 mm² | 121,6 |

| 4N TSMC | AD103 | 45,9 Milliards | 378,6 mm² | 121,2 |

| 5 nm + 6 nm TSMC | Navi 31 | 57,7 Milliards | 522 mm² | 110,5 |

| 7 nm TSMC | GA100 | 54.2 Milliards | 826 mm² | 65,6 |

| 6 nm TSMC | ACM-G10 | 21,7 Milliards | 406 mm² | 53,4 |

| 7 nm TSMC | Navi 21 | 26,8 Milliards | 520 mm² | 51,6 |

| 7 nm TSMC | Navi 22 | 17,2 Milliards | 335 mm² | 51,3 |

| 7 nm TSMC | Navi 23 | 11,1 Milliards | 237 mm² | 46,8 |

| 6 nm TSMC | ACM-G11 | 7,2 Milliards | 157 mm² | 45,9 |

| 8 nm Samsung | GA102 | 28,3 Milliards | 628,4 mm² | 45 |

| 8 nm Samsung | GA104 | 17,4 Milliards | 392 mm² | 44,4 |

| 8 nm Samsung | GA106 | 12 Milliards | 276 mm² | 43,5 |

| 7 nm TSMC | Navi 10 | 10,3 Milliards | 251 mm² | 41 |

| 7 nm TSMC | Vega 20 | 13.2 Milliards | 331 mm² | 39,9 |

| 16 nm TSMC | GP102 | 12 Milliards | 471 mm² | 25,5 |

| 14 nm GF | Vega 10 | 12.5 Milliards | 495 mm² | 25,3 |

| 16 nm TSMC | GP100 | 15,3 Milliards | 610 mm² | 25,1 |

| 12 nm TSMC | TU104 | 13,6 Milliards | 545 mm² | 25 |

| 12 nm TSMC | TU102 | 18,6 Milliards | 754 mm² | 24,7 |

| 12 nm TSMC | TU106 | 10,8 Milliards | 445 mm² | 24,3 |

AD104 intègre pas loin de 36 milliards de transistors, soit davantage que sur le précédent flagship (GA102), qui était pourtant plus de 2 fois plus grand (628 nm), mais gravé en 8 nm par Samsung. Si la RTX 4070 Ti utilisait la version intégrale d'AD104, ce n'est pas le cas ici. En effet, dans le but de certifier autant de puces aptes pour la RTX 4070 que possible, Nvidia a procédé à la désactivation d'un nombre conséquent d'unités au sein de son die. De quoi baisser le coût unitaire par puce, puisque TSMC facturant les Wafers à ses clients, plus ces derniers contiennent de puces opérationnelles, et plus les coûts de production par puce sont réduits.

| AD104 | RTX 4070 | RTX 4070 Ti |

|---|---|---|

| GPC | 4 | 5 |

| TPC / SM | 23 / 46 | 30 / 60 |

| FP32 | 5 888 | 7 680 |

| TMU | 184 | 240 |

| Tensor Cores | 184 | 240 |

| RT Cores | 46 | 60 |

| ROP | 64 | 80 |

| L2 (Mo) | 36 | 48 |

| Bus mémoire (bits) | 192 | 192 |

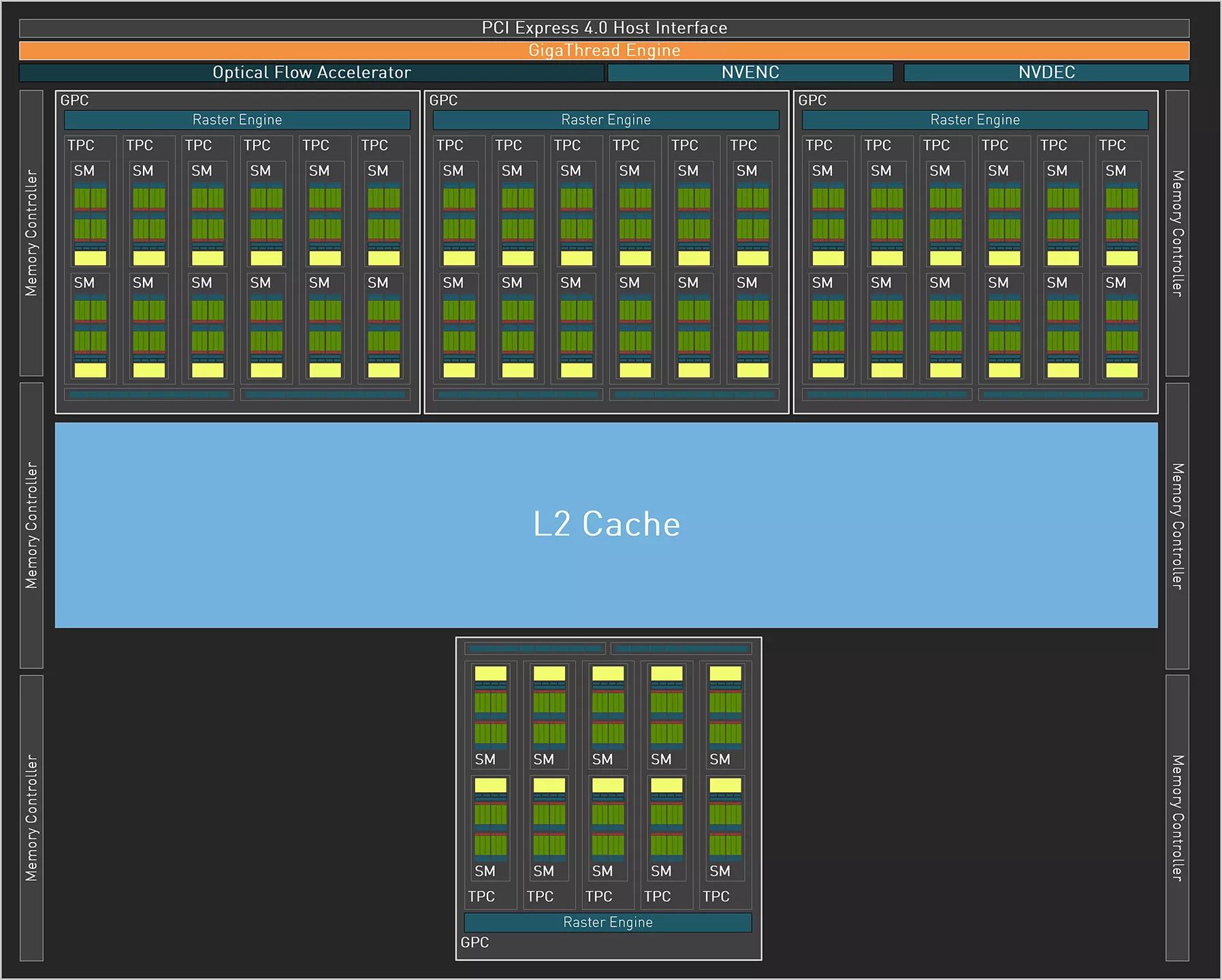

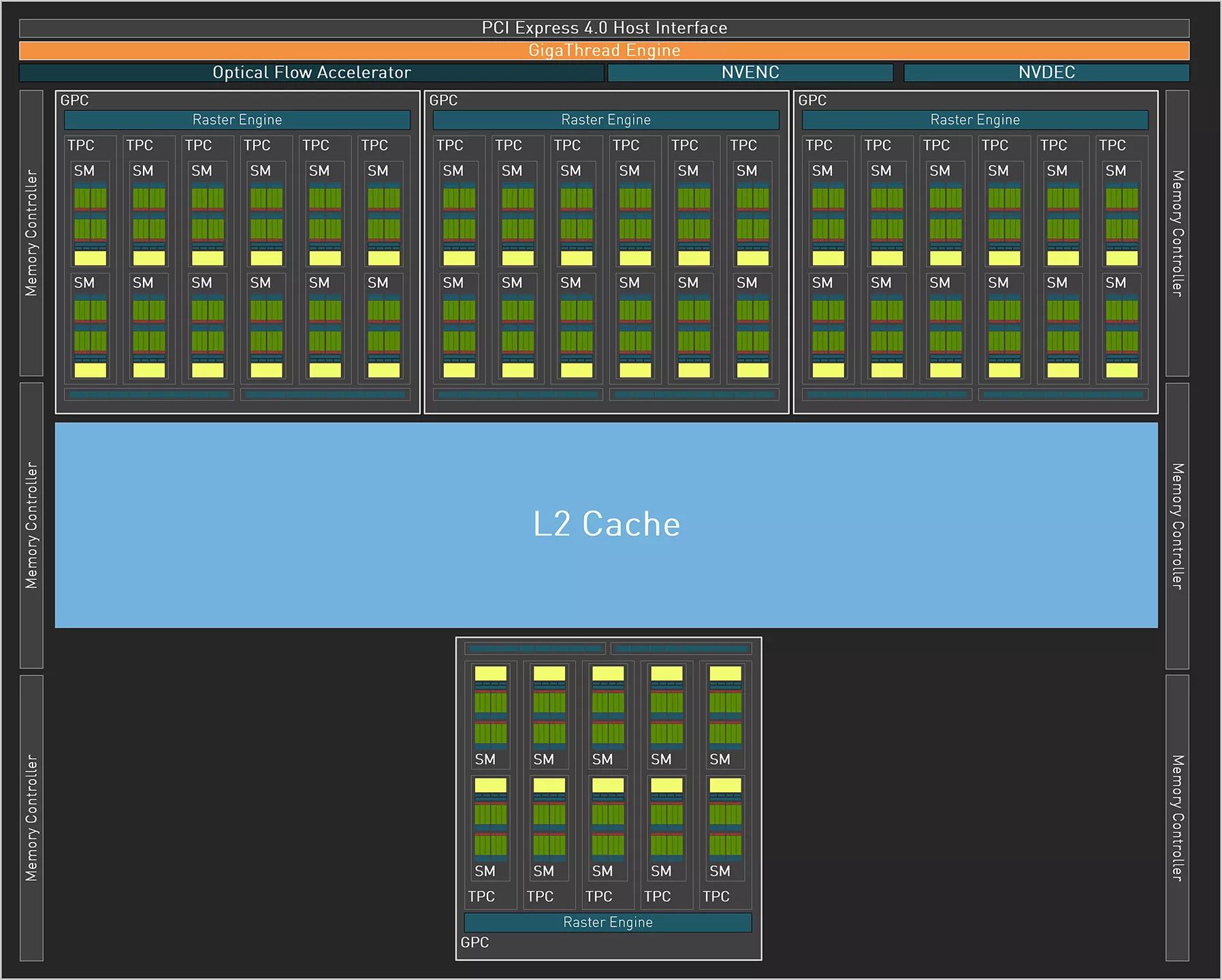

Un coup d'œil rapide au diagramme d'AD104 dans sa version RTX 4070, permet de constater que sur les 5 GPC inclus, seuls 4 sont activés. Qui plus est, un TPC est également désactivé parmi un des GPC actifs. Cela conduit à une réduction de 23% du nombre d'unités de calcul et de texturing. Du côté des unités de sortie ou ROP, la baisse est cette fois de 20 %. Enfin, si le bus mémoire reste identique à 192-bit, le cache L2 se voit lui, amputé de 25 %, à 36 Mo en tout et pour tout.

Diagramme GA104 de la RTX 4070

Diagramme GA104 de la RTX 4070

GA104 tel que configuré pour la RTX 4070

Pour le reste, le GPU de la nouvelle venue reprend les différents composants présents sur la version intégrale, mais avec une différence notable : exit le double encodeur, puisqu'un seul des deux sera activé pour la RTX 4070. Par contre, l'unité OFA, pierre angulaire de DLSS 3 est bel et bien présente. Du côté TGP, les verts ont retenu une valeur de 200 W, en baisse notable par rapport aux 285 W du modèle Ti. C'est également mieux que la RTX 3070, qui réclamait 220 W de son côté, et il faut remonter à la RTX 2070 (non SUPER), pour trouver une valeur moindre sur une carte de cette gamme. Il est temps de passer à la description de la carte de test page suivante.

Heu, dur à trouver des 6800 XT ? Pendant 6 jours on pouvait avoir une Carte graphique Sapphire Pulse AMD Radeon RX 6800 XT Gaming OC à 569€ chez RdC vendue par RdC.

Pourquoi du coup si les wafer sont si cher faire les die si grand ?

Je m'explique sachant que le ga104 a un bus 192 bits et du coup 12 go de vram quel intérêt de faire une 4070 ti avec ?

Mettre 4 gpc et non 5 coûterait moins cher à produire

Une carte aussi puissante que la 4070 ti aurait mérité un ad103 castré bus 224 bits comme ça 14 go

Pour appuyer ce que vous dites

https://cdn.mos.cms.futurecdn.net/AtNozaoGiNMBtrnDWTADSQ-970-80.png.webp

Et ce n'est pas prêt de s'arranger. Pour la SRAM, la loi de Moore est quasiment terminé, et ne bénéficiera plus de réductions de tailles sur les nodes plus avancé. Ça veut dire des surfaces équivalentes mais des mm² qui coûteront plus chère sur les générations suivantes, pour une même quantité de cache. D'où l'intérêt des chiplets et de techno de gravure différentes pour chaque partie, adopté par AMD. NVidia aussi devrait s'y mettre.

A part une meilleures perfs en RT (et encore), cette carte ne met certainement pas la 6800 XT de Novembre 2020 à la retraite... Surtout vu son prix !! Et elle risque de moins bien vieillir avec juste 12Go de VRAM plus lents en bande passante que les 3070Ti.

Elle consomme 100 W de moins en charge, propose un encodeur AV1 et le DLSS 3. La bande passante mémoire tu ne peux pas la comparer directement à celle de la 3070 Ti, vu la multiplication du cache L2 entre les deux puces. Enfin, 12 Go, c'est loin d'être insuffisant, il ne faut pas oublier que les plateformes de développement, ce sont les consoles. Avec la génération actuelle qui dispose de 16 Go unifiés, si tu enlèves les besoins du CPU, tu as grand max 10/12 Go disponibles pour le GPU. Ca n'empêchera pas certains titres de faire de la surenchère avec des textures XXL, mais généralement la différence ne sera pas flagrante entre celle stockées dans 12 Go et d'autres dans 16 Go.

Et pour le RT, il n'y a vraiment pas photo, les cas où la 6800 XT fait illusion en performance, ce sont ceux des jeux où les effets sont tellement réduits qu'ils ne se voient pas, ce qui lui permet lorsqu'elle a suffisamment d'avance en rastérisation pure, de rester devant en hybride (là aussi c'est clairement expliqué dans le dossier). Par contre, dès que la charge RT monte, les RDNA 2 s'effondrent, leurs unités dédiées n'étant pas au niveau. Des 6800 XT, il y en a de moins en moins, (oui ok tu en trouves encore ponctuellement à bon prix), mais ça sera de moins en moins le cas, et payer au même prix voir plus chère une 6800 XT qu'une 4070, ne me semble pas une bonne idée, d'où la mise à la retraite. Maintenant l'occasion fait le larron, et avec un très bon prix, n'importe quelle référence peut devenir une excellente affaire.

Depuis quand les portages consoles vers PC se limite aux spécifications des consoles ? C'est justement car ils ont de la puissance en plus que les portages peuvent être plus beaux, plus ambitieux niveaux nombre et taille de textures et surtout en terme de vitesse d'affichage. Les jeux qui sont capables de faire du UHD en 60Hz NATIF ça se compte sur les doigts des mains sur console. Les joueurs PC ont des écrans 120/144Hz avec VRR, donc des besoins différents...

Pour ce qui est du RT, c'est encore plus gênant la réponse, les effets RT sont les mêmes entre les RTX et RX... Qu'ils soient plus lents, j'en conviens, surtout quand l'implémentation est la version "propriétaire" de chez nVidia (pas de DXR mais du RTX pur-jus). Il n'y a qu'a voir l’implémentation Lumen et Nanite du RT de UE5.1, la 4070Ti est derrière (de peu) la 7900XT ! Et UE5 ça risque d'être pas mal de jeux dans les mois à venir.

Après libre à vous de dire qu'un carte limitée au DP1.4a (tiens comme la 6800XT), avec un DLSS 3.0 qui n'est mieux qu'avec la Fake Frame Generation en terme de vitesse (y'a qu'à voir les artefacts dans F1 2022, c'est pas encore ça !!), bridée à 12Go (et le FFG ça en prend entre 0,8 et 1,4Go !) car il ne faudrait pas que les cartes GP soient utilisé à la place des cartes Pro vendues à prix d'or (et donc nVidia se fait des marges hallucinantes), avec une rastérisation digne des concurrentes en ... 2020 vendues bien plus chères que la concurrence.

Alors si c'est pour virer le RT dans 8/12 mois par manque de VRAM, on va bien les sentir les "juste 650€" d'une carte milei de gamme.

on en trouve neuve à 639.99€ des 4070 signées Palit

Moui, je suis très mitigé concernant cette carte. Habituellement la gamme 70 c'est les perfs de la gamme 80 de la précédente génération +20% et une décote allant de 30 à 40%. Là, on a difficilement les perfs d'une 3080 pour presque le tarif MSRP d'une 3080. Bien sûr le rapport perf/conso est très bon mais encore heureux, ai-je envie de dire, quand on passe de 8 à 4nm. S'ajoute à ça une quantité de vram une fois encore calculée au plus juste. Ça commence à faire beaucoup.

Le plus hallucinant, c'est que cette carte aurait probablement été la 4070 Ti si Nvidia n'avait pas rétrogradé la 4080 12gb en 4070 Ti.

J'imagine que Nvidia a jugé qu'il valait mieux privilégier la puissance de calcul que la bande passante / quantité de mémoire. Vu le résultat, on peut difficilement leur donner tord pour l'heure. Maintenant ce n'est que pure spéculation de ma part, je ne suis pas dans la tête des architectes ni des stratèges de la compagnie.

Ah, ça fait plaisir de retrouver les tests.

Content de voir enfin une conso raisonnable sur ce genre de carte. Par contre, je trouve toujours que c'est très cher et j'ai l'impression que ça ne choque plus grand monde. Hier je matais un site US et il titrait "4070 review : 600 dollars mid-range is here". Mais d'ou cette gamme de carte à plus de 600 balles est devenue le milieu de gamme ? Je trouve ça lunaire.

Quant aux 4060 Ti/4060 qui devraient débarquer sous peu, si c'est du 500 balles vendu avec seulement 8 Go de vram, non merci, c'est du foutage de gueule.