Conclusion et directions de recherche

Depuis ses débuts timides au milieu du siècle dernier jusqu’à l’explosion de ChatGPT, les réseaux de neurones sont passés du fantasme fou de chercheurs à une machinerie performante capable d’effectuer de nombreuses tâches allant de la reconnaissance d’image à la discussion — même si cette dernière montre vite ses limites face à un utilisateur un tant soit peu vigilant. Cette explosion s’est effectuée pas à pas, et doit énormément aux GPU et à NVIDIA qui, dans les années 2010, a grandement participé au développement et à l’accélération de sa prolifération.

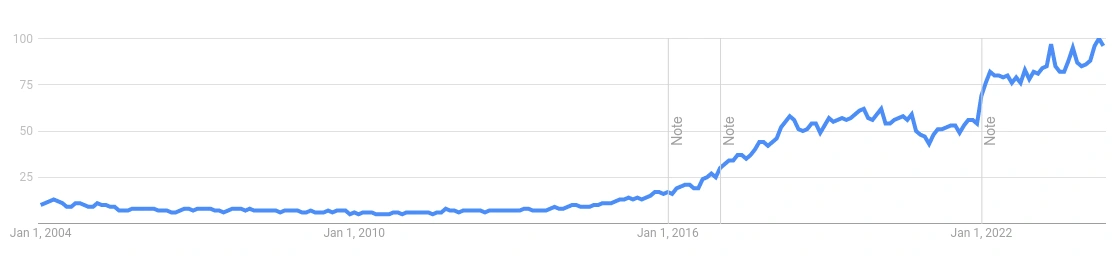

L’évolution de la popularité du machine learning dans les recherches Google : la bulle n’a pas fini de monter !

Du côté pratique, l’IA a sans nul doute révolutionné les applications de l’informatique, particulièrement dans les domaines de la reconnaissance d’image, de la transcription et de la synthèse vocale, ou encore de la génération de texte/image. Pour autant, sa puissance demeure limitée et son utilisation cantonnée à des tâches spécifiques voire rébarbative pour un humain : à vous de juger l’« intelligence » de la chose. Pour autant, la popularité du Machine Learning est encore loin de s’estomper vu l’engouement de l’industrie à son sujet ! Nombreuses sont les start-ups à vouloir se tailler une part du gâteau IA… Reste à voir si ledit gâteau est suffisamment généreux pour tous ou si « The cake is a lie ». Bien que la croissance de l’IA ait de beaux attributs la rapprochant d’une bulle, nombreux sont les domaines encore peu explorés, citons par exemple les questions de sécurité et de protections des réseaux (ou contre les réseaux). Et, dans cette ruée vers le machine learning, les concepteurs de matériel sont aux premières loges, le carnet de commandes de NVIDIA affichant un an de délai pour une H100 qui a été dévoilée en… mars 2022.

Face aux GPU, le pragmatisme voudrait que les architectures dédiées, par essence plus efficaces, dominent à terme le marché de la haute performance, cette prédiction est freinée par deux écueils. D’une part, le prix de ces accélérateurs est lié à leur popularité, car le coût du design et de la maintenance des logiciels qui les accompagne est astronomique — bienvenue dans le monde merveilleux du hardware ! Cela signifie que bon nombre d’entre eux restent tarifés trop haut par rapport aux moyens de certaines entreprises (surtout si la machine se destine également à d’autres tâches que le machine learning, ce qui est le cas notamment des supercalculateurs destinés à la recherche). De plus, qui dit spécialisé dit… spécialisé. À un type d’architecture de réseau ou, tout du moins, aux types d’architecture en vogue au moment du design ; ce qui peut être quelques années avant la sortie du matériel en question. Entre-temps, les besoins peuvent avoir changé, et la perspective de se retrouver avec du matériel inefficace dans quelques années a de quoi rebuter — d’autant plus que les progrès annuels en matière de lithographie se chargent déjà de rendre les machines obsolètes au fur et à mesure des années.

Les androïdes et leurs rêves de moutons électriques, ça n’est (heureusement) pas pour tout de suite !

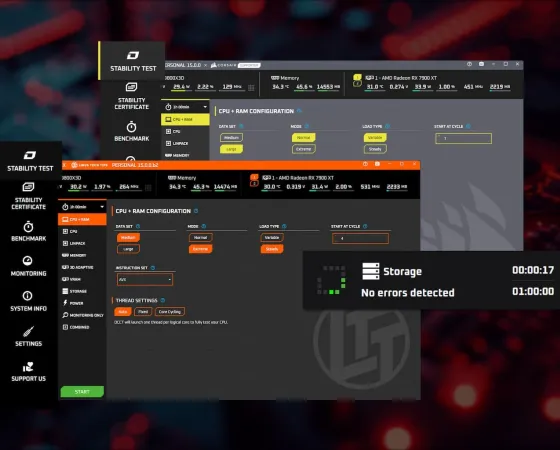

Reste qu’un pan de la recherche contemporaine se concentre sur les réseaux creux (ou sparse), c’est-à-dire des réseaux dans lesquelles une partie des neurones de certaines couches est tout bonnement et simplement supprimée afin de réduire la quantité de calcul nécessaire sans pour autant impacter la précision du réseau. Dans ce domaine-là, les architectures actuelles montrent rapidement leurs limites, car les accès à la mémoire passent de linéaires (accès à tous les poids et biais d’une couche selon une liste connue et régulière) à un motif aléatoire (liste des poids différents de zéro irrégulière et plus ou moins imprévisible). Et, si vous suivez les performances des mémoires, si les débits sont toujours très bons en accès séquentiel, l’aléatoire peut plomber sérieusement les performances ! Si, sur ce point-là, NVIDIA fait — une fois encore — bonne figure avec une première intégration de la sparsité dans ses GPU à partir de la génération Ampere, cette dernière se base toujours sur un modèle séquentiel d’accès à la mémoire suivi par une sélection : un choix qui aura du mal à passer à l’échelle si la proportion de creux dans les réseaux venait à s’intensifier. Son concurrent, AMD n’est pour le moment pas mieux loti puisque seule la série Radeon Instinct MI300 intègre des unités adaptées aux matrices creuses pour lesquelles des restrictions similaires à celles de NVIDIA s’appliquent. Pour le moment, l’équation se résout en intégrant des accélérateurs basse consommation pour l’inférence immédiate, et en laissant de gros GPU s’occuper de l’entraînement et/ou d’inférence de masse en datacenters ; une spécialisation qui ne semble définitivement pas près de s’arrêter !

Merci beaucoup pour cet article, j'en avais bien besoin. J'ai découvert de nombreux détails, notamment la problématique du sur apprentissage.

Heureux de t'avoir été utile :D !

Pas encore lu, mais sur la vignette miniature de la colonne des dossiers, j'ai bien cru que c'était le majeur qu'il tendait. Ça commence bien...

"F*ck, la race humaine" 🤣

Merci pour ce dossier que j'ai lu avec beaucoup de retard. C'est complet, détaillé, et surtout pointu malgré la presque absence de maths.