La carte par devant, par derrière, et même de côté !

L'emballage qui protège la carte graphique n'est pas très grand et est peu épais, normal pour une carte mini-ITX nous direz-vous. En guise de bundle, pas grand chose pour ne pas dire rien : un guide d'installation rapide et c'est fini. D'un autre côté, c'est un modèle d'entrée de gamme, mettre un bundle alourdirait le prix et serait contreproductif ! La carte mesure 17 cm de long, double slot et affleure l'équerre arrière. Son poids ? Il est identique à l'année où les germains ont envahi la Gaule, ou Constantinople s'est faite raser par un ouragan. Comme vous êtes des historiens accomplis, et que ça vous passionne, on vous dit 407, soit le poids en gramme de ce petit bout de carte.

Le ventirad est petit, même si 17 cm ça compte, il y a moins d'impact sur une carte graphique. Pas de chichis ici, on a droit à une sorte de radbox CPU avec une base plus grande, qui est en contact avec le GPU et les 4 puces de GDDR6. Pas de caloduc, de cuivre, le radbod est un bloc d'aluminium taillé, ovale et disposé dans le sens de la longueur. On peut faire difficilement plus basique, mais c'est aussi le but. Le ventilateur, unique, de type axial, mesure 90 mm de diamètre. Les pales sont striées et dentelées, et non jointes. Selon GIGABYTE, ces stries améliorent un peu plus la qualité de la ventilation en focalisant mieux le souffle à l'intérieur du radiateur. Quasiment tous les moulins de la firme sont comme ça.

La carte fait 2 slots, avec une équerre ajourée. Les 4 connecteurs graphiques occupent la rangée inférieure, sont constitués par deux DP 1.4a et deux HDMI 2.1.

Au verso, il n'y a rien de plus que des petits composants électroniques, les 4 vis qui fixent le bloc d'aluminium, et deux autres pour maintenir l'équerre arrière métallique. Pas de backplate, mais pas de composant qui chauffe type VRAM.

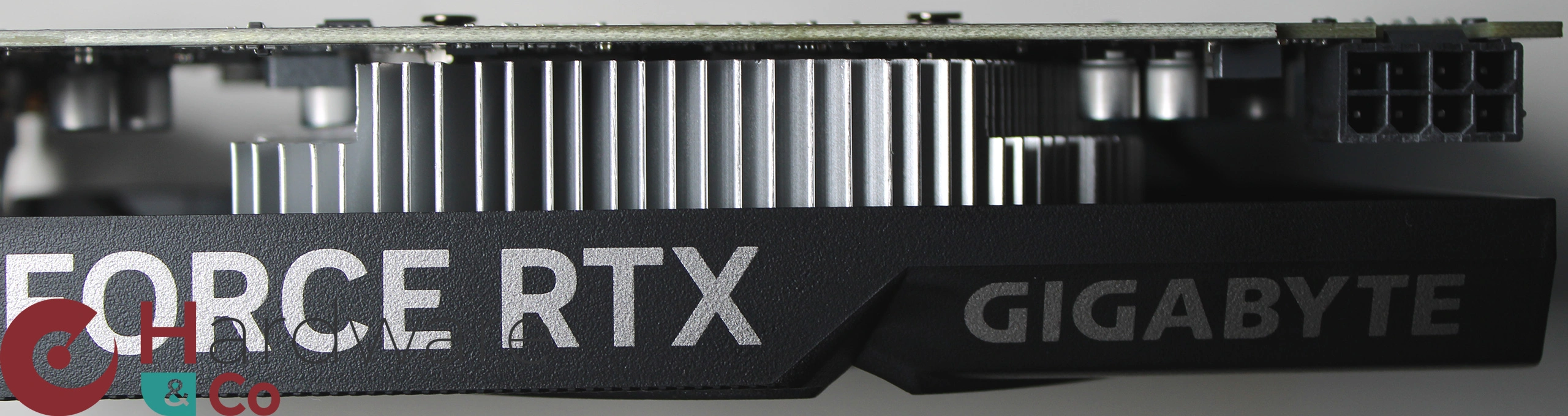

Voici une vue plus rapprochée du radiateur, pour voir les travées d'aluminium. et les entailles qui laissent la place aux condensateurs. L'alimentation se fait via un connecteur 8 pins qui apporte 150 W aux 75 déjà initiés par le slot PCIe. Bien que le TGP soit de 115 W, la carte dispose d'une réserve de 225 W. Facile !

Protocole

C'est le cœur de notre article. Une carte custom offre bien souvent des performances identiques avec presque toutes les autres. Nous avons décidé donc de tester cette série avec deux jeux seulement, avec les options les plus violentes Ultra/Max, et en rastérisation pure. La définition retenue est celle que préconise NVIDIA pour sa série, à savoir le 1920 x 1080. Nous avons choisi le preset Ultra pour les deux jeux testés, sans upscaling ni RT. Nous avons porté notre choix sur A Plague Tale Requiem, car il est l'un des plus beaux jeux du marché, ce qui implique une grosse charge. L'autre titre est Cyberpunk 2077. Avec ces deux titres exigeants, en version GOG, nous avons la certitude que les mises à jour ne modifieront pas le comportement du jeu au fil du temps. Et ainsi, nous pourrons comparer les cartes au même GPU entre elles. C'était le cas avant, mais devenait impossible quand les tests étaient trop espacés dans le temps, les éditeurs mettant à jour très souvent leurs jeux.

Toutes les cartes employant le même GPU, finalement, se différencient sur plusieurs points : la qualité de la puce qui permet aux constructeurs d'overclocker de série les cartes, la qualité du refroidisseur qui permet de maintenir des températures plus ou moins basses assurant des fréquences élevées en charge, les nuisances sonores liées aux profils décidés par les marques, l'embonpoint qui va de pair avec la taille du refroidisseur, les nuisances sonores et les températures, et enfin la qualité de l'électronique qui permet de voir une stabilité dans le comportement de la carte dans le temps et lors de fortes charges, etc. Bref, les leviers sont peu nombreux, mais permettent néanmoins d'avoir des cartes aux profils très variés ! Nous étudierons donc la consommation des cartes avec le module PCAT, qui lit directement la consommation de la carte par le slot PCIe, et n'est pas pollué par une autre consommation. C'est la vraie conso qui est donnée, pas celle parfois de l'API et que l'on retrouve sur les vidéos YT via Afterburner par exemple. Point de tricherie, nous aurons la vraie mesure !

Nous avons monitoré les nuisances sonores au repos, qui correspondent au bruit de fond de votre intérieur, mais elles n'apparaissent pas dans le tableau puisque notre sonomètre ne débute qu'à 30 dB(A). Pour ce qui est des nuisances en jeu, là aussi nous avons enregistré cela lors d'une session de jeu de 10 minutes afin de laisser le temps à la carte de se stabiliser. Ce n'est pas tout : afin de voir si la carte ventile à fond pendant du gaming, nous avons aussi monitoré le boucan qu'elle peut être amenée à faire si sa ventilation grimpe à 100 %, ce réglage est manuel et volontaire, ce n'est pas un comportement de la carte. C'est intéressant de voir si la carte a de la marge avant de vous casser les oreilles, ou si d'emblée, elle est à son maximum. Le confort ne sera forcément pas le même, 100 % représentant le point infernal qu'il ne faut surtout pas atteindre, et qui serait le signe d'une conception bâclée ou d'un modèle défectueux. Notez que tous les ventilateurs sont coupés au moment de ces relevés de bruit, sauf ceux de la carte graphique qui sont gérés par la carte elle-même.

Enfin, dernier point, afin de juger de l'efficacité générale du refroidisseur, nous avons enregistré les fréquences durant une session de 20 minutes du jeu A Plague Tale Requiem. Avec cela, vous trouverez également la température du GPU, du hotspot (le point le plus chaud du PCB), et le pourcentage du TGP. Cela donne une vision en un coup d'œil qui est riche d'enseignements sur la capacité du refroidisseur à dissiper la chaleur due à l'effet Joule, et la qualité de la puce. Vous pourrez en profiter pour voir notre nouveau module graphique en action, avec toutes les mesures en temps réel et consultables, sans oublier le zoom des courbes, ou encore la possibilité de cacher ou pas certaines lignes en cliquant sur la légende.

Configuration

Nous avons changé cette dernière depuis nos anciens tests pour plus de commodité, sur une table de bench. Elle est désormais basée sur une plateforme LGA1700, terriblement efficace pour jouer. Ce sont les pilotes NVIDIA GeForce 560.70 qui moulinent. La voici :

| UN KEZAKAL | DES KEZAKO |

|---|---|

| CPU + COOLING | Core i9-13900K / Noctua NH-U12A Chromax.black |

| CARTE MERE | |

| RAM | G.Skill 2 x 24 Go DDR5 7200C36 Trident Z5 RGB |

| CARTE GRAPHIQUE | GIGABYTE RTX 4060 D6 8G |

| ALIMENTATION | Be Quiet! Dark Power Pro 12 1200 W 80PLUS Titanium |

| BOITIER | Table de bench standard |

| STOCKAGE | Samsung 990 Pro 1 To |

Je trouve cette carte hyper honnête pour du FHD! Elle consomme quedal! On lui en demande pas plus.

Juste son prix avec un petit 40-50€ en moins, ça l'aurait fait, surtout avec la nouvelle gen qui arrive!

Merci pour ce dernier test de cette année !

Et bon réveillon du nouvelle an à tous !

en fait, elle est moins chère normalement, mais en fin d'année, ils montent tous leurs prix...

C'est un produit coherent, avec un ventirad de taille raisonnable par rapport aux capacites de la carte, et le prix de 316 euros est correct

En gros avec un casque anti bruit tu ne l'entends plus, carte sympa pour les fans de boitiers à faible volume.

Bonjour Thibaut,

Citation "Elle [la configuration de test] est désormais basée sur une plateforme LGA1700, terriblement efficace pour jouer."

Simplement par curiosité, je voudrais savoir Thibaut, comment tu qualifierais la configuration de test, si elle avait été basée (et elle ne l'est pas à mon grand regret) sur un Ryzen 7 9800X3D, "le Nouveau Maître du jeu !", à vous citer également...

Une bonne et heureuse année et big bizoux à vous tous (sans la moindre exception) 😍🤩😅

je la qualifierai de presque idéale parce que le 9800X3D est à un prix absolument indécent, ce sont des plateformes qui quand même marchent très bien en jeu, dans la quasi majorité des cas c'est le GPU qui limite si tu joues en UHD par exemple (ce n'est pas le cas ici), peut être que ça changera avec les RTX 50 ! Le 9800X3D (en prêt pour les tests d'Eric), comme les 7800X3D (celui que nous avons est un achat de notre structure pour les besoins du site), ne sont pas disponibles en prêt longue durée, ce sont des denrées rares, nous prêtons ces deux CPU parfois à d'autres rédactions pour qu'elles puissent mener leurs tests, c'est dire si ça ne tourne quasiment pas 🙂

Et moi aussi (nous) te souhaitons une belle année 2025 avec la santé comme objectif premier, comme j'ai eu l'occasion de te le dire, ton retour me fait très plaisir 😍

OK Thibaut, merci pour ta réponse tout à fait éclairante.

Thibaut, j'ai oublié de dire que j'adorai ton test, à une petite exception près... 😅

Thibaut, concernant le prix indécent du 9800X3D, moi qui voudrait acquérir un CPU l'été prochain, j'espère (à mon avis y'a que ça à faire) que AMD trouvera les moyens de produire suffisamment de ce processeur d'ici là, sinon effectivement je trouverai un autre CPU et celui_là avec un prix raisonnable...

la demande serait énorme malgré le prix, comme quoi, quand les gens veulent, ils trouvent les sous 😁

pour ce qui ets du prix, vaut mieux attendre encore quelques mois, mais actuellement rien n'est aligné pour nous avec la parité euro dollar qui devrait terminer en dollar monnaie plus forte. Je doute qu'on ait les mêmes prix qu'avant, mais là c'est trop cher, et en France c'est du viol avec le seul groupe qu'on a laissé acheter tous ses concurrents...

Merci pour tes conseils et les infos.

🙏