Il y a un mois, le Computex battait son plein, entre annonces de nouveau matériel et autres mises à jour logicielles. Or, pour le leader qu’est NVIDIA, concilier keynote (à destination des investisseurs et des clients) et ancien cœur de cible (joueurs) n’est pas une mince affaire : nous l’avons remarqué notamment à la GTC Paris. En regardant de plus près, les verts sont brièvement revenus sur leur nouvellement sortie RTX 5060, avant de bifurquer directement sur le train de l’IA. Heureusement, la firme avait également prévu diverses démonstrations à destination de la presse qui, faute de hardware pur et dur (mais où donc est la RTX 5050 PCIe !?), avait des intégrations logicielles sympathiques dans diverses applications de la communauté des joueurs et des streamers. Voyons cela ensemble !

Des RTX 5060, ça, il y en avait : de toutes les couleurs et de toutes les tailles !

Un assistant pour les streamers, en collaboration avec StreamLab

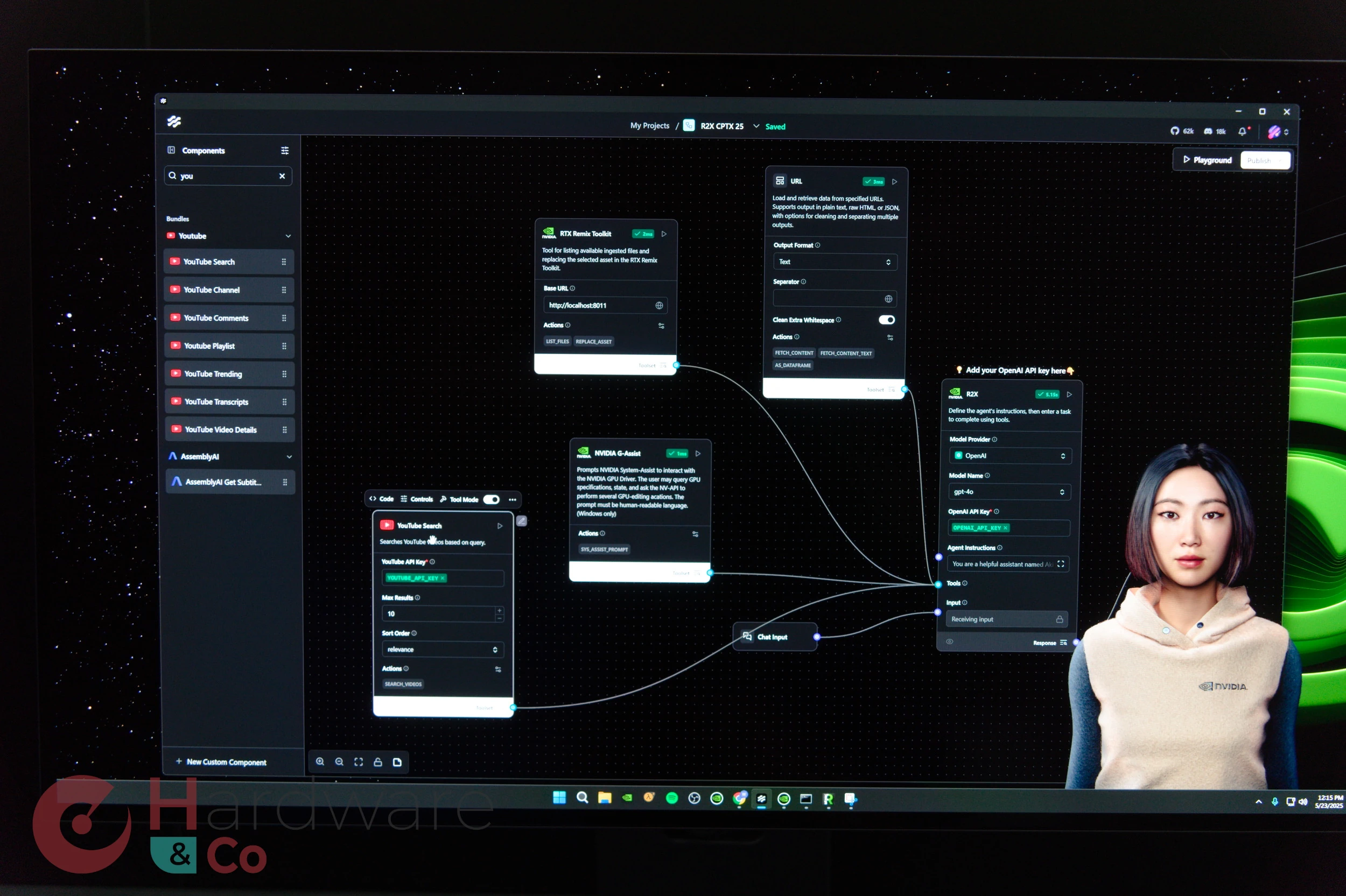

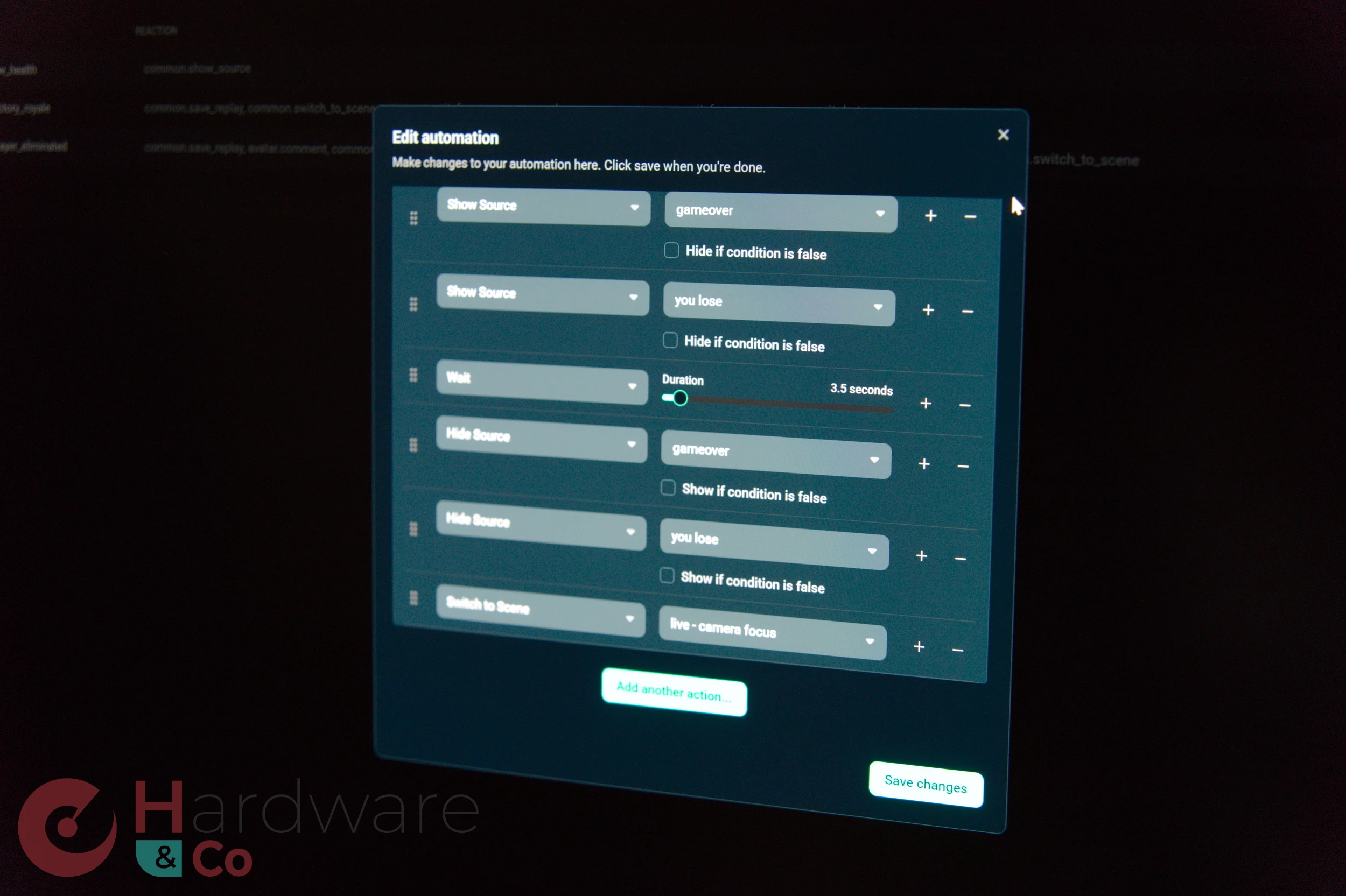

Si le gaming a longtemps été synonyme de nouveau marché, ce n’est désormais plus le cas et l’industrie a atteint son stade mature. Cependant, le streaming s’installe comme une nouvelle pratique de plus en plus répandue. Or, la majorité des streamers sont seuls à gérer leur contenu, ce qui est loin d’être une simple affaire. Avec leur agent de streaming, NVIDIA et StreamLab ont développé conjointement une IA capable de dynamiser tout cela, le tout de manière intuitive et amusante pour les viewers puisqu’elle se matérialise par un avatar présent (optionnellement) à l’écran, dont les paroles peuvent rythmer le stream.

Dans la pratique, cet agent a un rôle double : d’une part, être un second couteau pour donner la réplique et dynamiser le stream (cela semble peut-être bête, mais les moments de « blanc » où personne ne parle sont caractéristiques des vidéastes peu aguerris), et d’autre part d’apporter un support technique. Ainsi, l’assistant peut changer de scène, réagir à des événements en jeu tel la mort du personnage (attention, il faut pour cela que le titre soit pris en charge, ce qui prend quelques journées de travail pour l’équipe de développement afin de détecter les divers écrans rythmant ces passages), lancer un replay (fonctionnalité d’OBS) ou tout simplement commenter ce qui se passe à l’écran.

Sans surprise, nous retrouvons sous le capot la ribambelle de technologies de NVIDIA habituelle : Audio2Face pour animer l’avatar, ACE pour une partie des interactions, et Inworld AI pour ce qui est de déporter la réflexion du bonhomme (un modèle de machine learning de type LLM) dans le cloud. Si l’idée est de faire tourner un maximum de choses en local, cette partie-là demeure encore trop gourmande pour mouliner sur les machines personnelles, qui plus est en gardant une faible perturbation des performances en jeu — pour le moment quasiment inchangé d’après la firme, après essai sur des laptops.

Si jamais la chose décollait et que de grands noms de la scène Twitch venaient à utiliser l’agent de streaming, il ne faudrait pas non plus que tous les assistants se ressemblent. Pour cela, StreamLab a bien fait attention à intégrer divers réglages permettant de personnaliser la personnalité du bonhomme et son apparence. Reste à voir si la chose convainc : il est en effet déjà possible de lancer diverses transitions et autres effets via un Stream Deck ou des macros ; et il n’est pas certain que l’installation et la configuration de l’IA (sans parler de son coût, probablement par abonnement) soient contrebalancées par les fonctionnalités apportées. À voir comment la chose évolue dans le futur !

Project R2X : La même chose, mais directement sur le bureau

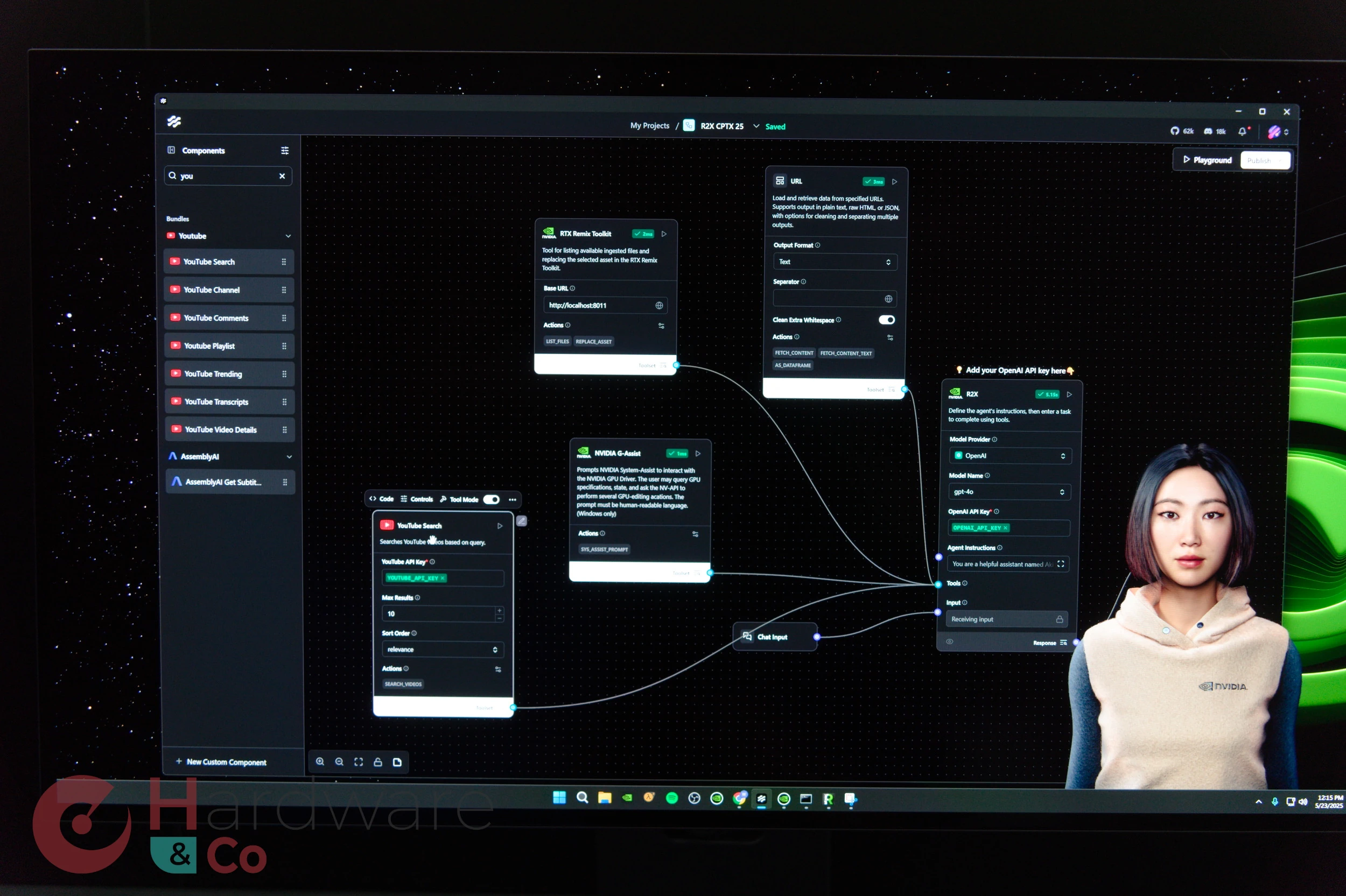

Si vous n’êtes pas un aficionado de la diffusion en direct de jeu, mais que la perspective d’avoir un compagnon (ou une compagne, comme cela a pu être la mode dans le début des années 2000) présent en bas à droite de votre écran vous réjouit ; alors le Project R2X vous sera tout indiqué. Encore une fois, nous retrouvons le cocktail de technologies vertes Audio2Face/NVIDIA ACE pour animer un personnage virtuel (rendu par l’Unreal Engine, si jamais vous vous posez la question), cette fois-ci dans le but de vous épauler dans vos tâches du quotidien.

Cette fois-ci, nous retrouvons OpenAI et son ChatGPT-4o aux commandes, avec la possibilité de lancer divers logiciels comme RTX Remix, lancer une vidéo YouTube, faire mouliner G-Assist ou encore analyser des documents par un simple glisser-déposer sur l’avatar. Bref, un couteau suisse assez pratique si vous pouvez parler à votre PC dans votre environnement personnel ou de travail.

Plus de précisions quant au Neural Radiance Cache

Enfin, le caméléon est revenu sur le détail d’une de ces technologies introduites avec Blackwell : le Neural Radiance Cache, ou NRC. Pour rappel, il est question d’utiliser un réseau de neurones pour se souvenir des trajectoires des rayons lancés précédemment, et pouvoir ainsi rapidement inférer par IA les réflexions d’autres rayons sans avoir à calculer complètement leur chemin.

Cachés dans un menu, certes, mais le paramétrage du NRC est là !

Initialement, l’idée était non pas d’améliorer les performances, mais de corriger les artefacts liés au denoiser. En effet, le Path Tracing (rendu 100 % par lancer de rayon) est très intensif en matière de puissance de calcul, si bien que tous les pixels n’ont pas tout à fait la même couleur une fois tous les rayons calculés : il faut alors débruiter (denoise) pour obtenir une image plus lisse. Habituellement, cela est effectué à l’aide d’un algorithme temporel, c’est-à-dire se reposant sur les couleurs des rendus précédents pour calculer ses propres valeurs. Or, dans le cas où des lumières viendraient changer rapidement de couleur ou d’intensité, le débruitage temporel mixe des images rémanentes au niveau des réflexions avec le vrai rendu.

vs

Lors des changements rapides de couleurs (comme en sautant sur ce bouton dans Portal 2 RTX), le NRC permet une propagation instantanée de la nouvelle teinte (jaune). Sur cet exemple, les reflets sur le sol restent ainsi bleus sans NRC, mais se parent d’une jaune avec.

Le Neural Radiance Cache limite ce phénomène en entraînant à la volée (donc en même temps que le rendu) via TCNN un petit réseau permettant de prédire les réflexions d’un rayon en fonction de son emplacement initial. Comprenez par là que votre GPU va adapter son réseau au fur et à mesure que le paysage autour de vous change ; et utiliser ce dernier pour démultiplier les rayons après chaque réflexion, menant à une image plus précise sans pour autant se reposer sur les frames précédents (enfin, tant que l’entraînement du réseau a été suffisant). Par la magie de Blackwell, la chose se révèle être plus performante que de lancer directement plus de rayons, d’où les gains en nombre d’images par seconde. Si jamais le NRC vous passionne, sachez que l’idée était initialement présentée dans un papier de recherche en 2021 !

Le compagnon de bureau existe en version "Paperclip" (Trombonne!) 😁

Ouiiiiii !