Si, pour le commun des mortels, le Computex est l’occasion de dévoiler du nouveau produit, la chose est ardue pour NVIDIA qui a déjà dégainé ses nouvelles cartes graphiques sur le premier trimestre 2025. Certes, la RTX 5060 pas-Ti est désormais officiellement achetable dans toutes les bonnes crémeries, offrant ses 3840 cœurs CUDA à qui qu’en veut — dans la mesure de 14,9 mm de haut très exactement et 1099 $ de ticket d’entrée pour la version mobile ; probablement pas de manière simultanée —, mais les deux cartes étaient déjà annoncées et connues depuis le 15 avril dernier. Alors, comment qu’on fait ?

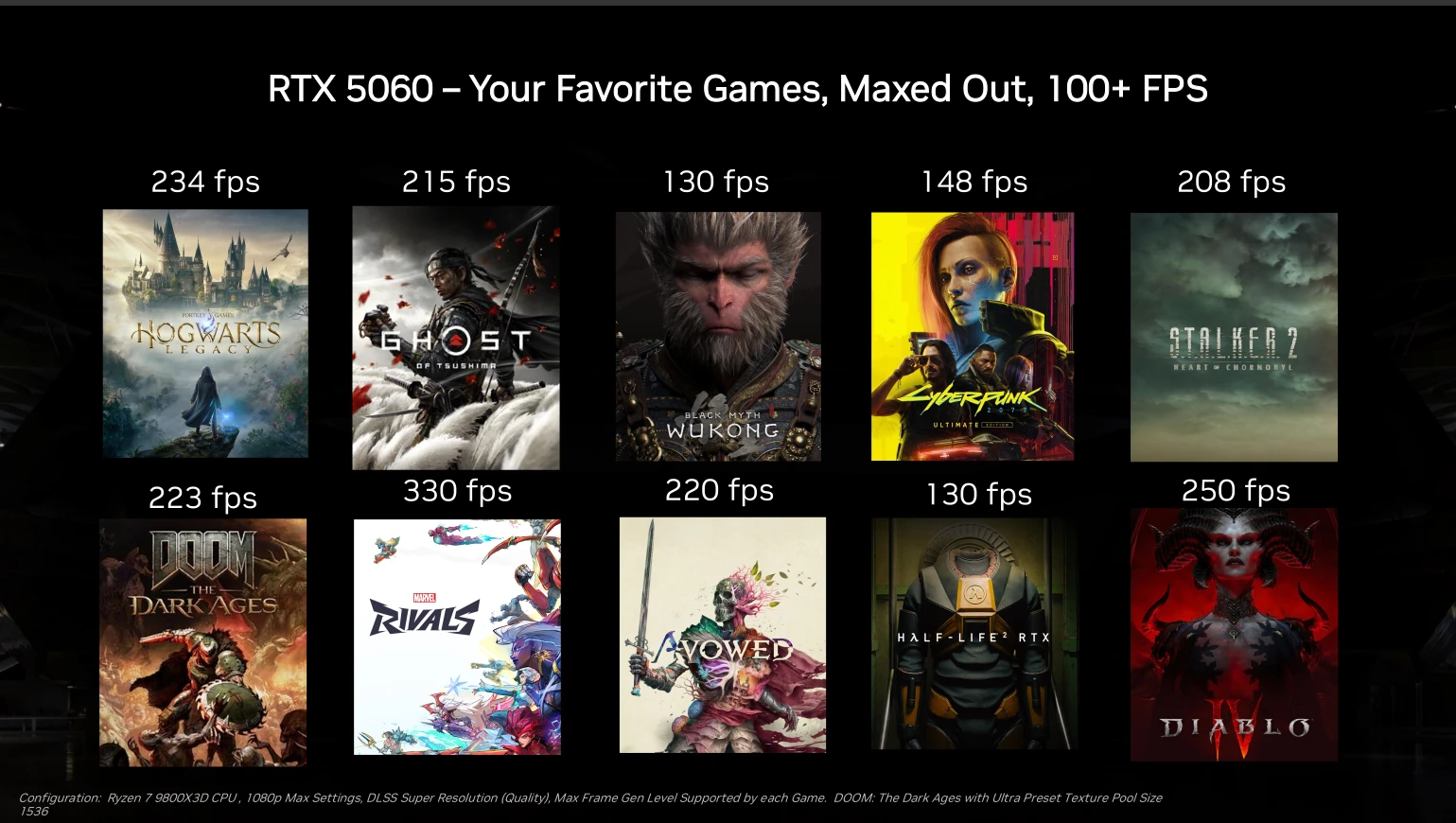

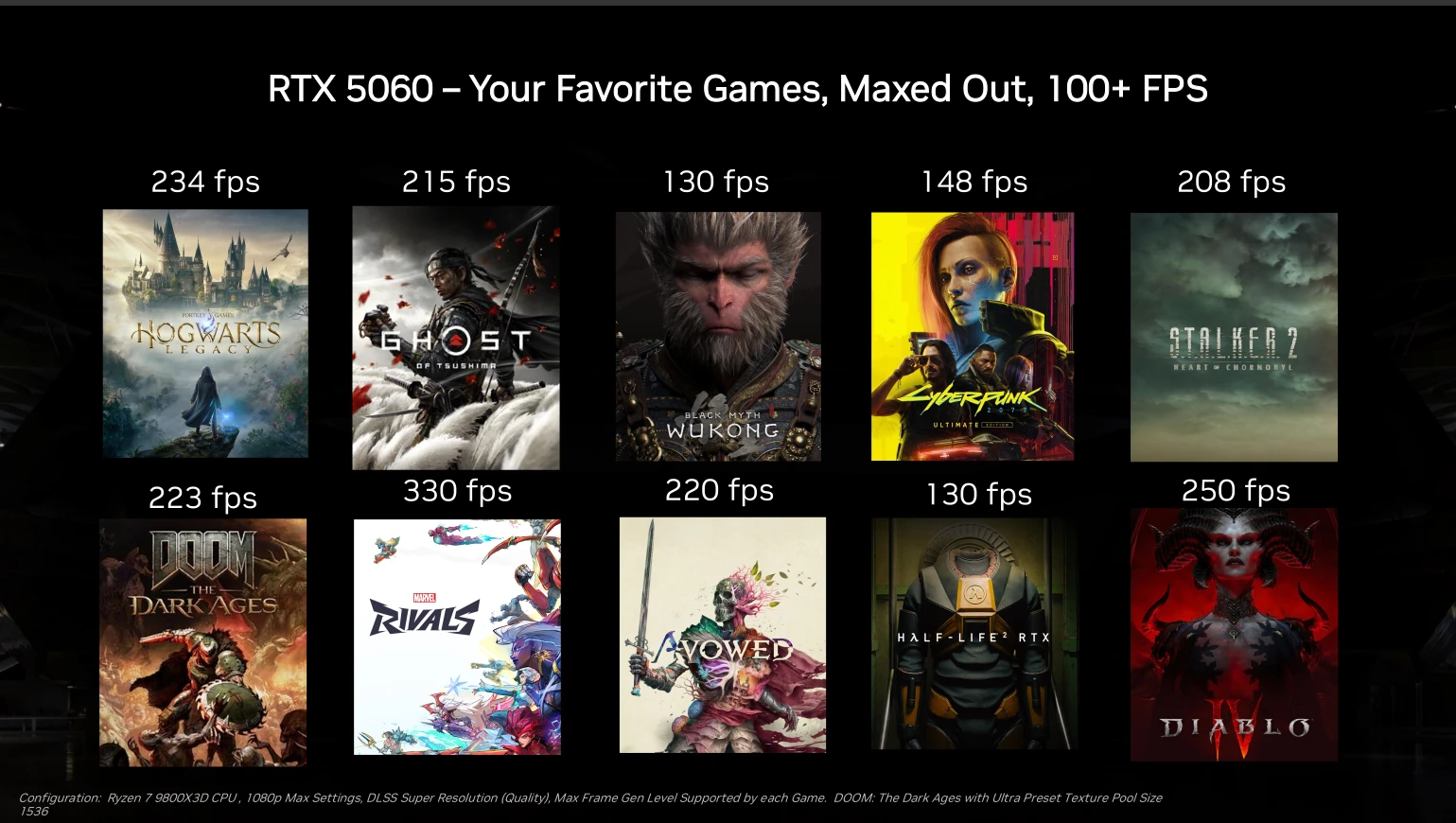

Vous l’aurez compris à la lecture du titre, la solution tient en un mot : « logiciel ». Et, cela tombe bien, l’écosystème software est un des points forts du caméléon, avec une base solide, CUDA, et de nombreuses équipes d’aides aux développeurs, qu’il s’agisse de jeu vidéo… comme d’autres choses. Côté JV, la sauce est connue : la RTX 5060, avec le multi frame generation, permet de jouer plus ou moins confortablement aux titres récents en 1080p voir 1440p.

Le nombre de ces titres et applications supportées par le DLSS4 ne cesse de croître, pour atteindre plus de 125 à l’heure actuelle — contre 20 au lancement. D’autres titres vont y passer, comme Portal RTX (qui vient normalement tout juste de recevoir un patch), ou F1 2025 pour qui cela ne devrait pas tarder. Côté RTX Remix, NVIDIA est très satisfait de son système de modding, et lance aujourd’hui un concours via ModDB avec la bagatelle de 50 000 $ à gagner, qui expirera au début de la Gamescom. Avis aux créateurs ?

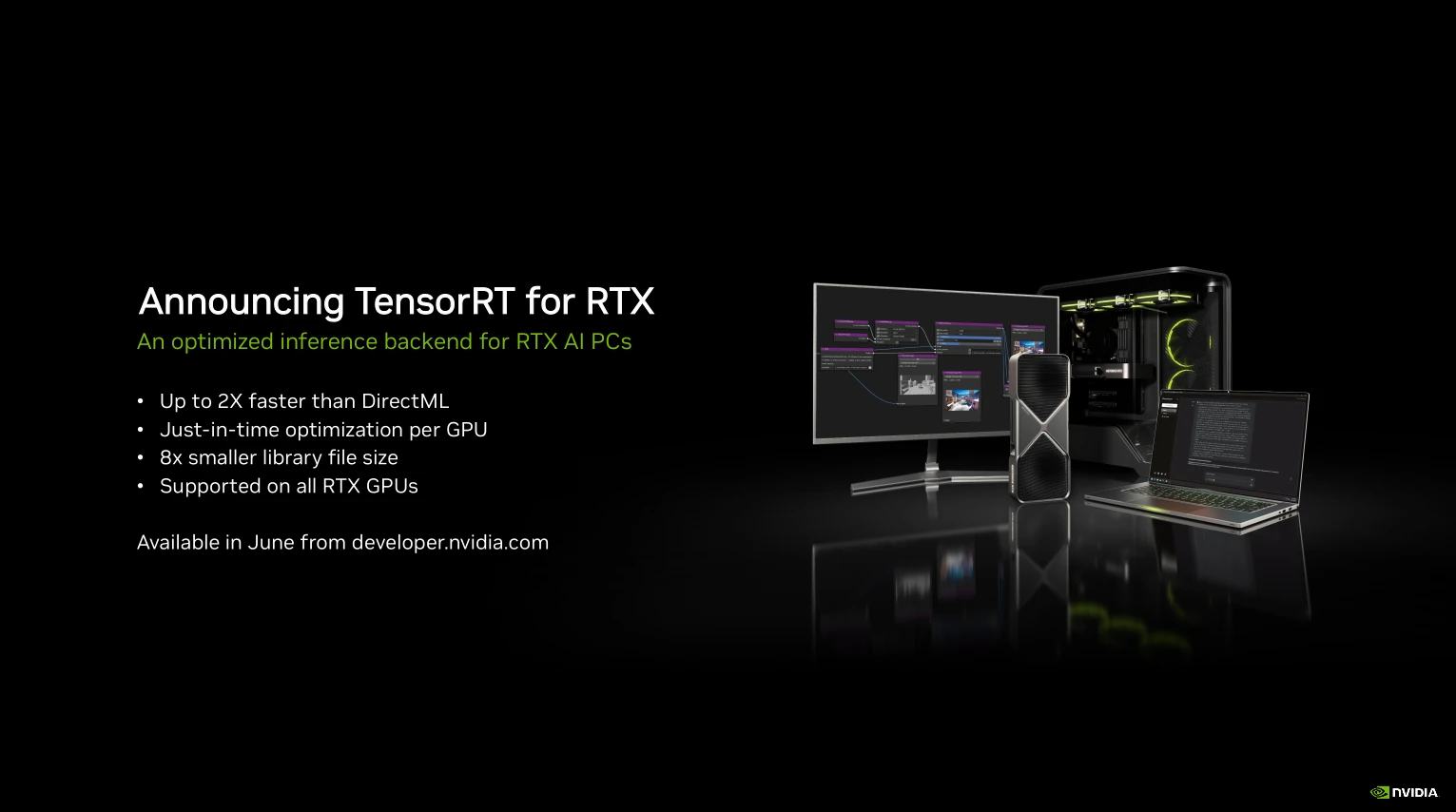

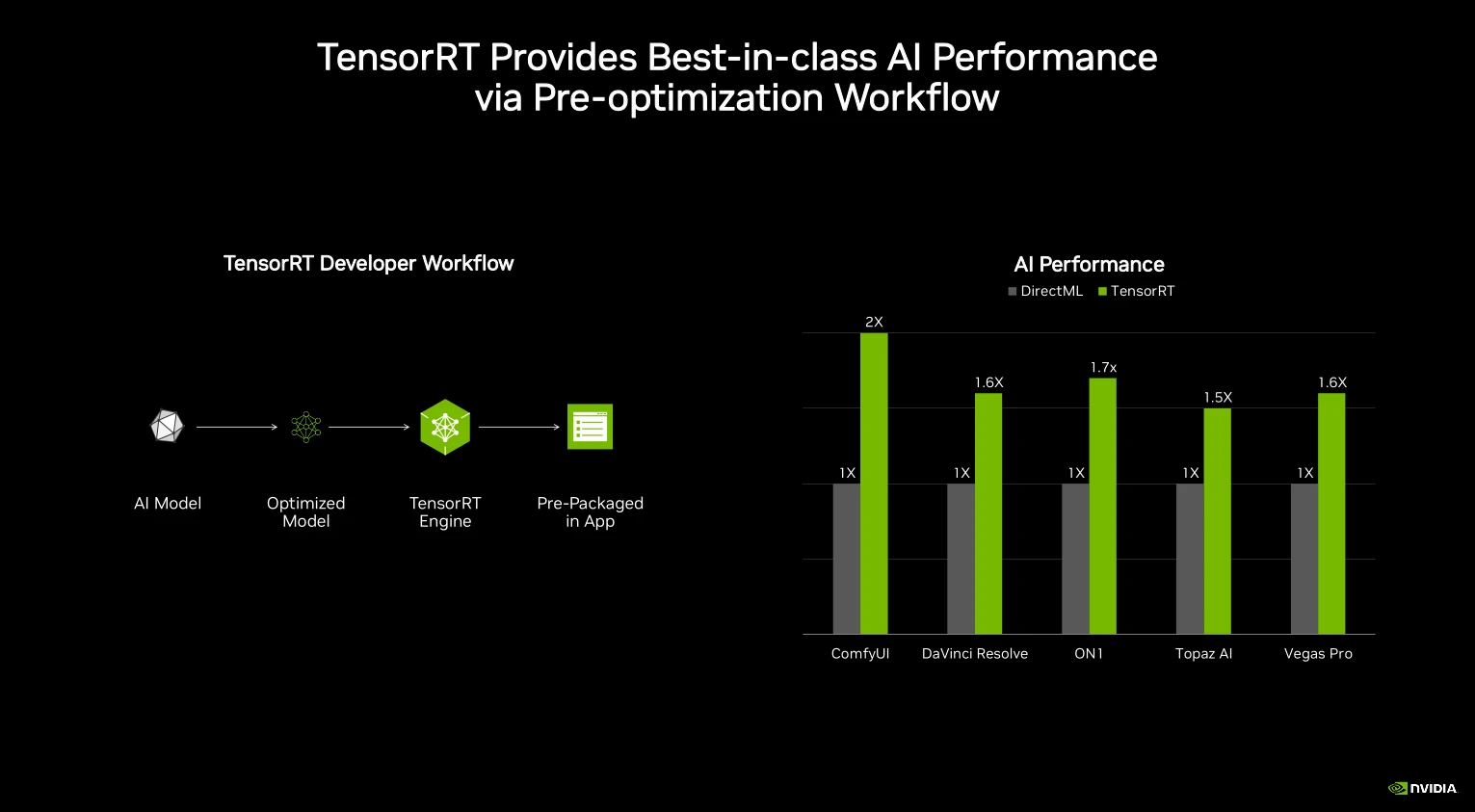

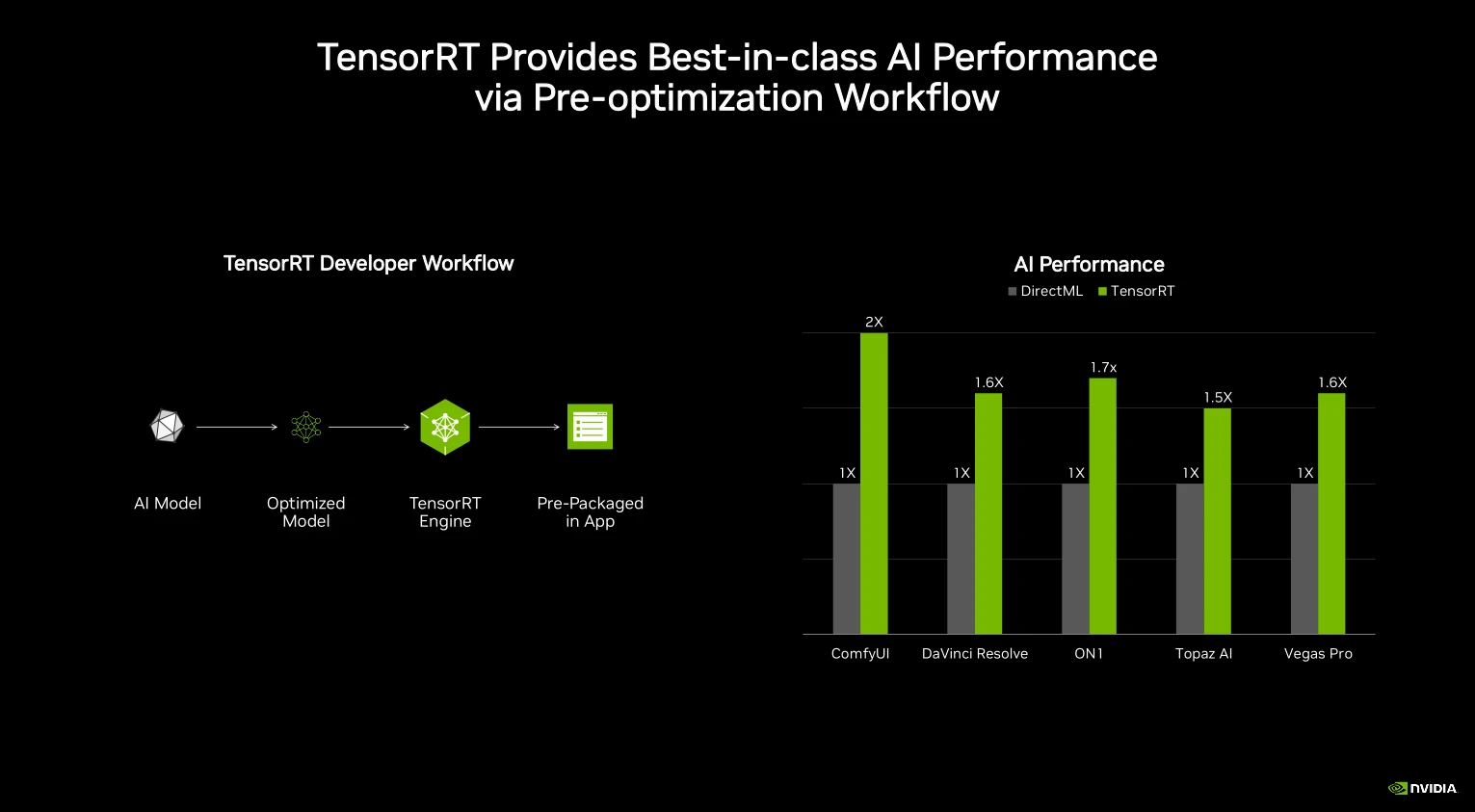

Cependant, la principale nouveauté provient du monde applicatif. En effet, NVIDIA annonce l’arrivée de TensorRT pour les RTX à partir de juin, un cadriciel (merci l’Académie Française !) fait maison pour l’inférence rapide de réseaux neuronaux, promettant des gains substantiels en performances par rapport à DirectML. En interne, il s’agit d’un compilateur fortement optimisant capable notamment de quantifier et fusionner les couches pour offrir des versions basse latence, haut débit de vos IA préférées en utilisant un runtime ONNX.

Grande nouveauté de cette version, la possibilité pour les développeurs d’exporter non pas un fichier optimisé par architecture, mais un fichier unique qui sera par la suite digéré en local sur les machines cibles. Il ne va sans dire que le procédé facilite grandement la distribution des logiciels, au plus grand plaisir des verts mais au détriment d’un temps de digestion côté utilisateur — ce qui est déjà le cas lors de la compilation des shaders, soit dit en passant.

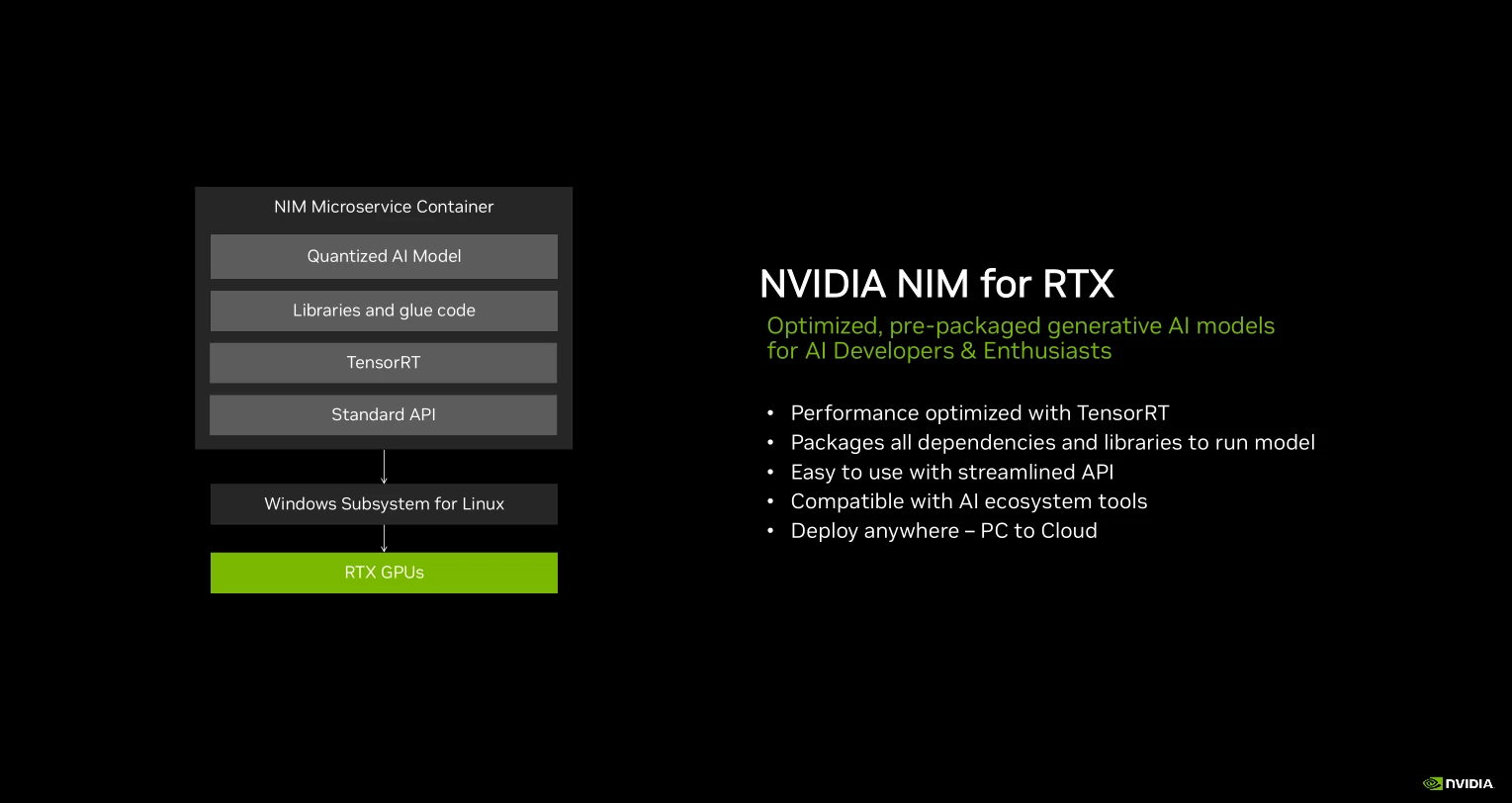

NIM pour les RTX sera également de la partie, une solution logicielle autour de microservices issue du monde professionnel permettant d’encapsuler et de composer aisément des modèles de machine learning ensemble au sein d’un unique paquet ; exécutable sous Linux comme Windows au moyen du sous-système Linux pour Windows (WSL2). Côté technique, les NIMs cachent de la conteneurisation (partage du noyau mais séparation des bibliothèques) de manière à déployer de manière rapide, efficace et durable différents composants logiciels optimisés par le caméléon, et, surtout, d’utiliser des interfaces standardisées intercompatibles. Au vu l’investissement des verts dans le domaine, les NIMs sont là pour durer : nous devrions vraisemblablement en réentendre parler sous peu.

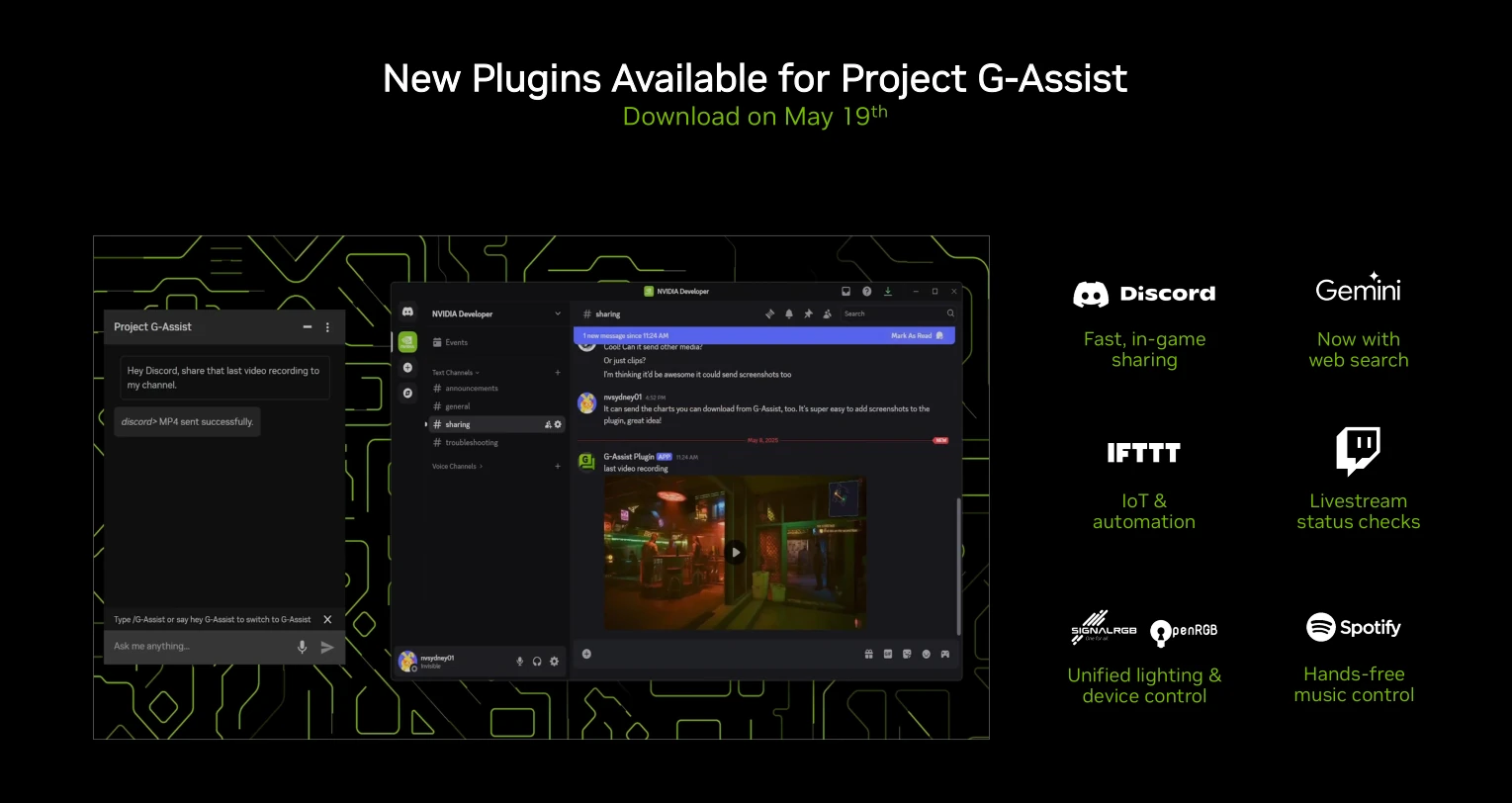

Enfin, G-Assist, le projet de NVIDIA visant à répondre aux questions des utilisateurs en utilisant l’IA,, est également mis à jour avec de nouveaux plug-ins : Discord, Twitch, Spotify,… En outre, un système de programmation no-code propulsé par ChatGPT permet de créer soi-même des interfaces si le cœur vous en dit. Reste encore à vérifier la qualité du code ainsi généré, la méthode IA étant encore connue pour être immature dans le domaine. Bref, une sacrée collection de nouvelles choses : le temps sélectionnera celles qui resteront !