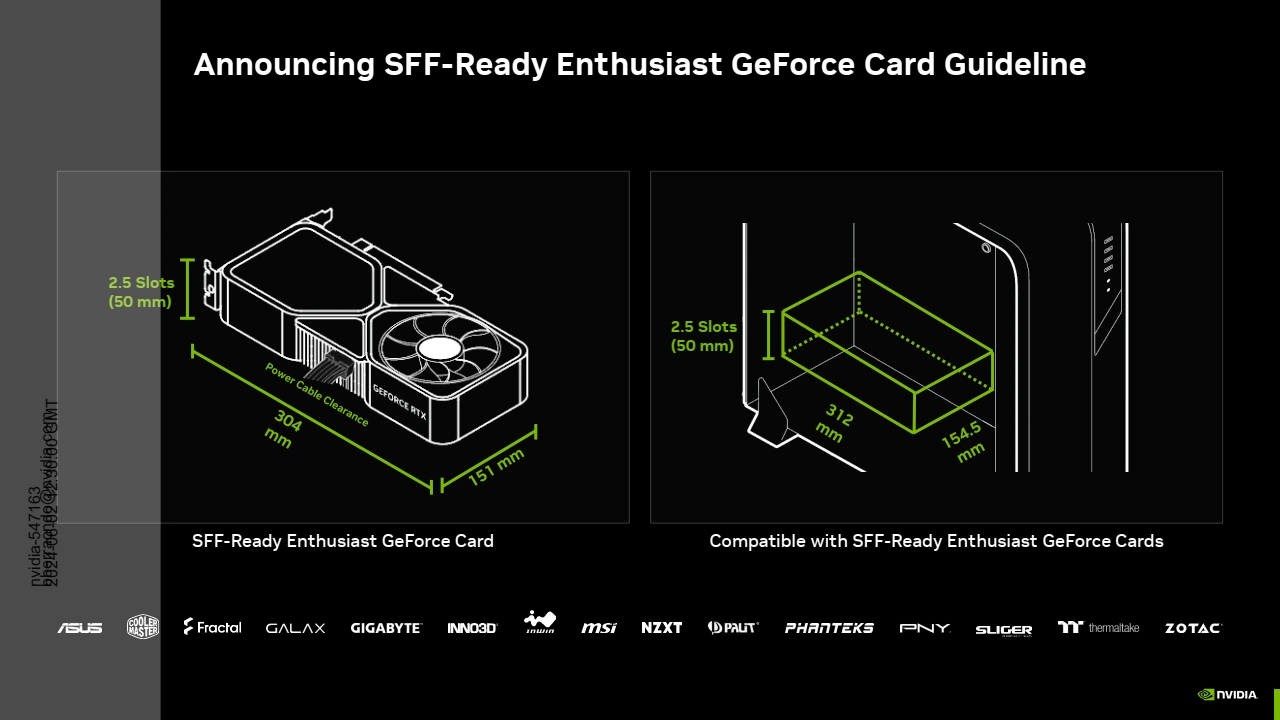

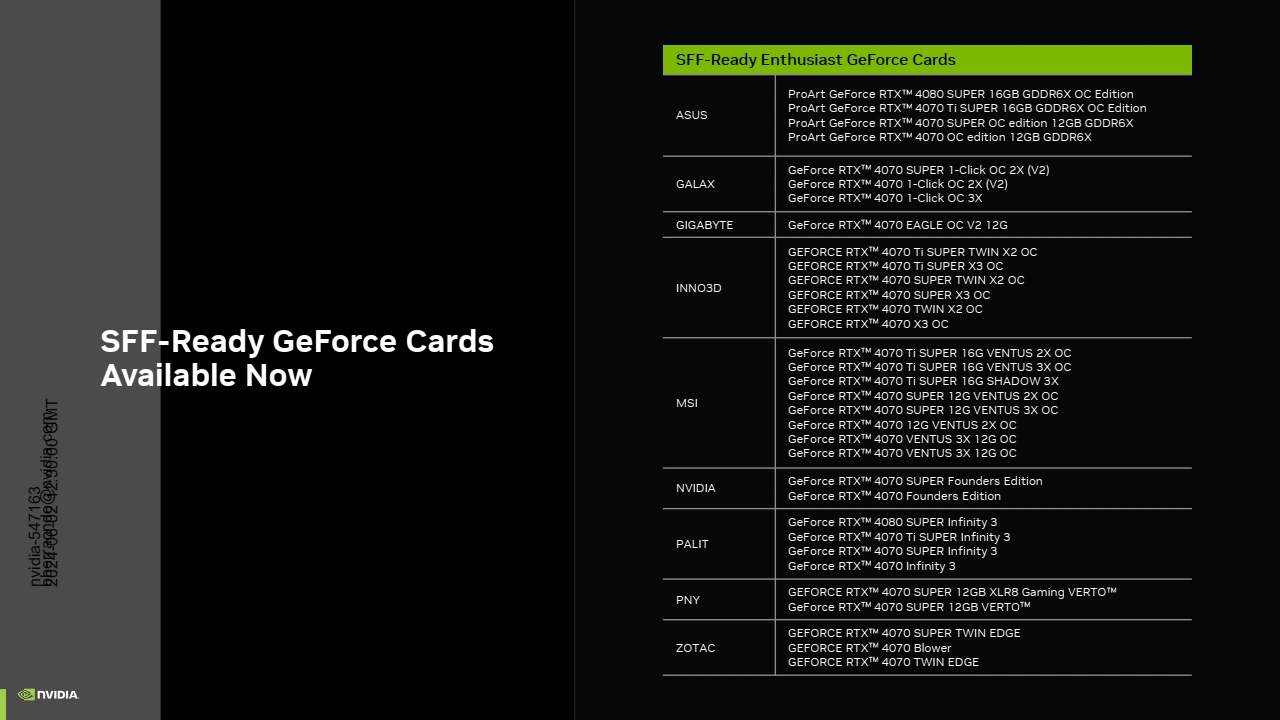

En préambule du Computex qui se tiendra du 04 au 07 juin 2024 à Taïpei, NVIDIA a procédé à toute une série d'annonces. Rien concernant la future gamme des GeForce qui devrait être lancée en fin d'année si on en croit les fuites à ce sujet. Mais il y avait bien un petit quelque chose côté Hardware, puisque le caméléon annonce le standard SFF (Small Form Factor) pour ses GeForce. Kesako ? Eh bien il s'agit de spécifications que doivent remplir certaines cartes graphiques et boitiers pour assurer leur compatibilité (particulièrement utile si ces derniers sont de petite taille comme le laisse supposer la dénomination). Ainsi, une carte et un boitier SFF-Ready ne doivent poser aucun problème d'installation, évitant au potentiel acquéreur de devoir vérifier les dimensions respectives pour s'assurer de leur compatibilité.

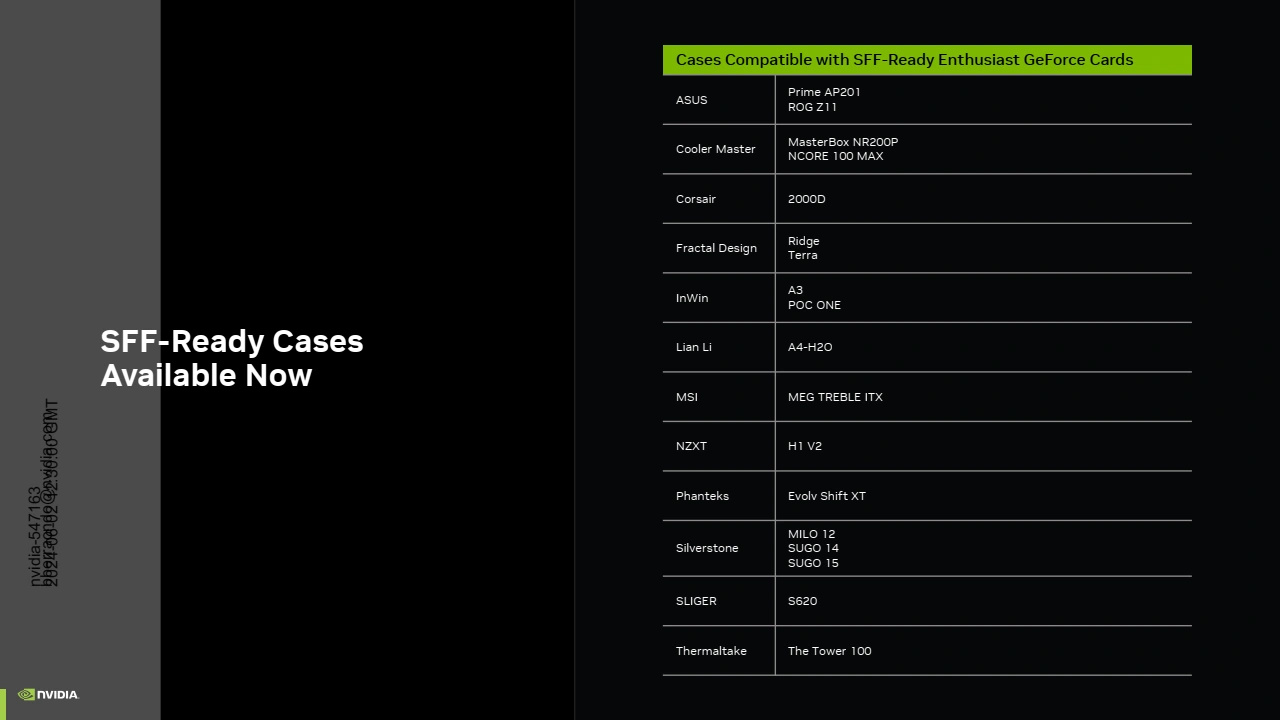

En pratique, une GeForce SFF doit être de classe RTX 4070 ou plus (ce sont de manière générale les cartes les plus performantes qui sont les plus encombrantes) et mesurer au maximum 304 mm de long, 151 mm de haut (incluant l'espace nécessaire à la connexion du câble d'alimentation en évitant une courbure trop importante qui pourrait conduite à fragiliser les contacts du 12HPWR) et 2,5 slot en épaisseur (50 mm). Les boitiers compatibles SFF doivent de leur côté proposer un espace libre de 312 mm en longueur, 154,5 mm en hauteur et 50 mm en profondeur.

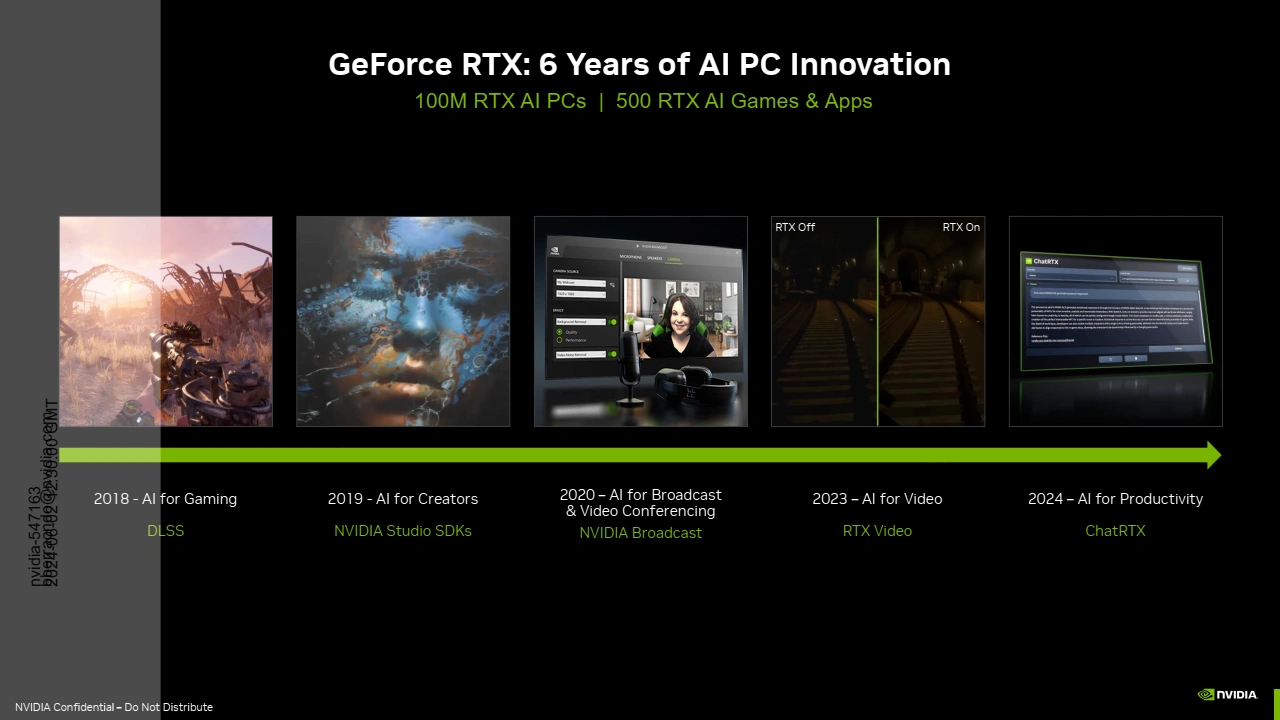

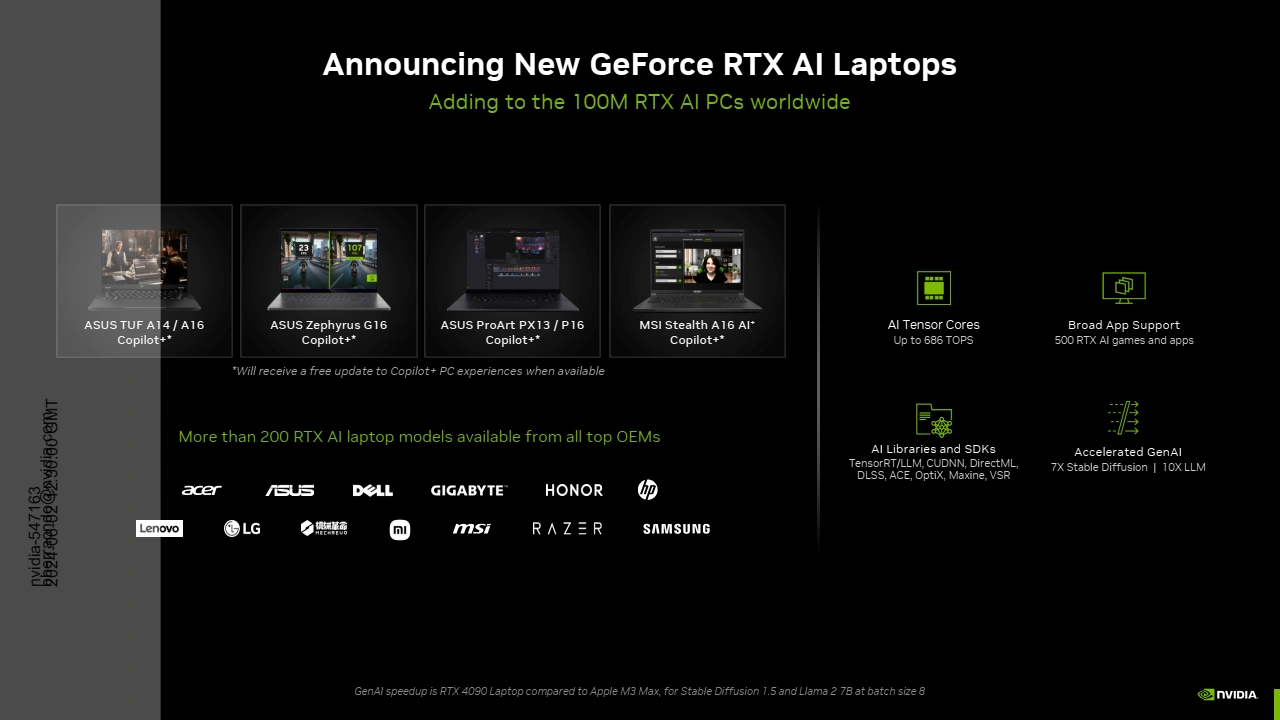

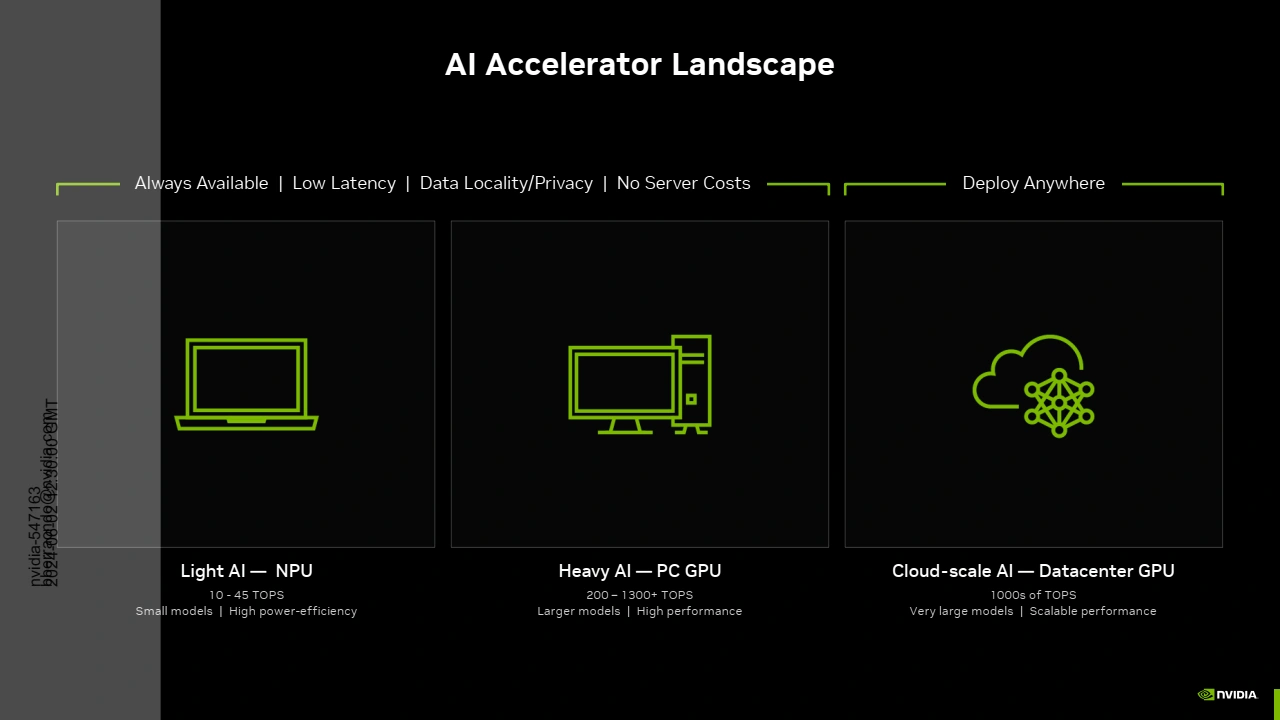

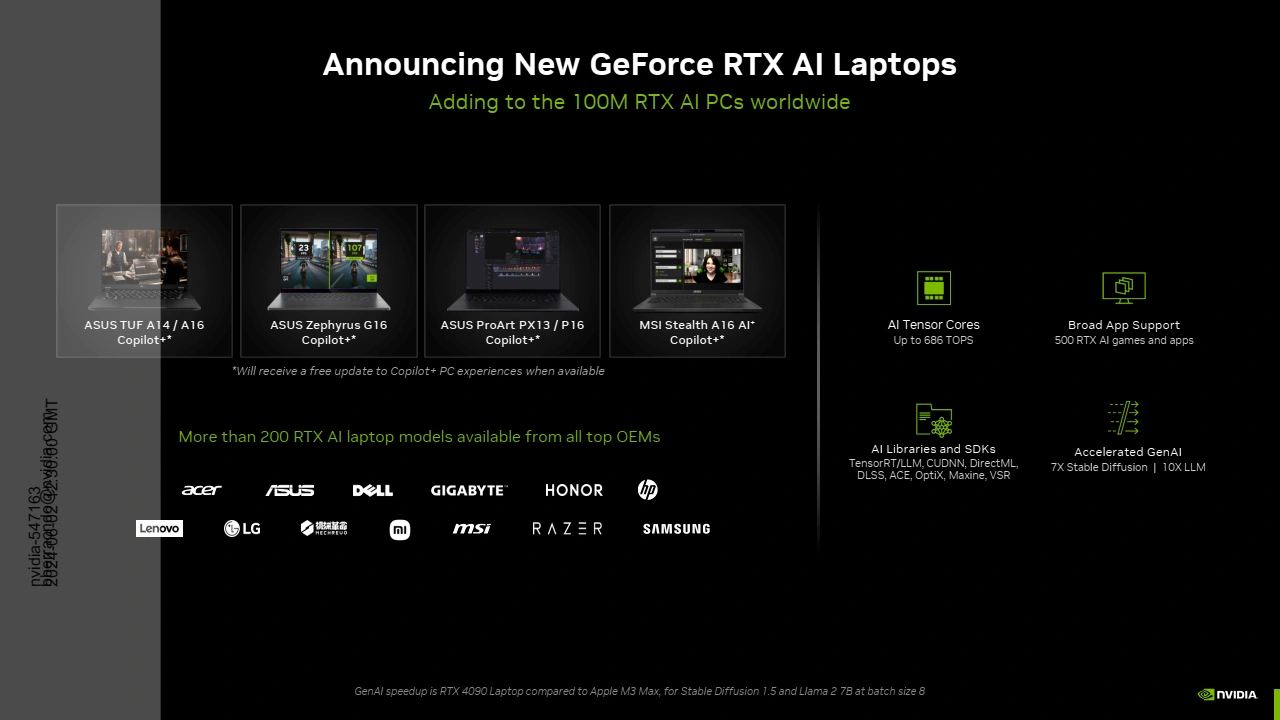

NVIDIA annonce également que son application NV App va prendre en charge de l'enregistrement (Shadow Play) AV1 jusqu'à 120 i/s ainsi que davantage d'options d'Overclocking / Tuning (OC Scanner) du GPU comme annoncé au lancement de la beta. Mais ce Computex est aussi l'occasion pour NVIDIA de rappeler à tout le monde que le boss actuel de l'IA c'est lui, et qu'il n'a pas du tout l'intention de laisser les autres marques le supplanter au niveau de sa principale source de revenus. Le caméléon se fend d'ailleurs d'une petite rétrospective, rappelant que dans le domaine des usages grand public, il propose depuis maintenant près de 6 ans (avec l'introduction des RTX 2000) d'initiatives s'appuyant sur l'IA accélérée par ses GPU. Pour enfoncer le clou, il annonce des PC portables RTX AI associant un processeur disposant d'un NPU à un GPU RTX. Copilot+ de Microsoft nécessite en effet un NPU capable de fournir au moins 40 TOPS de puissance de calcul.

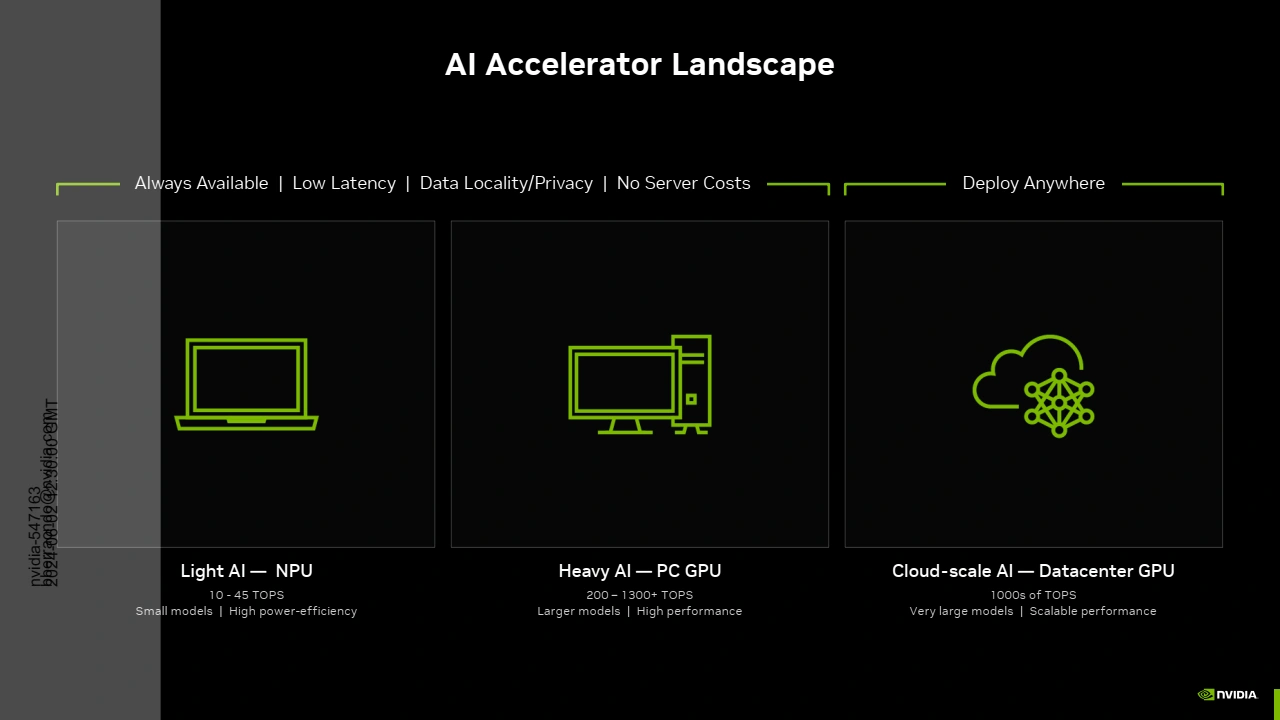

A l'heure actuelle, tant les Ryzen (Phoenix) que les Core Ultra (Meteor Lake) n'atteignent pas cette valeur (à contrario des Qualcomm Snapdragon X Elite / Plus), avec respectivement 16 et 11 TOPS. Toutefois, les générations à venir seront capables de franchir ce palier. L'avantage des NPU consiste en leur efficacité énergétique, idéal pour "alimenter" Copilot+ pour les tâches légères sans empiéter lourdement l'autonomie d'un PC portable. Par contre, lorsque les tâches nécessitent davantage de puissance, l'utilisation du GPU (d'un tout autre niveau puisqu'une simple RTX 4050 propose déjà 194 TOPS, et écrase les NPU en FLOPS) prend alors tout son sens. Pour cela, Microsoft et NVIDIA travaillent à la mise à disposition d'une API qui facilitera l'accès pour les développeurs aux modèles d'IA accélérés par le GPU, au travers de l'environnement logiciel Copilot de Windows. Cette API sera disponible au cours de l'année.

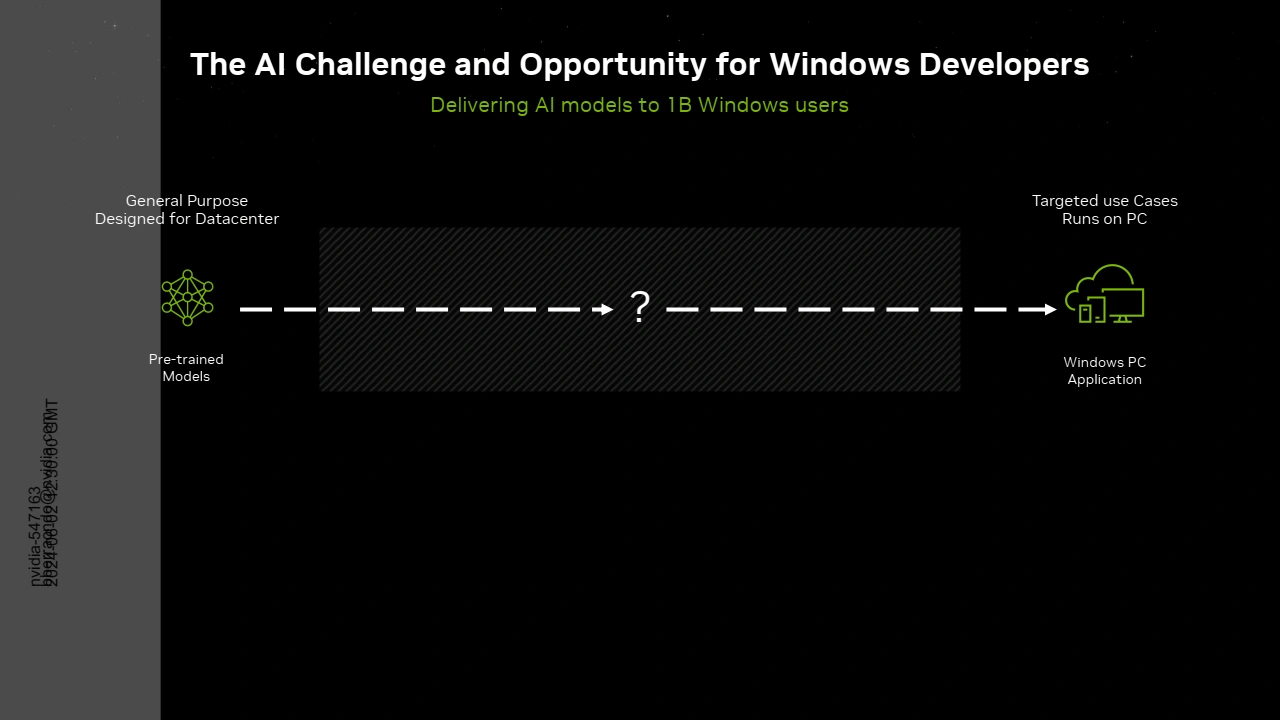

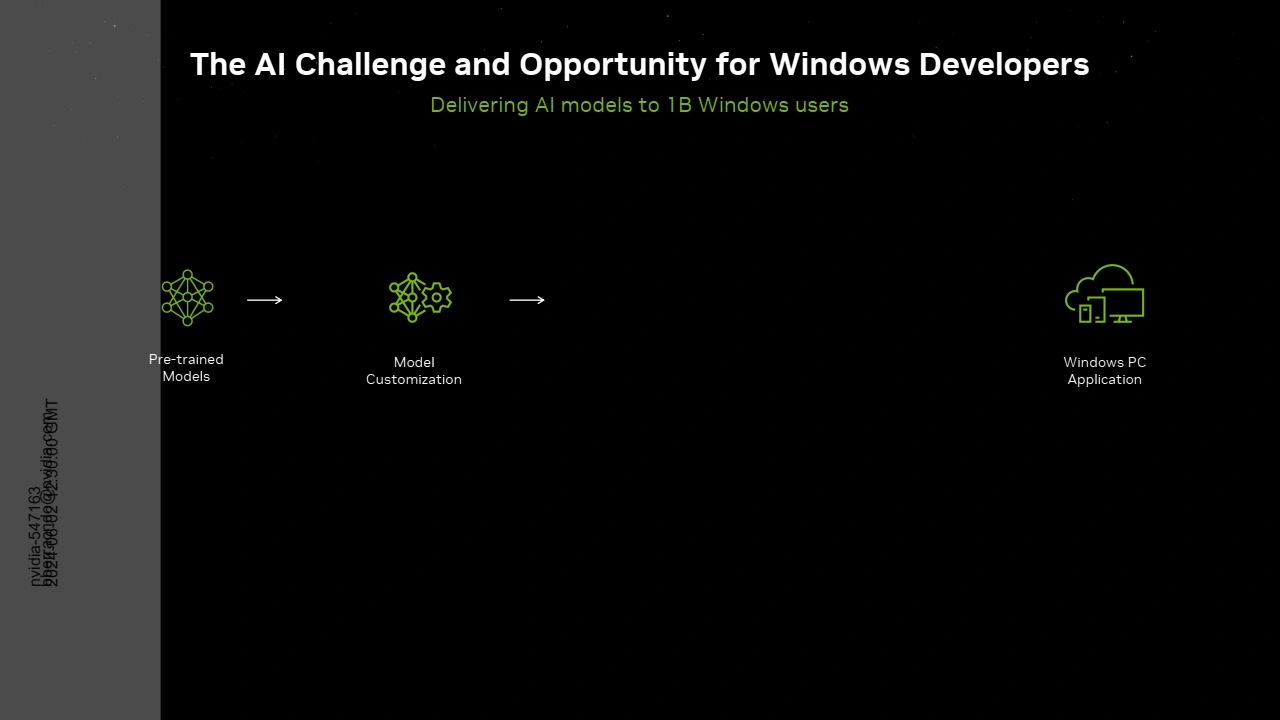

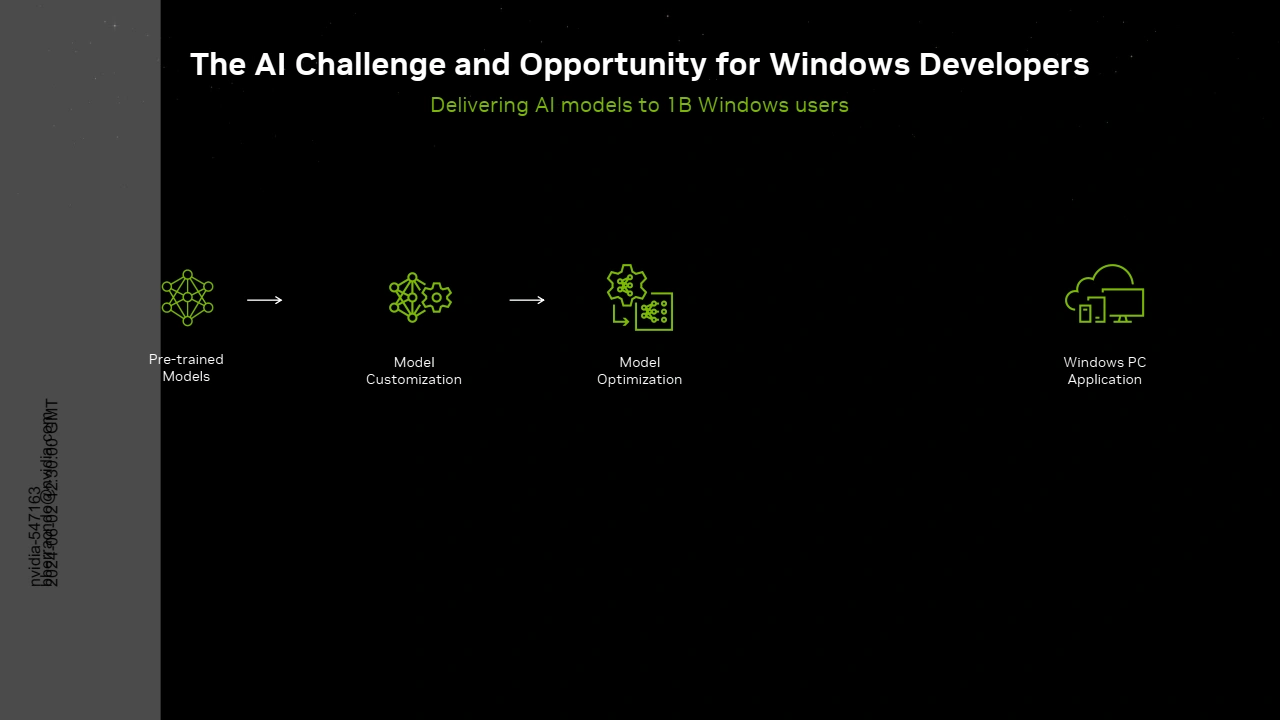

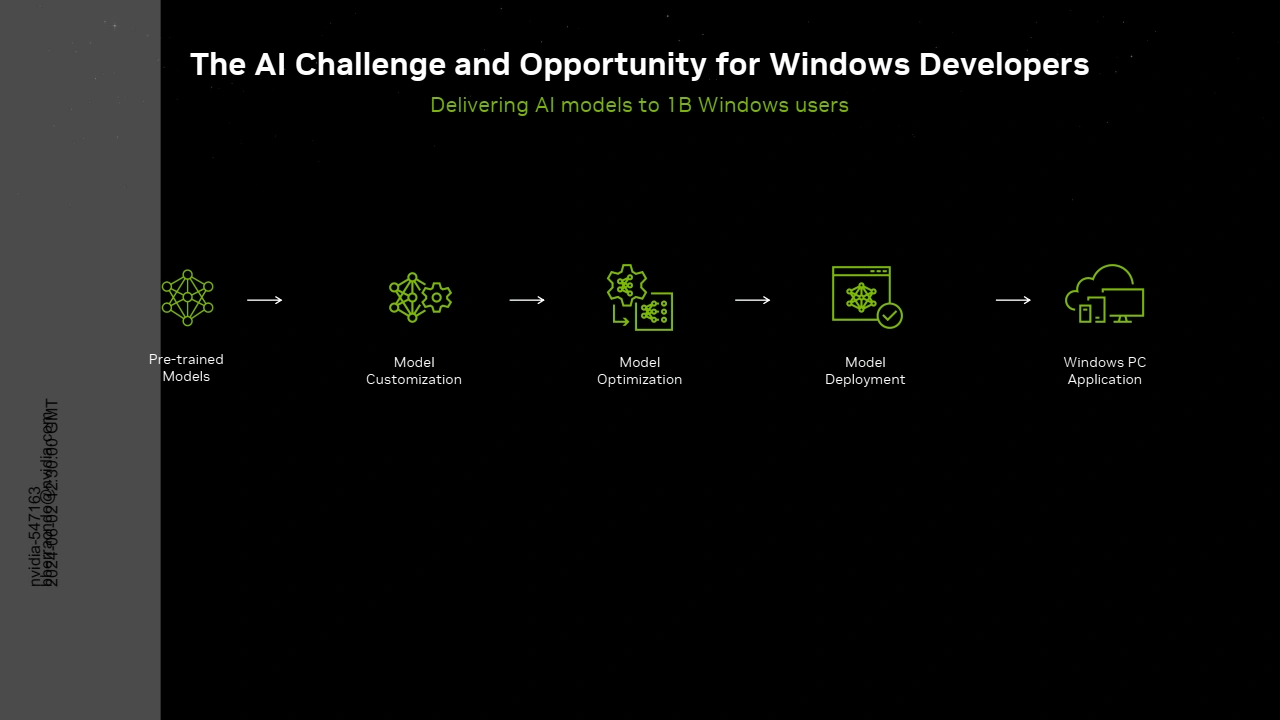

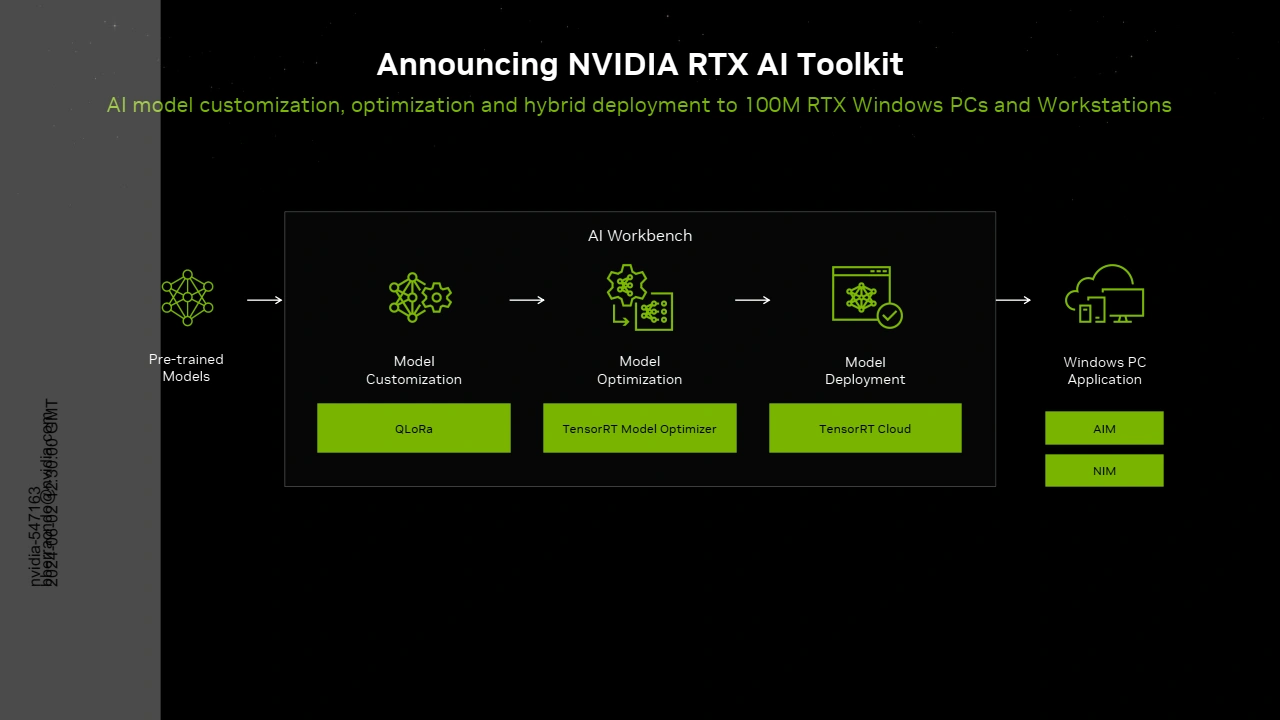

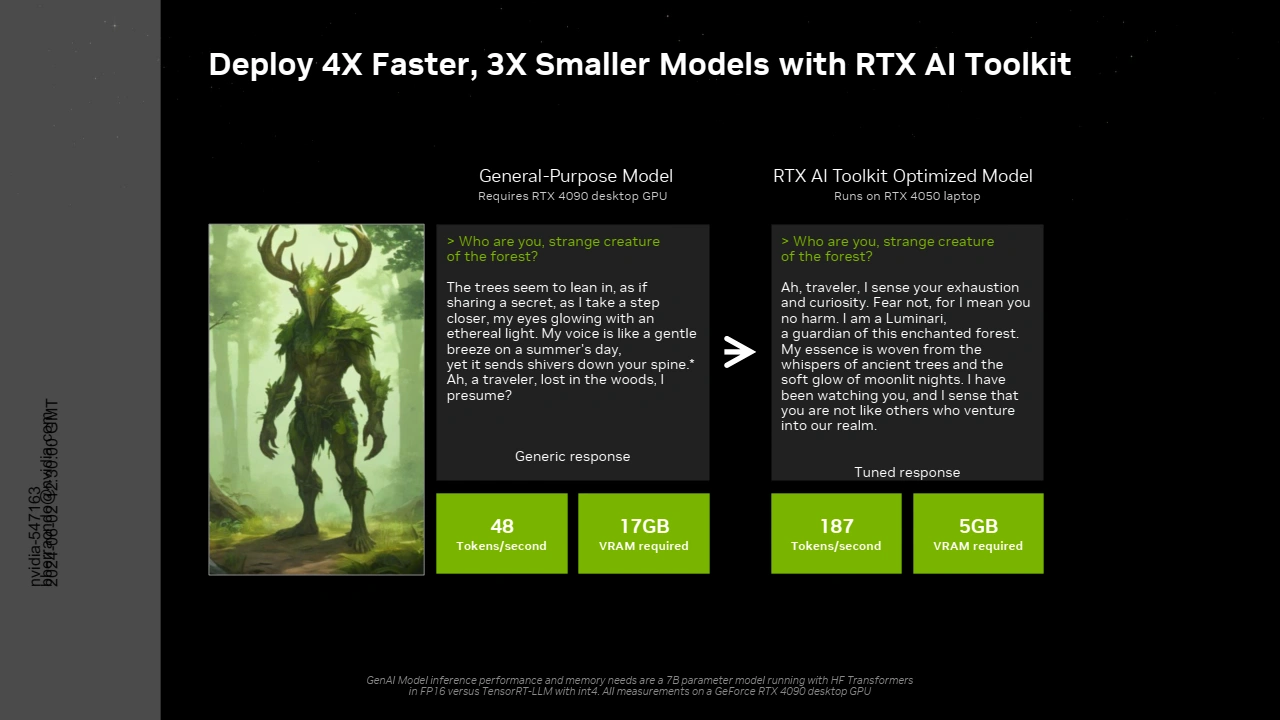

Il n'est donc pas question ici de suppléer les NPU intégrés au CPU pour faire fonctionner Copilot+ (même si en pratique rien n'empêcherait de le faire si Microsoft le souhaitait), mais bien de faciliter l'appel par ce dernier aux modèles IA tournant sur GPU. Toujours dans le but de faciliter l'usage de l'IA pour une exécution directement sur un PC local (et non au sein d'un DATA Center ce qui est le cas de nombreux modèles IA développés), NVIDIA propose ce qu'il nomme RTX AI Toolkit. C'est un ensemble d'outils et de SDK (disponible en accès anticipé au cours du mois) qui permettent d'adapter, optimiser et déployer des modèles IA génériques, afin de les faire fonctionner de manière optimale sur un PC RTX AI.

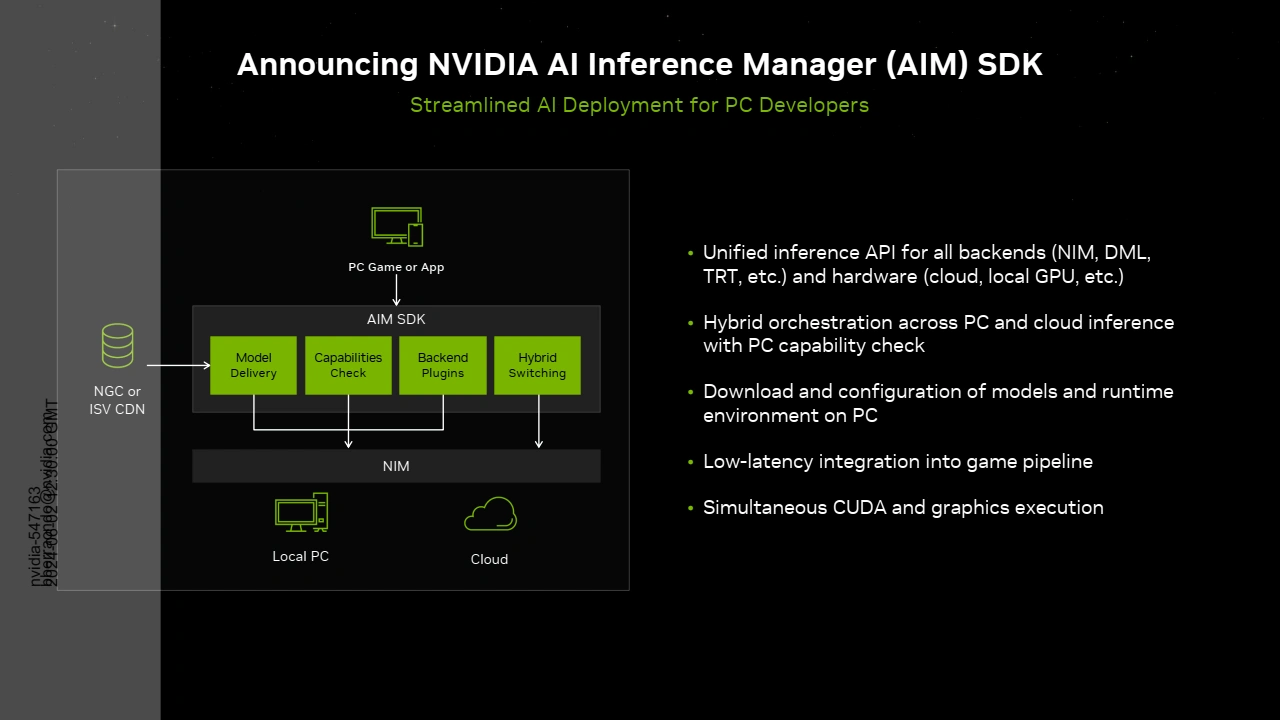

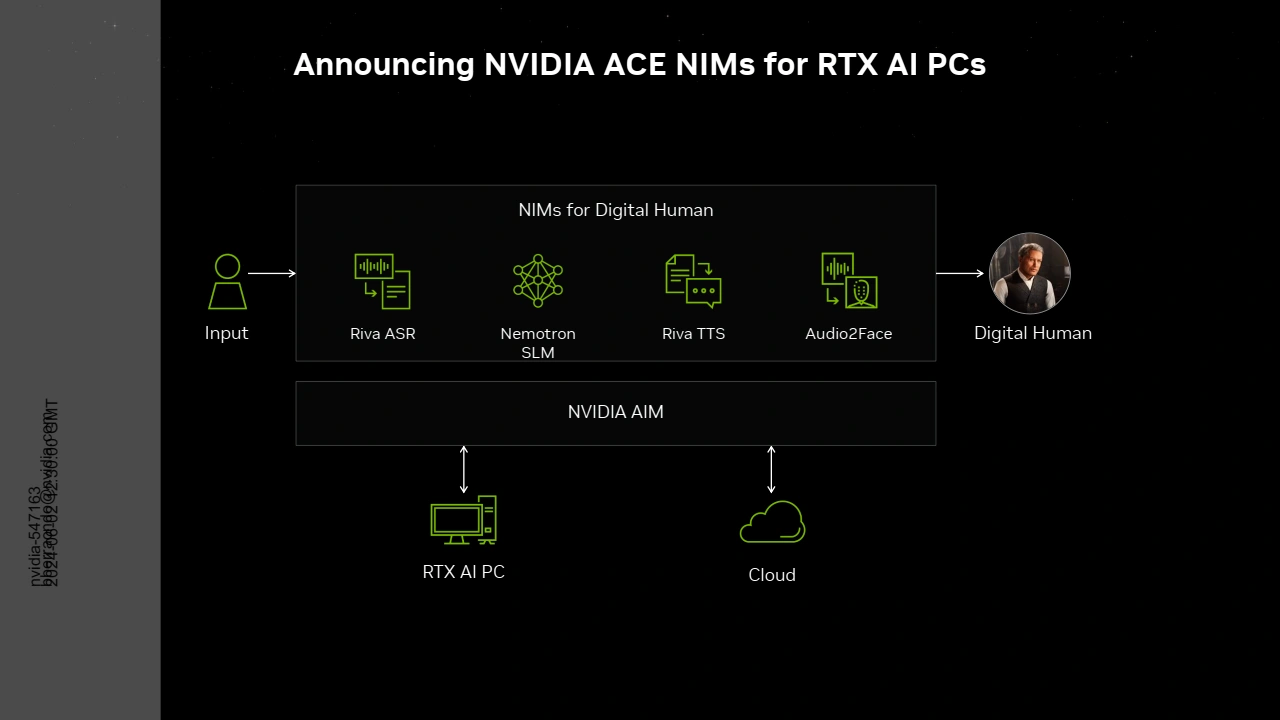

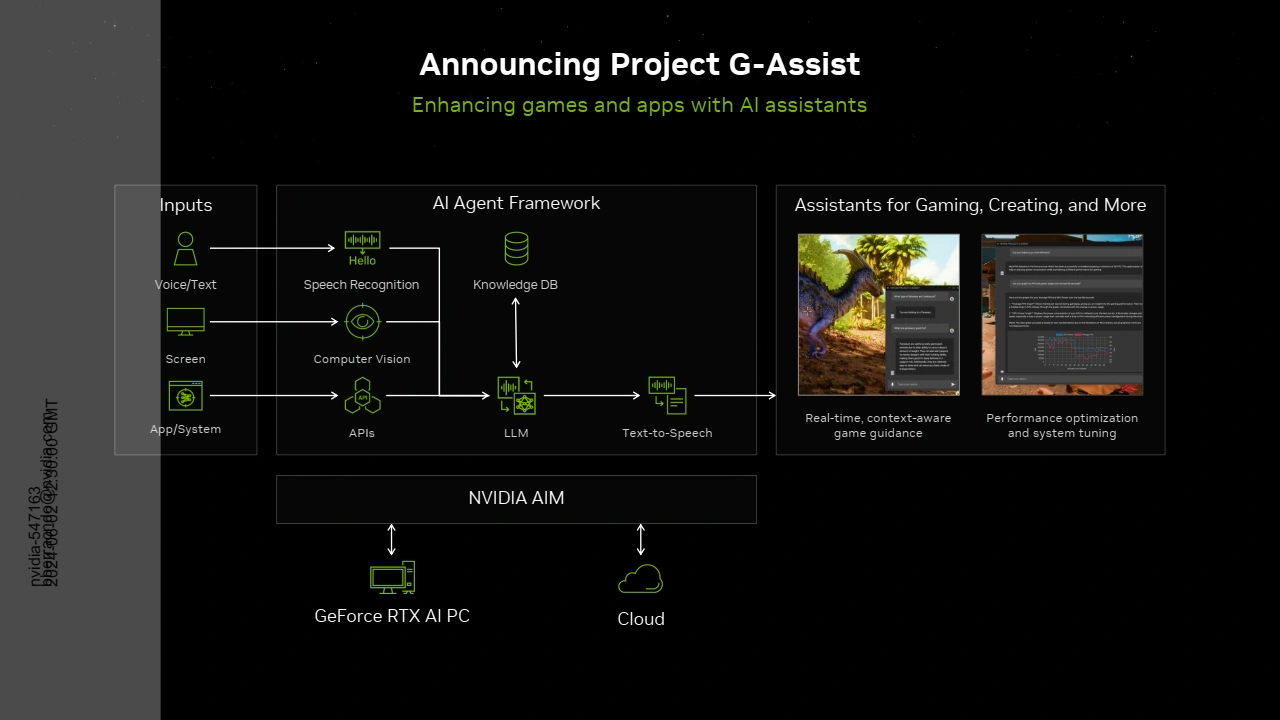

Ainsi, les développeurs peuvent utiliser TensorRT pour accélérer l'exécution de leur modèle sur GeForce RTX, et AIM (AI Inférence Manager disponible en accès anticipé) pour "orchestrer" l'inférence de manière transparente entre PC et Cloud, tout en préconfigurant le PC avec tous les éléments et dépendances nécessaires à l'exécution du modèle sur PC. On retrouve au bout de la chaine les NIMs (NVIDIA Inference Microservices) déjà annoncés précédemment, qui regroupent le modèle IA, l'environnement d'exécution et le moteur d'inférence optimisé pour le modèle au sein d'un package prêt à l'emploi. Tout ceci n'est donc pas foncièrement nouveau, le caméléon regroupant derrière RTX AI Toolkit les briques logicielles qu'il avait (pour la plupart) préalablement lancées.

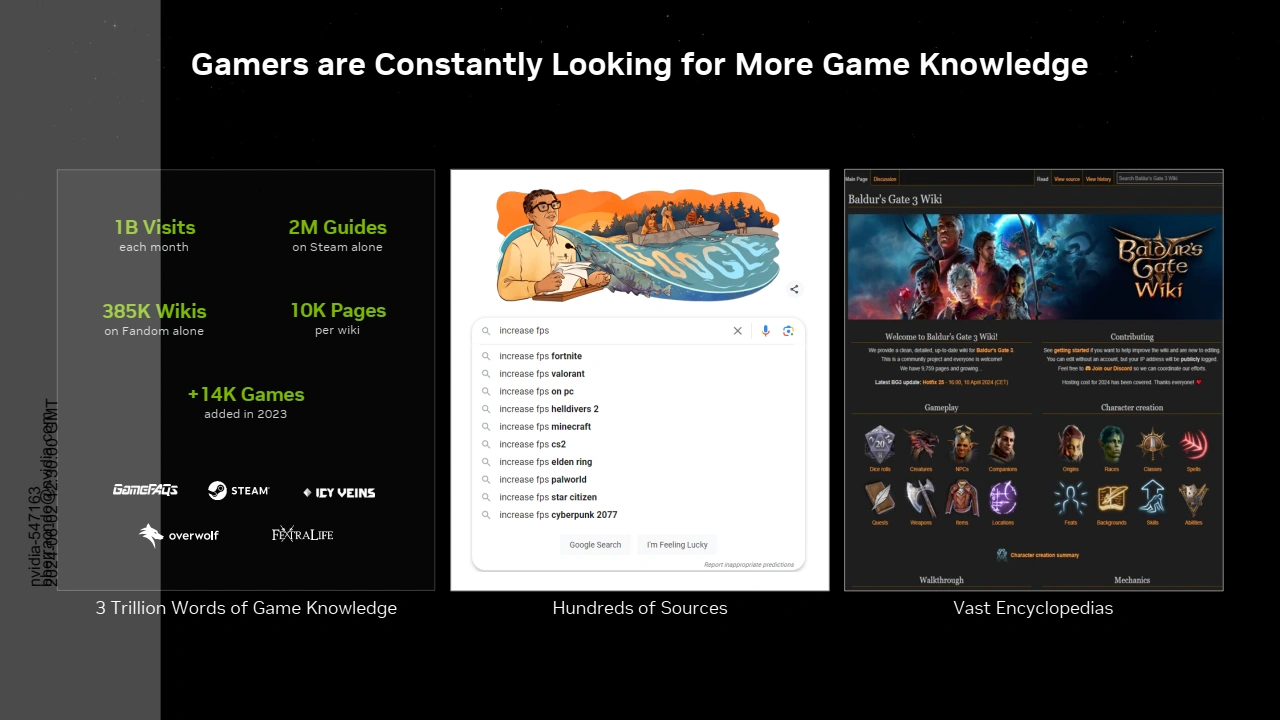

Les verts annoncent également le Projet G-Assist. Il s'agit tout simplement d'un assistant virtuel propulsé, on vous le donne en mille, par l'IA et qui pourra fournir des informations contextuelles au sein d'une application ou d'un jeu. Son intégration devra être assurée par les développeurs de l'application, mais NVIDIA insiste sur le fait que la communauté devrait être en capacité -d'améliorer son intégration et la pertinence des résultats renvoyés- par ses apports. Reste la problématique de l'agrégation des données sans en rétribuer les sources potentielles, mais c'est un point récurrent avec l'IA (vous pouvez vous référer à l'article de Nicolas à ce sujet). Enfin, G-Assist devrait être en capacité de proposer des modifications de réglages au sein de l'application/jeu pour prioriser les choix de l'utilisateurs (meilleure efficience, performance, etc.)

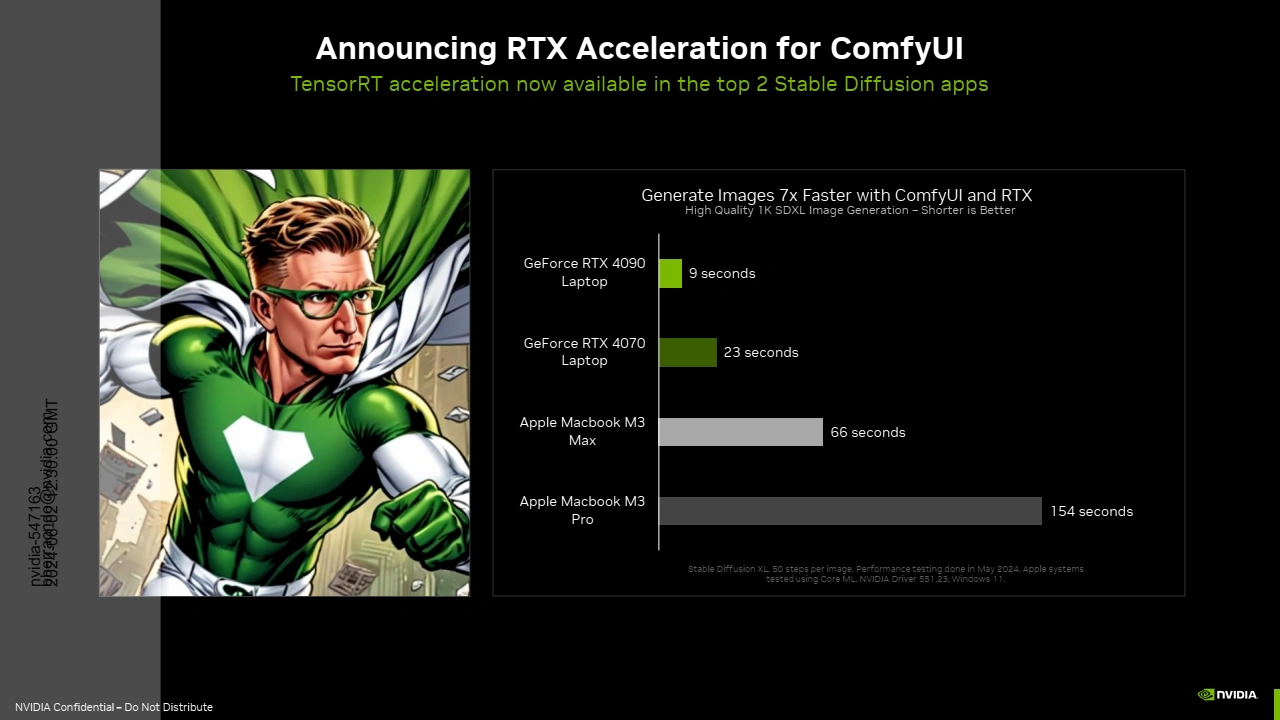

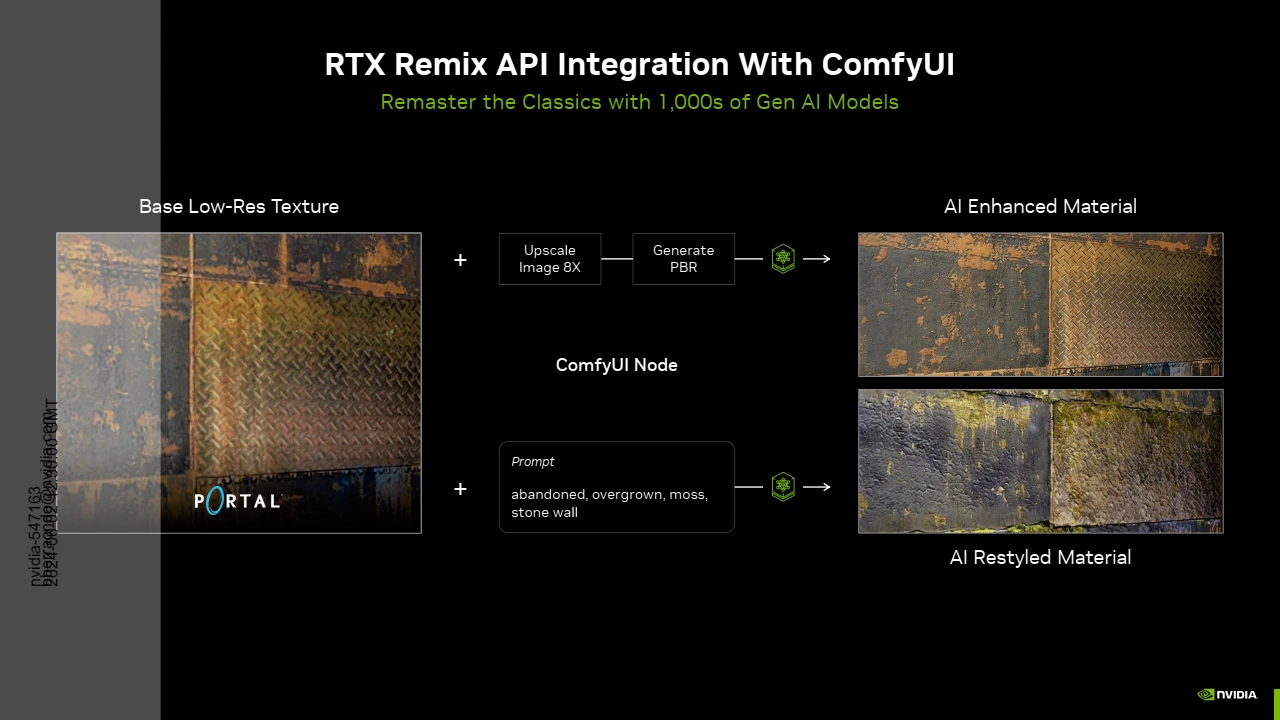

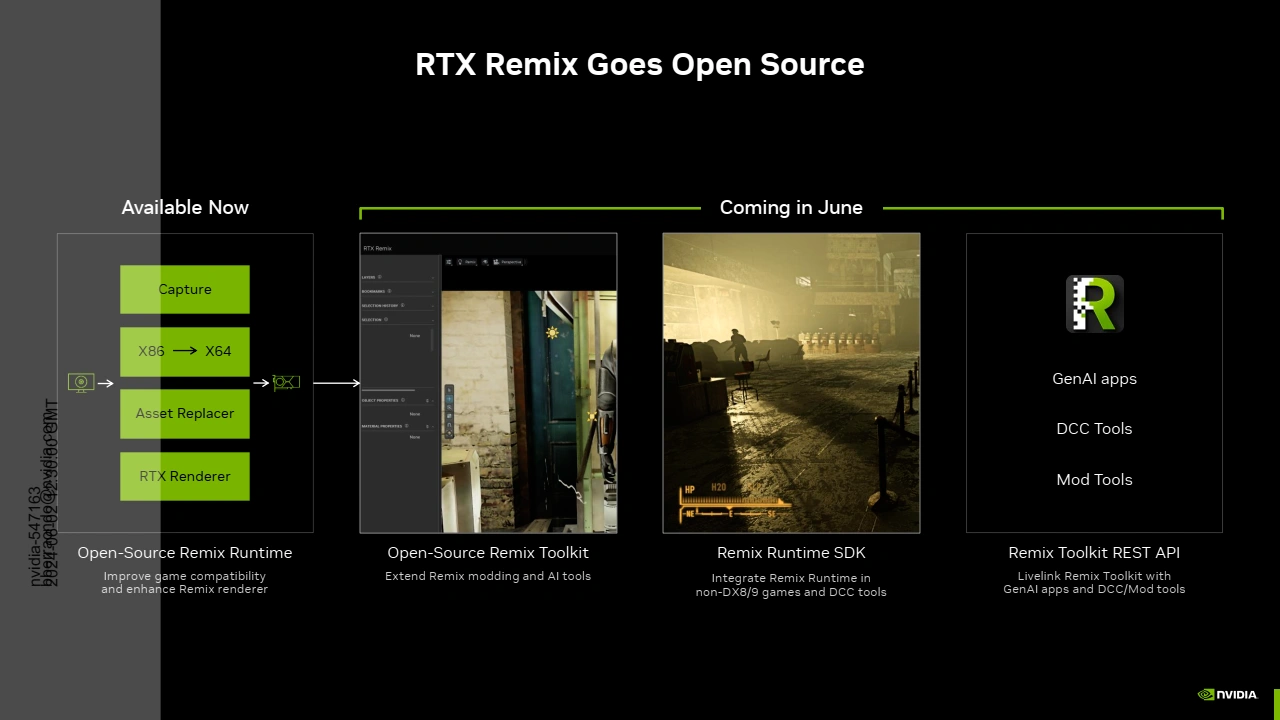

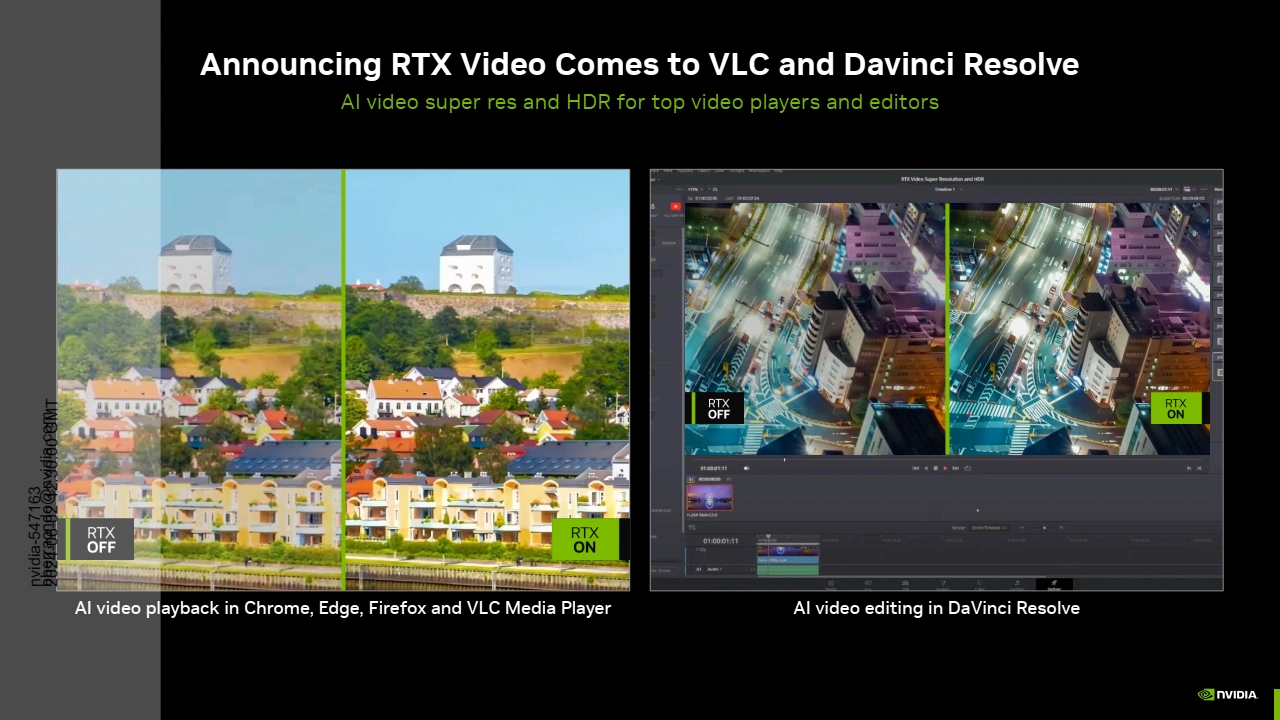

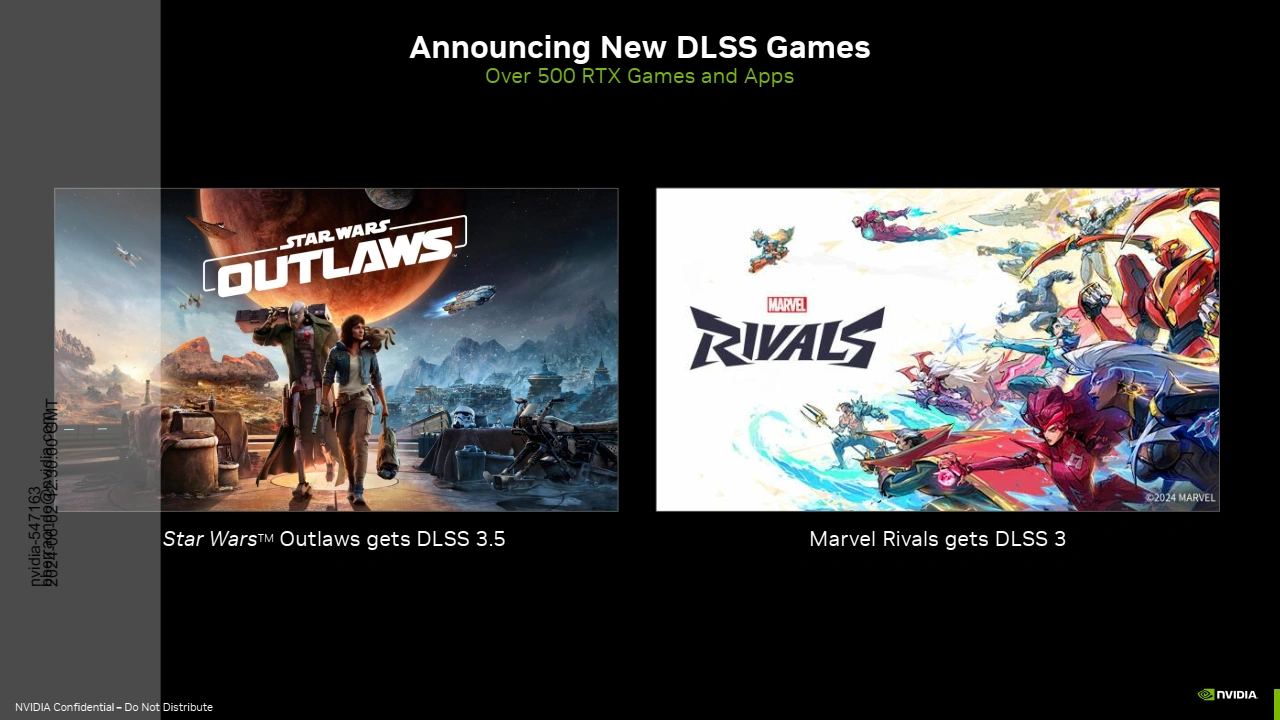

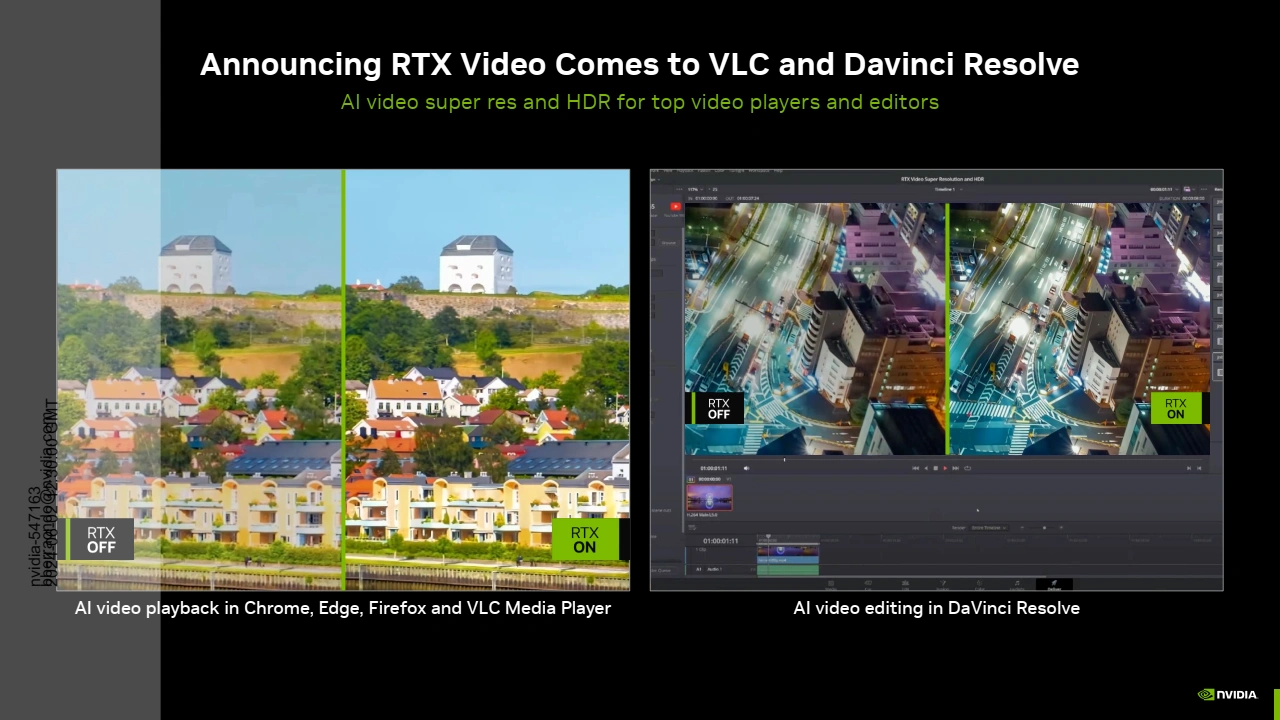

NVIDIA indique également proposer une accélération pour ConmfyUI, une interface utilisateur pour Stable Diffusion. Toujours dans le cadre des nouveautés, RTX Remix qui pour rappel est un outil des verts permettant un remasterisation de jeux s'appuyant sur Omniverse, passe Open source. Enfin, on ajoutera à la liste des annonces du jour, la prise en charge du DLSS dans deux jeux à venir (Star Wars Outlaws et Marvel Rivals) et l'intégration de RTX Video au sein de VLC et DaVinci Resolve.

Pour finir, le CEO des verts toujours vêtu de son intemporel blouson en cuir, a profité de cette conférence pré Computex pour nommer la future architecture des verts (post Blackwell donc) : il s'agira donc de Rubin, du nom de l'Astronome américaine Vera Rubin.

Ça sens l'annonce futur de la 5090 compatible sff alors que la 4090 ne l'ai pas au vu des précédentes rumeurs

15 cm de haut, 30 cm de long, 3 slots ! C'est quoi ce SFF ? Du Spacious Form Factor ?

2.5 slot et vs certains 4090 qui font 4.5 slots c'est small 😅

Vrai, mais j'ai toujours du mal à me faire à ces GPU géants. Le format proposé reste quand même 4x plus gros que le standard PCIe single-slot. A ce compte là on peut presque tout faire passer en tant que SFF.

en vrai j'aurais préféré une adaptation en pc de bureau de la 4090 pour pc portable avec 175 watts tu peux faire une version mini itx 17 cm de long dual slot comme la fury nano par exemple