C'est une question que de nombreux actionnaires d'AMD se posent assurément, après avoir vu trimestre après trimestre les bénéfices extraordinaires que NVIDIA a su tirer jusqu'à présent de la vague de l'IA et maintenant qu'AMD a enfin de quoi rivaliser avec son concurrent ! En effet, NVIDIA est seul pour l'instant à avoir réellement profiter de cette hype autour de l'intelligence artificielle, tandis qu'AMD est plutôt jusqu'ici resté en marge du phénomène, bien que ses résultats ne soient pas à plaindre, ils sont très loin de suinter l'IA comme ceux de NVIDIA. Mais la donne va peut-être enfin changer !

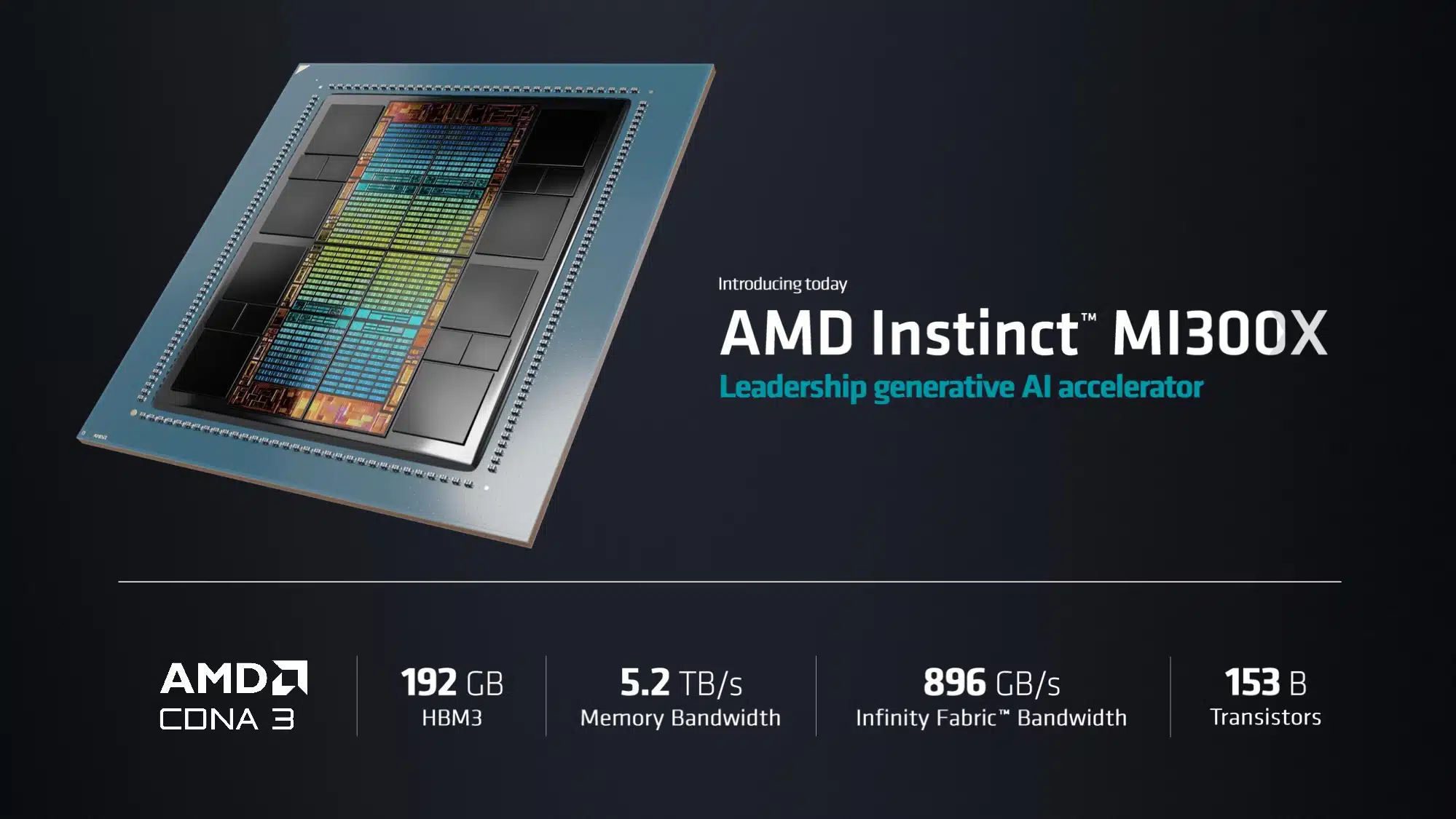

C'est en tout cas à présent une possibilité avec l'arrivée de la série Instinct MI300, composée de l'Instinct MI300A et Instinct MI300X, d'autant plus qu'AMD a annoncé des performances supérieures à fleuron H100 actuel de NVIDIA pour l'IA et serait d'emblée capable de lui prendre son titre ! Notez qu'une H200 est en préparation chez ce dernier, mais c'est ni plus ni moins une upgrade de la H100 avec l'introduction de HBM3e en remplacement de la HBM3. Il est un peu surprenant qu'AMD n'ait pas d'emblée choisi la HBM3e pour ses MI300, mais même avec celle-ci, la H200 aura toujours moins de mémoire et de bande passante qu'une MI300X, à raison de 141 Go et 4,8 To/s vs 192 Go et 5,3 To/s respectivement.

Sur le papier, la MI300X a donc de quoi plaire et permettre à AMD se surfer à son tour sur la vague. Et même sans forcément grignoter d'emblée sur les ventes de son concurrent, qui n'a toujours pas réussi à satisfaire seul la demande tellement forte du marché en matière d'accélérateur pour l'IA, et ce, en dépit des augmentations successives de la capacité de production. À ce propos, on serait d'ailleurs curieux de savoir comment a été planifié la chose par AMD, également chez TSMC. Qui sait, des arbitrages devront peut-être être effectués pour favoriser à présent la production d'Instinct, notamment pour le packaging avancé, l'étape de la production à laquelle la capacité tend le plus à manquer. Des places qui coutent très cher, à n'en pas douter.

Mais qui pour s'offrir le nouveau hardware de pointe d'AMD ? Lisa Su en a parlé lors d'une conférence avec les investisseurs le même jour de l'annonce des MI300. La PDG a fièrement annoncé que Microsoft, Meta et un OpenAI transformé ont tous décidé de passer d'importantes commandes pour de grosses quantités d'Instinct MI300X ! À combien la pièce, ça, personne ne l'a dit. Lisa Su a tout juste admis que les solutions d'AMD devront être moins chères à acheter et à exploiter pour faire de l'ombre à la concurrence. La disponibilité aussi sera un facteur très important. Il y a un coup à jouer, car chez NVIDIA, il faut actuellement patienter jusqu'à 52 semaines pour obtenir de la H100 pouvant couter jusqu'à 40 000 la pièce.

Rappelons ici que Microsoft et Meta ont jusqu'ici été les deux principaux acheteurs, et de très loin, de H100 dans le monde en 2023! Leur intérêt est donc une très bonne nouvelle pour AMD, sans pour autant oublier que la plupart de ces gros acteurs travaillent aussi à leurs propres solutions, qui pourraient donc à terme poser le même problème à AMD qu'à NVIDIA. Le hardware est une chose, l'écosystème logiciel une autre. Il va de soi qu'AMD entend bien bousculer la domination de CUDA avec l'avancement de sa suite logicielle ROCm, désormais à sa 6ᵉ version.

À voir maintenant dans quelle mesure l'entrée en jeu d'AMD avec ses MI300X va arriver à bousculer le statu quo et affecter le marché, et par conséquent les résultats de son concurrent. (Source : Hardwareluxx, WinFuture)

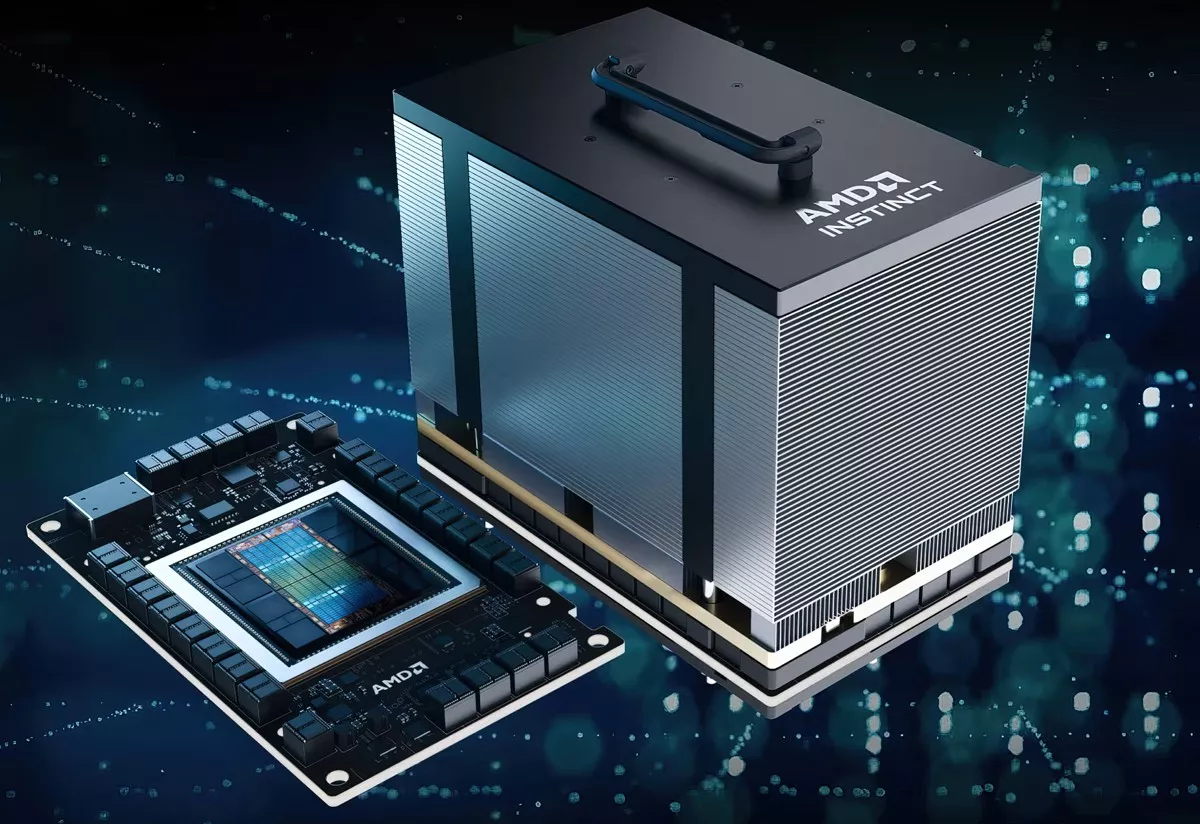

Oui, c'est gros et certainement lourd !

Ça reste des chiffres théorique mais le mi300x fait mieux que le h100 en ia et à plus de vram

La vram semble plus limiter les perfs en ia que la puissance de calcul elle même

Même la nouvelle version 141 go du h200 sera battue

Donc amd a ses chances

Oui, côté hardware, c'est bien. Mais ce qui fait aussi la force de NVIDIA, c'est l'écosystème logiciel. C'est donc également sur cet aspect-là qu'AMD va devoir beaucoup intensifier les efforts, car rien ne sert à avoir du super matos s'il est difficile de s'en servir à la hauteur de ses capacités.

Oui comme je dis c'est théorique

Le logiciel rentre en compte

Mais il y a une telle demande/besoin de puissance de calcul ia que apparemment les entreprises prennent tout ce qui est disponible 😅

Après, il y a eu de très gros efforts sur les implémentations et l'environnement logiciel, on peut suivre ça depuis le Github officiel de ROCm : par ici les curieux

Notamment depuis la mise à jour 5.7.1 parue en octobre dernier, qui ajoute le support des GPU Navi31 dans Pytorch, permettant de faire de l'inférence comme de l'entrainement. ROCm est aussi pris en charge dans ONNX Runtime, donc bon on est loin d'être à la rue aujourd'hui. Surtout que l'environnement Tensorflow diminue (en tout cas, nous c'est ce qu'on voit au labo) et à l'inverse, les projets exploitant Pytorch et/ou ONNX sont de plus en plus nombreux.

Il faudrait voir à quel point les différents entre OpenAI et NVIDIA jouent, car ONNX est développé par le premier, le fait que ce soit un outil open source le rend présent dans énormément de projets émergeants, donc à voir, NVIDIA est certes bien établi, mais moins serein qu'il n'y a encore que un an 😉

Open ia est la depuis un moment tchat gpt nvidia a aidé au développement il a fournis les puces ils ont peut voir se qui limité les perfs

Je trouve bizarre qu'il soit rester a 6 piles de hbm comme sur le a100