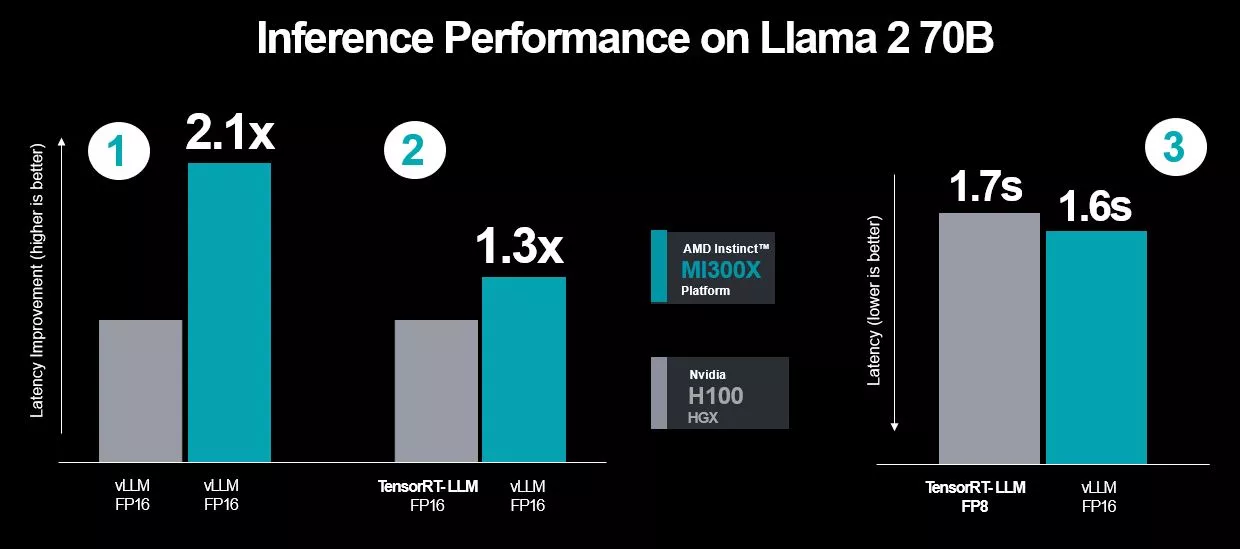

Mise à jour du 18/12/2023 by Matthieu S. - Étonnamment, l'intervention de NVIDIA (voir mise à jour du 14/12) avait été gratifiée d'une réponse assez rapide de la part d'AMD, vendredi soir dernier (le 16/12). Pas question de lâcher l'affaire donc, ce qui est probablement un bon signe quant à la confiance d'AMD en sa nouvelle série MI300 ! Selon AMD, les résultats présentés le jour du lancement avaient été mesurés en novembre, mais de nombreux progrès ont été réalisés entre-temps grâce à de nouvelles optimisations l'écosystème ROCm, notamment pour son usage avec les nouveaux accélérateurs.

C'est dans ces conditions et avec des scénarios adaptés cette fois-ci aux réclamations de NVIDIA qu'AMD a effectué une nouvelle passe de benchmarks. Résultat des courses, la MI300X aurait toujours une longueur d'avance sur la H100, et parfois même plus qu'avant ! Pour l'anecdote, les mesures d'AMD, de même que celles de NVIDIA, ont été effectuées dans des machines équipées en Xeon Sapphire Rapids, soit en terrain "neutre", quoi.

Malgré tout, il est tout de même difficile de nommer clairement un vainqueur pour ce segment dans lequel l'environnement logiciel évolue constamment, et avec, les scénarios d'usages. Mais cet échange a le mérite de prouver qu'AMD et NVIDIA sont cette fois-ci enfin bel et bien en concurrence ! Tant mieux, ce ne peut apporter que du positif pour la clientèle concernée.

Mise à jour du 14/12/2023 by Matthieu S. - Les benchmarks présentés par AMD pour mettre en avant les performances de ses nouvelles Radeon Instinct n’ont visiblement pas été du gout de NVIDIA, particulièrement ceux attribués à son champion H100. Sur le blog des développeurs, l’entreprise a donc accusé son concurrent de ne pas avoir testé le H100 avec un logiciel optimisé pour la plateforme utilisée et que s’il avait fait cela "correctement", il se serait rendu compte que le H100 est toujours 2 fois plus rapide. L’exemple mis en avant par NVIDIA est le résultat obtenu en interne avec le benchmark "Llama 2 70B Large Language Model", où il a été réalisé en 1,7 seconde par le H100, alors qu’AMD lui attribuait 3,6 secondes...

OK, soit. De toute manière, c’est un fait que les chiffres présentés par les fabricants dans leurs annonces sont pipeautés, dans le sens où ils n’affichent généralement que des demi-vérités arbitrairement basées sur les scénarios les plus favorables au produit présenté. Rien de neuf sous le soleil, tout le monde le fait. Pour l’instant, il est beaucoup trop tôt pour conclure que l’un est définitivement meilleur que l’autre, pour cela, il faudra attendre que les solutions concurrentes soient opposées en terrain neutre. Dans l’immédiat, l’accélérateur d’AMD n’est pas encore vraiment sur le marché, aucune affirmation ne peut donc être vérifiée pour l’instant. Le MI300X ayant plus de mémoire et qui est de surcroit plus rapide, il est réaliste, certes, de penser que la création d’AMD s’en sortira mieux dans certaines situations, mais pas forcément toutes non plus. Et comme toujours, les résultats dépendront aussi beaucoup du logiciel et des optimisations spécifiques en rapport au matériel utilisé.

Toutefois, le plus intéressant ici est de voir NVIDIA faire une sortie et avoir ressenti le besoin de réagir à l’existence d’AMD, ce que le Caméléon n’avait de mémoire pas fait depuis relativement longtemps, encore moins dans ce domaine. D’une certaine manière, c’est peut-être même flatteur et en dit potentiellement long sur la menace que pourrait représenter la nouvelle offre d’AMD sur ce segment, où NVIDIA n’a jusqu’à présent pas encore eu à lutter avec une opposition sérieuse. Tant mieux ? Au moins, NVIDIA a choisi un meilleur angle d’attaque qu’Intel pour s’en prendre à son concurrent.

Texte originel du 08/12/2023 - Quelle semaine pour AMD ! Non content d’avoir lancé un pilote résolvant un bug de longue date et apportant toujours plus de contrôle à l’utilisateur, la firme a également dévoilé deux puces à destination des professionnels : la Instinct MI300X, un GPU "normal" et la Instinct MI300A, qui se vante d’être le premier APU pour data centers. De quoi en faire une réussite ? C’est ce que nous allons voir !

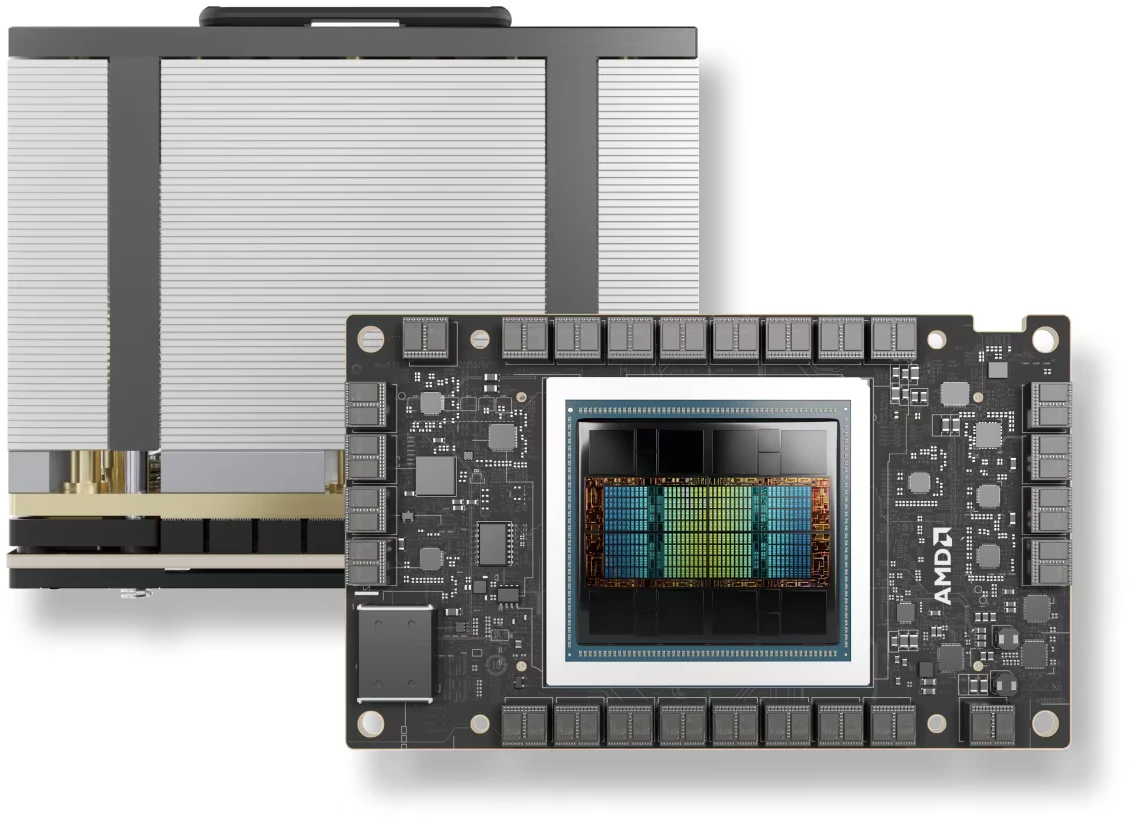

La MI300X dans son plus simple appareil

Fort de son architecture RDNA3 décomposée en chiplets dissociant unités de calcul (GCD, pour Graphic Compute Die) et cache (MCD, pour Memory Cache Die) qui fait le café (sans pour autant détrôner la RTX 4090 sur le très haut de gamme), voilà qu’AMD réutilise sa sauce magique avec CDNA3, la version pour professionnels. Et par "pro", il faut comprendre "gros serveurs", car pour fournir ses 163,4 TFLOPs en FP32, la nouvelle-née engouffre la bagatelle de 750 W ! Architecturalement, la prouesse est permise par 304 Compute Units disposés en 8 dies XCD (accelerator [X?] Compute Die, en 5 nm TSMC) intégrant chacun 38 CU. Rajoutez 8 stacks de HBM3 soir 192 GiB moulinant à 5,2 GigaTransferts/secondes (de quoi fournir 5,3 Tio/s selon la firme) sur une interface à 8192-bit supportant l’ECC, et voilà la belle. Enfin, pas tout à fait, car il faut encore compter sur 4 dies d’entrées/sorties glissés en-dessous (Input Output Die, en 6 nm), offrant 256 Mio d’Infinity Cache à la belle.

Tout cela est orchestré par l’Infinity Fabric, l’interconnect à tout faire des rouges, est se retrouve sur un même package grâce à un procédé nommé "3,5 D". Point de 4è dimension cependant, ce dernier résulte de l’utilisation jointe d’un stacking 2,5 D pour une partie de la puce (c’est-à-dire un bon vieil interposer en silicium du plus classique) et d’un empilement 3D grâce à l’hybrid bonding (déjà intronisé sur les CPU X3D de la boite).

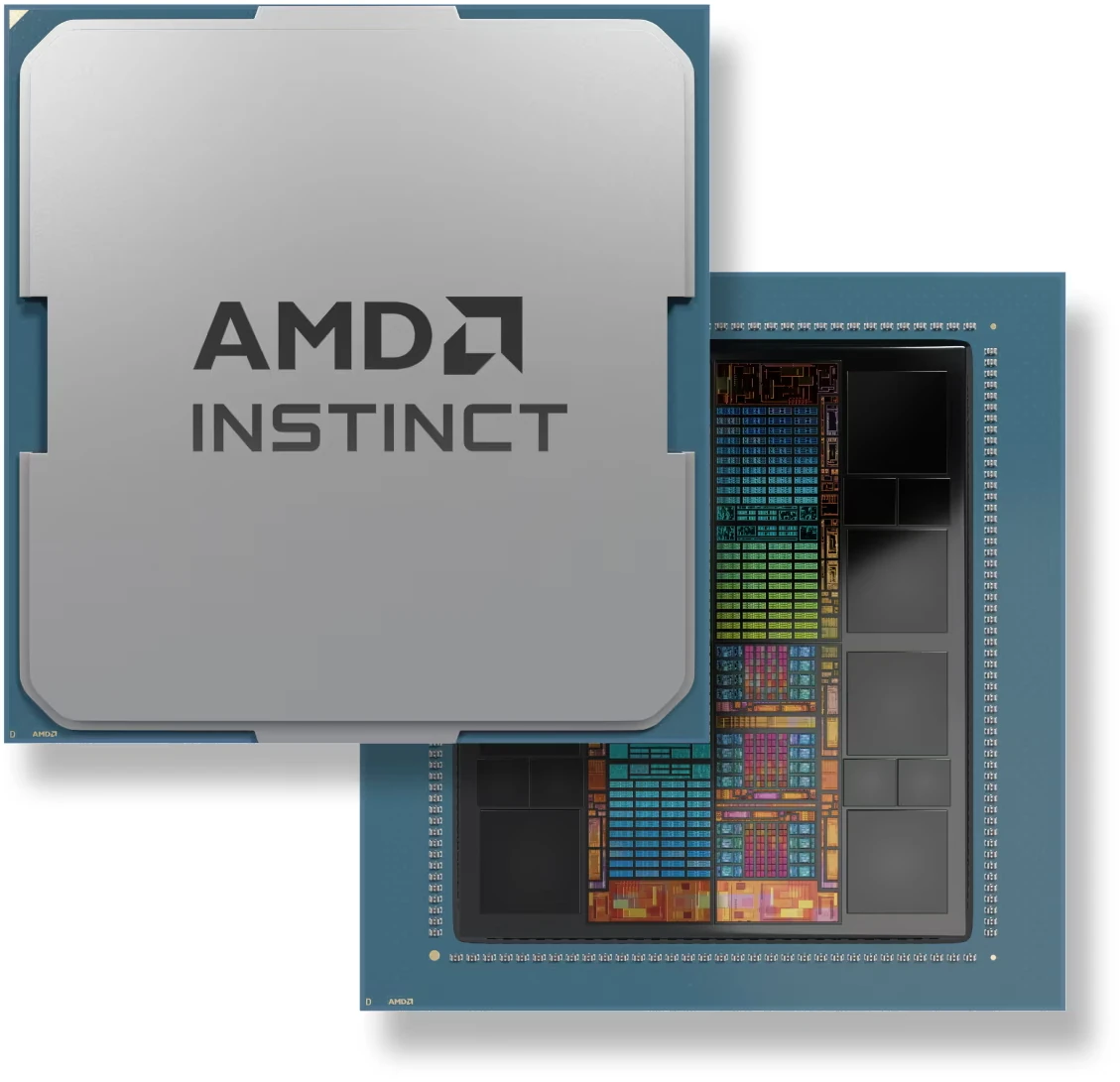

La MI300A, elle aussi à oilp'

Si la MI300A reprend une partie de la recette de sa sœur MI300X, elle en diffère par le format : socktée (socket SH5). Cela s’explique par le troc de deux XCD pour trois CCD (CPU Complex Die), comprendre une partie de calcul graphique de moins, mais des CPU en plus. De quoi former le premier APU pour data centers (la même idée que Grace Hopper au passage.... mais sous un seul die). Quelques ajustements sont également effectués sur la HBM3, ce qui amène le bousin à "seulement" 128 Gio de cette mémoire haute vitesse, pour 228 CU et 24 cœurs CPU : une sacrée config... sous un seul capot ! Revers de la médaille, le TDP de la bête est configurable entre... 350 W et 760 W : sortez les climatiseurs et les bons gros ventilos de racks ! Notez la présence d’un mécanisme de déplacement de l’enveloppe thermique entre CPU et GPU, ce qui permet d’optimiser la répartition des watts en fonction de la charge, pour toujours plus de performance à la clef.

Au niveau des performances, AMD communique sur une MI300X 1,6 fois meilleure que la NVIDIA H100 sur des tâches d’IA ; sachant que la MI300A serait, quant à elle, 1,8 fois meilleure en multiplication de matrices générales FP64 (DGEMM), et à égalité en INT8 et INT16. Pour l’occasion, AMD en a profité pour mettre à jour son écosystème ROCm concurrent des verts : de quoi offrir des gains plus ou moins importants sur l’intégralité de la gamme. Est-ce que cela sera suffisant pour convaincre les masses ? Nous verrons cela dans quelques années sur les statistiques de ventes !

Par là pour la fiche produit de l’AMD Instinct MI300X

Et par ici pour celle de l’AMD Instinct MI300A

Ces 2 sont top la ou nvidia a fait "juste" un a100 en plus grand avec le h100 la c'est une vrai évolution et avec de l'innovation

Apu pour serveur avec ram unifié c'est top

Alors suite à la réaction de NVIDIA, je suis allé voir le billet de blog, où l'on sent effectivement une sorte de vexation dans le discours. Restons sur des choses factuelles, je comprends parfaitement leur réaction quand on se sent tout puissant d'avoir eu le marché tout seul pendant des années, mais il y a un point qui me chiffonne trèèèèèèèès fort sur leur réponse.

Dans leur "script optimisé pour obtenir les résultats", on voit qu'un nombre incroyable de paramètres ont été rajoutés, qui sont loin d'être sans incidence et qui rendent leur réponse pas aussi exhaustive qu'on peut le penser. En effet, l'un des ajouts principaux est le fait que la précision dans leur script est divisée par 2, ce qui est effectivement très efficace pour des opérations d'inférence - qui sont celles pointées du doigt - afin d'améliorer les performances.

Cependant, dire que "ce sont là les vrais résultats" c'est pas si vrai : en faisant ainsi, on obtient pas du tout le même calcul, celui-ci se retrouvant à une précision plus faible, avec un entrainement différent, des impacts sur la consommation... Alors oui, NVIDIA prouve que le calcul aurait pu être optimisé, par contre quid d'appliquer ces optimisations, qui pour certaines ne sont pas uniques à leurs archis (puisque le même back end, Pytorch, est exploité de manière similaire). Car si passer en FP8 double les performances, bah pareil pour la MI300X, qui est compatible et qui oh, bah dispose d'exactement le même comportement sur le papier.

Bref, ce genre de réponse c'est pas sympa pour la clarté du discours, ça va rajouter au fanboyisme chez chacun des fabricants. Dommage que sur du matériel de ce genre, il sera toujours très compliqué d'obtenir des résultats de tests indépendants pour s'assurer de la réalité sur le terrain 😭.

Merci pour cette contribution 🙏

Je plussoie. Ça parait déjà très inhabituel comme intervention de la part d'un fabriquant, puisque tout le monde sait bien que les benchmarks fait par les firmes présentent les puces sous leur meilleur jour... Alors démentir publiquement, pourquoi pas, mais quand c'est en changeant l'application (car changer la précision, moi j'appelle ça changer le benchmark [DGEMM n'est pas GEMM !]) c'est d'autant plus... étrange. Certes, en pratique, on préférera p'têt du float8 au float16, mais la MI300 est aussi équipée d'unitées FP8 en 1:2 si j'ai bien lu la spec (comme tu le dis). Rajoutez à ça que le blog compare du débit (temps moyen d'exécution) là ou AMD cause latence (durée entre le début et la fin d'une unique exécution) et ça me semble être un opération de com' qui se prend un peu les pieds dans le tapis...

Intel se sentira un peu moins seul alors 😆

Ce qui est étonnant, c'est que pour un leader "irréprochable", il y ait ce besoin de justification, alors qu'il y a peu de données comparables.

Cela reste marrant de se dire qu'il y a encore quelques mois NVIDIA disaient qu'ils n'auraient jamais de concurrents viables, que tout le monde se disait qu'ils domineront le marché etc... Pour que maintenant, on ait la sensation que ce n'est plus aussi vrai. Pourtant, je pense qu'il aurait fallu des mois, voire des années pour qu'AMD les rattrape au niveau logiciel, à moins que la transition ne soit si facile ?

De mon avis, pas forcément le meilleur move des verts, qui pourrait surtout envenimer les choses plus que de rassurer leurs clients 🤣

Ton avis sur la nouvelle réponse d'AMD ? 😄

Perso mon avis c'est qu'autant le matériel que l'écosystème logiciel sont tout frais, ils vont forcément gagner en performance avec le temps (la carte d'nVidia n'a pas les performances du jour de sa sortie elle aussi).

Donc avec le temps, la MI300 supplantera la H100 sans le moindre doute. Il faudra voir comment elle se comporte face au H200. Pour la B100 par contre il n'y a guère d'illusion à se faire. Il faudrait qu'AMD raccourcisse son cycle de développement, car arriver 12 mois après le concurrent ça permet certes de placer son produit meilleur dans l'entre-deux du cycle d'nVidia mais ça fait aussi rater des ventes à AMD qui aurait pu capter un peu de marché en arrivant en Mars dernier.

C'est d'autant plus vrai qu'il semble qu'nVidia veut raccourcir le cycle de développement d'une génération à l'autre.

Il faut faire gaffe, on ne parle de notre marché en tant qu'individus pour se faire plaisir sur nos jeux vidéos, mais d'une gamme dédiée à des centres de services de taille conséquente. Les cycles de renouvellement, les temps pour la finalisation des achats ou les comparaisons de performances n'ont strictement rien à voir avec ce que nous pouvons comparer à notre échelle.

Un cycle de 12 mois, c'est pas si long dans un tel milieu, ou un serveur doit durer minimum 5 ans, et où l'on achète pas forcément des nouvelles lames tous les 6 mois. C'est d'ailleurs un reproche de certains professionnel quand le matériel évolue trop souvent : instabilité des environnements logiciels, compatibilité avec les lames compliqués (oui, car on achète pas toujours en pièce détachée, et les intégrateurs ne sont pas friands de ce qui est trop récent), problèmes dans le support...

Pour ce qui est du logiciel entre autre, je vais répéter un truc déjà dit : utiliser des cartes AMD pour le ML, c'est très similaire à NVIDIA, il suffit de déclarer un device("cuda") et de disposer d'une version de Pytorch compatible, ce qui est tout autant le cas chez les verts. Pour le développeur ou l'utilisateur final donc, probablement qu'il n'y verra aucun changement, et tout l'écosystème du machine learning ne va pas forcément se concentrer que sur le vert. D'autant plus que si AMD continue dans la voie de l'open source, il y a des chances que ça motive certains contributeurs à optimiser cette partie là de l'environnement logiciel, là où chez NVIDIA on est dépendant d'un système fermé et de la confiance que l'on attribue à l'entreprise. 2 visions, à voir laquelle va s'imposer dans un plus long terme.

Une réponse prévisible, qui montre à NVIDIA que ce n'était peut être pas une bonne idée de se précipiter dans la comparaison rapide et la vexation. Les évolutions de ROCm sont effectivement présentes, et montrer qu'ils obtiennent une meilleure latence avec en restant sur 16 bits faces aux tests en 8 bits chez les verts, c'est un cadeau pour le marketing.

Néanmoins, ça manque de pouvoir le vérifier en vrai, et il n'est pas impossible que c'est surtout qu'en pleine crise sur les appels d'offre chez NVIDIA qu'AMD ait tapé (sans le vouloir je suppose) là où ça fait mal. Il faudra voir selon le placement tarifaire et les dispos, mais c'est un terrain grand ouvert pour AMD que les verts ont offert, à voir si cela va jouer auprès des clients.

C'est une guerre de chiffre en simplifier dur de dire qui a raison ça dépend beaucoup su programme exécuté

Mais en simplifié amd revient dans la course il est plus largué

Blaxkwell par contre nvidia sera loin devant