Mise à jour du 16/11/2023 - La rumeur concernant l’arrivée de silicium conçu par Microsoft était bonne ! Durant sa conférence Ignite, Microsoft a présenté un duo de puces faites maison destinées à accélérer l’IA et le cloud.

La première est le CPU Azure Cobalt 100, un processeur avec 128 cœurs bénéficiant du jeu d’instruction Armv9 64-bit. Hélas, Microsoft a été plutôt avare en détail. Ce qui a été dit est qu’elle est basée sur une version personnalisée par Microsoft de la plateforme Neoverse CSS d’Arm, et il se pourrait donc qu’il s’agisse aussi de cores Arm Neoverse N2. Du reste, la puce possède 12 canaux pour la mémoire. Microsoft cible des performances supérieures à 40 % aux puces Arm non spécifiées actuellement employées dans les serveurs cloud d’Azure.

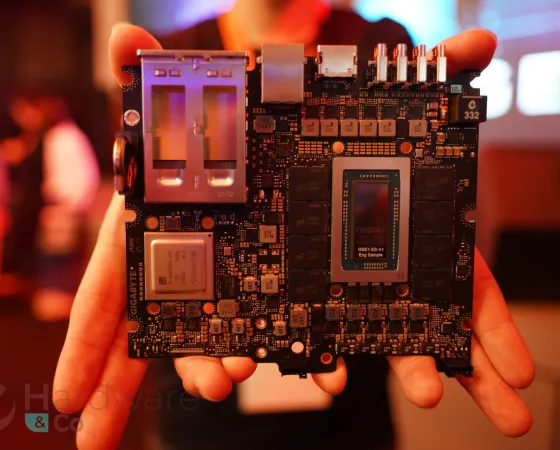

L’autre puce est l’aboutissement du projet Athena de Microsoft, à savoir un accélérateur IA baptisé "Maia 100" ! Les 105 milliards de transistors composant la puce ont été lithographiés au 5 nm par TSMC. Chaque accélérateur aura une bande passante agrégée de 4,8 Tb/s avec 4 puces mémoire de type HBM. Les performances étant apparemment toujours en cours d’évaluation, nous ne savons pas encore comment se placera la solution de Microsoft vis-à-vis du hardware concurrent, comme le H100 de NVIDIA ou les Instinct MIx00 d’AMD. Microsoft, craindrait-il une comparaison immédiate ? Il y a fort à parier que l'entreprise aurait déjà communiqué à ce sujet dans le cas où des performances supérieures ou moins égales seraient possibles...

Les nouvelles puces devraient commencer à être déployées dans les centres de données de Microsoft à partir de la première moitié de 2024. D’ici là, plus de détails seront sans aucun doute partagés, et avec des chiffres sur les performances, espérons-le.

Attention, ce n'est pas pour autant que Microsoft va laisser tomber ses partenariats avec d'autres constructeurs. En effet, la conférence Ignite a également fait la part belle au hardware et aux technologies d'AMD et d'AMD pour Azure, notamment la 4e génération EPYC, les nouvelles Instinct MI300X, l'accélérateur H100 et le futur nouveau modèle H200 de NVIDIA. Azure de Microsoft sera le premier cloud à utiliser le nouvel accélérateur d'AMD et l'entreprise a aussi pour projet d'utiliser la solution H200 de NVIDIA pour une nouvelle série de machines virtuelles. (Source : Microsoft, TPU)

We are announcing new innovations across our datacenter fleet, including the latest AI optimized silicon from our industry partners and two new Microsoft-designed chips. #MSIgnite https://t.co/5488N3pkKG pic.twitter.com/XeO0PDHAiR

— Microsoft (@Microsoft) November 15, 2023

Texte original du 09/10/2023 - Deux rumeurs ont émergé successivement sur le même sujet, celui de fabriquer des puces customs pour l'IA. Il se murmure qu'OpenAI et Microsoft y songeraient sérieusement.

Le premier serait en train d'explorer cette possibilité pour la prochaine génération de modèles IA et pour s'aider pourrait chercher à acquérir une ou plusieurs entreprises spécialisées dans ce domaine, potentiellement des startups. De ce côté-ci, rien n'aurait encore été décidé et rien n'aurait déjà été inscrit dans le marbre. Toujours est-il qu'OpenAI a déjà fait connaitre son mécontentement vis-à-vis des difficultés d'approvisionnement grandissantes et de la hausse successive des couts pour les puces IA, dont NVIDIA est à ce stade le fournisseur principal à la tête de 80 % du marché mondial en question. Une dépendance qui, on l'imagine, peut effectivement être problématique à bien des égards. Opter pour la création d'une puce custom - qui serait cependant fort certainement toujours fabriqué par le même, à savoir TSMC (ou peut-être Intel ??), dont le manque de capacité (certes, ponctuel), notamment en matière de packaging, est pourtant bien connu - permettrait effectivement une meilleure autosuffisance et surtout optimisation des couts, l'IA étant une affaire bien couteuse, autant à l'achat du matériel (un H100 peut facilement atteindre les 30 000 $) requis que pendant son opération. À savoir qu'OpenAI fonctionne actuellement avec un superordinateur conçu par Microsoft (gros investisseurs d'OpenAI) via Azure avec plus de 10 000 GPU signés NVIDIA et 285 000 cores de CPU.

Et Microsoft dans tout ça ? C'est un peu la même histoire et un peu pour les mêmes motivations : n'avoir qu'un seul fournisseur (gourmand et en situation de monopole) est problématique et couteux, alors qu'il semble y avoir volonté (et potentiel) de faire mieux et pour moins cher en interne. Allez savoir, OpenAI et Microsoft ont peut-être prévu de travailler ensemble sur ce projet, qui pourrait donc en réalité être commun. Côté Microsoft, la rumeur parle spécifiquement d'une annonce imminente planifiée pour novembre 2023 lors de la conférence Ignite (se déroulant du 14 au 17) d'une puce custom pour accélérer l'IA. Elle aurait d'ailleurs même déjà un nom de code : Athena !

Il est évident que la bulle de l'IA fait des envieux, surtout avec tout le pognon que NVIDIA est en train d'en extraire, presque seul, tout là-haut sur son p'tit nuage bien vert. Que des entreprises (petites et grandes) songent à se lancer dans la création de puces customisées, que ce soit pour faire concurrence, et/ou réduire leur dépendance et/ou le cout de leur infrastructure, serait en fait une suite assez logique. D'autres marchés sont passés par cette étape (comme celui du SoC pour smartphone, par exemple) et celui de l'IA, tout profitable et en pleine expansion qu'il est actuellement (et donc virtuellement peu risqué), devrait aussi y arriver avec l'arrivée progressive de nouveaux acteurs. Certes, déloger NVIDIA de sa position dominante ne sera pas une mince affaire, ce sera peut-être même impossible, mais on imagine que ce marché gagnerait tout de même à être moins déséquilibré... (Source : TPU)

Crédit image : TheAIGRID, via YouTube.

On manque énormément d'informations

Le maïa 100 semble avoir 4 piles de hbm ça me semble peu au vu du nombre de transistors

Car avec autant de transistors ça veut forcément dire une grosse puissance de calcul