Si, lors de la Gamescom 2024, nous avons pu rencontrer divers fabricants tels MSI, ASUS ou encore ASRock, certains grands géants de la tech étaient également présents, tel NVIDIA. Comme à son habitude, la firme avait tout un tas de démonstrations à nous montrer (que nous vous détaillerons ultérieurement, pas de panique !), le contenu le plus proche du hardware était sans nul doute la démonstration du G-SYNC Pulsar, une technologie de réduction du flou de mouvement dévoilée en début d’année au CES (ici pour la communication de la firme à ce sujet — en anglais), et rappelée il y a quelques jours à l’occasion de la sortie du jeu Black Myth : Wukong. Plongeons ensemble dans les détails de son implémentation !

G-SYNC, késako

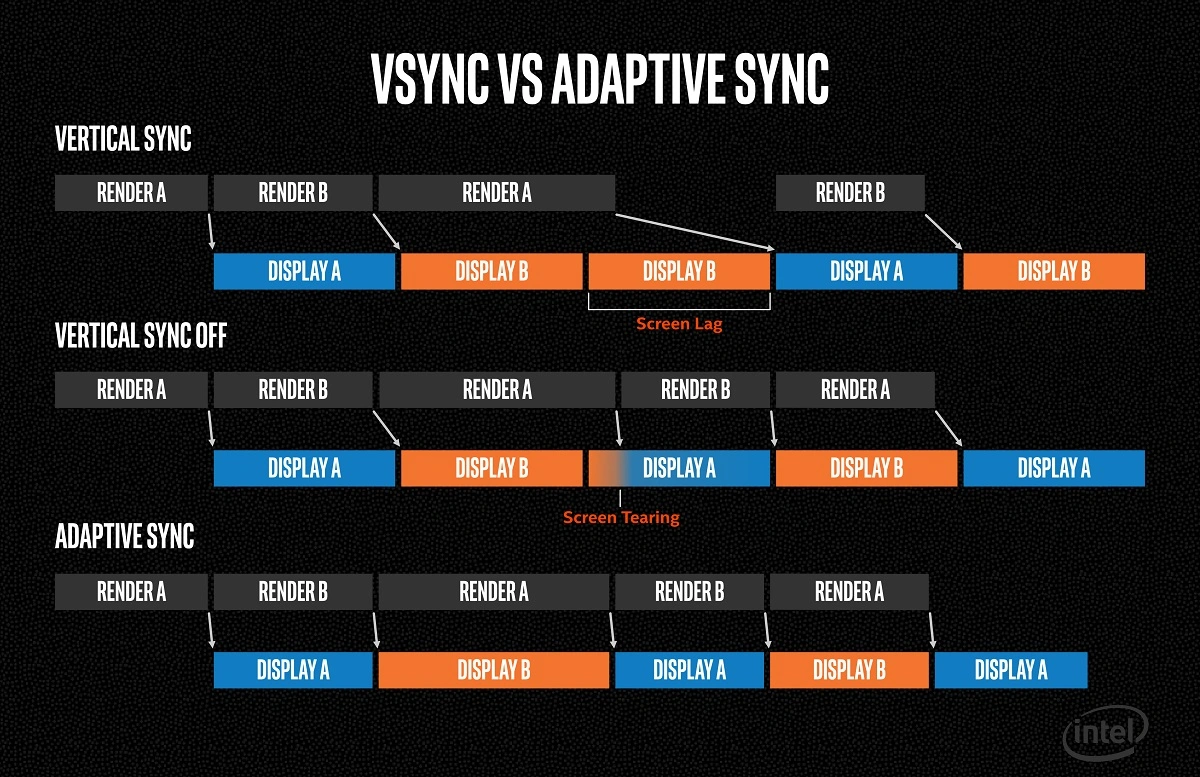

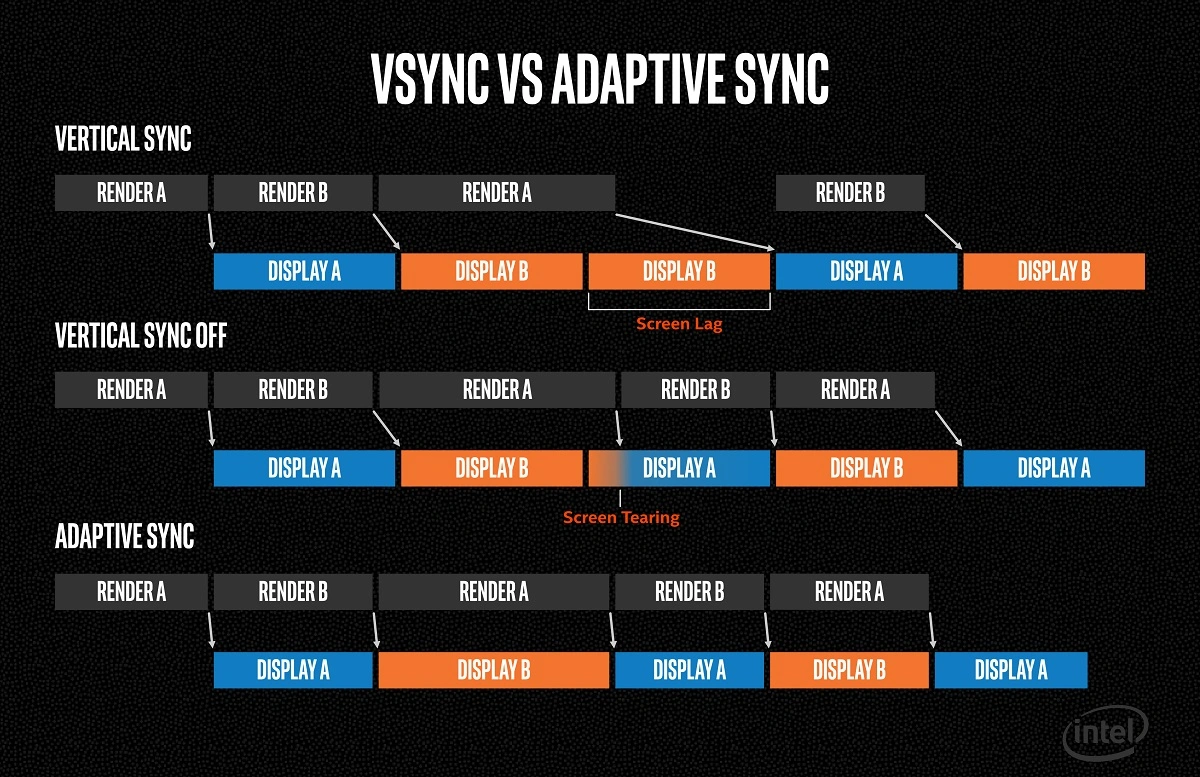

Tout d’abord, revenons en arrière sur le G-SYNC. Cette technologie permet de faire dialoguer l’écran et la carte graphique de sorte que le premier affiche une image dès que le second a fini de la calculer, basée sur l’Adaptive Sync de VESA. Chez AMD, la chose se nomme FreeSync. Auparavant, trois modes étaient possibles :

- Pas de synchronisation : l’image envoyée par le GPU peut alors être mise à jour pendant l’affichage, ce qui crée des déchirures (tearing), c’est-à-dire que le bas de l’image correspond à la première frame, et le haut à la seconde.

- Synchronisation verticale (V-Sync) : la carte graphique calcule une image, puis attend un signal régulier du moniteur signalant qu’elle peut être affichée. Cela évite le tearing, au prix d’une latence plus élevée puisque l’image affichée est issue d’un calcul ancien et ainsi une sensation moindre de fluidité. En revanche, la carte graphique peut se reposer une fois l’image calculée, ce qui diminue sa charge et donc la chauffe.

- Synchronisation rapide (Fast Sync) : tout comme la V-Sync, sauf que la carte graphique ne s’arrête pas et continue de calculer ses images. Seule la dernière image complète est envoyée une fois le moniteur prêt. La latence est ainsi bien meilleure, mais la fluidité pas encore au top, en particulier si la carte graphique « manque » un créneau de rafraichissement, auquel cas l’image précédente est maintenue : c’est ce qu’on nomme des microlatences ou stuttering.

Avec la G-SYNC, l’initiative d’affichage de l’image est la responsabilité de la carte graphique (dans les limites d’une fréquence minimale et maximale de l’écran). On affiche alors une image dès que celle-ci est prête, minimisant la latence et maximisant la sensation de fluidité à taux d’image par seconde égal. Pour ce faire, l’écran doit être muni d’un module spécifique capable d’effectuer ce traitement du signal à afficher, et là, deux choix sont possibles : un FPGA — circuit générique programmable — ou un ASIC — une puce dédiée qui ne fera que ça. Dans les premiers jours du G-SYNC — et ses multiples versions, cinq selon nos sources, pour répondre aux besoins croissants en matière d’interface et de rapidité —, la première solution avait été retenue, avec initialement un modèle de chez Intel (via sa filiale Altera) : un Aria V GX, équipé de 768 Mio de DDR3. Vu le prix élevé et la jeunesse de la technologie, le choix était parfaitement sensé, le seul inconvénient par rapport à un ASIC étant la consommation du module, mesurée à une petite quinzaine de watts. À l’inverse, le concurrent AMD a fait le choix d’une implémentation directe via des scalers manufacturés par Realtek, Novatek ou MStar, supportant le standard Adaptive Sync… Une solution qui était impossible pour les verts, puisque leurs premiers travaux sur le G-Sync le précèdent largement ! Cependant, dans un but de limitation des coûts, ces scalers n’implémentaient pas tous le support total de l’Adaptive Sync, ce qui a donné lieu à divers labels tels le LFC ou le FreeSync Premium. Finalement, l’argument du coût a eu raison du G-Sync, et NVIDIA a également accepté l’utilisation de moniteurs Adaptive Sync dépourvus du module G-Sync sous le patronyme G-Sync Compatible.

Illustration du fonctionnement de l’Adaptive Sync : le travail de la carte graphique est en gris, les images affichées en couleur ; un changement de couleur correspondant à une nouvelle image

Ça pulse !

Bon, nous voilà bien avancés, mais qu’est-ce que Pulsar et le flou de mouvement ont à faire là-dedans ? Eh bien, par un mécanisme couplant le rétroéclairage à la fréquence des écrans, il est possible de diminuer le flou perçu lors de mouvements rapides d’éléments sur l’écran. Nous insistons sur le flou perçu : il n’est pas question ici d’un flou cinétique rajouté par le moteur de jeu pour l’immersion (que certains s’empressent de désactiver !), mais d’un phénomène optique lié à la persistance rétinienne se produisant lorsque l’œil suit un objet sur un écran (vous pouvez en faire l’expérience ici : plus le taux de rafraichissement est élevé, plus l’extraterrestre semble flou). Pourtant, si vous faites un arrêt sur image, les pixels sont, eux, bien nets !

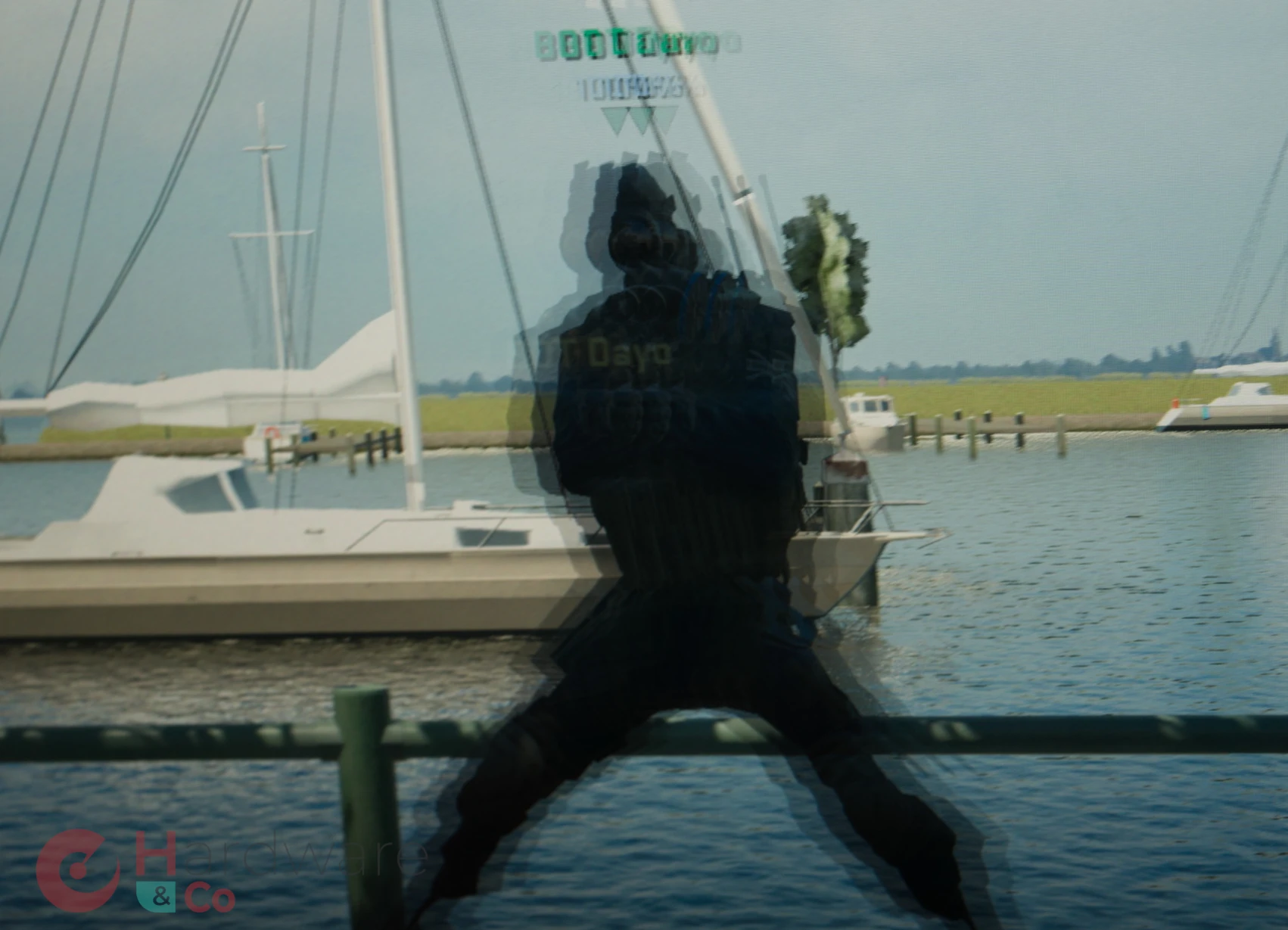

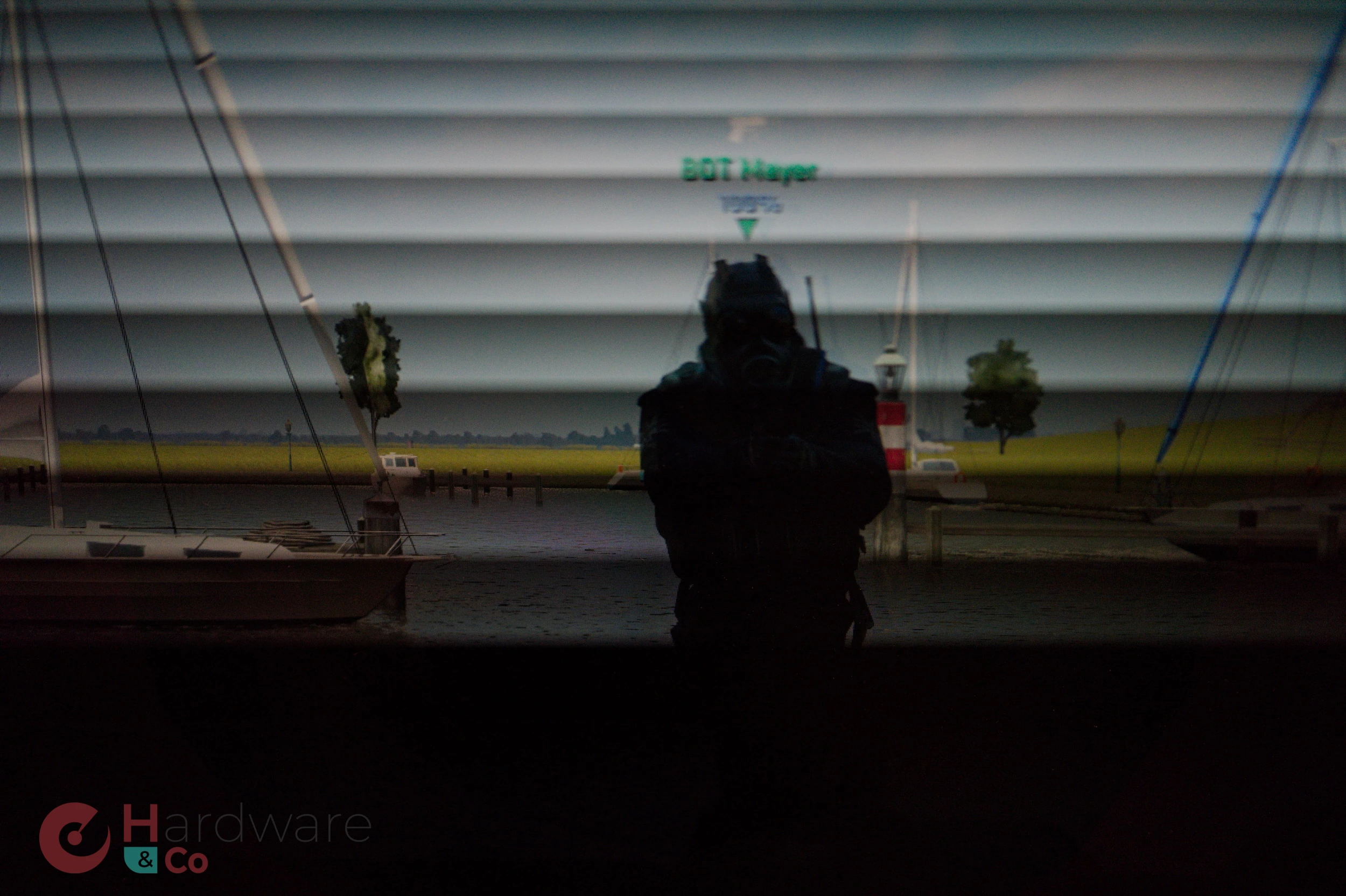

Dans les faits, le mouvement sur un écran n'est qu'une succession d'images fixes (illustration ici d'un écran non-pulsar, où notre appareil a flashé trois images bien nettes).

Pulsar va régler cela en diminuant la durée pendant laquelle une image est affichée via le backlight strobbing. Sur les écrans LCD, la dalle est composée d’une partie à cristaux liquide affichant les couleurs en surimpression, et d’un système de rétroéclairage (LED, mini-LED, micro-LED, éventuellement épaulé d'un Quantum Dot…) chargé de produire la lumière nécessaire pour projeter le tout dans vos yeux. Au lieu de produire une lumière continue, le backlight strobbing va aller faire clignoter cette couche, et ce de manière synchronisée avec les images affichées. Résultat ? Les images viennent frapper la rétine pendant un laps de temps plus court (uniquement quand le rétroéclairage est actif), mais avec une luminosité plus forte, ce qui améliore la sensation de netteté. Pour avoir testé la chose en pratique, le constat est sans appel ! Si vous cherchez un cliché montrant la différence de flou, n’allez pas plus loin : il faut un moyen de synchroniser un mouvement de caméra avec un mouvement de personnage sur l’écran pour observer la chose, ce qui est impossible à reproduire pour nous — qui plus est dans le salon qu’est la Gamescom — : il faudra se fier à notre ressenti.

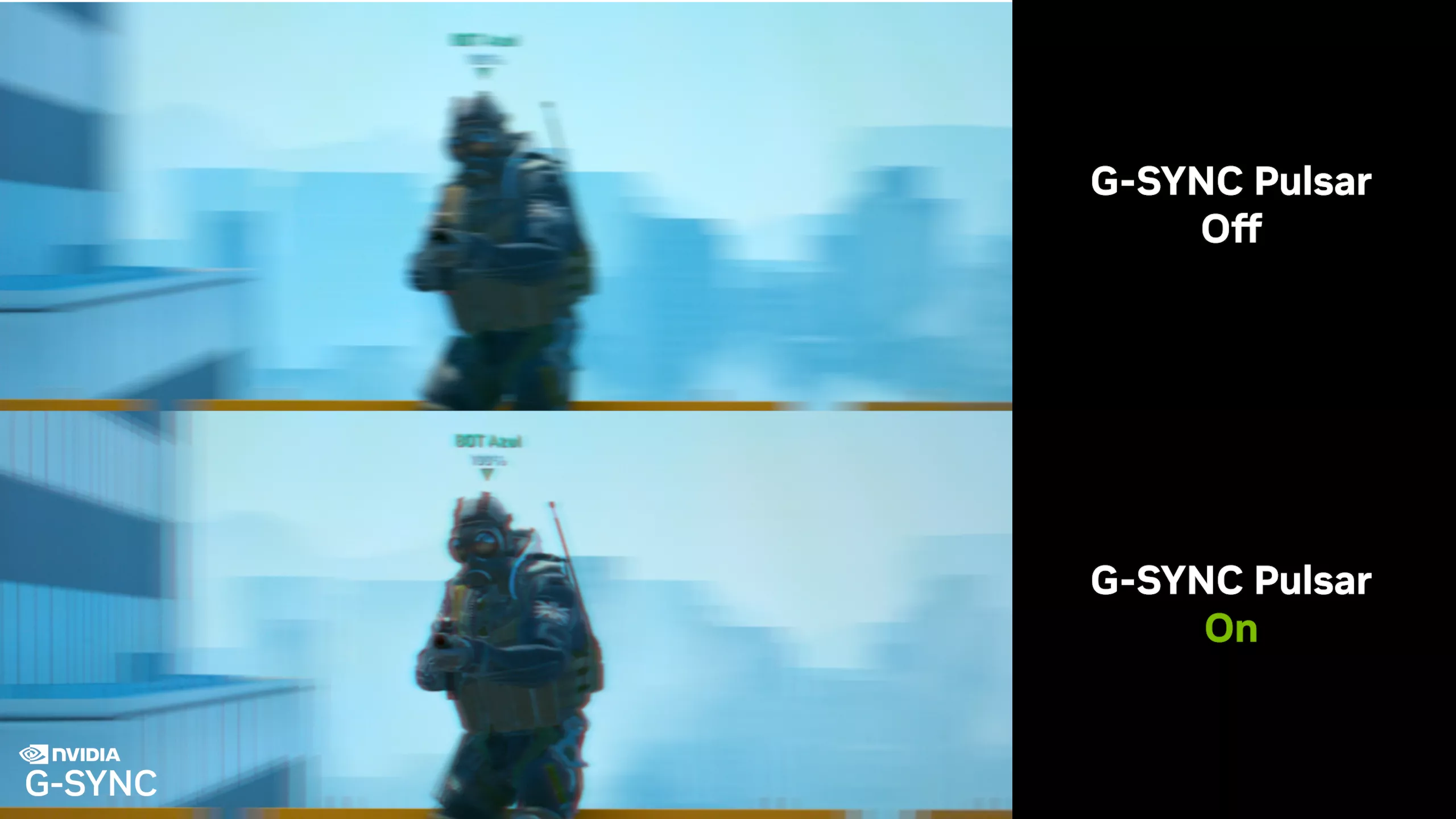

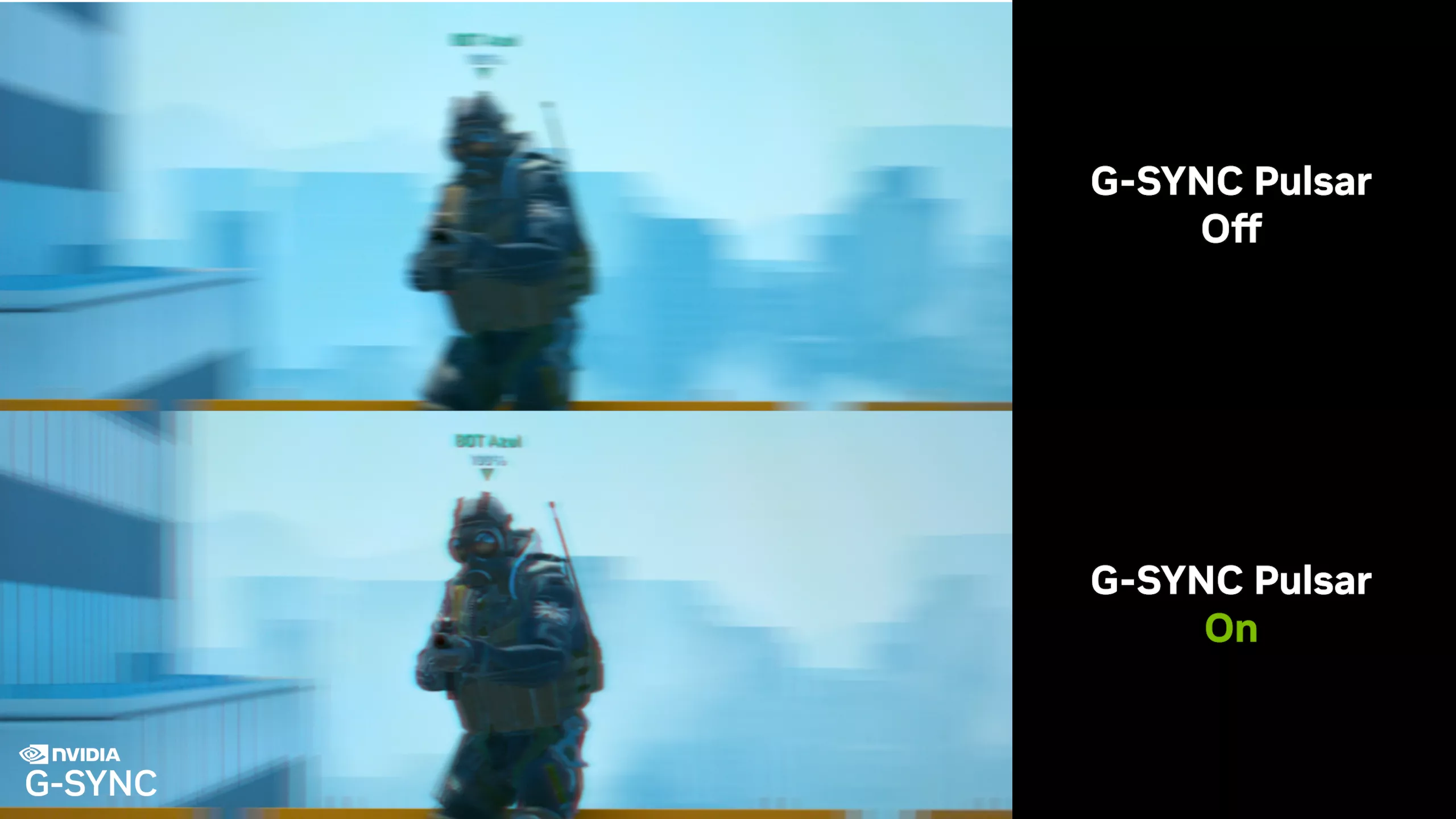

Illustration de l’effet par NVIDIA

Inconvénient de la chose : d’une part, le clignotement induit une perte de lumière, il faut donc un rétroéclairage plus puissant pour conserver un même niveau de luminosité. D’autre part, la vibration peut être visible à « basse » fréquence, si bien que Pulsar se désactive en dessous de 90 FPS pour des raisons de confort. Notez enfin que, sur un OLED, l’implémentation doit être encore plus simple puisque les pixels ont leur propre rétroéclairage, mais nous n’avons pas plus de détail à leur sujet.

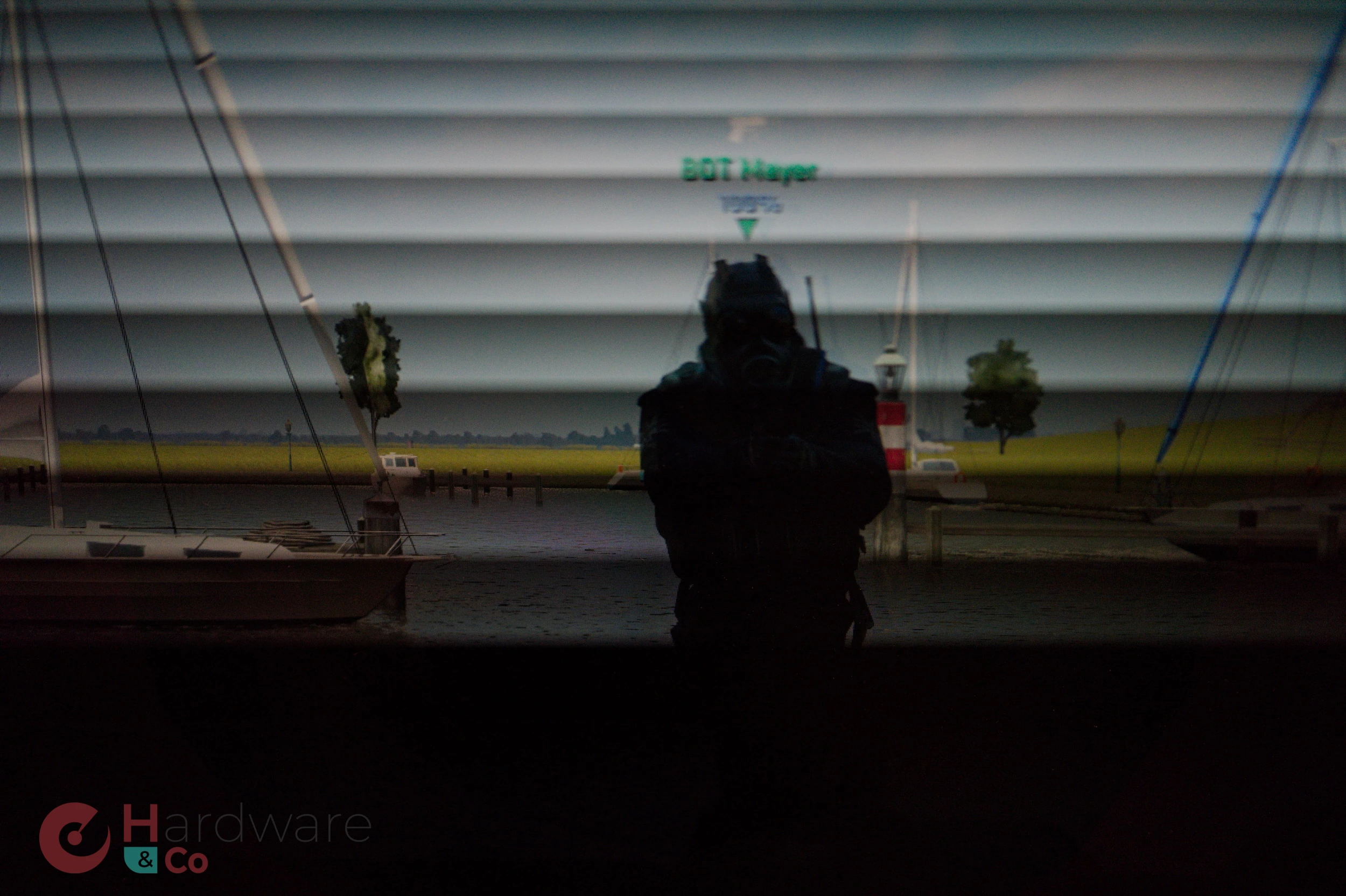

Notre caméra a pu percer les mystères du backlight strobbing : ici, le moniteur désactive son rétroéclairage par bandes horizontales.

Pour permettre à cette technologie d’être compatible avec le G-Sync et la fréquence modulable des écrans, NVIDIA a dû envoyer à la corbeille son module G-Sync, qui est désormais remplacé par un scaler de chez MediaTek : un MT9810 pour être exact. Les premiers modèles équipés seront les AOC AGON Pro AG276QSG2, Acer Predator XB273U F5, et ASUS ROG Swift 360 Hz PG27AQNR. NVIDIA communique également sur un prix réduit en passant par ces modules (MediaTek s’étant débrouillé pour amortir le coût de production et de design, la puce devant logiquement être plus petite qu’un FPGA généraliste), bien que le montant exact de la ristourne ne soit pas connu. L’objectif à long terme étant d’étendre ces scalers sur toute la gamme, nous pouvons espérer des baisses de prix dans les mois à venir une fois les gammes de moniteurs renouvelées : chouette !

Chez nVIDIA, ils aiment bien les choses compliquées

Ca impressionne le chaland, du coup ca fait vendre

Exemple, tout le monde est en admiration devant le DLSS, alors que c'est une techno dispensable

Pour la clarté de l'image, il "suffit" de jouer en 240Hz, et c'est plie

Faites nous de bons moniteurs 4K 240Hz, c'est tout ce que je demande

Justement non et c'est expliqué dans la news...

Bah c'est pas un peu contradictoire ce que tu racontes ? Tu nous sorts que le DLSS est dispensable, puis tu demandes ensuite d'avoir des écrans en 4K 240 Hz ? Va falloir que tu nous explique comment tu fais ça, je suis curieux.

Avoir un ecran 4K ne t'oblige pas a jouer en 4K

La 4K, c'est ideal pour travailler, quand tu joue, tu peut descendre en FullHD. Et il y a d'autres techniques que le DLSS pour upscaler du FullHD en 4K

Tu ne réponds pas vraiment à la question que je te pose là 😅

Plutôt que de botter en touche, je te demande comment tu fais ? OK il y a d'autres techniques, par contre explique moi alors pourquoi le DLSS à côté est dispensable ? Quel problème t'as avec le DLSS en particulier ? Parce que je ne saisis pas ton raisonnement là.

jouer en fullhd sur un écran 4K, bonjour l'aliasing à outrance

il ne jure que par Lossless Scaling, qui est sympa mais qui est très loin d'être la solution miracle.

Malheureusement tout ce que tu dis est faux.

LOL !

Tout ça pour ne pas utiliser le triple tampon (triple buffering), qui possède l'immense avantage de garantir une absence totale de déchirure (tearing) et de bégaiement (stuttering)... Bon, il y a bien un petit inconvénient (latence un peu supérieure (*)) avec le triple tampon, mais avec les fréquences de synchro verticale des moniteurs modernes, et la puissance démentielle des GPU, on est plus vraiment à 1/120ème ou 1/150ème de seconde près !

(*) Latence oscillant entre 1 (cas idéal où la trame n+1 a été calculée juste à temps pour être affichée) et 2.99 trames (cas défavorable où deux trames sont en mémoire tampon au moment où le moniteur est enfin près à afficher la trame suivante).

Quel rapport avec le sujet de la news ? G-Sync Pulsar vise à régler le problème de persistance rétinienne et le triple tampon n'a aucun impact à ce niveau... Qui plus est, c'est loin d'être la panacée que tu décris du fait justement de la nécessité d'avoir la synchro verticale activée, ce qui peut être problématique dans bien des cas pour des configurations à la limite dans certains jeux conduisant au yoyo entre synchro à la fréquence de rafraîchissement du moniteur ou la moitié de cette dernière entraînant là, de belle saccades (+ accroissement de la latence dont tu parles mais qui n’est pas négligeable à 60 i/s par exemple).

Cela à un rapport avec le Gsync, Freesync, Vsync: et non, pas du tout, bien au contraire, le triple tampon permet de se passer totalement de toute forme de synchronisation du moteur de rendu avec le moniteur (le moniteur fonctionne à sa fréquence de rafraîchissement *fixe* et le GPU envoie simplement l'image de l'un des deux tampons de réserve pendant que le GPU fait son rendu "ne roue libre" dans le troisième).

Donc ça n'a rien à voir avec le G-Sync Pulsar qui est le sujet de la news, mais plutôt que de lire cette dernière et réagir en conséquence, tu es parti dans un hors sujet sur le triple tampon. 🙃 Par contre il est tout à fait exact que j'ai répondu trop vite sur le triple buffering, mea culpa sur la confusion.

Mais je maintiens, ce n'est pas à mes yeux la solution idéale en termes de confort et je lui préfère largement les VRR. D'ailleurs le triple buffering ne règle pas tous les soucis de saccades puisque tu peux avoir un retard combiné de rendu d'images successives qui dépasse 2 tampons, à quoi s'ajoute le surcroit de latence non négligeable sur des taux de fps aux alentours de 60. Cela va bien sûr dépendre des jeux et certains seront plus ou moins adaptés à cette techno.

Après, que cela te convienne tant mieux, et c'est tout ce qui compte en définitive.

Le tampon triple ne résout pas le problème de bégaiement car l'image affichée reste la dernière complète. Dans le cas où le jeu tourne à 59 FPS pour un écran 60 Hz, il y aura un moment où la même image devra être affichée sur deux cycles de rafraîchissement de la dalle ; c'est ce que le G-Sync / FreeSync cherche à éviter (et, au passage, l'importance cruciale du LFC dans le FreeSync). Le triple buffering est un juste milieu entre le VSync et le Fast Sync, mais pas une solution au problème de désynchronisation des fréquences... Il faut également toujours une synchronisation car la rotation des tampons doit se faire en dehors des phases de mise à jour du moniteur (i.e. la techno repose toujours un échange avec moniteur indiquant les périodes de rafraîchissement de l'image).

En libérant le GPU du Vsync (ou Freesync, GSync et autres variantes) on permet un gain en FPS, car au lieu de se retrouvé bloqué lors du de l'appel "swap buffer" par le pilote du GPU qui attend bien sagement l'impulsion de synchro verticale suivante du moniteur, le CPU peut commencée à envoyer les "draw calls" pour la trame suivante au GPU.

Du coup, le rendu peut se faire bien au delà de la fréquence d'un moniteur 60Hz (dans votre exemple), et il n'y a aucun bégaiement (stutter) !

Le problème est que la plupart des utilisateurs ignorent que s'ils active le tampon triple, il doivent aussi désactiver le Vsync, et là, évidemment, le résultat est pire.

Pour ma part, je n'ai jamais utilisé le Vsync et toujours le tampon triple, sur tous mes PC et avec toutes mes cartes graphiques et moniteurs, et je n'ai jamais rencontré le moindre souci de bégaiement, à partir du moment où le moteur de rendu est capable de générer un peu plus de trames par seconde que la fréquence VSync du moniteur (et avec un 60Hz et un couple GPU+CPU moderne, ce n'est vraiment pas un problème de nos jours: la plupart des jeux AAA tournent à plus de 100fps lorsque laissés "en roue libre", i.e. avec Vsync désactivé).

C'est là qu'est la confusion : le gain de fluidité du G/Free Sync ne s'effectue que lorsque le frametime est (légèrement) superieur au temps entre deux images affichées par l'écran (cf illustration du milieu de l'article). Dans ce cas là, que vous soyez en tampon triple / vsync / fast sync, il y aura du beggaiement (et peu de temps mort GPU car la carte est principalement "derrière" l'écran), et pas en Adaptive Sync. Par contre, l'Adaptive Sync "de base" (pas pulsar) en 120 Hz+, c'est bien moins perceptible !

Dans mon exemple, je supposais que les 59 FPS sont une limite dûe à la lourdeur du rendu (en RTX non upscalé sur une carte ancienne par exemple), et donc que le tampon triple n'y changera pas grand-chose..