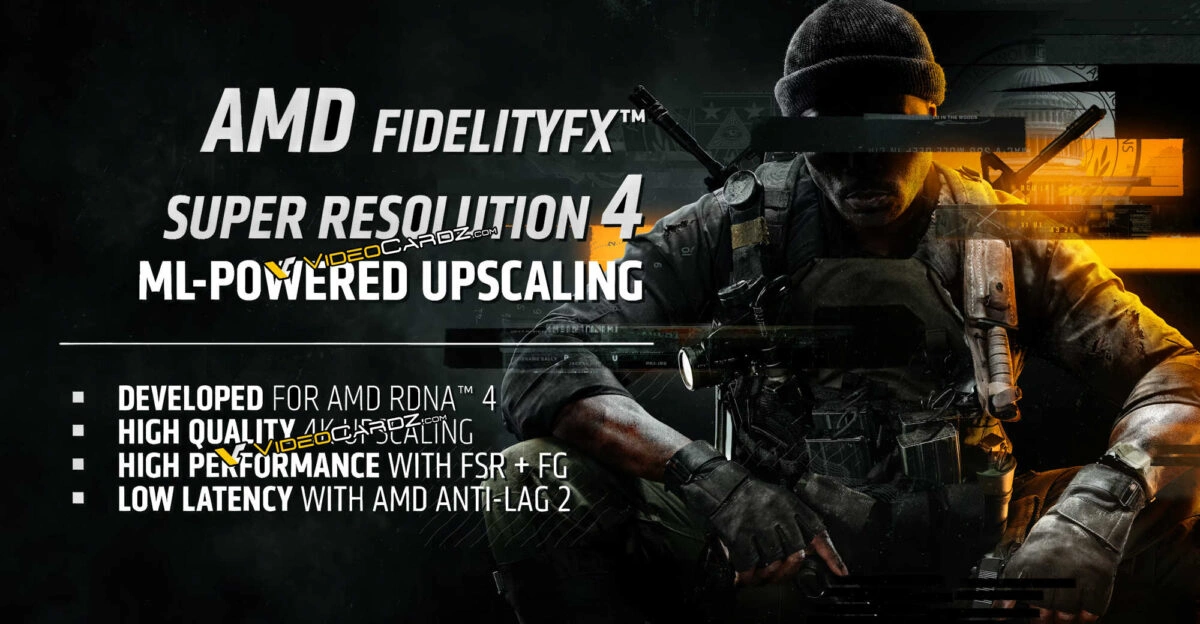

Les grandes annonces du CES sont attendues ce soir pour AMD et dans la nuit pour NVIDIA, avec notamment les nouvelles générations de cartes graphiques de chacun, respectivement baptisées Radeon RX 9000 et GeForce RTX 50. Mais ce n'est pas tout car ces cartes graphiques à la sauce 2025 devraient également être accompagnées de nouvelles générations de mise à l'échelle pour chaque fabricant : le FSR 4 chez AMD et le DLSS 4 chez NVIDIA.

VideoCardz est semble-t-il parvenu, comme souvent d'ailleurs, à mettre la main sur la présentation officielle d'AMD sans avoir eu à se soumettre à un quelconque contrat de non divulgation. Parmi les données qu'ils distillent au compte goutte, une information concernant le futur FSR 4 ne manquera sans doute pas de faire couler de l'encore si elle venait à être confirmée : le FSR 4 ne serait compatible, d'après AMD lui-même, qu'avec les Radeon RX 9070 :

Les récentes AMD Radeon RX 7000 devraient donc devoir se contenter à l'avenir du FSR 3.1, tandis que les Radeon RX 9070 et RX 9070 XT auraient de leur côté accès à ce fameux FSR 4 sur les jeux compatibles avec la nouvelle version de la technologie. La grande nouveauté du FSR 4 sera l'ajout de l'IA pour optimiser encore davantage la solution d'upscaling d'AMD, à la manière de ce que NVIDIA fait déjà avec son DLSS. À ce titre, de nombreux possesseurs de Radeon RX 7000 devaient pourtant espérer avoir droit au parfum du FSR 4 puisque leurs cartes graphiques sont dotées de ce qu'AMD appelle des "Accélérateurs d'IA" dans leur architecture, chose que les Radeon RX 6000 n'avaient pas. Pour autant, et si on en croit donc cet extrait d'image qui proviendrait d'après nos confrères directement d'AMD, seules deux nouvelles cartes à base de l'architecture RDNA 4 et de sa nouvelle génération d'accélérateurs d'IA plus performante à n'en pas douter pourraient finalement faire fonctionner la nouvelle technologie.

Une autre question se pose : pourquoi préciser uniquement "RX 9070 Series" alors que d'autres déclinaisons de cartes graphiques RDNA 4 devraient être lancées ? On parle de RX 9060, 9050 et 9040. On peut soit adopter une approche méfiante et la possibilité que AMD ne permette réellement pas l'utilisation de son FSR 4 sur les déclinaisons moins puissantes, soit juste se dire que c'est peut-être là le signe qu'AMD ne va lancer que les Radeon RX 9070 ce soir et a réalisé une présentation "au présent", avec les seules cartes à l'instant du lancement qui seront à même d'exploiter le FSR 4. Pour ce qui est des jeux, selon VideoCardz Call of Duty: Black Ops 6 serait officiellement confirmé comme compatible FSR 4. Une info qui n'en est pas vraiment une puisqu'on savait depuis longtemps qu'il serait dans les starting blocks pour l'arrivée du FSR 4. Il restera à voir s'il sera seul ou accompagné lors de l'officialisation qui devrait être faite ce soir !

Les jeux ps5 pro seront aussi fsr 4 eeeee pssr pardon 🤣

Autre option : c'est la fonction d'upgrade automatique du FSR 3.1 vers FSR 4 qui est réservée aux 9070 ?

Les autres cartes nécessiteraient le développement FSR4 à coder et prendrait plus de temps à être dispo ?

le FSR 4 est accéléré avec des unités matérielles, comme pour la FG de NVIDIA, il faut que les unités présentes puissent envoyer du bois, et c'ets parfois au détriment des générations antérieures.

Cela veut peut-être dire qu'AMD à adopter une approche comme NVidia avec un FSR plus lié au hardware pour avoir de meilleur perf. Le FSR logiciel marchant partout, y compris chez la concurrence, c'est cool, mais cela ne fait pas vendre de nouvelles cartes si les performances sont moins bonnes que le DLSS.

Je bénis néanmoins AMD pour m'avoir permis de continuer à jouer en 2K avec m'a 1070 jusqu'à maintenant grâce au FSR. Je vais pouvoir lui donner une retraite bien méritée cette année :)

Le grand publique ne croient plus depuis longtemps que les divisions gpu d'AMD et Intel sont à la hauteur de Nvidia et ce pas seulement au niveau du hardware et de tout ce qui attrait à l'IA mais quand de manière répété, le Caméléon à le jour de la sortie de chaque nouvelle génération, une dizaine de grands jeux compatibles au nouveau DLSS et autant de logiciels pros et quand six mois, le nombre de jeux compatibles DLSS2, DLSS3 etc... est X20 au FSR2/3

Au bout d'un moment, quand le publique voit aussi que chaque nouvelle génération des gpu d'Intel est un immense bide commerciale, on finit par arriver à une situation délirante ou au lieu de se réjouir qu'il y à une concurrence et que c'est bon pour nous, on se dit qu'ils sont tellement mauvais, qu'à ce compte-là, ça permet de se payer un Gpu Arc récent pour presque rien et d'avoir le dernier FSR sur sa RTX.

En même temps ils n'en sont qu'à leur 2ème 😅

Ca serait bien surtout d'avoir des CG qui tiennent la route en puissance pure au lieu d'utiliser des artifices pour tricher sur les FPS en réduisant la résolution lors des scènes de mouvement ...

Les mecs te mettent plein de technologies applicatives dans leurs cartes, ça gonfle le prix et ça prend des ressources au lieu d'innover dans la puissance brute. Ce qui baisserait clairement les prix ...

sauf qu'avec les moteurs actuels, si tu veux de la puissance brute comme tu dis, il faudrait un GPU 4x plus gros qui serait 4x plus cher, pomperait bcp plus, pour un produit final incompatible à la vente. C'est la raison pour laquelle AMD a pas réussi à faire un concurrent de la 5090/5080 avec ses chiplets. TSMC a augmenté ses prix donc la carte de tes rêves ne serait pas dans ton budget. L'IA apporte une réponse tout à fait crédible à une limitation technologique, et il faut te dire que les finesses de gravure évoluent plus lentement, et qu'il est compliqué de l'adapter à des puces de plusieurs milliards de transistors comme les GPU.

Le souci c'est que les jeux sont codés avec les pieds donc tu peux mettre la puissance que tu veux ça fera pareil. Le souci c'est pas le matos mais les studios de devs qui font l'impasse sur l'optimisation pour économiser !

La question à se poser, c'est est-ce que tu vois une différence négative à l'utilisation du DLSS ? Est-ce que tu vois une différence négative à l'utilisation du FG ?

Si on en voit pas, je ne vois pas pourquoi on se plaindrait de quoi que ce soit.

Oui à leur sortie ces technologies étaient perfectibles, elles ont bien changées depuis.

Moi j'attends de voir les tests! Et un décorticage by Riton!

Les cores matriciels de 2eme gen?

L'infinité cache de 3eme gen?

Le nombre de transistor?

La réorganisation des WP/SM, l'archi' donc?

Ya t'il un équivalent aux OFA's de NVIDIA pour le FG? Qui justifierait pas une gen mais une gamme, en l'occurrence QUE la série rx 9070?

Tant de questions demeurent... Mais ça ne saurait tarder .

Patience 😌.

" Allez la team, levé moi cet NDA, vous l'avez déjà dans les mains " 😜

Plus que les GPU, le problème provient pour moi surtout du codage des jeux qui ne sont plus tellement optimisés et consomment des ressources monstrueuses pour des gains ...

Je suis toujours outré de voir qu'un jeu occupe plusieurs dizaines de gigas, dépassant même la centaine pour plusieurs, tout en étant truffés de bugs à la sortie et "stables" finalement seulement plusieurs mois après et à nouveau après des gigas de rustines.

Si encore il fallait des années pour finir une campagne solo en y jouant tous les jours...mais nous en sommes très loin.

Et clairement, les modes multijoueurs ne justifient pas la place occupée, ni les textures ultras HD.

Le visuel ne fait pas tout, loin de là, et surtout à ce prix-là. Mettre de l'argent dans des moteurs 3D qui tendent vers le photoréalisme devrait passer après le plaisir de jouer, d'essayer de nouvelles mécaniques de jeu en solo ou à plusieurs, en VS ou en coop...

L'expérience vidéoludique ne se résume pas à l'image affichée ou au fait de posséder le dernier titre sorti, surtout s'il est injouable.

Mais bon, tant que les clients achètent, pourquoi la méthode de production changerait-elle ?

Je pense que pour juger qu'un développeur est mauvais ou qu'il sait pas optimiser, il faut être soi même compétent dans le même domaine ce qui n'est pas mon cas. Je pense aussi qu'on ne sait pas assez de choses internes pour savoir s'ils ont le temps de bosser sereinement. Des bugs il y en a toujours eu, et je sais pas quel âge tu as, mais à l'époque (je te parle de 1998/1999 a minima), il fallait attendre un mois et la sortie du magasine avec le CD qui incorporait les patches pour rendre un jeu lavé de ses bugs. Aujourd'hui, ils charbonnent plus, et tu as des moyens d'avoir les patches rapidement, sans compter la quantité astronomique de machines qui existent. C'est bien aussi de pas toujours jeter l'opprobre sur cette profession, car à terme, il y en aura plus et il y aura moins de création. Et je serai simplement tenté de te dire que si tu ne trouves plus ton compte dans cette discipline, il y en a plein d'autres. Je t'assure que tu idéalises le passé, et que les jeux d'avant étaient moins fouillés. Tous les jeux actuels ne sont pas des poubelles vides 🙂

Le premier défis d'un éditeur de jeu, c'est d'intéressé ceux qui peuvent financer son jeu alors qu'il existe des placements plus sur et ou le retour sur investissement est plus rapide. Le seul moyen, c'est d'appliquer un modèle de développement qui tend quand un jeu cartonne à des marges monstrueuses.

Dans cette idéologie, la même que dans moult industries, on cherche partout les économies et comment faire la même chose à moins chère. En dehors de garder et bien payer quelques producteurs starlettes qui apportent une certaine image à la marque, la pensée est qu'il est plus important d'avoir de grand nom de studio, que les équipes historiques qui ont fait de cette structure, ça renommer.

En résumer, au lieu de garder des équipes de talents et de continuer à bien les payer entre deux développement ou quand leurs jeux bides, on garde le minimum de personnes compétentes pour développer un jeu, on met ce qui faut de manager qui savent respecter un budget, une date et un cahier des charges.

Depuis la sortie fin 2013 des PS4/XboxOne, le cachier des charges d'un triple-A est de rendre captif les joueurs à coup d'incessants patchs. Comme le vendredi 13, il y à trente ans qui portait malheur, que la Française des jeux à transformer en journée de la chance, le marketing à fait du jeu qui sort trop bugué, le côté positif du bon développeur qui va assurer un long suivi à son jeux.

Outre qu'un jeu bogué à été transformé d'un naufrage à un jeu très ambitieux qui nécessite évidemment des rustines, c'est aussi le moyen de maintenir l'actualité sur le titre durant des mois à coups de l'arrivé du NewGame+ et autres options.

Concernant le développement lui même, si on n'est pas totalement parano, il est probable que les studios ne font pas exprès de sortir des jeux pas finis mais qu'on leur impose des deadline difficile à tenir quand certains membres importants d'équipes sont embauchés, virer ou déplacer au gré du vent dans l'idée qu'à ce salaire, ils vont juste bosser sur cette étape d'un jeu et partir sur un autre. En outre, entre les tests internes ou l'éditeur impose qu'à X stade du développement on lui présente ou fait tester par un publique test, des démos du jeu et devoir bricoler des trailers et autres démo pour la presse...

Pour avoir le temps de développer et tester des idées de gameplay et d'imaginer qu'un jeu entier tourne autours du concept, mieux vaut être un studio appartenant à Nintendo, Sony ou des gros studios autonomes adosser à une grande source de revenu comme Valve.

Eh bien nous n'aurons visiblement pas la réponse aujourd'hui, vu qu'AMD a fait une impasse totale sur la branche Radeon lors de keynote AMD.

Est-ce vraiment rassurant ? Ont-ils besoin de voir d'abord la main d'nVidia pour décider de leur propre placement de produits ?