Protocole et configuration

Afin d'avoir des mesures les plus précises possibles, et de pallier aux légères variations de fréquence de GPU modulées par GPU Boost 4 (l'enveloppe thermique et de consommation donc), nous avons fait 3 passes pour chaque jeu après avoir fait tourner le jeu "à vide" une minute pour que la carte se stabilise le plus vite possible à sa valeur réelle ingame, et réalisé la moyenne des trois. Ces relevés incorporent les moyennes, mais aussi le 1% Low, qui correspond au 1% des images les plus basses enregistrées le long de la séquence de test. Plus que la valeur "moyenne" des images mini, ce 1% Low retranscrit mieux les variations dans le framerate, avec les pics bas et donc les saccades que vous pourriez observer pendant votre partie, ces dernières étant justement les plus gênantes pour une expérience ludique agréable.

Pour départager les deux CPU, nous avons utilisé 16 jeux, ce qui ne signifie pas, dans ce cas, 16 moteurs différents. En effet, l'Unreal Engine 4, devenu incontournable, vampirise de plus en plus de jeux AAA, et la situation ne devrait pas être différente avec son successeur l'Unreal Engine 5. Ce dernier a accaparé des studios qui utilisaient encore un moteur 3D maison, comme CD Projekt Red (The Witcher et Cyberpunk) ou encore Eidos (Tomb Raider édité par Square Enix). Chaque titre est poussé au maximum des options, la RTX 4090 étant vendue comme une carte qui ne fait pas de concession, alors allons y gaiement ! Ce seront 12 titres avec RT qui seront affichés dans les graphiques, mêmes réglages évidemment.

Nous avons utilisé Frameview dans sa dernière version publique, la 1.4.8323.32104943, qui permet d'obtenir facilement des informations diverses dont les images par seconde et les 1% Low, ainsi que Windows 11 Pro 22H2 épaulé par 64 Go de mémoire pour éviter tout goulot d'étranglement, ce qui impacterait les résultats et modifierait le comportement de la carte graphique. Voici donc la machine qui a été utilisée :

| KESSKECÉ | JOLI PETIT NOM |

|---|---|

|

CPU |

Ryzen 5 7600X et Ryzen 9 7900X @ 5 GHz |

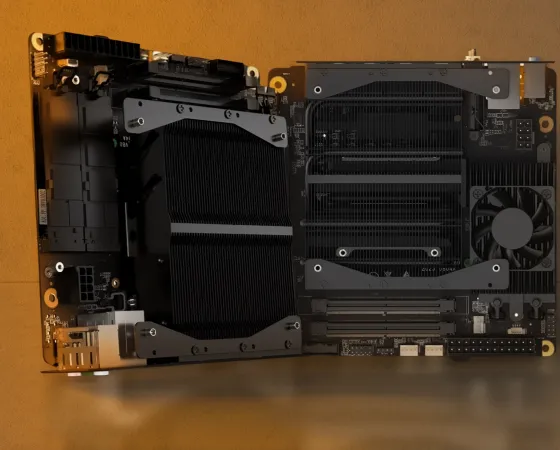

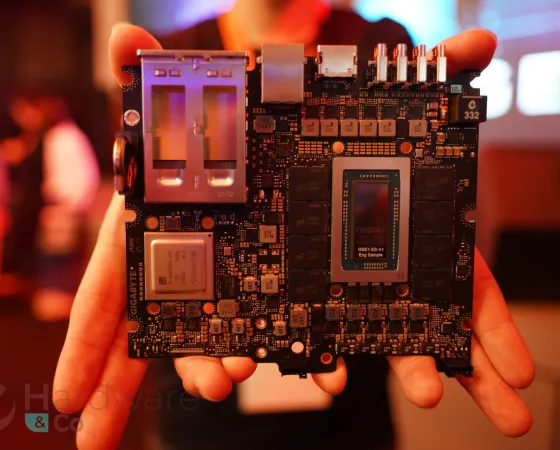

| CARTE MAMAN | GIGABYTE X670E AORUS Master |

| RAM | Corsair 2 x 16 Go DDR5 5200C38 Dominator RGB |

| GPU | PALIT RTX 4090 Gamerock OC |

| ALIMENTATION | Fractal Ion+ 860W 80PLUS Platinum |

| REFROIDISSEUR | be quiet! Pure Loop 2 FX |

| BOITIER | Fractal North Mesh |

Haa ravi de vous retrouver Môssieur ^^ il serait intéressant de voir ces résultats sur les deniers jeux qui ont posés de lourds soucis sur les cpu comme hogwarts legacy. Car si même dans cyberpunk le cpu n'est jamais à jenoux avec le rt activé ce n'est plus vraiment le cas pour des jeux comme hogwarts legacy ou midnight suns. J'ai pu lire que ces fameux jeux ne rencontraient pas les mêmes problèmes avec les dernières gen Intel mais je serais curieux de savoir si les dernières gen AMD aussi peuvent encaisser ces défauts sur les derniers jeux (si je dit pas de bêtises dues à l'UE4). Un grand merci pour cet article en tout cas 😍

"Môssieur" te va bien :D

Je m'attendais plutôt à un duel Core I9 13900KS vs R9 7950X3D vu que la RTX 4090 arrive à être CPU limited pour des références que l'on peut à peine qualifier de "vieilles", mais bon vu que le site vient de sortir, rien d'étonnant pour le premier.

J'imagine aussi que vous n'avez plus accès à l'ancien stock d'hardware.

Ceci dit, ça me rappelle un peu il y a 17 ans ces graphes en images, la nostalgie qui remonte. Mais vivement les graphes dynamiques bien sûr :jap:

Par contre, le Thread Starvation, ça existe. Peut-être pas aujourd'hui, mais on y est très bientôt. Un 6C/12T n'est clairement pas envisagaeable sur le moyen voire même court terme pour du gaming.

Mais heeeuuuuu patapé je cours déjà de partout et je n'ai que deux mains ^^' !

Hâte de voir le comparatif avec le 5800X3D.

tu vas le voir mercredi au plus tard :)