7600X ou 7900X, comment qu'on va faire ?

Premièrement, nous avons choisi deux CPU de la même génération, les Ryzen 5 7600X et Ryzen 9 7900X, afin de limiter le plus possible les variations qu'induiraient deux plateformes différentes, avec des optimisations qui le sont tout autant. Mais pour contrecarrer l'overclocking automatique qui est par définition variable selon la qualité des puces, nous avons bloqué les deux CPU à la même fréquence de 5 GHz. Par conséquent, nous pourrons dire que les différences de performances proviennent du nombre coeurs / threads, mais aussi de la mémoire cache L2 + L3, nettement à l'avantage du 7900X.

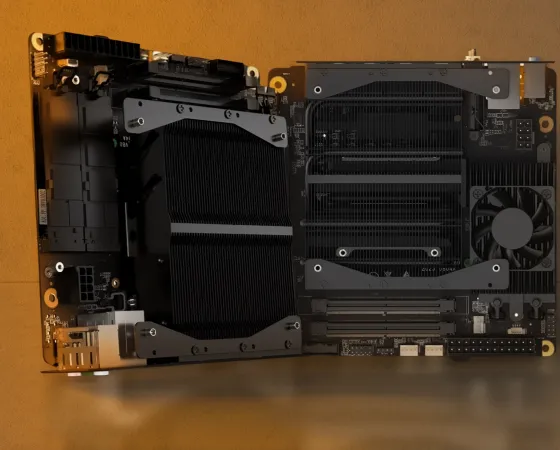

Car le reste de la plateforme est identique : même carte maman, même RAM et mêmes réglages/latences, même bloc d'alimentation, même refroidisseur, et enfin même châssis, tout pareil en somme sauf ce qui ne l'est pas, plus La Palice on meurt ! La partie graphique est assurée par une RTX 4090 signée Palit, modèle Gamerock OC.

Une RTX 4090, c'est une carte faite pour l'UHD, et a priori sans concession sur les options graphiques tant que l'on reste dans le domaine de la rastérisation, à savoir sans le moindre effet lié au ray tracing à quelques exception près. Pour comprendre la méthodologie, il est important de clarifier certains points. Le premier est simple : pour charger la carte en UHD, il faut que la carte calcule tout en UHD, ce qui exclut de facto tous les upscalings. Ces derniers diminuent la consommation et la charge des CUDA Cores puisque la scène de référence dont est issu le DNN Model, est calculé dans une définition inférieure à celle de l'écran avant une mise à l'échelle.

Malgré l'emploi de Tensor Cores, la charge diminue grandement sur les unités classiques . L'objectif du test est, justement, de montrer l'impact du CPU dans les perfs de la RTX 4090 en UHD, en conditions extrêmes, et il faut pour cela éviter de donner tout moyen de "tricher" au GPU, de lui alléger la charge, ce qui fausserait la réalité et ne respecterait pas l'objectif du test. Le second, nous avons également inclus une partie ray tracing, toujours sans DLSS, afin de charger encore plus le GPU que ne le ferait la rastérisation pour la gestion des effets tels que les ombres, les éclairages, les réflexions, l'occlusion ambiante. Vous l'aurez compris, c'est UHD et rien d'autre !

Haa ravi de vous retrouver Môssieur ^^ il serait intéressant de voir ces résultats sur les deniers jeux qui ont posés de lourds soucis sur les cpu comme hogwarts legacy. Car si même dans cyberpunk le cpu n'est jamais à jenoux avec le rt activé ce n'est plus vraiment le cas pour des jeux comme hogwarts legacy ou midnight suns. J'ai pu lire que ces fameux jeux ne rencontraient pas les mêmes problèmes avec les dernières gen Intel mais je serais curieux de savoir si les dernières gen AMD aussi peuvent encaisser ces défauts sur les derniers jeux (si je dit pas de bêtises dues à l'UE4). Un grand merci pour cet article en tout cas 😍

"Môssieur" te va bien :D

Je m'attendais plutôt à un duel Core I9 13900KS vs R9 7950X3D vu que la RTX 4090 arrive à être CPU limited pour des références que l'on peut à peine qualifier de "vieilles", mais bon vu que le site vient de sortir, rien d'étonnant pour le premier.

J'imagine aussi que vous n'avez plus accès à l'ancien stock d'hardware.

Ceci dit, ça me rappelle un peu il y a 17 ans ces graphes en images, la nostalgie qui remonte. Mais vivement les graphes dynamiques bien sûr :jap:

Par contre, le Thread Starvation, ça existe. Peut-être pas aujourd'hui, mais on y est très bientôt. Un 6C/12T n'est clairement pas envisagaeable sur le moyen voire même court terme pour du gaming.

Mais heeeuuuuu patapé je cours déjà de partout et je n'ai que deux mains ^^' !

Hâte de voir le comparatif avec le 5800X3D.

tu vas le voir mercredi au plus tard :)