Les rumeurs la décrivaient déjà de très près, avec sa VRAM en GDDR7 et son bus inchangé, hé bien voilà que le tonton Jensen, armé de sa verste en cuir intemporel (une aubaine pour nos confrères de Tom’s Hardware, qui avaient visiblement apporté un très bon objectif ce jour-là) l’officialise : Blackwell sera la prochaine architecture pour centre de calcul, succédant à Hopper dont l’annonce datait de septembre 2022. Et, puisque ce dernier n’a pas eu de déclinaison côté grand public, nous pouvons sans trop nous mouiller affirmer que ce sera également le cas de ce noir-bien (amis anglophones, nous vous saluons !) ; mais ce n’est pas pour autant que le bousin se voit dénudé d’intérêt, bien au contraire.

Crédit image : Tom’s Hardware

Depuis l’avènement de CUDA et l’explosion du machine learning comme moyen efficace d’effectuer des tâches auparavant restreintes aux humains ; NVIDIA n’a pas cessé de surfer sur la vague IA afin de spécialiser ces GPU dans le domaine. Cela a passé notamment par l’intégration de Tensor Cores matriciels — des unités dédiées à cet effet —, et un investissement massif dans la recherche et le développement de frameworks logiciels stables et optimisés. Les résultats financiers des verts en témoignent, la stratégie porte ses fruits, au prix d’une disponibilité limitée et, depuis quelques années, d’une concurrence latente du côté des architectures dédiées type Intel Gaudi ou Graphcore . Autant dire que Blackwell était attendu de pied ferme par bon nombre d’industriels désireux de se tailler une part de choix dans le gâteau conséquent de l’IA pour tous : voyons donc ce que cette nouvelle microarchitecture leur apporte.

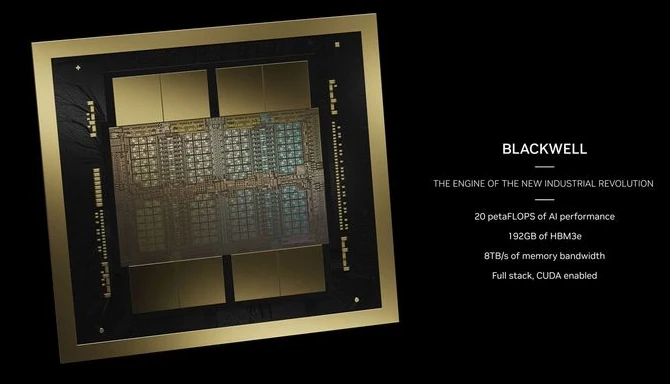

Tout d’abord, faute de gravure plus fine stable, c’est toujours un nœud de classe 5 nm qui se retrouve aux commandes, à savoir le 4NP de chez TSMC : un 4N (celui « personnalisé pour NVIDIA » de Ada et de Hopper, dont le curseur est poussé encore davantage sur la performance). Ce dernier permet de caser quelques 208 milliards de transistors sur 2 chiplets de taille inconnue, mais s’approchant dangereusement du maximum théorique de 858 mm2 ; de quoi offrir 20 PétaFLOPS dans des tâches d’IA et une interconnexion avec 192 Gio de HBM3e (8 stacks de 24 Gio à 1 Tio/s chacune) afin de repousser une fois de plus les limites de la bande passante mémoire. Or, qui dit chiplet dit interconnect, et même si le caméléon vend sa puce comme fonctionnant de manière monolithique, Blackwell n’échappe pas à la règle. C’est ainsi qu’une NVIDIA High Bandwidth Interface se voit intégrée, qui mouline à 10 Tio/s, pour lier les deux morceaux ! Enfin, la puce est bien entendu compatible avec la technologie multi-GPU de la firme, le NVLink, pour offrir 1,8 Tio/s de bande passante bidirectionnelle par GPU, pour une limite de… 576 unités ! De quoi faire rêver les nostalgiques du SLI, la chose ayant complètement disparue des configurations modernes. Au niveau du TDP, un B200 consommera seul jusqu’à 1000 W dans sa configuration HGX B200, c’est-à-dire coupé par 8 avec un CPU x86, cas dans lequel la puissance tombera à 18 PFLOPS en FP4 ! Si besoin, une version B100 moins testiboulée est également au programme, avec « seulement » 700 W de TDP et 14 TFLOPS de FP4 : si les caractéristiques exactes ne sont pas connues, cela semble être peu ou prou la même puce, mais aux fréquences amoindries.

Or, sans changement de nœud de gravure, comment NVIDIA peut-il augmenter autant sa puissance, pour passer de 4 PFLOPS sur Hopper à 20 PFLOPS sur Blackwell ? Hé bien, la chose est simple : il ne s’agit tout bonnement pas de la même chose ! Ceux de la génération précédente sont en FP32, là où NVIDIA innove et rajoute du… FP4, une représentation des données à 4 bit par nombre ; permettant toujours plus de parallélisme par rapport à FP8 ou au FP16 préexistant. Rajouter que NVIDIA compte sa sparsité (capacité à ignorer des opérations dont la valeur serait dans tous les cas nulle) comme des calculs effectués, et vous verrez que les performances réeles, même sur une simple multiplication dense, ne seront pas tout à fait du même ordre de grandeur ! Cependant, Blackwell propose tout de même un facteur 2,5 par rapport à Hopper en ce qui concerne les performances à isoformat ; de quoi rassurer quant au bien-fondé de la nouvelle génération.

Tout comme Hopper, Blackwell sera également disponible en « Superchip » Grace-Blackwell : 2 puces Blackwell, une puce Grace, et un TDP configurable jusque 2700 W et les 20 TFLOPS promis de FP4. De quoi abandonner la complémentarité des patronymes, mais pas celle hardware ! De quoi composer jusque 36 CPU Grace (de l’Arm massivement multicœur, pour rappel) avec la bagatelle de 72 GPUs Blackwell, le tout disponible dans un seul rack nommé GB200 NVL72 et refroidit à eau. Rajoutez un peu des dernières plateformes NVIDIA Quantum-X800 InfiniBand et NVIDIA Spectrum-X800 Ethernet fournissant du réseau à 800 Gbit/s (de quoi ridiculiser l’Ethernet 5 G voire 10 G grand public !), et voilà une belle impression de la chose. Avec une telle cargaison, nul doute que les stocks initialement manufacturés fondent à vu d’œil… Au total, le rack offre 1,4 exaFLOPS de performance pour l’IA ; sans compter sa possible multiplication au sein de DGX SuperPOD : quand NVIDIA fait du produit pour les entreprises, ce n’est pas à moitié !

Reste que cela nous fait une belle jambe pour nous, grand public, puisque ces technologies nous seront complètement hors de prix. Pour autant, entre un ChatGPT se démocratisant, de l’IA générative toujours plus attrayante et des systèmes d’abonnement au cloud au vent en poupe, nous risquons bien de faire bien plus usage de ces puces que ce que nous pourrions penser au premier abord. Enfin, la question se pose également de la filiation possible entre ce Blackwell sauce data center et son homologue pour PC du bureau ; mais, pour le moment, les fuites demeurent muettes à ce sujet… pourvu que cela arrive rapidement !

EDIT: je devais la placer 🤣

😂

Collé 2 die à côté amd fait ça depuis fin 2021 avec la mi 250x

L'annonce est bizarre on manque de plein d'informations qu'on a normalement comme le nombre d'unité et la puissance de calcul en non tensor

J'aurais aimé que nvidia passe à 12 puce de hbm la quantité de vram limite l ia

Tsmc sait faire des interposé plus grand et donc compatible

Le die lui fait lui 800 mm² appriorie on peut aller jusqu'à 854 mm² et les contrôleurs ram peut être plus petit en gérant une fréquence moins haute vu qu'on passe à 12 pas besoin d'être aussi rapide

Alors oui ça coûte plus cher à la production mais bon on est pas sur des carte vendue en entrée de gamme et si ça permet des gains de perf les client sont prêt à payer

Bon sur le papier la grosse innovation c'est le passage à 192Go de hbm, on sent que l'arrivée des mi300x avec la même quantité de mémoire et des perfs comparables voir supérieures au h100 ont fait bouger NVIDIA.

Hâte de voir des bench de la bête

J'aurais plutôt traduit en "puit noir". 🤓