Fin avril, Intel Foundry tenait son Direct Connect 2025. Un évènement auquel notre Nicolas avait d'ailleurs assisté. Il présentait d'ailleurs déjà le sujet que nous allons aborder dans notre actualité du jour : le souhait d'Intel d'inclure un waterblock directement dans l'IHS de ses processeurs. Afin de tenter de nous adresser au plus grand nombre, désolés du coup pour les passionnés qui savent déjà très bien tout cela, rappelons que les processeurs actuels possèdent à leur surface une petite plaque (généralement en cuivre) baptisée IHS (Integrated Heat Spreader) qui sert à protéger les puces très fragiles du processeur, tout en pénalisant le moins possible les échanges thermiques avec le refroidisseurs que l'utilisateur vient ensuite installer par dessus. Cette interface supplémentaire dans l'échange thermique induit cependant tout de même une légère baisse de performances inévitable, au point que certains utilisateurs avancés vont parfois retirer l'IHS pour grappiller quelques degrés supplémentaires : le fameux "delid".

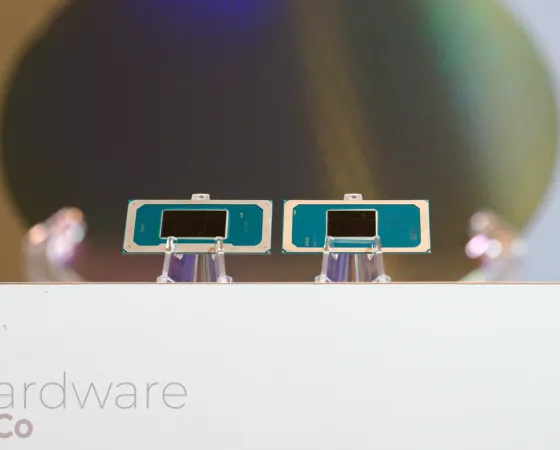

Du côté d'Intel Foundry, et alors que la consommation des CPU et leur température est un frein notable à l'évolution de leurs performances et caractéristiques, on travaille donc activement à mettre au point des waterblocks qui prennent directement la place de l'IHS à la surface du processeur. Dans l'article de Nicolas en lien un peu plus haut, nous pouvons voir sur le premier cliché à quoi cela pourrait ressembler :

Vous voyez le nom de la personne qui tient ce prototype pendant que Nicolas le prend en photo ? Rajiv Mongia ? Eh bien nous retrouvons en cette mi-aout ce haut responsable de l'architecture thermique chez Intel Foundry, qui nous reparle de cette "Advanced Thermal Interface" dans une courte vidéo mise en ligne sur la chaine YouTube officielle d'Intel :

L'occasion de découvrir que le sujet n'est pas du tout abandonné et même qu'Intel semble vraiment parier donc dessus pour l'avenir. Mongia commence par expliquer les différents niveaux où son travail d'ingénieur en architecture thermique intervient, avant de présenter un IHS (ou lid) classique et donc d'expliquer qu'Intel Foundry "ne s'arrête pas là et travaille à intégrer la circulation du liquide directement à l'intérieur de l'IHS.". Il montre ensuite, mais la caméra a du mal à faire le focus, l'intérieur d'un prototype. Comme il le confirme, mais Nicolas vous en parlait déjà il y a 3 mois, l'idée est de pouvoir proposer un produit complet aux clients avec la puce et son waterblock intégré directement, dans un packaging prêt à l'emploi où il ne reste plus qu'à brancher les tubes de son watercooling.

Mongia conclut sa vidéo en estimant que ce type de solution avancée de refroidissement devient importante en ces temps où les demandes de performances liées à l'IA sont de plus en plus importantes, afin que les CPU puissent suivre au mieux la cadence des surpuissants GPU afin "d'en extraire le maximum de performance"'. On sent l'appel du pied pour convaincre des partenaires de suive Intel Foundry dans son projet, le mot magique "IA" étant lâché.

Je vois bien l'utiliser de se type de refroidissement

Mais i cest pour se retrouver avec des puces a 2000 watts et des rak au niveau du millions de watts et le serveur complet au niveau du giga 😒

Je trouve pas très utile cette énergie pourrait etre plus utile ailleurs

OK l ia c'est utile / important mais j'ai l'impression qu'on essaye de tuer une moche avec une bombe nucléaire un peu de mesure et d'efficacité énergétique

La mochophobie n'a pas de limite 😉

IA! IA! IA!

Les vendeurs de cartes graphiques vendent bien des modèles équipés en série d’un waterblock donc why not. Principal intérêt c’est que ça n’annule pas la garantie (sauf à prendre un 9800x3d delidded par thermal grizzly qui en assure la garantie).

Maintenant dans le domaine pro, je serai étonné qu’ils ne vendent pas déjà des processeur sans capsule à ceux qui le veulent. Apple avait bien dans ses Mac Pro des xeon sans capsule.

Par ailleurs dans les machines pro, tout est custom et optimisé au mm. Chaque fabricant y va de son design.

non la ça va plus loin si j'ai bien copris directement dans l'ihs pas en watercooling tu as déjà des watercooling cpu

C'est ce que je dis. Ce n'est qu'un processeur sans sa capsule (ihs) sur lequel ils installent un waterblock.

Et bien évidemment que ça se fait déjà, au détriment de la garantie.

Mais je ne vois pas l'intérêt du truc :

Les fabricants doivent déjà disposer auprès d'Intel de CPU sans IHS. Apple en avait sur ses mac pro et j'avais d'ailleurs décapsulé des xeons pour les upgrader.

Leurs serveurs cherchent à être le plus compact possible. Cela signifie que tout est spécifique. L'écartement des tubes, leur position, etc... Intel va proposer des modèles pour chaque fabricant ?

Ca n'a aucun intérêt pour le commun des mortels, ça manque au minimum de leds et d'un écran :)

Rajiv 😀 , je le connais personnellement (mari de ma cousine), super !

Je vais lui mettre un petit mot avec le lien vers ici.

Merci beaucoup ! Si jamais il a des informations précises sur ce qu'Intel compte faire de cette technologie (grand public ? datacenter ?) et des partenaires intéressés, on est bien entendus preneurs :D

Why not vu les fours que sont les CPU modernes ! Un ultra 9 ou Xeon frais ça se refuse pas

Vu comment chauffe les modèles récent pour continuer à faire grimper la puissance de ces petits pépite va falloir trouver autre chose que le watercooling classique qui commence légèrement à montrer ses limites notamment sur les x3d. Bientôt l'azotecooling avec des cartouches à changer régulièrement

Non, car là c'est directement dans l'IHS ce qui est énormément plus efficace qu'un watercooling conventionnel...

Sont fort en R&D chez Intel : ils viennent de découvrir que la flotte est moins chère que l'indium... 😅

Ça ne fait que prouver ce que je dis depuis longtemps, la plus grosse parade pour gagner des perf gen après gen c'est la course au "centaines" de MHz

Ça n' arrive plus à améliorer la prédiction du sheduler et etc... On est à un plafond

Le x86-64 avait un peu debarassé qqs merde historique du x86 32bits

Mais voilà arrive un moment tu peux plus vraiment optimiser le jeu d instruction

Y a pas 36façon de faire une addition, 36façon de faire une multiplication

Les gains sont à chercher coté amélioration du code des logiciels, ce que très peu d éditeur font (d ou le passage au format abonnement pour tenir le client par les C d un produit qui ne s améliore plus, pire régresse)

Ou faut revoir totalement la plateforme, donc re mettre à plat le standard battu autour du ATX avec les banque de mémoire DDR

Y a la RRAM/ReRAM dans les tuyau mais quand ça préfère faire des saut de puce bien market économie de chandelle en t annonçant que t inquiète y a la ddr6 et ddr7

Et là encore ddr6 ddr7 c est quoi foncièrement... De l overclocking

Y en a qui croit que la guerre des GHz c est un jour arreté lol, c'est l eldorafa des nouveaux faux produit pour maintenir les prix élevé sur le marché des cpu

Et un grand pas serait d'avoir un système de d exploitation qui arrive à fonctionner qqpart sans "cpu" en terme classique ou on l' entend

L' initiative ne viendra jamais de Intel qui est avant tout un vendeur de cpu

L' initiative peu venir de ARM car ils vendent du "concept" de circuit cpu/gpu/ etc..

Problème un après "ATX" en ce moment c este tre les main de NVIDIA avec leur futur machine en partenariat avec mediatek

Là où qqpart Microsoft/Qualcomm pendant la phase d exclusivité de Qualcomm sur windows arm aurait dû en profiter pour pondre un après atx

Surtout qu en parallèle ils veulent sous traiter leur futur console à un Asus acteur majeur sur la production de mobo

Coté AMD ne ça bouge pas non plus alors qu il serait eux aussi capable de proposer un après ATX, mais vu ce qui se dessine sur l "AM6" c'est mort... D ailleurs le desktop devient déplus en plus un marché de niche pour AMD qui sort toute ses nouveauté cpu en avance sur notebook (ça sera le cas pour Médusa, zen5 ciblait avant tout les serveurs avec l avx512 d ou son drop assé rapide sur desktop)

Oh que si, au niveau hardware c'est plus facile à dire qu'à faire 😉 (mais intéressant quand-même), et je ne parle pas des divisions, racines ou fonctions trigonométriques...

Ceci dit, en pratique c'est probable que tous les CPU "haute performance" aient convergé vers les mêmes techniques.

Mais j'imagine qu'il doit tout de même y avoir pas mal de paramètres réglables en fonction du cahier des charges (fréquence cible, budget de transistors, latence des (micro-)instructions, consommation, etc).

Si on remonte au niveau de l'architecture du CPU, comme vous le dites, on est à un plafond, et j'aurai plutôt tendance à être d'accord dans le sens où ces machines sont extrêmement optimisées pour les situations pour lesquelles elles ont été conçues. Mais peut-être qu'à l'avenir, les charges de travail vont évoluer, et donc les CPU aussi (plus/moins d'ALU entier/flottant, plus/moins rapides/efficaces, etc.), tout ceci est une question de compromis.

Et les architectes CPU ne sont probablement pas entrain de se tourner les pouces, il n'y a qu'à voir Intel qui pensait pouvoir compenser l'Hyper Threading par d'autres moyens architecturaux. Comme il semblent vouloir revenir en arrière, c'est que ça n'a pas dû marcher aussi bien que prévu, mais peut-être qu'une autre idée du style pourrait émerger à l'avenir.

Pas vraiment, les usages évoluent (machine learning récemment, par exemple) et il y a encore des gains en matière de procédés de gravures qui donnent des transistors supplémentaires, pour lesquels il faut trouver la meilleure utilisation :). Par contre, c'est effectivement des gains moins important que de passer de 600 MHz à 1,2 GHz comme on a pu le voir il y a des années....