Ça n’est pas souvent qu’Intel et AMD se serrent les coudes pour développer ensemble quelque chose. Parmi ces OVNIs se trouvent les Intel iX-blablaG utilisant une partie graphique AMD Vega, mais pour le grand public, c’est à peu près tout. Et cela se comprend : s’acoquiner avec la concurrence, ça n’est pas souvent vu d’un bon œil. Or, côté serveur, la chose est en train de se reproduire côté interconnect : NVIDIA a frappé un grand coup avec son NVLink, une solution permettant d’interconnecter des cartes graphiques en utilisant une implémentation propriétaire offrant tout ce dont l’industrie requiert : basse latence et haut débit. À côté, l’Omni-Path Interconnect d’Intel n’a pas été couronné d’un grand succès (de loin..) et l’InfiniBand est actuellement sous influence depuis le rachat de Mellanox (dernier constructeur indépendant de matériel InfiniBand) par NVIDIA en 2019. Bref : ça ne va pas glop pour l’interconnect sur serveur !

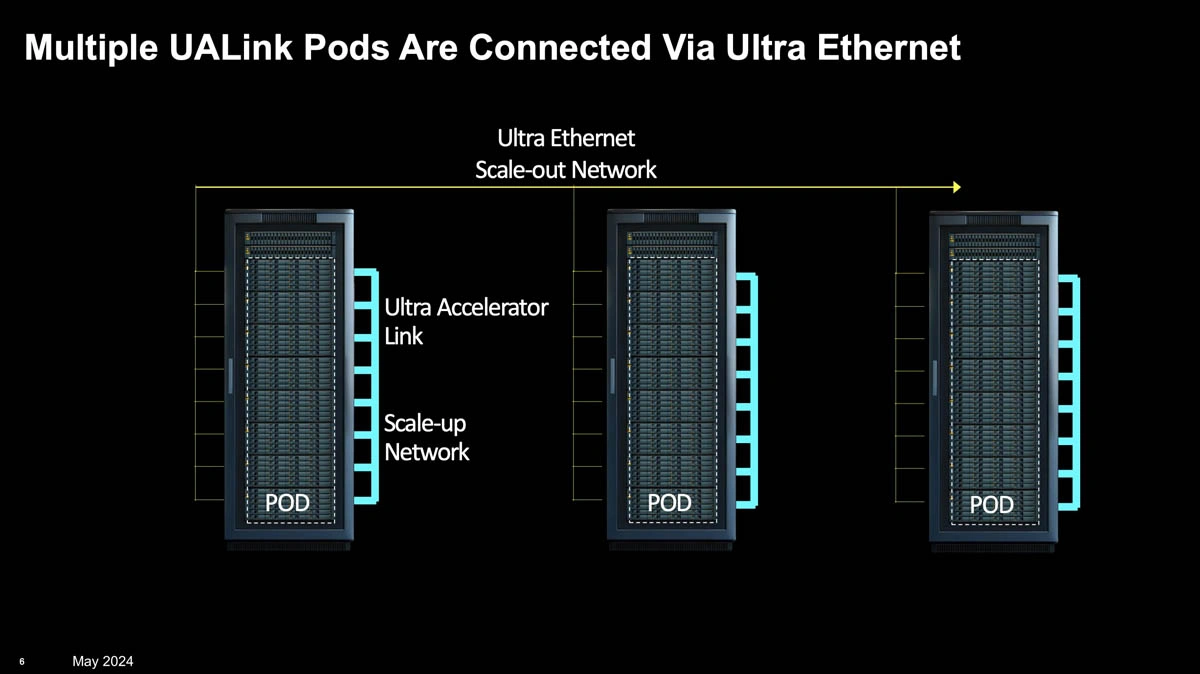

Au besoin, le standard sera complémenté par l’Ultra Ethernet pour relier différents clusters ensemble.

Si « pas glop », en fait, qu’Intel, AMD, Microsoft, Cisco, Broadcom, Google, HPE et Meta se sont joints dans un groupe chargé de concevoir un nouveau standard ouvert pour relier des accélérateurs ensemble : l’Ultra Accelerator Link (UALink). Scalable jusqu’à 1024 accélérateurs d’IA (qui peuvent être des CPU comme des FPGA), le bousin est censé sortir au troisième trimestre 2024 dans sa version 1.0, sachant qu’une mise à jour apportera une augmentation de la bande passante pour Q4 : quel programme ! Dans la pratique, cet interconnect devrait permettre de piocher dans la mémoire des cartes reliées sans encombre en supportant les chargements et rangements (y compris de manière atomique), le tout via une couche physique se basant sur la sémantique de la mémoire — un principe qui sonne bien mais qui ne nous apprend pas beaucoup !

Avec tout ce beau monde, NVIDIA peut se faire quelques cheveux blancs, mais d’ici à ce que l’écosystème prenne, de l’eau peut encore couler sous les ponts : autant dire qu’il va encore falloir raquer pour les entreprises désireuses de se monter un cluster de calcul !

Pas d'annonce de performance visé dommage

"Ultra" rapide, voyons ! À la louche, je dirais au moins plus que l'InfiniBand 😏

Tiens donc, pourquoi ne pas l'avoir baptisé IALink? Ils ne sont pas au courant de la hype? Ça ne prendra jamais.

C'est pour le mainstream l'IA à toutes les sauces. J'ai l'impression que les pros se prennent quand même un petit peu plus aux sérieux entre eux 😄