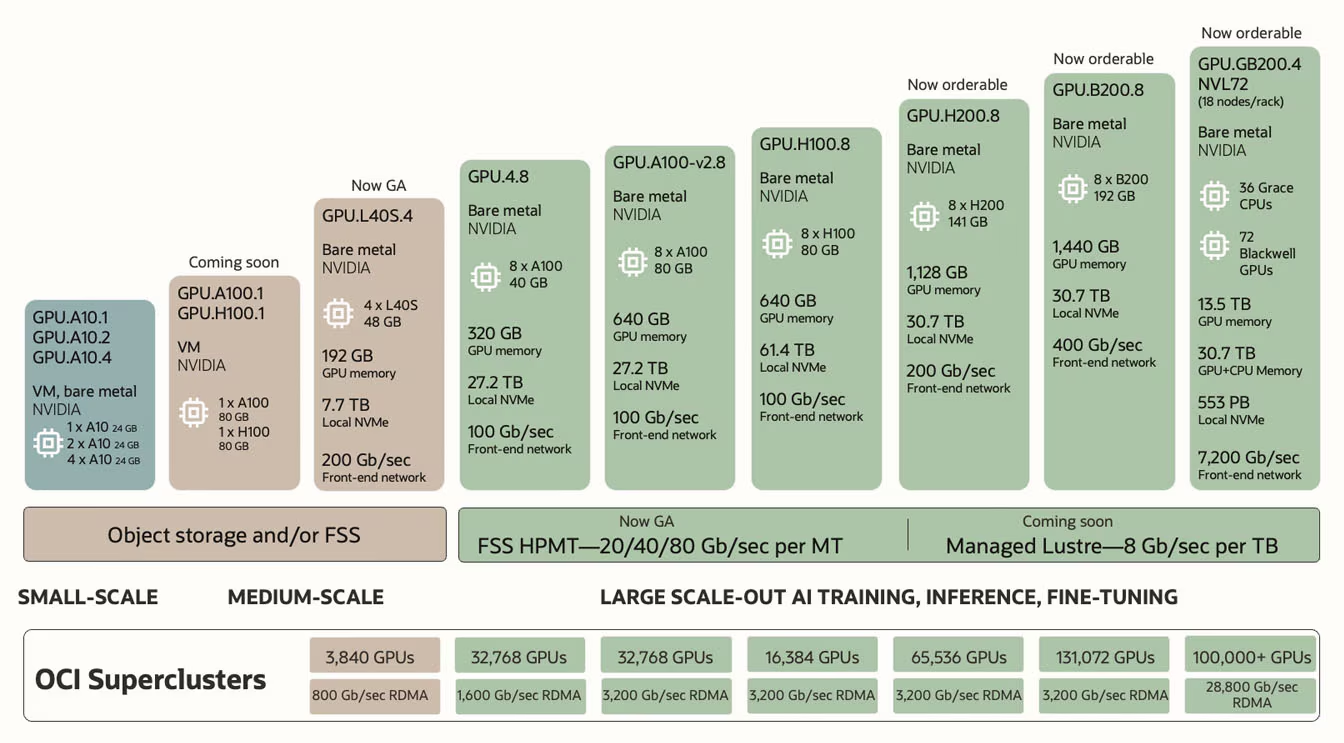

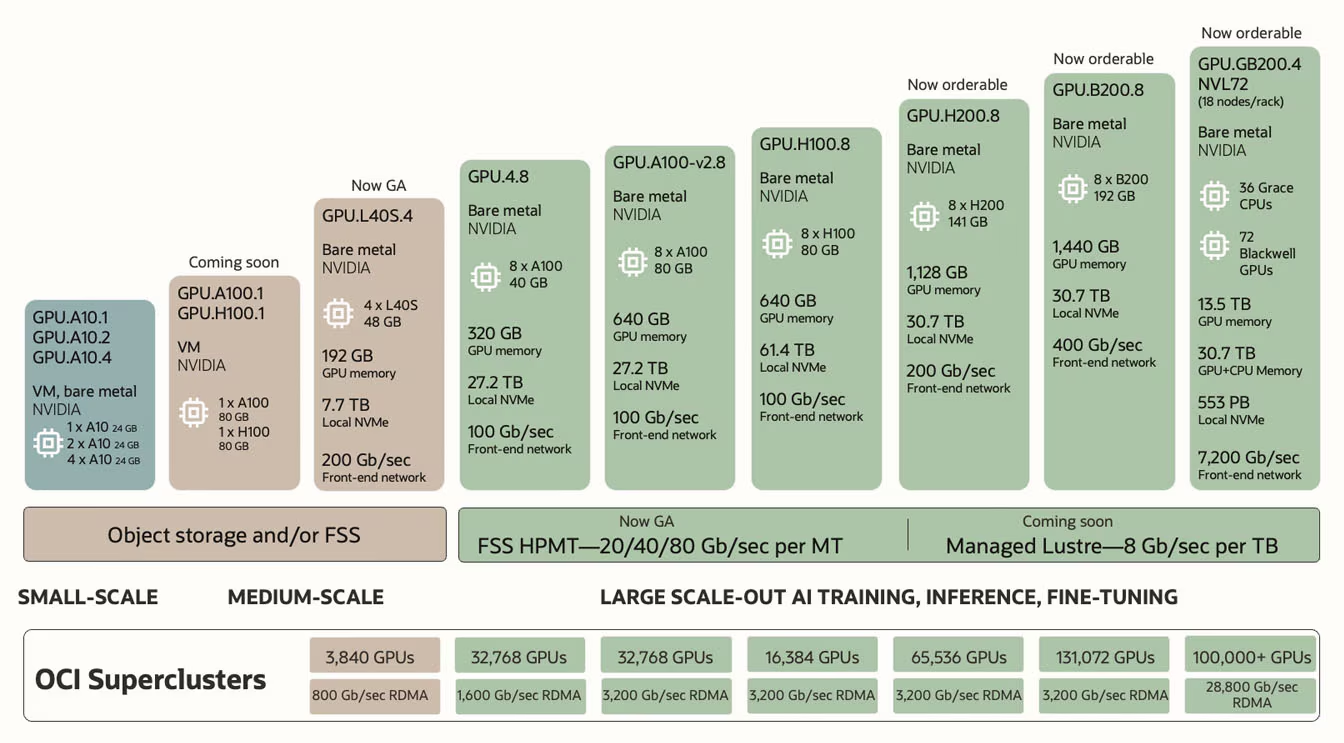

Hier, Oracle a dévoilé un nouveau type de supercluster de superordinateurs qui sera disponible prochainement pour entrainer de l’IA via sa Oracle Cloud Infrastructure (OCI). Les performances dépasseraient celles de tous les superordinateurs actuels, y compris ceux annoncés récemment par Elon pour son xAI Colossus. Ainsi, une grappe OCI d’Oracle pourra prochainement être configurée également avec des puces Blackwell de NVIDIA. À ce jour, l’opérateur utilise des GPU H100 et H200, ainsi que des solutions réseau comme RoCEv2 avec NIC ConnectX-7 ou SuperNIC ConnectX-8, ou encore celles basées sur l’InfiniBand Quantum-2 de NVIDIA. Un peu plus en détail, le futur catalogue d’Oracle ressemblera à ça :

- Superclusters OCI avec jusqu’à 16 384 GPU H100 pour 65 exaFLOPs maximum en pointe.

- Superclusters OCI avec jusqu’à 65 536 GPU H200, pour 260 exaFLOPs maximum en pointe.

- Superclusters OCI avec plus de 100 000 GPU B200 ou GB200 pour 2,4 zettaFLOPs maximum en pointe !

Voilà, Oracle se vante donc d’avoir le premier superordinateur à capacité "zettaflopique" ! Bon, il faut dire que la supergrappe à base de B200 embarquera tout de même trois fois plus de GPU que Frontier, par exemple, et ses 37 888 Instinct MI250X, et encore beaucoup plus par rapport à d’autres superordinateurs du Top500. Sous réserve d'une autre annonce d'un concurrent, Oracle est pour l'instant aussi le fournisseur cloud à intégrer le plus de GPU Blackwell. Par exemple, l'UltraCluster de chez AWS n'exploitera que 20 736 GB200 et aucune solution équivalente n'a encore mis en avant chez Azure ou Google.

Cependant, il est impératif de préciser qu’Oracle a "mesuré" ces performances en FP4 (4 bits en virgule flottante), un format de très faible précision pas encore très utilisé, mais qui commence à devenir tendance, notamment dans le domaine de l’intelligence artificielle et du deep learning. Le FP4 n’est généralement pas exploité pour des calculs complexes nécessitant de grande précision, mais des calculs à effectuer extrêmement rapidement. Or, ce n’est pas du tout le standard utilisé pour mesurer les performances de superordinateurs et les comparer les uns aux autres. Par exemple, le classement du Top500 utilise le benchmark LINPACK, lequel mesure les performances en FP64. Enfin, la majorité des modèles sont aujourd’hui encore entrainés au FP16. Et à ce jeu-là, le supercluster OCI avec B200 n’afficherait "que" 459 exaFLOPs en FP16 et "seulement" 5,2 - 5,9 exaFLOPs en FP64. C’est toujours bien loin devant les prestations en pointe de Frontier, mais pour le marketing, c’est quand même moins attrayant que de vanter du zettaFLOPs.... Notez enfin que ces performances seront aussi dépendantes de la capacité d’Oracle à faire fonctionner tous ces GPU B200 ou GB200 ensemble, ce qui ne sera pas une mince affaire, car à cette échelle, les interconnexions vont chauffer très dur.

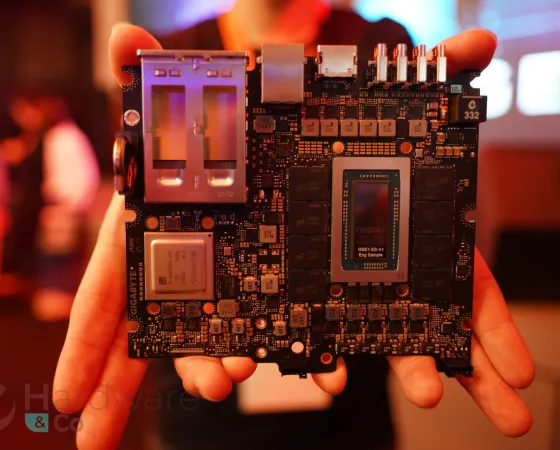

Oracle annonce que les commandes sont déjà ouvertes pour son supercluster à base de GPU Blackwell. La version la plus puissante utilisera les nouvelles baies NVL72 GB200 de NVIDIA, des cabines refroidies à l’eau contenant chacune 72 GPU communiquant entre eux via NVLink de 5ᵉ génération à une vitesse de 129,6 To/s. Cependant, la disponibilité reste floue. Oracle a seulement déclaré que les GPU Blackwell de NVIDIA seront disponibles au cours de la première moitié de 2025. (Source : Oracle, The Register, Tom's)

J'ai plein de questions

La principale est ce que c'est utile un super calculateur aussi gros ? Je parle en terme d'efficacité les interconnexion entre tous ces serveurs ne vont ils pas poser problème à une telle échelle ?

5.9 exaflops c'est plus de 3 fois frontier le numéro 1 du top 500 frontier consomme déjà 22.5 méga watts

Je crois que le gh200 nvl72 cest 120 kw sans parler des interconnexion donc on va être sur plus de 200 méga watts l'efficacité est pas ouf

Ellison a parlé de datacenter de 1 gigawatts à l’avenir dans la réunion sur les résultats du trimestre.

Tout cela pourrait être alimenté par une partie des mini réacteur nucléaire qui doivent être construit

Il me semble que hors EPR, Macron a dégainé un projet identique pour notre industrie nucléaire.

Tout ça pour que M michu demande à une ia de lui générer une femme aux gros sein 😒😅

On pourrait mieux exploiter tout ça

Disons que c'est "un peu" du bruteforce pour le résultat réel : beaucoup d'entreprises investissent dans le deep learning, alors qu'on a même pas fini de l'optimiser que ce soit en software (beaucoup de points à revoir) et en hardware (les GPU sont loin d'être réellement bons).

Le souci principal c'est pourquoi aller dans telles proportions, pour quelle utilisation ? Quand on voit par exemple le retard de certains modèles/outils vis-à-vis de l'état de l'art scientifique, ou la réutilisation de modèles parfois pas adaptés par manque d'ingénierie, est-ce que la priorité ne serait pas de figer un peu les besoin plutôt que de pondre ce genre de choses ?

Il faudrait voir aussi les cas d'utilisation : si ce n'est juste que pour faire encore plus de LLM dans le vent ou des "IA génératrices", alors c'est un gâchis complet. Le pire c'est que ça va encore créer une mauvaise image du domaine, qui mérite bien mieux quant à ses bénéfices réels : progrès en médecine, génétiques, explorations des possibilités en physiques, véhicules autonomes...

En plus Blackwell je trouve est mal conçu

L'architecture est bonne et puissante mais mal exploité

Je trouve qu amd a montré la voix avec le mi300a

C'est un calcul fait en "gros" mais le nvl72 on est sur 120kw sout 1.7 kw par gpu