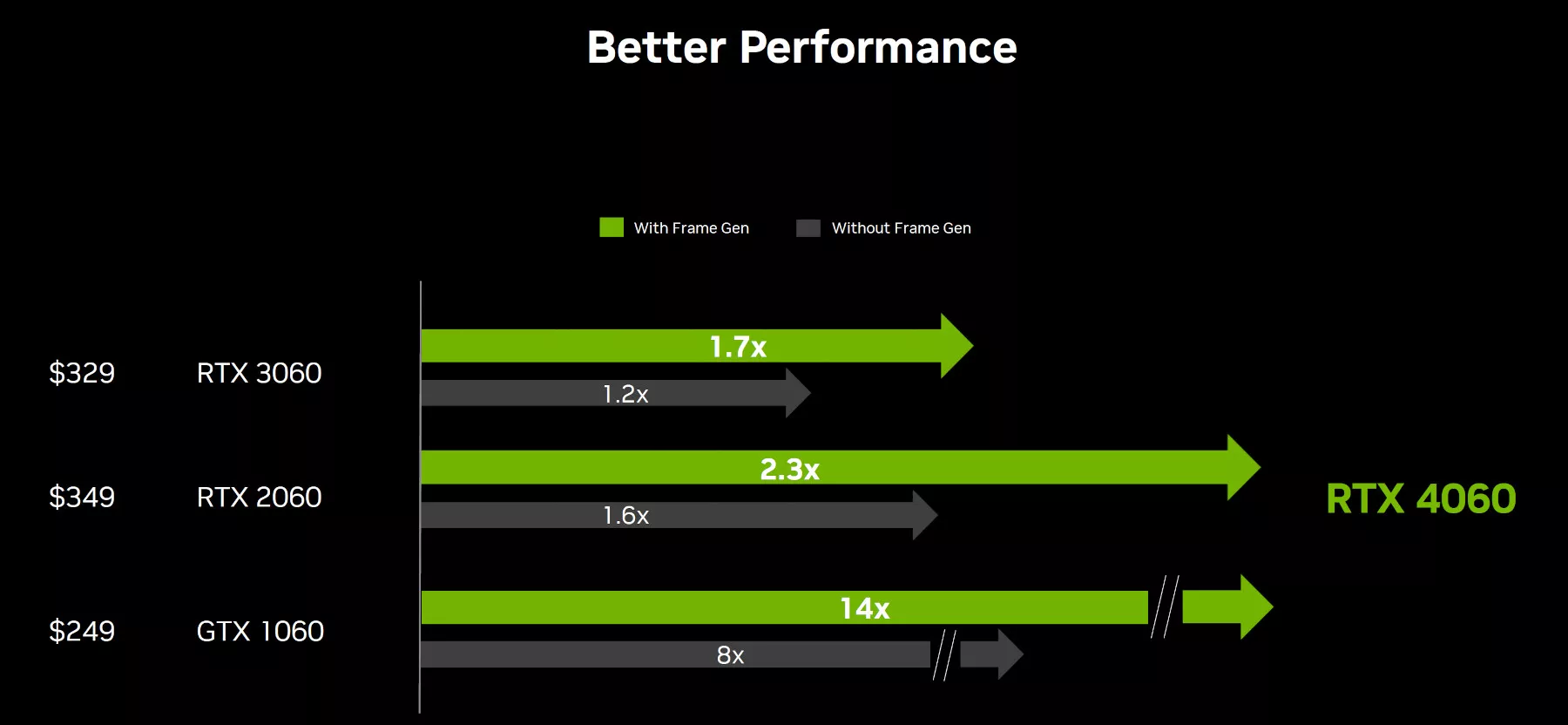

A l'arrivée d'une nouvelle carte graphique, tous les arguments sont bons pour tenter de la mettre en avant. Avec sa GeForce RTX 4060, NVIDIA ne peut pas compter sur la quantité de VRAM embarquée, ni vraiment sur les performances pures de la carte alors un levier évident est bien entendu celui des performances en activant le DLSS 3 propres aux cartes GeForce RTX 40. NVIDIA ne s'en prive pas et annonce ainsi que si la RTX 4060 ne serait en performances brutes que 20 % devant la sa devancière la GeForce RTX 3060, l'écart monterait à 70 % une fois le DLSS 3 activé, grâce au Frame Generation .

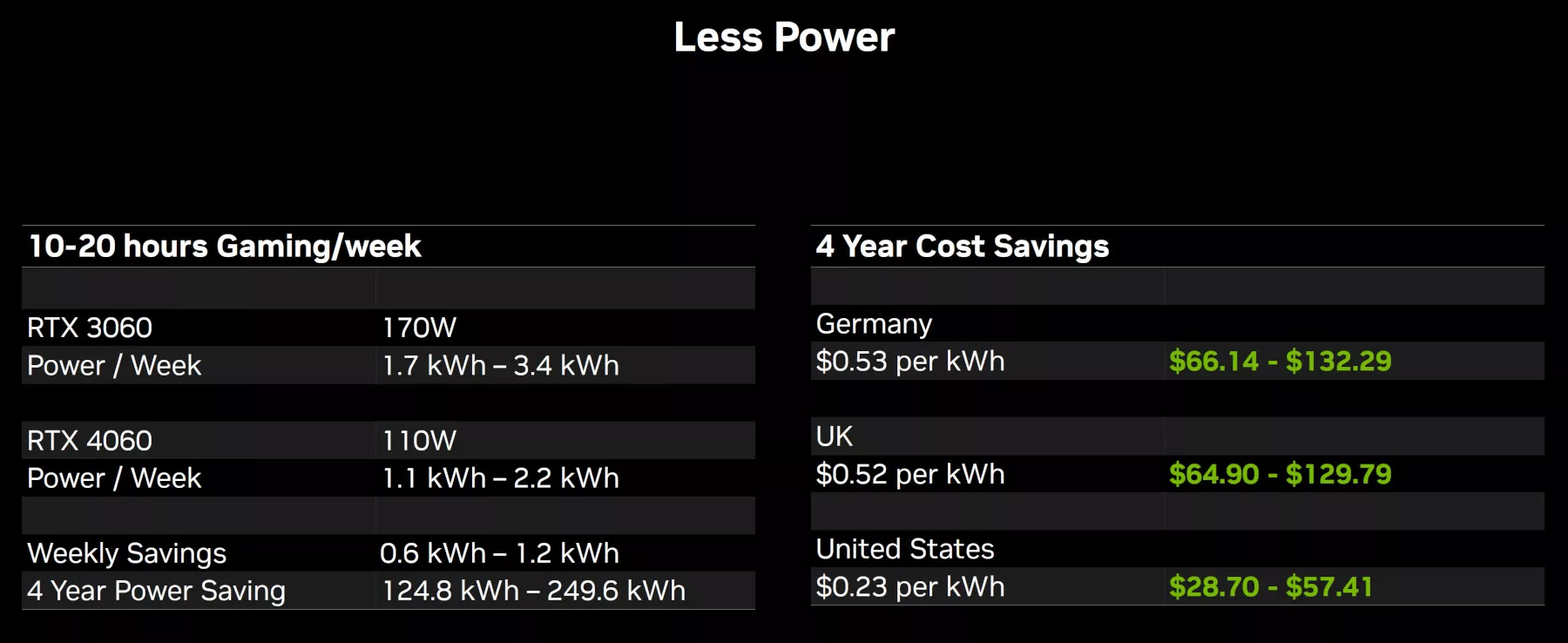

Voilà déjà un argument de trouvé, une bonne chose de faite. Seulement, un deuxième serait intéressant, non ? Alors il était temps pour les verts de sortir une seconde carte de leur poche : la consommation électrique. On le sait, la RTX 4060 a un TGP de seulement 115 W ce qui est un avantage indéniable, mais pas toujours privilégié par les joueurs qui ont principalement les performances en tête (surtout quand ce sont les parents qui paient la facture d'électricité). NVIDIA tente de faire prendre conscience de l'économie qui peut être réalisée avec une carte moins énergivore avec une autre diapositive, qui compare toujours la petite nouvelle à la RTX 3060, offrant de son côté un TGP de 170 W.

Et là il y a plusieurs choses à analyser. Tout d'abord on constate que si le TGP de la RTX 3060 a bien été utilisé, la RTX 4060 est affublée de son côté d'un 110 W au lieu de 115 W. NVIDIA nous ferait-il passer le message que ce sont les consommations réelles en jeux qui sont ici représentée et que la RTX 4060 serait finalement plutôt à 110 W ? Possible, admettons que ce soit le cas en attendant la confirmation par les tests. Pour la RTX 3060 rien de choquant, les tests réalisés par Eric dans ses dossiers de cartes graphiques montrent qu'elle consomme effectivement en moyenne 170 W en jeu.

Les indices de consommations énergétiques par semaine sont pris pour deux temps de jeux différents, 10 h par semaine tout d'abord puis 20 h par semaine ensuite, NVIDIA a su rester raisonnable dans les temps de jeux choisis pour ne pas grossir inutilement le trait, une démarche appréciable. Pour l'économie par semaine estimée à 0,6 à 1,2 kWh, on peut même signaler que ce serait en réalité davantage encore puisque ces valeurs ne tiennent pas compte du rendement de l'alimentation, alors que votre fournisseur d'électricité lui, bien évidemment, en tient compte dans ce qu'il vous facture. Ces chiffres auraient pu donc être augmentés par NVIDIA de 8 à 10 % qu'il n'y aurait rien eu d'anomal, mais cela n'a pas été fait. On va dire que cela compense le fait que, lorsqu'on joue, la carte graphique n'est pas non plus tout le temps à 100 % de charge.

NVIDIA estime ensuite que vous garderez votre carte graphique 4 ans. Là les avis vont diverger évidemment d'une personne à une autre. Certains conservent effectivement leur carte graphique environ sur cette durée quand d'autres la changent plus souvent et vont trouver cela exagéré. Il n'y a sans doute pas de réponse précise à chercher à ce niveau, mais nous allons commencer de notre côté par refaire les calculs pour une année déjà. Nous allons de plus en profiter pour utiliser le tarifs réglementé de l'électricité en France en 2023 afin de voir ce que cela donnerait pour nous plutôt que ces bases en dollars données par la diapositive et où la France n'est pas indiquée. Sur la base de 10 h de jeu par semaine durant 1 an, l'économie sur la facture d'électricité permise par une RTX 4060 par rapport à une RTX 3060 peut être estimée à 31,2 kWh soit 6,43 € par an (le tarif réglementé est de 0,2062 € TTC le kWh). Sur 4 ans l'économie serait donc de 25,73 €. Pour quelqu'un qui jouerait 20 h par semaine ces valeurs seraient doublées, à savoir 12,87 € par an et 51,47 € sur 4 ans. Rappelons que l'on parle là de l'économie envisageable en possédant une RTX 4060 à la place d'une RTX 3060.

On est donc largement en dessous des valeurs indiquées par la diapositive chez nos deux confrères européens à savoir l'Allemagne et le Royaume-Uni, où l'électricité est bien plus chère qu'en France actuellement. Ces sommes ne sont néanmoins pas anodines pour nous aussi, notamment pour des joueurs très réguliers (voire acharnés) pour lesquels l'écart grimpera encore.Cet argument de NVIDIA trouvera écho chez vous, ou non, parmi ceux qui valent le coup d'être pris en compte lors du choix d'une carte graphique, mais il a au moins le mérite de nous refaire réfléchir un peu aux coûts annexes de l'acquisition d'un ordinateur ou tout autre appareil électrique finalement, dont le fonctionnement est loin d'être gratuit...