Beaucoup ont noté des soucis dans la communication d'AMD ces derniers mois. Le premier couac, que la firme évite de mentionner, c'est le bug de la fréquence VRAM et donc la consommation démesurée de la carte sur un ou plusieurs écrans au-delà de 60 Hz. Alors que Frank Azor vantait la consommation maitrisée des RX 7900 face au concurrent, il s'est bien gardé de signaler ce "bug", toujours pas corrigé depuis plus de 6 mois maintenant.

Lors de la même conférence, AMD avait annoncé le FSR 3. Il était donné pour arriver, mais pas avant 2023. Six mois plus tard, nous savons juste qu'il va reprendre la même philosophie que le DLSS 3, à savoir une génération d'images fantômes, qui tournera sur Radeon exclusivement, et dont le mode opératoire reste un mystère. En effet, NVIDIA a souffert avec des unités dédiées (Tensor Cores, OFA), demandant une grosse quantité de calculs, AMD devrait réserver ceci à ses RX 7900, les seules équipées d'unités pour l'IA au contraire de toutes ses autres cartes. On ne voit pas par quel miracle ces calculs seraient réalisés sur des unités classiques, au risque de faire s'effondrer la puissance de calcul en rastérisation, obligatoirement élevée pour faire fonctionner un jeu. En tout cas, l'absence de communication sur le sujet témoigne de difficultés à mettre au point une technologie qui était presque vendue comme "facile" par Frank Azor.

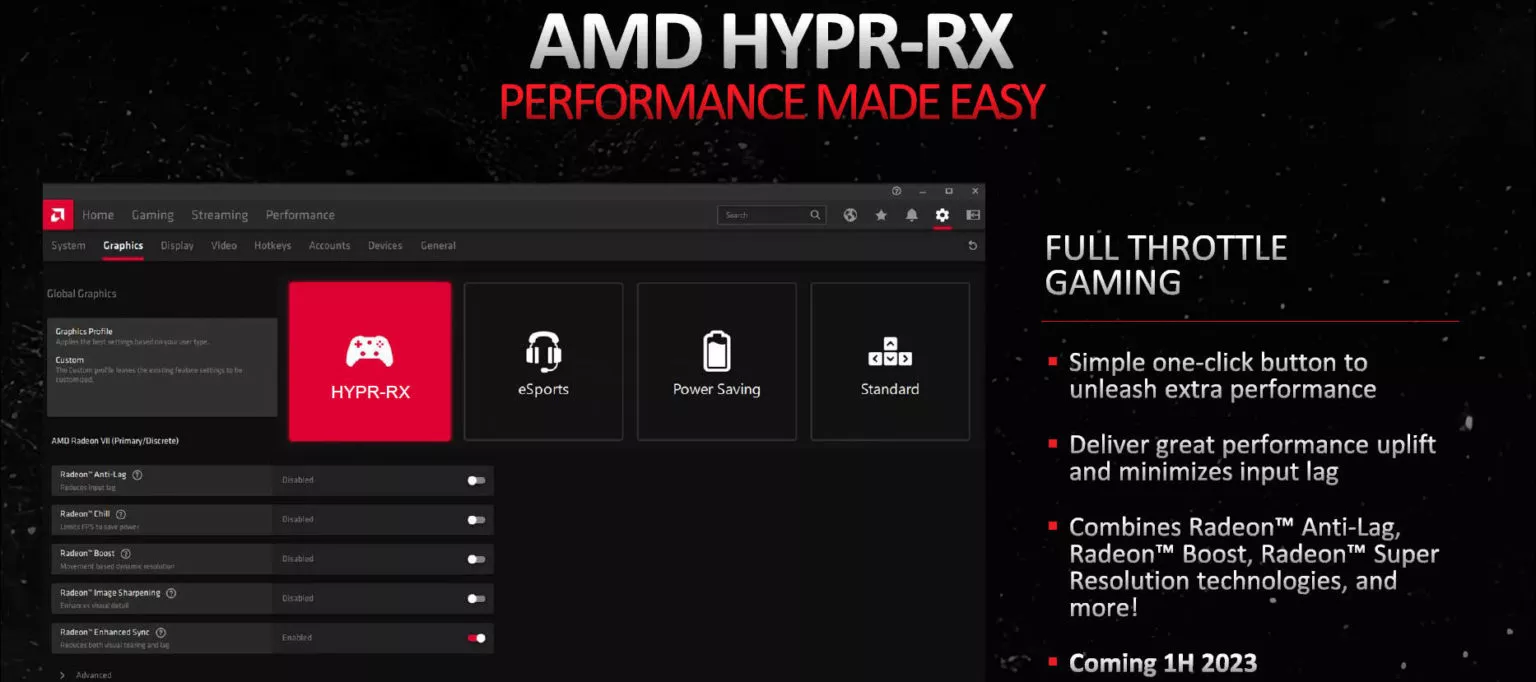

Enfin, on en revient à AMD HYPR-RX. C'est la réponse, presque identique, d'AMD à Reflex. Elle combine AMD Radeon Super Resolution (le FSR 1 intégré aux pilotes), AMD Antilag (réduction de latence) et AMD Radeon Boost (diminution de la définition selon la charge du jeu). Antilag est une bonne chose. Les deux autres, pas si sûr. Pourquoi ? Parce que le RSR est un FSR 1, un upscaling spatial qui n'offre pas de bons résultats visuels, comme certains jeux DLSS 1 à leurs débuts, qui dégrade par trop la qualité d'image, là où le FSR 2 par exemple est largement meilleur. Pourquoi ne pas faire un RSR 2 plutôt que recycler ce RSR ? Ensuite Radeon Boost change dynamiquement la définition, cette option est assez perturbante, puisque la définition change et donc la qualité et la finesse du rendu. HYPR-RX était promis pour le premier semestre 2023, il est donc en retard.

Tout ceci combiné avec l'absence de communication autour des Radeon RX 7700/7800 series inquiète vraiment. Nous espérons qu'AMD n'est pas dépassée par tous ces chantiers, peut-être trop vite annoncés pour ne pas laisser le concurrent libre, mais force est de constater que factuellement, AMD ne répond plus de rien depuis des mois. Ce n'est pas la RX 7600 qui a rassuré, obligée de lâcher le 5 nm pour un 6 nm peu avantageux. Si AMD pouvait donner des nouvelles de tout ces points abordés, nous serions en partie rassurés.

La RTX 2080 S fait aussi bien en RT mais sera limitée au DLSS2 en effet. La RX 5700 XT est la meilleure option Prix/Perfs pour ceux qui veulent jouer en FHD avec un budget limité, ce qui est le cas des clients de l'entrée de gamme. Le RT, que j'adore, n'est pas essentiel et la priorité pour ceux qui cherchent à s'équiper pour moins de 250€ et pouvoir profiter de leur compte Steam ou autres.

https://image.noelshack.com/fichiers/2023/26/7/1688286590-capture-d-ecran-2023-07-02-102918.jpg

https://image.noelshack.com/fichiers/2023/26/7/1688286590-capture-d-ecran-2023-07-02-102843.jpg

tu t'entêtes à vouloir nous caser des cartes d'occasion à des gens qui auront mieux fait de taper dans du neuf. Minage, quel usage est fait de la carte ? Les RDNA 1 en plus souffrent encore et toujours des écrans noirs jamais résolus, tu seras bien malin si tu conseilles une telle carte d'occasion qui pètera dans 3 mois ou qui fera des écrans noirs en plein jeu. Les RTX Turing ont miné comme des folles pendant la crise. Puis y'a un truc qui est fort, c'est le DLSS 3. En tout cas, c'est peut être ce que toi tu ferais, mais je ne conseille pas de foutre 250 € dans une carte d'occasion dont tu ne connais rien, et surtout pour la "garder" sur le long terme. Il vaut mieux économiser et aligner plus sur un modèle neuf qu'une occasion.

C'est amusant parce que j'ai acheté 3 cartes de minage pour teste, TOUTES avaient les ventilateurs morts, à grincer, frotter, il a fallu les changer. Je ne te parle pas du GPU, il a fallu repaster car la pâte était toute sèche. Franchement, acheter de telles cartes, faut le faire en étant un peu bidouilleur et savoir à quoi s'attendre, sans compte le prix des pièces qui majore. Faut aimer se faire chier pour des cartes qui se vautreront plus avec la prochaine gen de jeux, quand le DLSS 3 permettra de tenir bien plus longtemps.

@Castor Tu oublies le changement d'alim prévu pour faire tourner une 5700xt qui consomme le double d'une 4060 tout en se faisant ratatiner en RT. Le gain sur le budget que tu mets en avant sera perdu ailleurs (je ne parle pas de la conso qui ne doit pas non plus entrainer plus de quelques euros pas an pour cette différence). Une personne qui a une config budget et qui n'a pas les sous pour se payer une grosse carte graphique n'aura pas plus les sous à mettre sur une alim d'au moins 100W de plus. Elle sera certainement davantage intéressée de pouvoir profiter du RT en gardant sa config, sans risquer de jeter par les fenêtres le prix d'une 5700xt non garantie, en cas de souci.

pas de RT avec les cartes RDNA 1, ce n'est apparu qu'avec RDNA 2 et les ray accelerator, finalement faibles par rapport à NVIDIA et Intel. 🙂

Anéfé, jeu m'aient trompez. C'est une génération que j'ai sauté, du coup j'ai un peu zappé les capacités de ces gpu.

hummm Voyons, Nvidia=Technologie fermé qui fonctionne bien mais propriétaire et hors de prix parce que basé sur du hardware... AMD, technologie qui fonctionne un poil moins bien, mais souvent utilisable par n'importe quel matériel, open source et prix maîtriser et basé sur du software. Nvidia à tendance à toujours monté les prix vers le haut et ce depuis un bail... je me souviens lorsque les 8800gts sont sortie, presque 400€ pour du haut de gamme, alors qu'on était plus sur du 250€ 300€ d'ordinaire. Et maintenant on en arrive à payer 1500€ de l'entrée de haut de gamme... Et quand au RT... Technologie trop gourmande pour notre hardware actuel, au point qu'on est obligé de tricher en faisant du dlss et FSR... technologie arrivé prématurément pour le grand publique qui aurait nécéssité minimum 10 ans d'évolution d'hardware pour être implémenter en toute quiétude, et vu la poigné de jeu l'implémentant (sans parlé que certains ont juste des implémentation partiel) OSEF des perfs de ces cartes avec cette technologie. Et j'en était très content de ma 5700xt qui avait de bonne perf en 2k pour 400€ à sa sortie, les serie 2000 de Nvidia fallait presque le double du prix pour la même perf en rastérisation, et me parlé pas de l'absence de prise en charge du RT sur la 5700xt, j'ai déjà dit ce que j'en pensait, et faire du rt avec des série 2000 c'était vraiment naze.

La RX 5700XT était au niveau de la RTX 2070, elle coutait pas du tout le double à sa sortie, la mémoire te joue des tours !

Pour le FSR 3, il va falloir une carte Radeon ayant de l'IA, et donc destinée aux seules cartes RDNA 3. De plus, ça passera par les pilotes a priori, donc ça sera fermé, et cadenassé aux autres cartes y compris RDNA 2. Il faut aussi comprendre que l'injection d'images fantomes, ca implique une somme de calculs colossale, et un algo de débruitage efficace, que quasiment aucune carte ancienne ne pourrait faire. Ca dépasse le simple cadre du NVIDIA méchant AMD gentil, ce sont des contraintes techniques qui font surtout la loi. Et donc le reste de ta réponse, ca ne concerne que ton avis, et n'est donc pas représentatif de l'avis des gens en général. Si tu veux rester avec ta 5700XT, aucun souci, tu ne dégouteras pas les autres pour autant de vouloir évoluer vers quelque chose de mieux, après tout chacun voit midi à sa porte 🙂

oups pardon le prix d'une 2070 msrp était "juste" de 629€ contre 400€ pour une 5700xt... 229€ de différence pour des perfs identique... ah excuse c'est vrai la 2070 pouvait activer le ray tracing pour faire des screenshot🤣 Pour le FSR3, wait and see, peut être qu'il faut des unités de calculs dédié, mais pour l'instant on a peu d'info, on verra comment ça fonctionne réellement quand ce sera présenté en version final. Et désolé mais Nvidia ses solutions opensource on peut les compter sur les doigts de la main, contrairement à AMD, en tout cas la plupart des technos qu'ils ont créer sont souvent activable qu'importe le matériel. Je ne serai pas étonné que le FSR3 fonctionne sur une majorité de hardware avec des features en moins pour remplacé le FSR2, mais donnerais tout son potentiel sur du RX7000, mais bon spéculation, wait and... De toute façon ces technos sont juste là pour combler le manque de puissance pour gérer nativement le RT, Nvidia avec ces séries 2000 à intégrer cette feature 10 ans trop tôt, on peinait déjà exploiter la résolution 4k, qu'il en rajoute une couche...

RTX 2070, lancement le 17 octobre 2018 pour $499 (@stock) et $599 (Founder Edition)

RX 5700 XT, lancement le 7 juillet 2019 pour $399 (@stock) et $449 (Anniversary Edition).

9 mois d'écart entre les deux, le RT et le DLSS en plus, on est loin du x2 que tu annonçais ou des 629 euros que tu sors de ton chapeau.

GTX 295 - $520 (BI-GPU ! 2 GPU ET PAS UN SEUL) - 289 W - (236W pour la 280) - 2009

GTX 480 - $499 MSRP - 250 W - Mars 2010

GTX 580 - $499 MSRP - 365 W - Novembre 2010

GTX 680 - $499 MSRP -300 W - Mars 2012

GTX 780 - $650 (pendant 6 mois, jusqu'à que ça passe à nouveau à 499$) - 250 W - Mai 2013

GTX 980 - $549 MSRP- 165W - September 2014

GTX 1080 - $599 MSRP - 180 W - (2016)

RTX 2080 - $799 MSRP- 215W - Septembre 2018

RTX 3080 - $719 MSRP (En pratique : pénurie-scalped-covid-cryptoblaireaux, y'avais pas grand chose à vendre et les prix c'était plutot x1.5 voir x2) - 350 W - 2020

RTX 4080 - $1299 MSRP- 320 W - Novembre 2022

Je suis allez faire de l'archéologie sur le net pour trouver ça. Je sais pas si c'est utile à quelqu'un dans la conversation, mais je regrette les prix ...