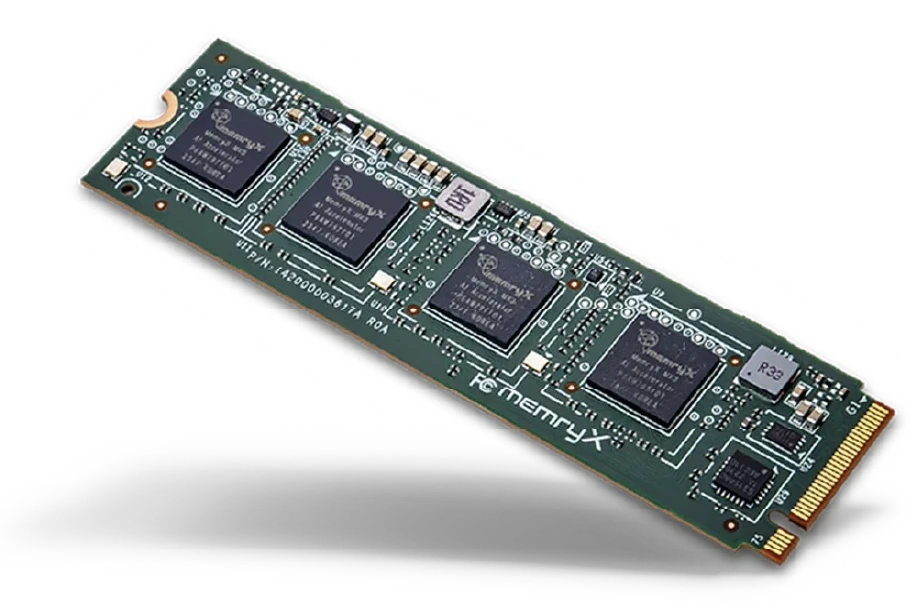

Au tout début du mois d'octobre 2024, la marque MemryX lançait sa puce MemryX MX3, dédiée au calcul IA. Elle était alors officiellement disponible en vue d'une production, mais tant d'annonces ne sont pas suivies de faits que le doute était permis quant à des suites et une existence réelle du produit, les "vaporwares" (produits fantômes) étant plutôt nombreux du côté des startups liées au monde du hardware informatique. Ce n'est pas le cas cette fois-ci puisque non seulement la puce existe belle et bien, mais elle est également proposée sous forme d'une carte additionnelle au format M.2 2280 sobrement baptisée MemryX MX3 M.2 Module.

Chaque MemryX MX3 M.2 Module contient 4 puces MemryX MX3, pouvant fonctionner à 1 GHz nous annonce-t-on avec alors une puissance en calcul IA de 6 TOPS par MX3 soit 24 TOPS pour un module complet. Le tout se ferait avec une consommation comprise entre 6 et 8 watts en charge, suffisamment basse pour qu'un simple radiateur, fourni, mais non présent sur le cliché de présentation ci-dessus, suffise à dissiper la chaleur émise par le MemryX MX3 M.2 Module.

Avec 24 TOPS, nous n'avons évidemment pas affaire à un foudre de guerre. Cependant, l'intérêt du produit, qui ouvre la porte à des solutions de secours, par exemple pour les configurations PC qui ne seraient pas dotées d'un processeur comprenant un NPU chargé des calculs IA. Si un impératif de puissance minimale requise pour ce type de tâche venait à apparaitre, on pense notamment au monde professionnel où remplacer tout un parc informatique est une gageure, l'ajout de ces modules "Edge AI" qui ne nécessitent qu'un port M.2 2280 au format PCIe 3.0 pourrait tout à fait trouver son utilité s'il n'y pas pas besoin de plus que ces 24 TOPS, qui suffisent à bien des tâches basiques finalement.

Le MemryX M.2 Module n'est pas donné pour sa petite puissance de calcul : 149 $, mais encore une fois ce tarif sera justifié s'il permet d'éviter des changements plus radicaux au niveau de la configuration dans des cas précis. Il restera à voir si d'autres s'engouffrent dans cette brèche des solutions alternatives permettant de doper les performances IA de système qui n'en sont pas pourvus d'origine. Nos confrères de Phoronix on en tout cas pu mettre la main sur un exemplaire de la solution de MemryX et ont été plutôt agréablement surpris du résultat, avec notamment un pilote Open Source qui tient la route.

Le MemryX MX3 M.2 Module en test chez Phoronix

Le concept est sympa. La limitation en terme de mémoire par contre semble fatale à une intégration concrète : 42 millions de paramètres... C'est vraiment très très peu. Les llm qui donnent des résultats potables ont minimum de l'ordre de 4 ou 8 milliards de paramètres, et la norme est souvent de l'ordre de quelques centaines de milliards pour les modèles à la pointe (d'accord ce n'est pas le but ici mais c'est pour montrer la différence de 3 ordres de grandeur). Idem pour de la génération d'image.

Pour de la reconnaissance et/ou de la classification très basique... Pourquoi pas mais pourquoi s'embêter avec de l'IA en premier lieu ?

Soyons à la hauteur d'une traduction à la québécoise, un vaporware est un produit vapeur 😅

Bonjour, est-ce qu'on peut espérer qu'un soft comme Ollama gagne en rapidité pour des petits modèles comme gemma2 par exemple ? Si c'est le cas et avec une petite baisse de tarif, ça pourrait effectivement être intéressant pour des machines pas très veilles mais faiblement armées pour le traitement AI