En 2023, il y a plus d'un an, NVIDIA avait montré ses travaux concernant une nouvelle méthode de compression des textures dans les jeux, la Neural Texture Compression. Le but, évident, est de diminuer le volume des textures dans les jeux tout en améliorant la qualité visuelle de celles-ci. Certes, les RTX ont des unités dédiées pour l'IA ce qui les rend toutes potentiellement capables de faire de la NTC, mais la méthode NVIDIA fonctionne aussi avec les autres cartes possédant des unités dédiées, dont les cartes RDNA 3 ayant des unités de calculs matriciels connues sous le nom de Matrix Accelerator. Certes, AMD ne les exploite pas, mais elles y sont.

L'idée était sûrement bonne puisque près d'un an plus tard, AMD annonce bosser sur une méthode dont la philosophie est identique : réduire la taille des textures et améliorer le rendu. Le nom ? Neural Texture Block Compression, on peut difficilement faire plus proche que le nom choisi par NVIDIA. Autre point, qu'AMD garde flou et qu'il expliquera lors de l'Eurographics Symposium on Rendering in London, c'est comment ça fonctionne ? Techniquement, on ne devrait pas être très éloignés des travaux des verts, mais il y a quand même un point qui interroge. Il y a bien Neural dans le nom de la technologie AMD, lui qui traditionnellement évite l'IA sur matériel dédié. Est ce qu'AMD va utiliser enfin ses Matrix Accelerator intégrés aux cartes RDNA 3 et donc limiter sa technologie à cette seule génération, ou va-t-il sortir un algo qui fonctionne sur toutes les Radeon via pilote, au risque de ne pas obtenir un résultat satisfaisant, à la manière d'un FSR 3 qui a pris 18 mois avant d'arriver à être un peu mieux.

Comment sera accueillie la chose ? Si la solution de NVIDIA est de meilleure qualité et qu'elle fonctionne sur RDNA 3, ça sera dur pour AMD de réussir cette fois. D'un autre côté, nous ne savons pas quand cela arrivera, mais il y a fort à parier que le premier qui sortira les marrons du feu en premier remporte l'adhésion du secteur. De plus, il se pourrait que l'arrivée des cartes Blackwell entraine celle du DLSS 4 ou de la NTC, et cela, nous espérons qu'il en sera touché un mot au SIGGRAPH à partir du 28 juillet.

Parce que la compression n'a pas un effet uniquement sur la quantité de mémoire utilisée, mais aussi sur l'occupation de la bande passante. La compression à la volée, c'est un moyen de transférer plus de textures plus complexes, sans pour autant devoir utiliser de la mémoire plus rapide.

LA quantité de VRAM c'est une chose, mais souvent les gens oublient que le débit est très important aussi, et qu'il n'est pas toujours compensé par plus de RAM ou de cache. Tu peux augmenter autant que tu veux le réservoir, si le tuyau n'est pas plus large, tu ne vas pas augmenter le débit plus que ça ;)

L'article est super intéressant, car au-delà de la présentation d'AMD on peut surtout retrouver le programme de la conf associée. Il y a des présentations de tous les bords, et il y a d'autres informations comme qui présente pour AMD.

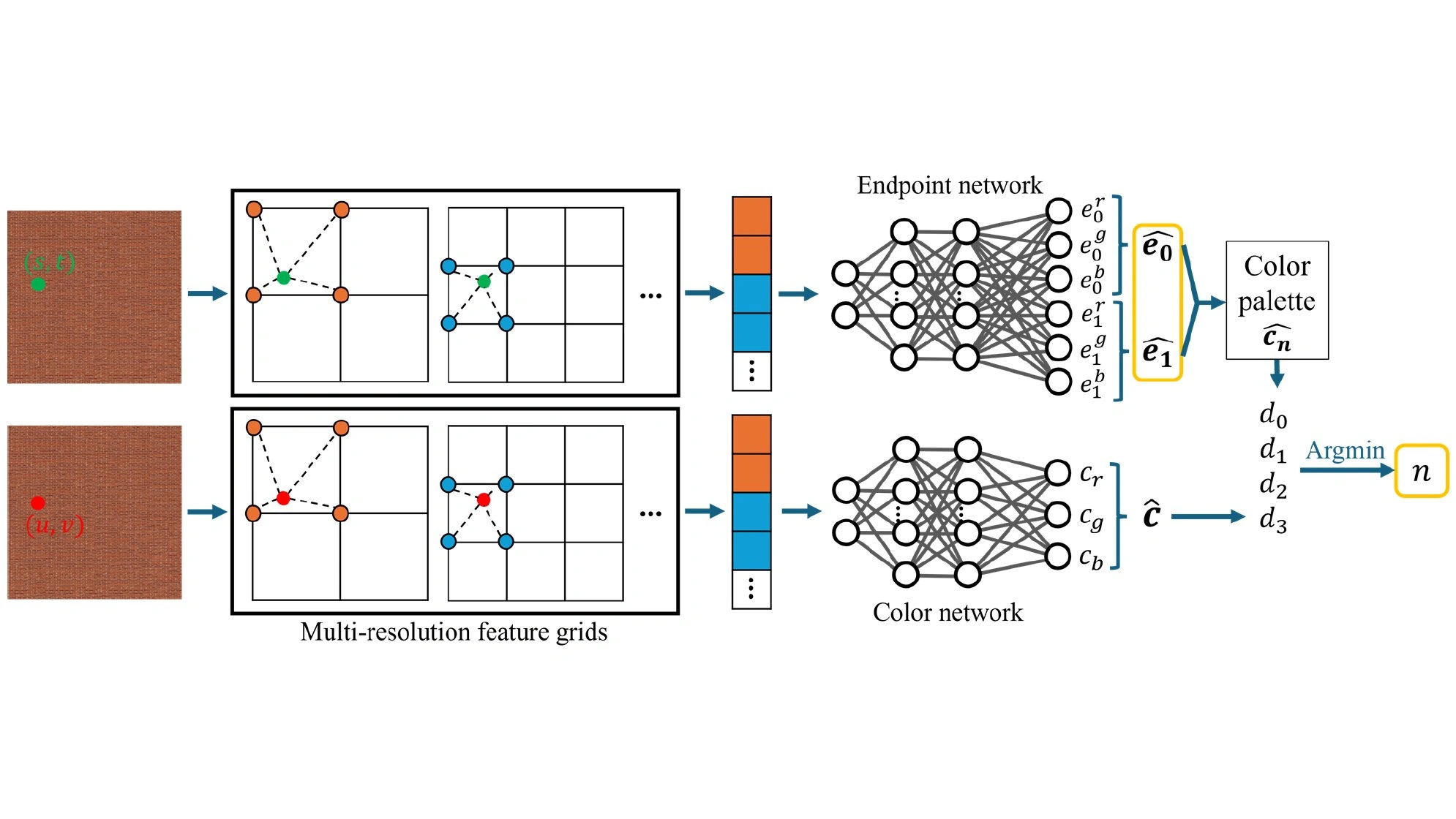

Car là on est sur des gens qui ont déjà présenté un papier très intéressant, et il faut le dire si c'est retenu prometteur, car il permet d'utiliser une méthode de compression par machine learning efficace, simple et peu gourmande, qui accélère le ray tracing. Un papier qui exploite le système de pipeline actuel des RTX 7900xxx, et démontrant que la combinaison des unités hardware permet d'obtenir un résultat correct plus rapidement sur des scènes complexes.

Avant qu'on me dise que je fais du hors-sujet, c'est juste pour souligner 2 points.

Il n'est pas impossible que maintenant, AMD exploite lui aussi des unités de produits matriciels directement sur le GPU, au risque de perdre la compatibilité avec ses "anciens" GPU. En vrai, pas de mal à ça, il serait temps car bon le retard devient un peu lourds sur de nombreux points. Surtout que niveau ML, leurs GPU ne sont pas si mauvais non plus (en faisant un test sur plusieurs modèles populaires, j'ai obtenu des performances assez proches d'une A40 avec une RX7900XTX, mais je n'en ai plus de dispo 😔).

L'autre point, c'est que des modèles légers de compression ajoutés dans le traitement peuvent grandement améliorer les performances à de très faibles pertes pour des scènes lourds et complexes, là où ces pertes sont le moins visibles. Le papier de NVIDIA démontrait que pour un coup faible en latence, le gain en qualité était immense, le tout en s'appuyant sur la même philosophie que ce papier d'AMD (d'ailleurs, ils datent à peu de chose près de la même époque).

Bon reste que comme le dis Thibaut, là à première vue il y a du retard, donc va falloir un grand coup de pied au derche chez les rouge ou alors ça a bossé en secret sur qqchose, ça on devra attendre que ça ne sorte vraiment au-delà des présentations.

Au-delà de l'intérêt évident de la chose, pourquoi AMD communique maintenant sur ce sujet alors qu'à la base, c'est née d'une polémique au premier semestre 2023, qui concernait que Nvidia ? En effet, début 2023, une série de jeux comme : "Hogwarts-Legacy, Frostpunk, Cyberpunk, TLOU, Returnal ..." faisaient explosé la consommation de Vram dés lors qu'on activait le raytracing en 1440p et au-dela. Nvidia était pointé du doigt parce qu'il était le porte drapeau des effets RT mais au lieu de prévoir des gpu milieu de gamme mieux doté en Vram, il maintenait le sacro-saint 8go : "2070, 2070Super, 2080, 3060Ti, 3070, 3070Ti et la 4060".

Nvidia finit par réagir en présentant une technologie à même de stocker plus de données pour que 8go de Vram soit suffiant puis quelques mois plus tard, sans qu'on sache si cette technologie était prête et diffusé aux développeurs, près de la moitié des titres qui posaient problèmes ont été patché et consommait moins de mémoire vidéo.

AMD n'à jamais été concerné car ils dotaient les Radeon 6000, la première génération compatible avec le raytracing, avec bien plus de Vram.

Un an à passé depuis cette polémique et Nvidia n'a jamais reparlé de cette technologie, jamais une autre série de jeux ont fait flamber la consommation en Vram ?

Un an après, AMD communique sur une technologie qui rappelle celle de Nvidia, pourquoi ? Le problème sur les jeux n'est plus d'actualité, les Radeon continuent à être mieux doté en Vram (RX7000 vs RTX4000) et comme plus des 3/4 des joueurs sur desktop et plus sur laptop ont des cartes/puce Nvidia, on ne comprend pas en quoi ils sont concernés ?

Est-ce vraiment un travail de bon samaritain ou est-ce une mise en scène en mode "regardez-moi", j'ai comme Nvidia, une longue expertise en IA, apportez-moi vos capitaux, que je profite à mon tour de la bulle spéculative en matière d'intelligence artificielle ?