Avec l'explosion de l'intelligence artificielle, la mémoire de type HBM a plus que jamais le vent en poupe. En effet, ses qualités sont indispensables à l'élaboration des accélérateurs, quels qu'ils soient, et ce, généralement en grosse quantité. Il s'agit par conséquent d'un segment très rentable en ce moment pour les producteurs, à tel point que sa production est largement favorisée par rapport aux autres types de mémoire. De plus, ce marché ne compte à ce jour que trois fournisseurs principaux : Micron, Samsung et SK hynix. Ce dernier est de loin celui qui tire actuellement le mieux son épingle du jeu, mais les autres ne sont pas en reste pour autant et la forte demande de la part des plus gros consommateurs de mémoire HBM leur assure pour l'instant une certaine place aussi. Justement, qui seraient donc les clients les plus gourmands ?

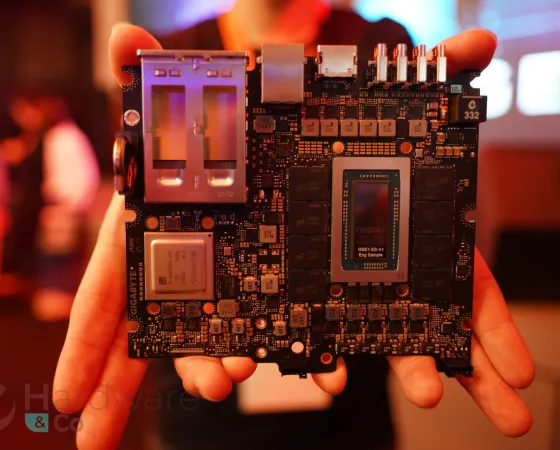

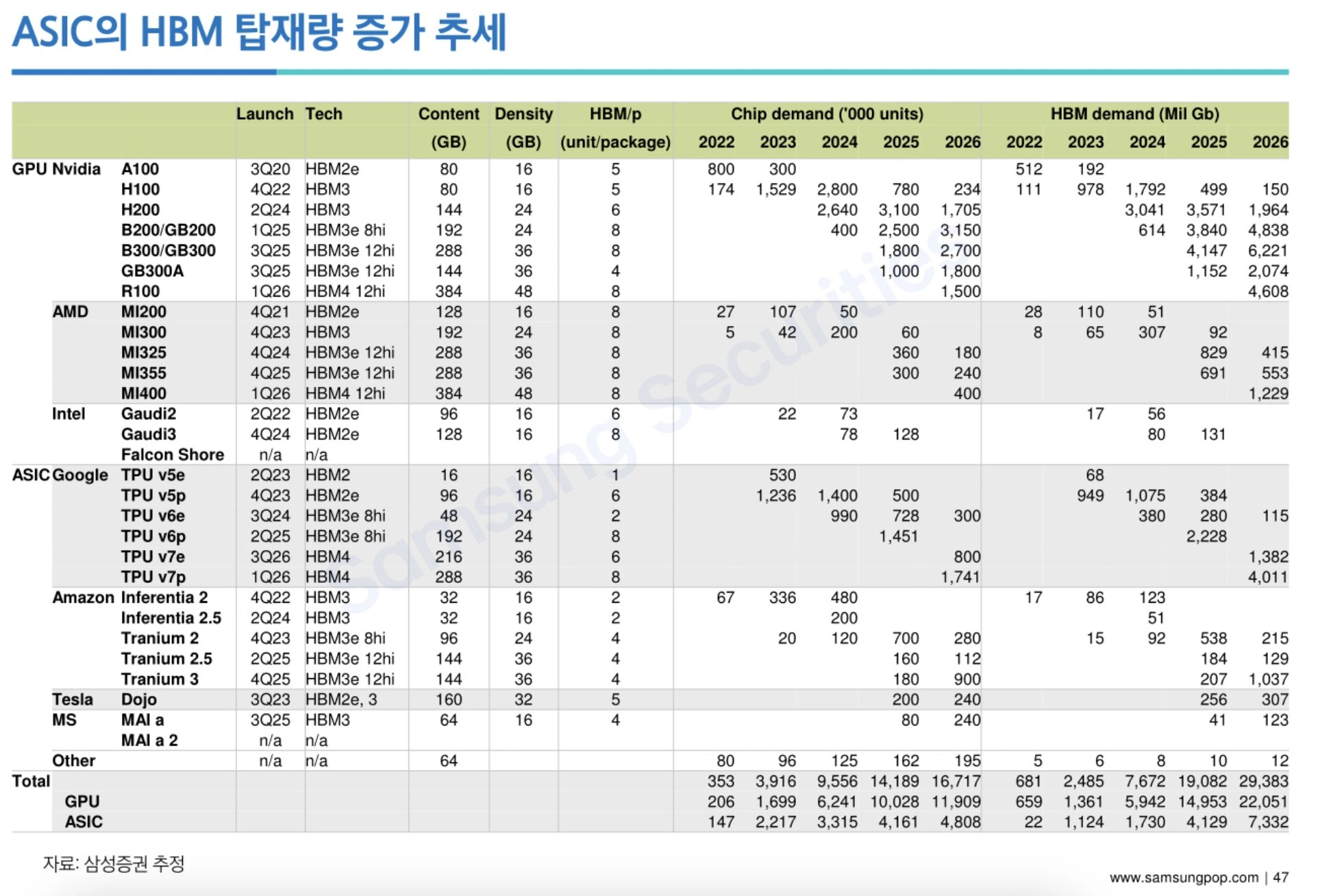

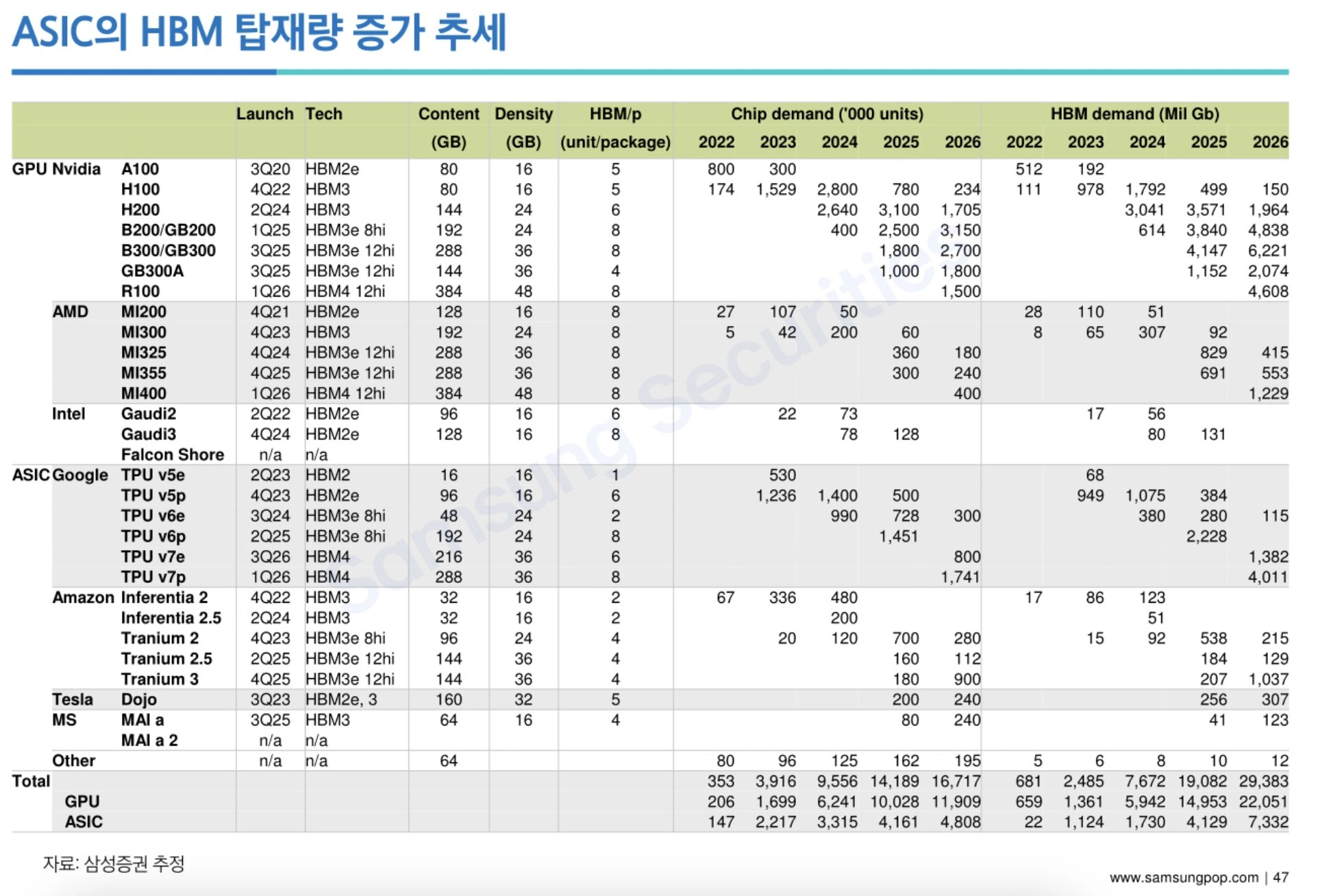

Un document interne élaboré par Samsung Securities - société de services financiers et filiale de Samsung - donne un début de réponse. Il s'agit d'une feuille de route projetant l'évolution de la demande en matière de mémoire HBM de la part des principaux utilisateurs. Il faut toutefois tempérer l'information, puisque le document daterait de début 2024, ce qui impliquerait que toutes les données ne sont plus nécessairement très fraiches. Notamment, la MI325X y est affichée avec 288 Go de HBM, alors qu'elle a en fin de compte été castrée à 256 Go. On voit aussi la MI355 planifiée pour Q4 2025, alors qu'elle vient d'être avancée à mi-2025, donc potentiellement Q2/Q3. Enfin, le document semblait vouloir établir un marché total adressable (TAM) jusqu'à fin 2026, ce qui veut dire que ce ne serait pas une projection de l'évolution de la demande de mémoire HBM limitée à Samsung - chez qui le développement des dernières générations de HBM s'est avéré quelque peu compliqué, rappelons-le.

En tout cas, si l'on s'en tient à ce document, le plus consommateur de HBM présent et futur serait NVIDIA, ce qui ne surprendra absolument personne. En revanche, on sera peut-être un peu plus surpris de découvrir qu'AMD ne serait qu'en 4ᵉ position. Google serait en 2ᵉ position, suivi d'Amazon en troisième place. Il est vrai que les acteurs s'étant attelés à la conception de leur propre puce maison donnent beaucoup plus rarement des détails, notamment de quantité, sur le matériel installé dans leurs propres centres de données. Au fond, c'est assez normal, contrairement à AMD et à NVIDIA, ils ne fabriquent que pour eux-mêmes et n'ont pas de vente à faire valoir en la matière. En tout cas, les chiffres de demande de HBM souligneraient bien l'intensivité du déploiement de matériel pour l'IA chez ces acteurs. Accessoirement, ça illustrerait aussi en fin de compte la taille du marché potentiel échappant aux vendeurs d'accélérateurs susmentionnés. Microsoft y apparait comme anecdotique, mais c'est certainement un peu trompeur, puisque le gros de ses investissements dans l'IA se fait actuellement via OpenAI, un gros client de NVIDIA. Quoi qu'il en soit, à l'image d'Amazon et Google, Microsoft aussi entend dépenser beaucoup de milliards de dollars cette année pour l'IA, des sommes cumulées gigantesques dont le bénéfice assuré pour la vente de HBM n'est sûrement pas encore reflété dans ce document.

Et Intel dans tout ça ? On voit bien que le marché de l'IA échappe totalement à ses séries Gaudi. Et en supposant que le document soit bien de début 2024, les incertitudes autour de Falcon Shores, désormais annulé, étaient visiblement déjà évidentes depuis longtemps. Bref, en attendant Jaguar Shores, qui sera probablement basé sur la HBM4, Intel ne sera pas un gros consommateur de HBM. (Source : X, Computerbase)