La quantité nécessaire de mémoire vive embarquée sur les cartes graphiques est un débat qui n'en finit plus et sur lequel il est difficile de statuer tant les données changent d'un jeu à l'autre. Du côté de NVIDIA, on fait clairement le pari pour le moment de la parcimonie. Au lancement de sa gamme GeForce RTX 40 en 2023 le discours était clairement que 8 Go était suffisant pour du 1080p avec en fer de lance la RTX 4060 Ti, et que 12 Go était amplement suffisant pour du 1440p voire davantage, puisque les RTX 4070 et RTX 4070 Ti embarquaient cette quantité là. Les verts mettaient par la suite un peu d'eau dans leur vin en lançant une RTX 4060 Ti en version 16 Go et faisaient glisser la RTX 4070 Ti SUPER en modèle 16 Go début 2024, mais on sent tout de même que la différence de point de vue demeure entre NVIDIA et AMD, qui propose systématiquement plus de VRAM que son concurrent direct à tarifs équivalents.

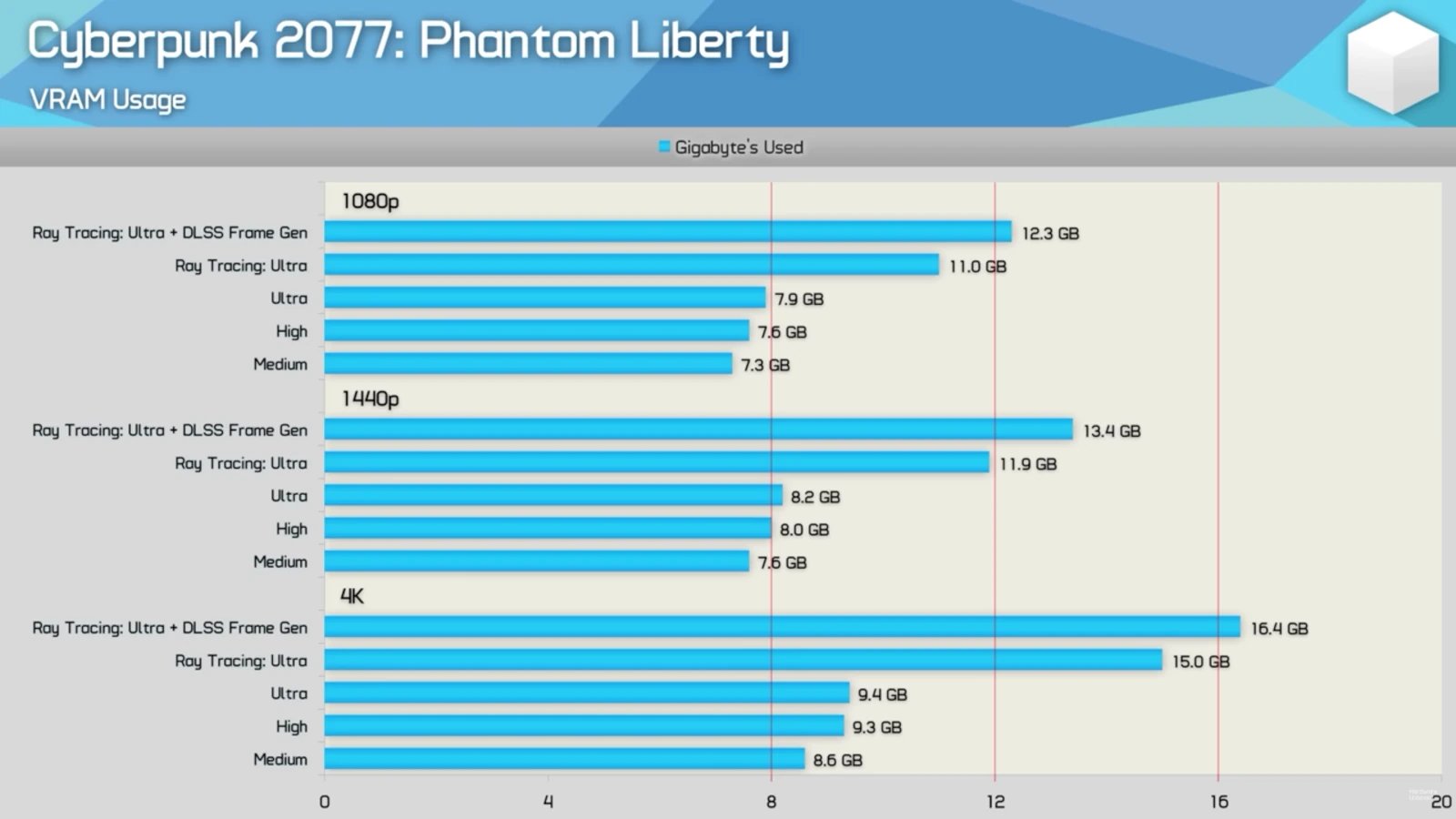

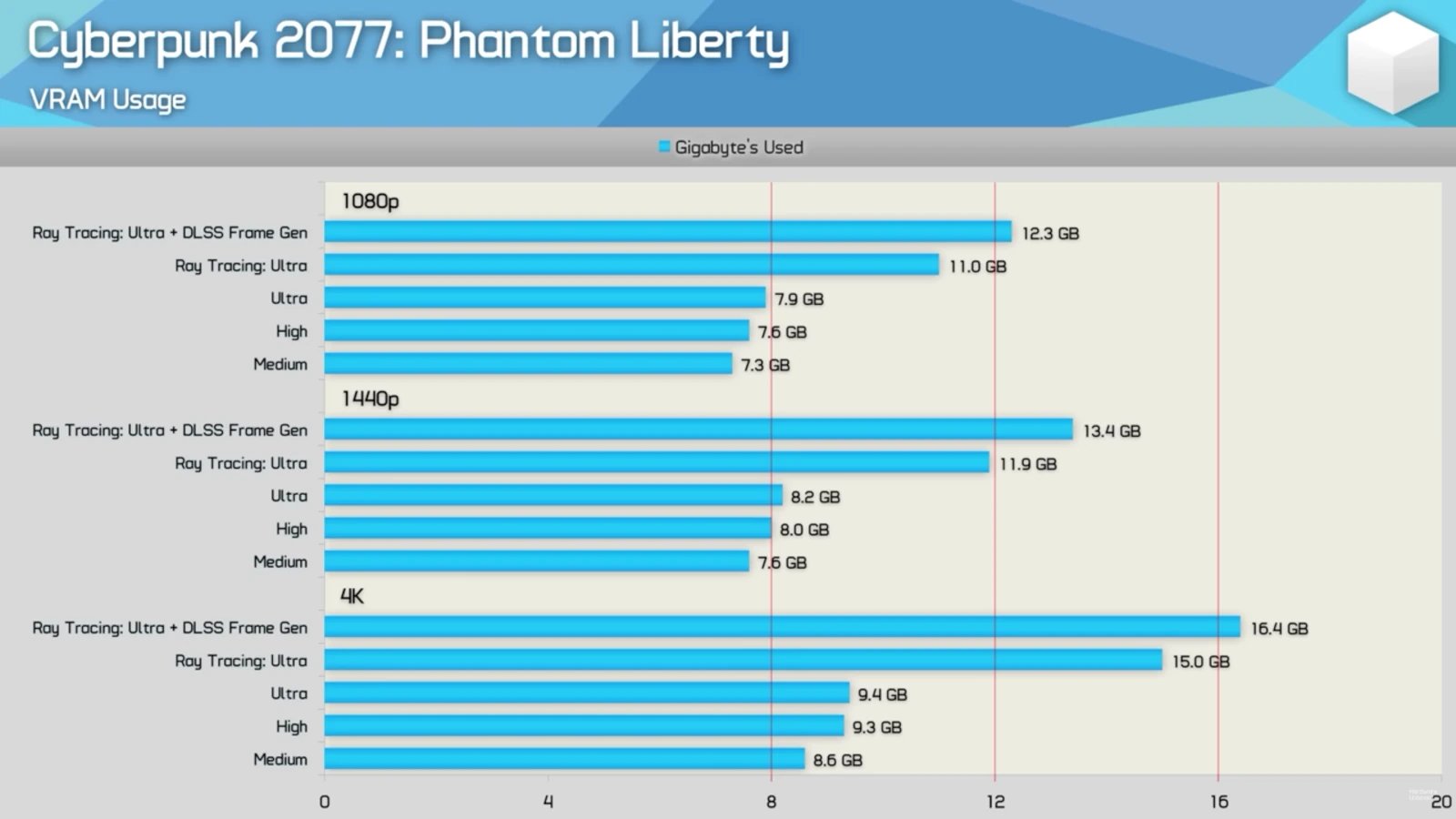

Qui a raison ? Un nouvel élément de réponse a été publié il y a une petite dizaine de jours par nos confrères de la chaîne YouTube Hardware Unboxed. Ils se sont intéressés à 12 jeux différents, dont ils ont testé la gourmandise en mémoire vive vidéo à la fois en FHD, QHD et UHD, tout en jouant à chaque fois avec les réglages graphiques afin de multiplier les mesures. Ils sont allés jusqu'à activer le ray tracing lorsque c'était possible, ce qui a évidemment un impact non négilgeable sur la VRAM utilisée, mais également en y ajoutant l'activation du DLSS, avec frame generation sur les jeux le supportant. Un paramètre qui alourdit encore la facture en utilisation VRAM. Le bilan n'est pas anodin du tout et a tendance à repousser NVIDIA dans les cordes puisque, même en 1080p, les 8 Go de VRAM ne sont régulièrement trop justes avec activation du ray tracing et du DLSS 3. Quant aux 12 Go, le constat n'est guère plus reluisant si vous envisagez là encore d'activer un maximum d'options graphiques et le frame generation, et ce dès le 1440p dans plusieurs jeux d'après ce test.

Voici par exemple les résultats obtenus lors de ce test pour Cyberpunk 2077. Ne croyez pas qu'on a volontairement pris un titre gourmand en VRAM, c'est même plutôt le contraire ! Les graphes de Avatar: Frontiers of Pandora par exemple vous donneront des sueurs froides si votre quantité de VRAM vous préoccupe... On vous laisse découvrir tout cela en détails dans la vidéo de Hardware Unboxed.

je ne me doutais pas que le frame generation ça ajoute de la vram le dlss de base lui diminue

Alors tu gagnes de la VRAM techniquement vis-à-vis d'avoir des images de la résolution native, mais tu augmente la consommation à côté (et donc, selon les cas tu consommeras plus) pour plusieurs raisons :

Il ne faut pas croire, bien que ça permette de générer des images à un coup de traitement et de mémoire moindre, cela revient à consommer plus que d'avoir bah juste le même nombre d'image. Cela reste quand même très intéressant tout de même !

Pour ceux qui ont 12Go de VRAM et qui ont un moniteur 4K, pas de souci, il suffit de jouer en FHD ou QHD et d'utiliser Lossless Scaling pour upscaler en 4K

Pour ceux qui ont 16Go de VRAM, alors la ils sont tranquilles pour de nombreuses années, vu la très faible proportion de gamers qui ont plus de 16Go de VRAM

Le frame generation, c'est plus un gadget qu'autre chose, donc vraiment pas indispensable

Hello,

Cela fonctionne vraiment bien le Lossless Scaling ?

Perso, j'avais pris une 4070 Ti pensant naïvement être un peu tranquille avec ses 12 Go mais bon vu les tableaux, je vois bien que c'est une belle connerie. Pas trop envie de repasser tout de suite à la caisse surtout que je vois que 16 n'est pas non plus la panacée.

grayzone Warfare

Les NVIDIA 4070 super prennent que 1 go en 2 k et 10.5 en dlss et 11.5 en 4k

AMD prennent 14go.en 2k ,14.9go en 2k fsr et 15.5 go en 4 k

Nvidia gère mieux la ram on dirait.

mis a part les fans de nvidia, qui ne sont pas objectifs, les fans d'amd ont tout compris, tout comme le fabricant : en effet, amd a une gamme bien plus logique et sympa niveau tarifs, evidemment.

les 16 go viennent avec les 7800 xt, les 7900 gre, puis on tape les 20 go avec les 7900 xt et enfin 24 go avec les 7900 xtx

20 go c'est deja un minimum si tu veux tout mettre en ultra avec le fsr, et c'est seulement avec 24 go que tu es tranquille pour 5 ans ? environ...

en tout cas le fsr continue de s'ameliorer et bon, pour les pauvres qui veulént casser leur tirelire,

une carte puissante avec 24 go a moins de 1.000 boules, c'est top

chez les verts c'est 1700 ?

pour un dlss de moins en moins superieur au fsr d'amd. encore 2 ou 3 generations de fsr, et les fans d'amd auront un fsr aussi bon que le dlss de nvidia.

je prends les paris pour le fsr 4 !!!

hahaaaaaà goooooo amd !!!

Je suis en *total désaccord* avec la politique de "parcimonie" (ou plutôt de rat avide de profits juteux) de NVIDIA !

Ma RTX 3070 commence franchement à se trouver à l'étroit avec ses 8Go de VRAM, et il est clair qu'aujourd'hui déjà, 16Go semble une quantité raisonnable pour un confort de jeu correct. Même un vieux logiciel comme le client pour Second Life (récemment mis à jour pour le rendu PBR des matériaux) demande une quantité croissante de VRAM, et 8Go, c'est bien trop peu pour pousser la qualité à fond (bien que le GPU puisse suivre sans problème au niveau puissance), même en Full HD !!!

NVIDIA a intérêt à corriger le tir avec les RTX 5000, s'il veut conserver ses clients: 16Go, c'est le *strict minimum* pour une carte graphique de 2024 !

Ah bah clairement nVidia a revu sa copie depuis la 1080Ti et la difficulté qu'ils ont éprouvé a faire changer de carte les détenteurs de cette dernière... Depuis lors il y a juste ce qu'il faut pour le présent (et encore) et surtout il faut pas que la carte puisse vivre trop longtemps ! :)

Moi je joue en 4k à RDR2 sur une RTX4060. Alors je ne sais pas de quoi on parle là franchement... les jeux qui sortiront dans 2 ans? Laissez moi rire.

Quand on regarde le test complet (au format écrit, c'est tout de même plus simple imo : https://www.techspot.com/review/2856-how-much-vram-pc-gaming/ ), on s'aperçoit que le plus gros facteur est la présence ou non du RT mais qu'inversement, il n'y a pas tant de variation entre medium <-> ultra, FHD <-> UHD sur une bonne partie des titres testés.

Et à côté, ils parlent très peu (pas, au moment des tests) de la qualité des textures qui sont pourtant un gros facteur dans la consommation en VRAM.

Il aurait été intéressant de voir le comportement de jeux avec une carte qui a moins de VRAM (pour comparer comment le jeu s'adapte à la contrainte, s'il prend des largesses / nettoie moins derrière lui comme il a de la place pour s'étaler) et également de voir la consommation de VRAM pour une qualité de texture donnée.

Il n'y à pas deux jeux qui utilisent la Vram de la même manière sur Windows, en fonction du moteur, du fait que les jeux sont lead-plateform console ou que l'ensemble est conçu pour charger un monde ouvert ou au contraire différents niveaux. Certains jeux vont streamer au maximum afin d'utiliser le moins de mémoire vidéo, d'autres vont essayer de tout charger en Vram. Certains moteurs vont vous incitez à bien configurer des réglages car ils vont se contenter d'afficher le jeu de manière brute, à l'inverse d'autres moteurs ont des capacité de monitoring et adaptent la chargent à votre hardware avec très peu d'options graphiques.

Depuis qu'on est passé à la 3D, il y à des studios qui se contentent d'acheter un moteur, d'injecter le jeu et qui ajustent le visuel et la fluidité, d'autre font leurs moteurs ou en modifient un autre et ont des capacités de pousser plus loin à hardware identique.

Sur certains jeux dés qu'on monte un peu en réglage, c'est au gré le streaming du support de masse qui est limitant, d'autre le processeur ou encore les différents type de mémoire.

La quantité de Vram sur une carte graphique, c'est l'élément qui semble le plus à même d'être compris par n'importe qui mais de même que 16 et deux fois plus que 8, quid de savoir si il existe des taux d'occupations en Vram différent et pour un même jeu, pour les mêmes réglages entre une architecture Radeon, type 6000/7000 et des RTX 3000/4000 ? Est-ce que les techniques/capacités à réduire l'espace à aller lire plus rapidement en dehors de la mémoire vidéo sont les mêmes ?