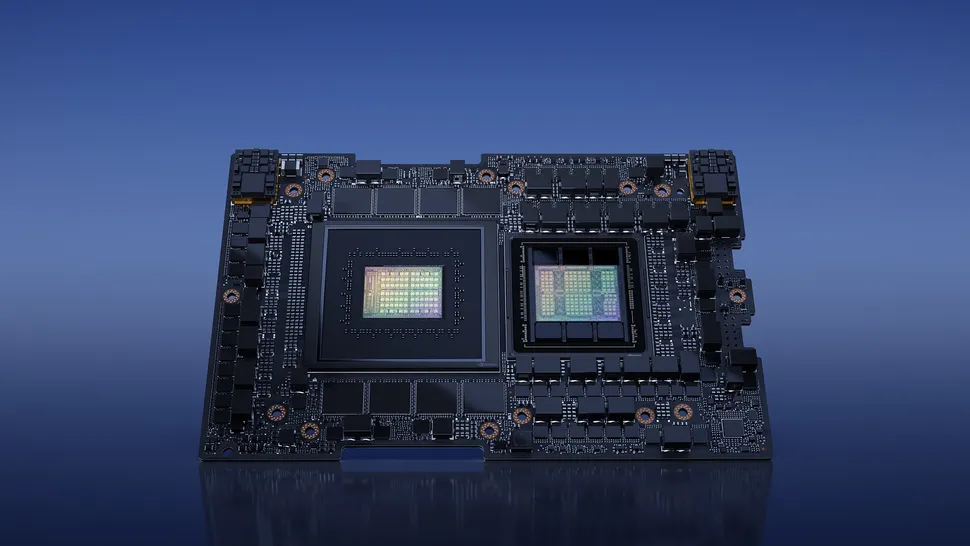

Alors que le caméléon va devoir revoir à la baisse ses exportations en direction du Moyen-Orient au vu des récentes nouvelles consignes de l’Oncle Sam, cela n’empêche pas la firme de continuer le développement de ses produits. Et, dans ce domaine, Grace Hopper est sans nul doute l’un des plus attendus : sortir un module alliant conjointement CPU et GPU maison sur deux die distincts, c’est bien une première pour la firme ! Néanmoins, la gestation du bébé n’en finit pas : initialement présenté lors de la GTC de 2022 de mars dernier, le bousin n’est toujours pas disponible pour les professionnels… ce qui était attendu, puisque la firme annonçait début août que ce module GH200 n’arriverait qu’au second trimestre 2024.

Mais, du coup, qu’est-ce que le bousin a dans le ventre ? Selon un benchmark MLPerf soumis par la firme elle-même (déduisez-en que toutes les optimisations possibles et imaginables ont dû être appliquées au bousin), le multimodule affiche jusqu’à 17 % de gain de performance face à une H100 — une carte composée grosso modo du GPU seul, accompagné de 80 Gio de HBM3 en lieu et place des fameux 282 Gio de HBM3e du GH200. De quoi montrer au passage l’efficacité en pratique de l’interconnect reliant les deux dies, affichant la bagatelle de 900 Gio/seconde de débit théorique ; et l’intérêt des 144 cœurs Arm, dont le nom ne fait pas forcément penser à du calcul haute performance à première vue. Heureusement que l’architecture Neoverse est là pour rattraper le coup !

Cependant, les verts se sont abstenus de commenter l’entièreté des résultats, en se cantonnant aux 17 % sur GPT-J 6B, un réseau chargé d’effectuer des résumés à partir d’une entrée textuelle uniquement. Avec 6 milliards de paramètres, le bousin est costaud, mais loin des 175 milliards de nombres formant la configuration de GPT-3 ! Il faut dire que le combiné risque surtout de briller dans des cas pratiques où une tâche généraliste de prétraitement de données (typiquement de la décompression) peut être déportée sur le CPU, histoire de laisser le GPU gambader tout seul dans son machine learning. De quoi remplir les poches de la firme, et accompagner la croissance des multiples start-ups et autres départements IA, revenus sur le devant de la scène suite à la démocratisation de Chat GPT.

Enfin, la firme a également profité de l’occasion pour teaser son L4, un GPU PCIe optimisé pour l’inférence avec un TDP rikiki de 75 W. Comparé en version octocarte à 2 Xeon 8380 (le top moumoute de chez Intel en CPU pour la génération Ice Lake), le GPGPUs sortent sans souci vainqueur avec une efficacité énergétique de 120 fois celle du concurrent. Certes, mais la polyvalence n’est pas non plus la même… (Source : Tom’s Hardware)