Non content d’avoir réussi à fourrer des pilotes WiFI (plus ou moins) dans les BIOS, GIGABYTE avait tout un tas d’autres tours dans son sac au Computex, incluant du matériel peu conventionnel. SI vous vous rappelez, l’an dernier, la firme avait lancé son logiciel AI Top, une suite permettant aux semi-professionnels de faire du machine learning sur mesure au moyen de composant grand public et HEDT (enfin, surtout ces derniers !).

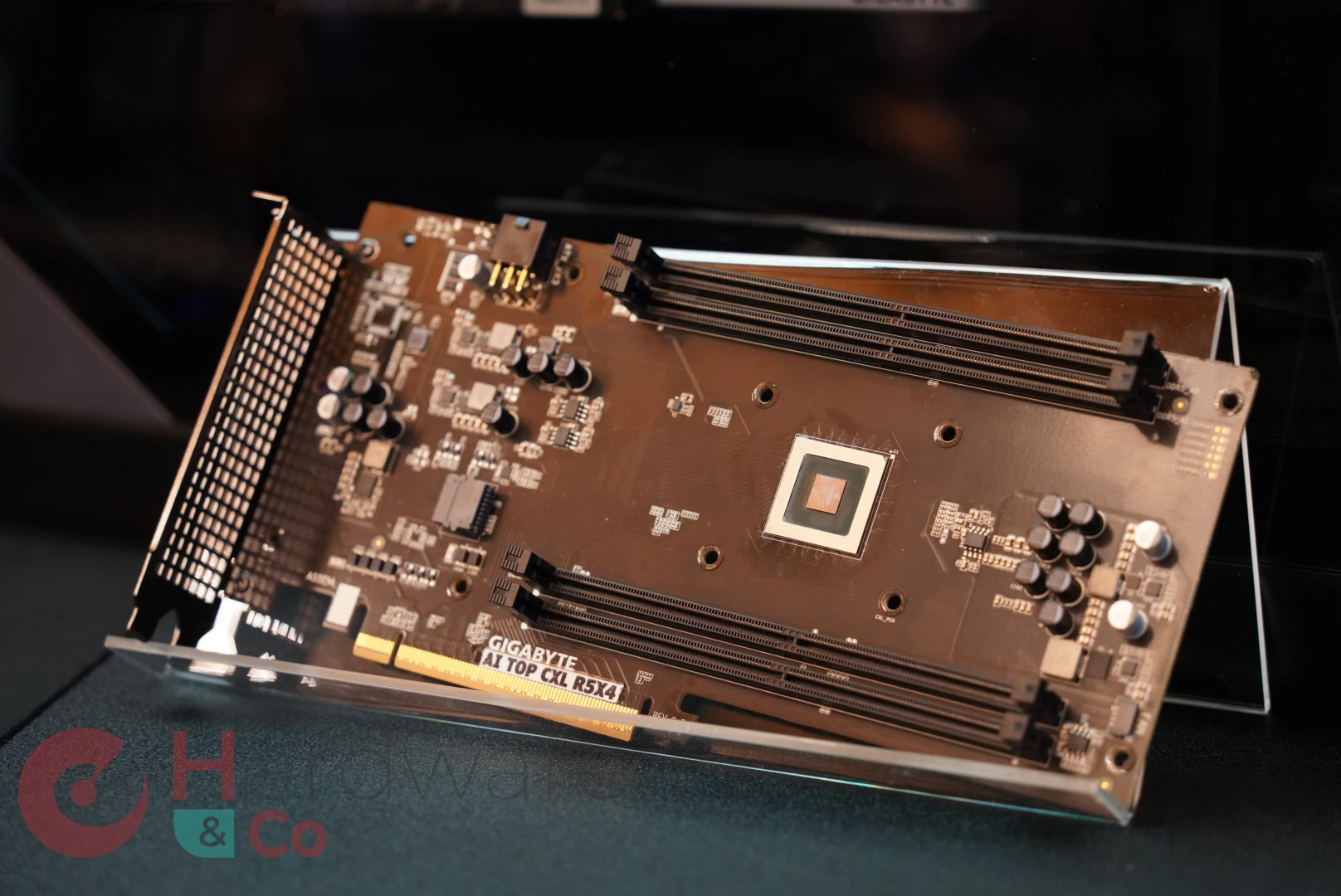

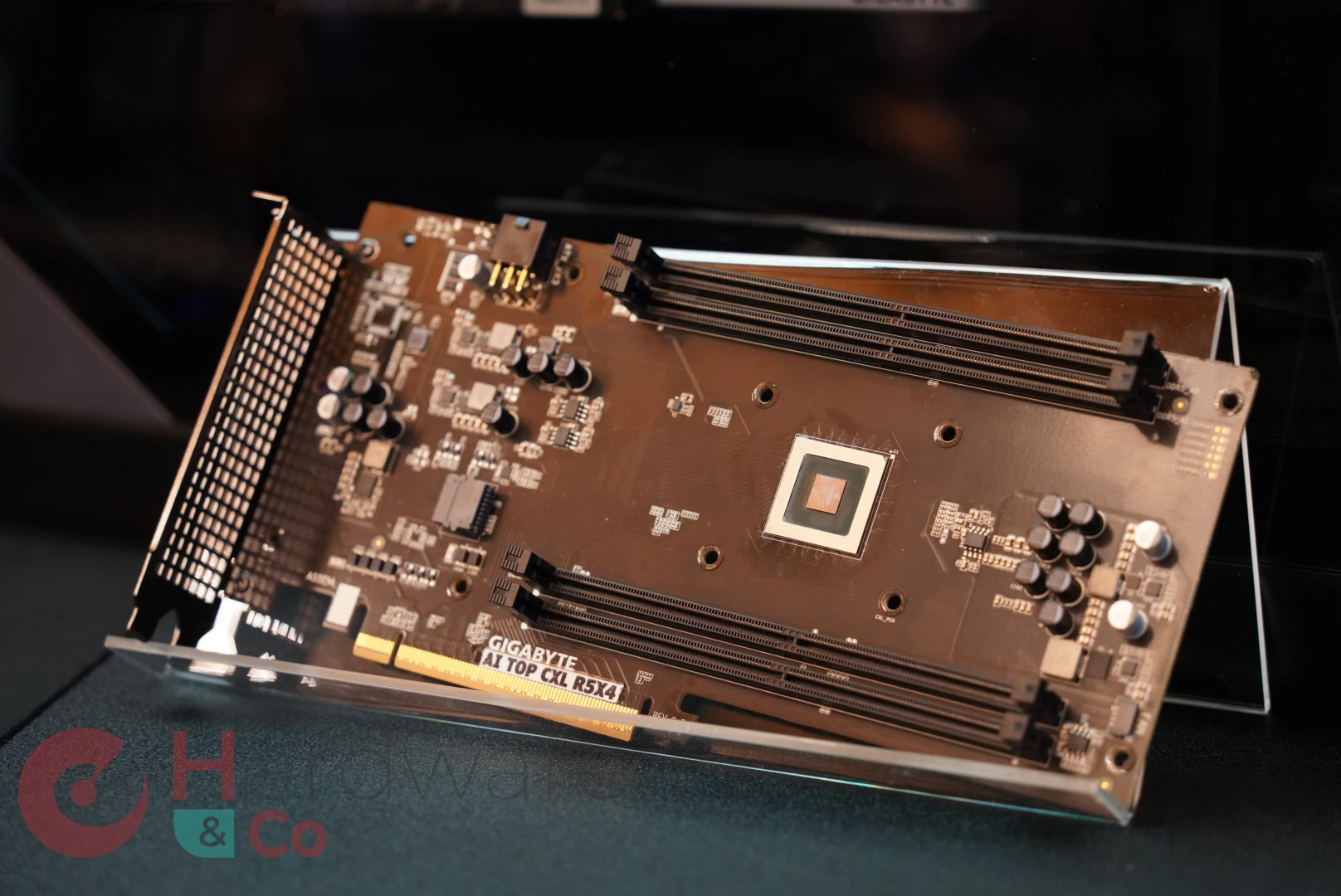

Or, les CPU AMD Threadripper sont compatibles avec la norme CXL, une surcouche de l’interface PCIe qui permet (entre autres) d’y brancher de la mémoire adressable directement depuis le CPU hôte. Vous l’avez compris, c’est via cette technologie que GIGABYTE vous permet, au moyen de son AI TOP CXL R5X4, d’augmenter la capacité de RAM de votre machine. Ainsi, pas moins de 4 barrettes de 128 Gio de DDR5 (en RDIMM, en revanche !) peuvent être rajoutées à votre machine, à condition d’avoir un Threadripper de chez AMD (modèles W790 AI TOP et TRX50 AI TOP, dans les faits) et une connexion PCIe 5.0 x16 libre, ainsi qu’un connecteur 6-pin PCIe (pour assurer la stabilité de l’alimentation, pas pour tirer la totalité de 125 W disponibles en cumulé avec le port hôte !). Et, si cela ne suffit toujours pas, vous pouvez également vous acquitter d’une seconde carte pour doubler cette capacité. Annoncée à un tarif avoisinant les 500 $, la carte trouvera principalement usage chez les professionnels… mais cela pourrait donner des idées pour des extensions futures de nos machines grand public. Avis aux amateurs ?

Les perfs doivent être de l’ordre de la ddr5 en single channel. Donc c’est à réserver à un public très particulier. Peut être pour upgrader un serveur sans remplacer la ram par de la plus grosse et plus coûteuse en attendant de le remplacer.

Mouais, faut vraiment trouver un use case (machine trop peu fournie en Vram au départ ?). Parce que même en admettant qu'on atteingne la bande passante théorique du pcie 5 x16 = 128 Go/s , ça reste très faible dans le contexte de l'IA, en tout cas pour de l'inférence (la Vram des GPU est en To/s sur les GPU orienté IA maintenant).

Après je peux peut-être voir l'utilité pour manipuler de gros fichiers (traitement vidéo ? pleins de modèles à précharger pour swap plus vite de l'un à l'autre ? networking très intense genre 2x40Gb/s qui saturerait vite un SSD ?) sans subir la chute drastique de perf des SSD pcie 5 après une centaine de Go écrits.

Vu que c'est AI Top, je dirais pour l'IA, en particulier pour les LLM qui demandent énormément de RAM, quitte à utiliser cette mémoire comme swap plus que que RAM

Bah c'est justement mon problème : la sortie en token/s c'est plus ou moins égale à [bande passante mémoire]/[taille du modèle] (pour un modèle dense, les MoE sont moins coûteux en bp relativement à leur taille totale mais sont énorme , 250Go pour qwen235b:q8 ou 404Go pour ddepseek R1 q8 )

Et là ça fait mal : un modèle de 35Go (qwen3 32b en q8) sortirai à peine 3-4 token/s

Autant dire qu'avec un modèle raisonnant (donc quelque centaines voir milliers de tokens "cachés" au début en plus) la réponse va être longue. Et pour de l'entrainement j'en parle même pas.

L'utilité que j'y vois serait de mettre en cache les tokens d'un (de) long(s) prompt(s) que j'utiliserais régulièrement. Ca économise le (temps de) recalcule de nombreux tokens au prix d'un accès au swap/ramdisk. Les API propose 50% de reduction sur le coût de ces cached tokens. Un RAID de SSD pourrait marcher aussi bien s'il y a surtout de la lecture et peu d'écriture.