Alors que la première révolution IA pour le grand public a apporté des améliorations impressionnantes en matière de détection d’image et reconnaissance vocale, la deuxième vague propulsée par Chat GPT et divers algorithmes tels GauGAN de chez NVIDIA s’attaquent à la génération (textuelle comme visuelle). Si de nombreux sites web proposent désormais de tester la chose en ligne, les plus malins — et ceux désirant de contourner les limites d’utilisation — préféreront installer le service en local, et générer à volonté… tant que le GPU le permet. Car le machine learning est très friand de puissance de calcul (c’est même son plus gros défaut : manger de la multiplication-accumulation de matrices comme Titi engloutit ses petits-déj’), et les verts s’en sont largement servis ; d’une part en finançant des projets de recherches tournant sous du matériel de la firme (merci CUDA !) et d’autre part en adaptant petit à petit son architecture aux besoins de l’IA avec les Tensor Cores.

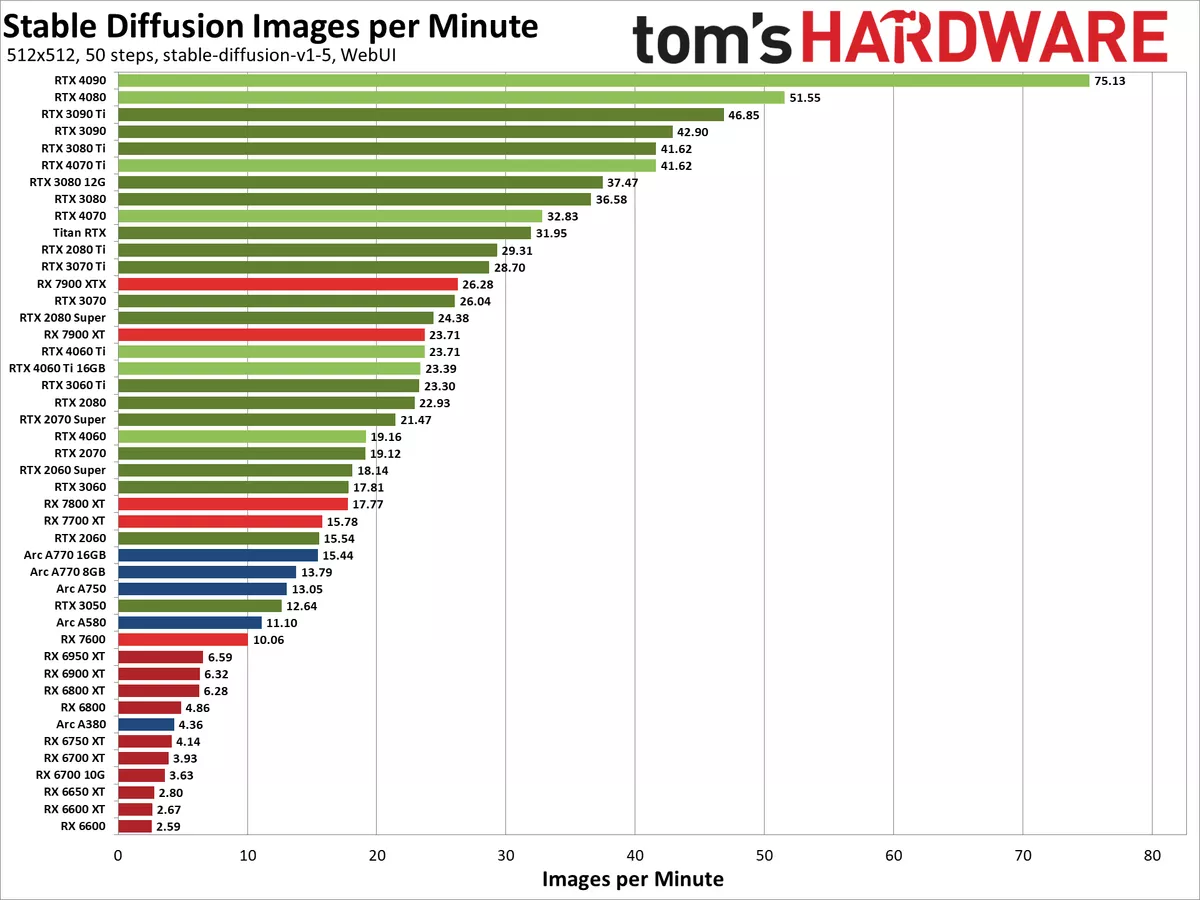

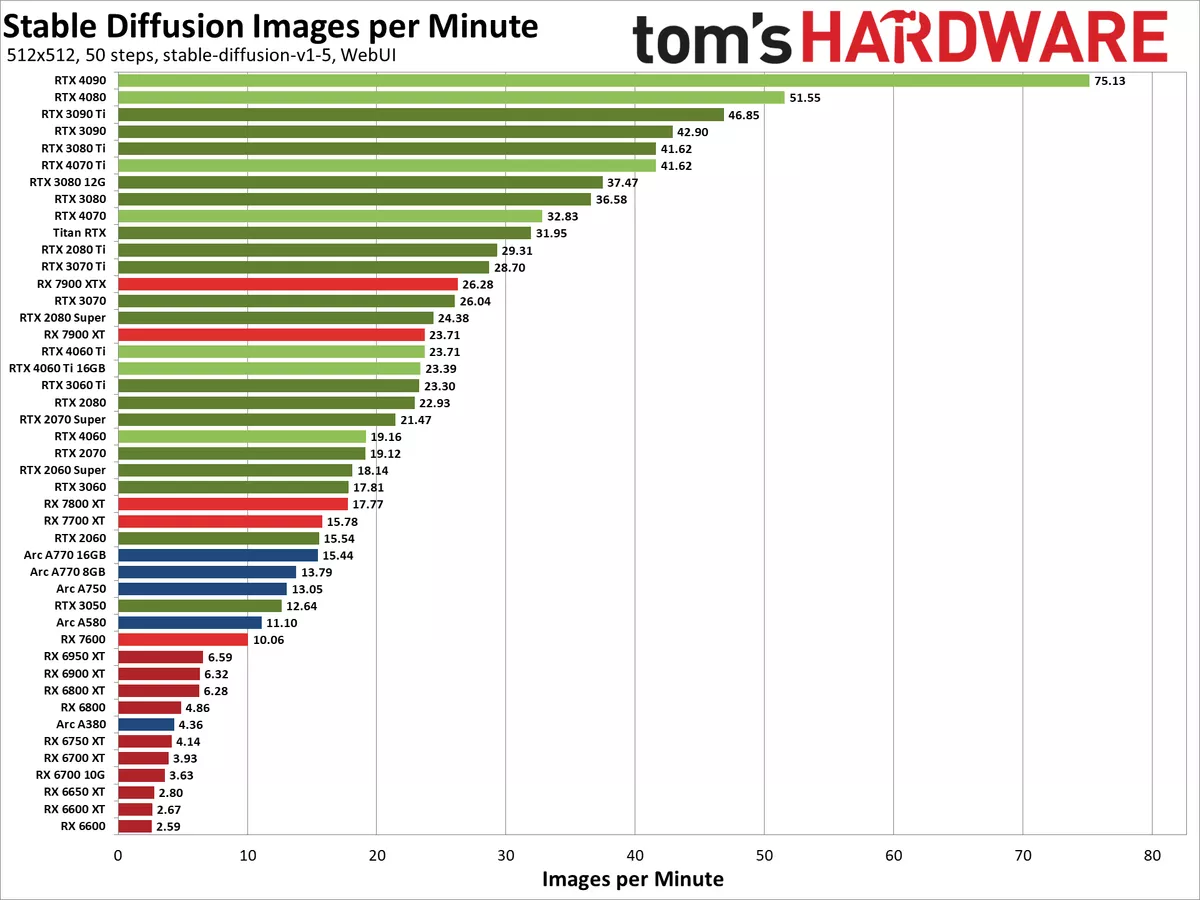

Maintenant cet état de fait dressé, que valent les cartes vertes et rouges, toutes générations confondues ? Notre confrère Tom’s Hardware s’est posé la question, et a testé la bagatelle de 45 cartes de chez Intel, AMD et NVIDIA pour déterminer kiki ki est le meilleur sur Stable Diffusion, un réseau de neurones très en vogue permettant de générer des images à la suite d’une description succincte (le prompt). Voilà leurs résultats pour la production d’une image de 512x512 px :

Sacrée rouste pour les rouges, où le top moumoute — la RX 7900 XTX — se retrouve placée au niveau… d’une RTX 3070 autrement plus abordable et datée ! Il faut dire que le caméléon peaufine ses Tensor Cores depuis 2017 (architecture Volta), et n’a pas lésiné sur les moyens côté logiciel. En effet, si l’installation du combiné interface web/back-end Automatic1111 a été quasi-automatique pour une utilisation avec un GPU NVIDIA, chez AMD et Intel il a fallu farfouiller davantage. La RTX 4090 se retrouve sans surprise en tête des scores avec moins d’une seconde de génération par image ; et met la pâté à la RTX 4080, pourtant seconde, avec un sympathique + 50 % de performance. Ça, c’est fait ! Pour le reste, la RTX 3090 et sa version Ti se retrouvent troisième et quatrième, le reste des gammes se trouvant ordonnées sans grande surprise. Notez que l’IA est connue pour être également exigeante sur le sous-système mémoire : de quoi expliquer certains paliers dans le classement, typiquement la RTX 3060 Ti et l RTX 2080 au même niveau, car disposant toutes deux de 448 Gio/s de bande passante VRAM en dépit d'un delta de 25 % de puissance de calcul brute FP16 hors Tensor Cores en faveur de la 2080. Voilà qui explique en partie la domination des verts côté pros, et, par opposition, l’appétit des concurrents (coucou les bleus !) pour ce secteur en pleine expansion et ô combien juteux. À voir si l’avenir confirme ce quasi-monopole !

Très intéressant, il faut que je vérifie. Je ne pensais pas que ma 6900XT prenait aussi cher.

Par contre la quantité de RAM a aussi son utilité et AMD est généralement mieux pourvu.

Oui, mais pour la quantité c'est un go / no-go ; impossible totalement de faire si la carte n'en a pas assez. En revanche, j'ai testé avec ma 2080 et j'avais des temps bien plus longs que ceux-là, mais j'ai changé les paramètres donc... normal.

Ça représente beaucoup d'acheteur gamer ce genre d'utilisation ? Ou bien c'est des gens qui veulent accéder à ça pour moins cher qu'avec un GPU de la gamme PRO peut-être ?

Pas sûr de saisir l'importance de lancer des générations d'IA en local pour faire la même chose qu'en ligne. D'autant plus que ça coûte moins cher en électricité de faire la requête sur internet plutôt que de faire chauffer son GPU pour ça (même si j'imagine la consommation très mesurée par rapport à un jeu vidéo).